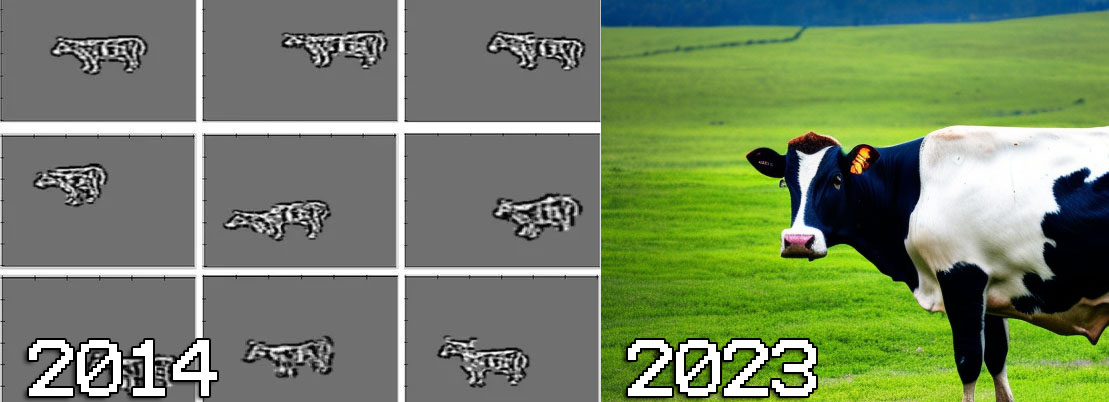

Alguns meses atrás – e são bem poucos – o AIpocalipse estava restrito aos artistas digitais, especificamente aos que faziam comissões para otakus desenhando a Bulma de bikini, ou algo assim. Agora o Tsunami apareceu no horizonte e todo mundo está com medo do que vai acontecer.

- Microsoft 365 Copilot – Eles vão dominar o mundo – de novo

- GPT-3 - Entrevistamos o fantasma na máquina

Restos de uma sociedade distópica, na visão do Stable Diffusion (Crédito: MeioBit / SD)

É compreensível. É normal ter medo do desconhecido, quando vemos nosso ganha-pão, tudo que aprendemos durante a vida se tornar obsoleto. Isso acontece com razoável freqüência, mas em geral são casos específicos. Ninguém se pergunta o que aconteceu com as empresas que criavam fidget spinners, ou fabricantes de Ioiôs, um brinquedo extremamente atrelado a modas.

A diferença, agora no AIpocalipse é que a Revolução não está atingindo camponeses ameaçados por tratores a vapor, ou operários tamancudos assombrados com teares automáticos.

Tivemos seis meses em que a IA ameaçava somente artistas do Tumblr, mas agora a lista de atividades “ameaçadas” ocupa páginas e páginas. Atividades ditas como criativas estão na mira da IA, há relatos de sites demitindo redatores (não tenha ideias, Mobilon) e trocando-os por assinaturas do ChatGPT Pro.

A Microsoft lançou o Github Copilot X, que pode ser o AIpocalipse ou a Utopia para desenvolvedores, mas vai destruir instituições. A Adobe lançou o Firefly, seu gerador de imagens via IA. A Shutterstock também lançou seu serviço, o que gera um monte de questões. Eles são um serviço que licencia e revende imagens de arquivo, mas com seu gerador os fotógrafos se tornam redundantes.

Se bem que na verdade, o próprio gerador da Shutterstock é redundante, mesmo com instalações caseiras como a minha consigo gerar um monte de imagens de mulheres felizes com suas saladas.

Em verdade as empresas estão correndo pois não têm ideia do futuro, elas precisam de uma cabeça de ponte na IA, ou vão ficar pra trás, mas e nós?

Inovação == Demissão?

Existe uma visão de que toda inovação tecnológica acarreta perda de postos de trabalho. O Glorioso Aldo Rebelo, Ex-Ministro de Ciência, Tecnologia e Inovação acredita tanto nisso que apresentou um Projeto de Lei que proibia inovações tecnológicas. Na prática a resposta é... é complexo.

A população empregada hoje é bem maior do que em 1827, então de alguma forma novos postos de trabalho foram criados, mas os antigos muitas vezes foram atropelados.

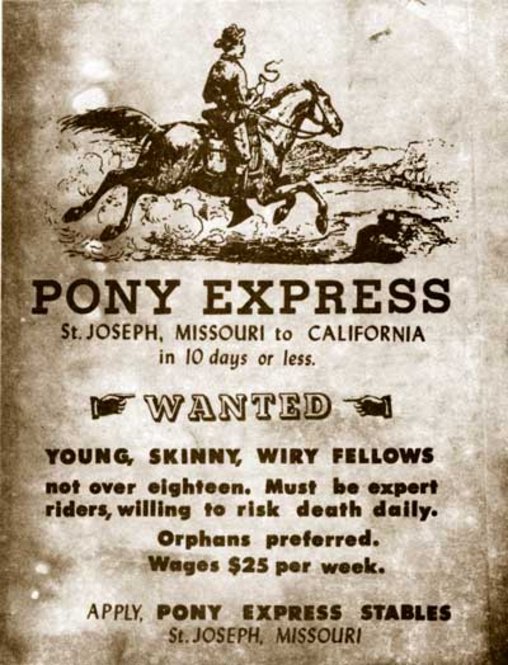

O Pony Express foi um serviço no Velho Oeste ligando o Missouri à Califórnia. Lembre-se, naquele tempo era tudo mato, atravessar o país era perigosíssimo e levava meses. A eleição de James Buchanan como Presidente dos EUA em 1857 levou meses para chegar aos jornais da Califórnia.

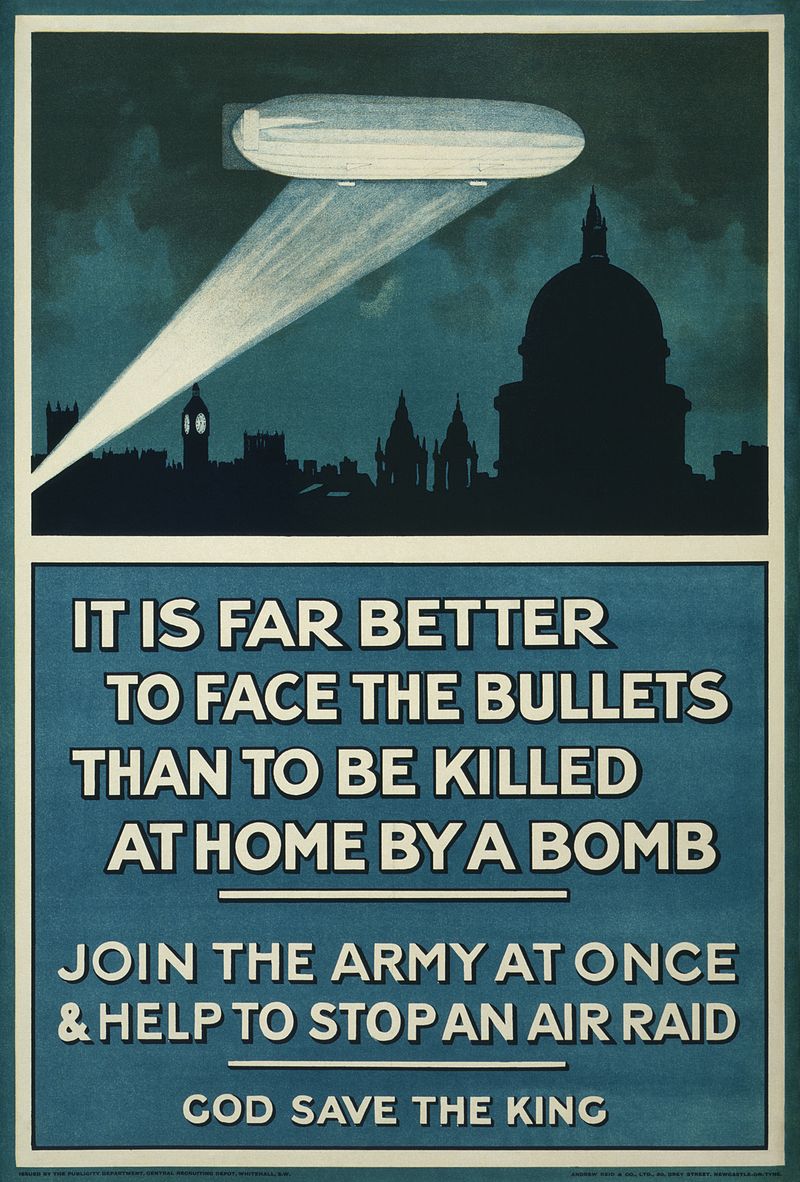

Cartaz de recrutamento para o Pony Express. (Crédito: Domínio Público)

O Pony Express mantinha uma rede de postos logísticos a cada 16km, onde jovens, em geral órfãos cavalgavam alucinadamente até o limite de seus cavalos, chegavam no novo posto, tomavam uma água, pegavam um cavalo novo e seguiam adiante. A média de tempo para uma correspondência cruzar costa a costa nos EUA agora era de dez dias. A eleição de Lincoln foi comunicada em apenas 7.

O Pony Express era uma maravilha logística, mas durou apenas 18 meses, de 3 de abril de 1860 a 26 de outubro de 1861. A chegada do telégrafo tornou uma excelente e revolucionária ideia totalmente obsoleta.

A invenção do automóvel foi a pá de cal nos cavalos, muitos viraram cola, ou foram vendidos para açougues ou fazendas. Os fabricantes de carroças se adaptaram para produzir carrocerias, muitos fabricantes de carros vendiam só o chassis, que o cliente então enviava para adaptarem a carroceria.

Cocheiros se tornaram motoristas, outros postos de trabalho sumiram, mas a inovação tecnológica também cria novos postos. Carros precisam de frentistas, de vendedores de seguro e de mecânicos. Uma montadora produz muito mais do que uma fábrica de carroças, e demanda um número maior de funcionários, mesmo com automação.

É meio cruel invocar Darwin, mas sobrevive quem melhor se adapta às mudanças, e o mundo muda o tempo todo. Os EUA estão cheios de cidades ligadas à mineração que perderam sua fonte de renda, há vários projetos bem-sucedidos onde mineiros foram treinados como programadores de computador.

Imagem genérica de programadores (Crédito: MeioBit / SD)

Gerações de marinheiros treinados em veleiros tiveram que se adaptar a vapores, depois diesels. Artes e habilidades são perdidas, mas assim é a vida. Sé que aqui, do olho do furacão, não conseguimos ter a perspectiva global.

AIpocalipse Now

Muitos, muitos anos atrás reza a lenda um dono de um escritório contábil, daqueles bem chucros chegou na sala onde 3 ou 4 sujeitos trabalhavam com sistemas em Clipper (pergunte a seus pais) e sumariamente demitiu todo mundo. Ele então tirou um disquete de uma pasta, enfiou no drive e digitou na tela do DOS: “Folha de Pagamento”.

Nada aconteceu. Ele havia comprado um gerador de relatórios bem popular na época, que permitia que você escolhesse via menus algumas opções e tinha razoável flexibilidade, acessando o dBase (avô, pergunte a seu avô). O slogan da publicidade desse gerador era “despeça seu programador”.

Empresas que estão demitindo ou pensam em demitir por causa da IA estão sendo burras como o sujeito da anedota acima. Exceto casos específicos, AI deve ser usada como ferramenta de aumento de produtividade, não de corte de custos.

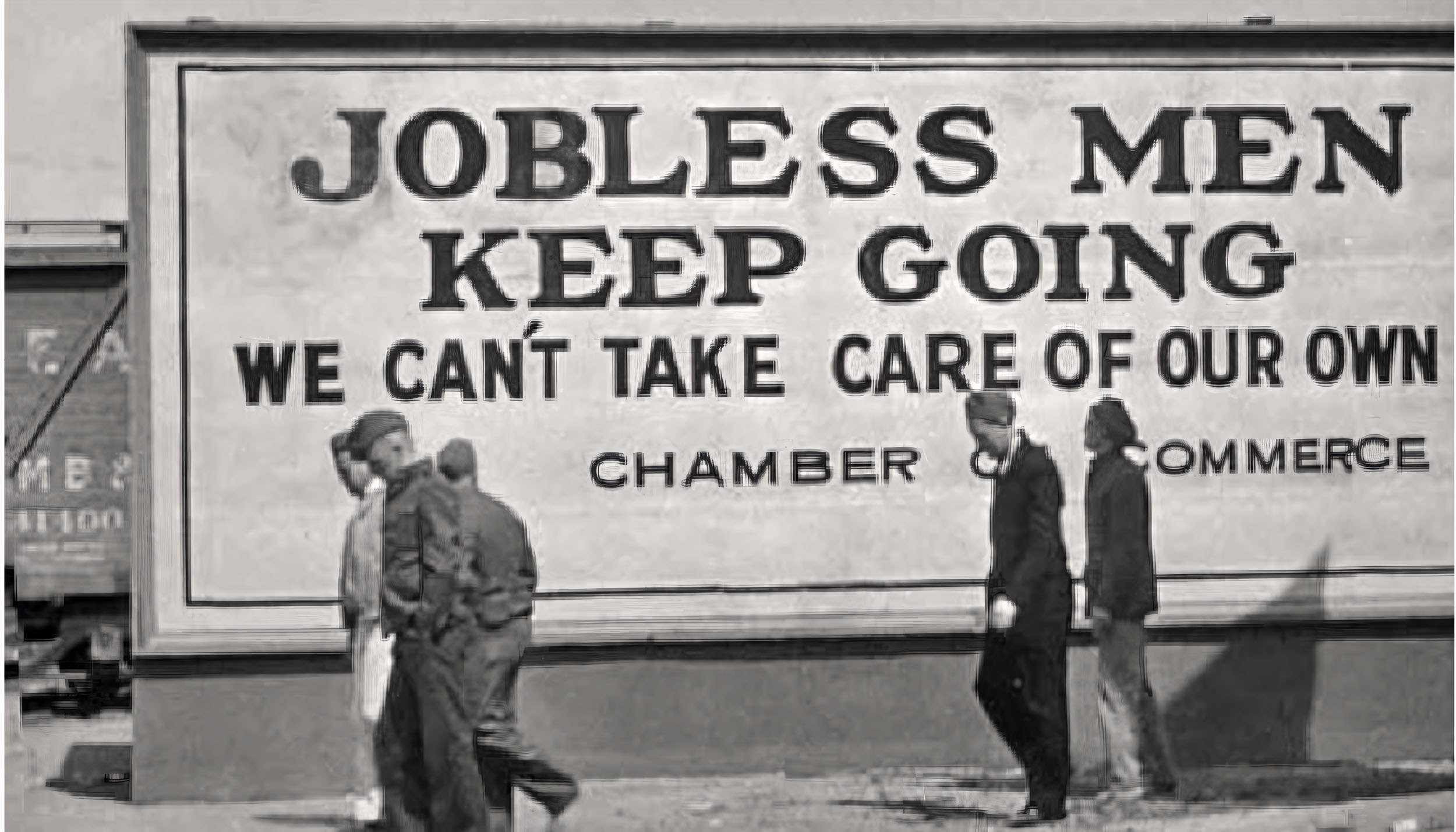

Placa erguida durante a Grande Depressão de 1929 (Crédito: Domínio Público)

Há bastante gente em pânico, um grupo de artistas entrou com uma ação coletiva contra A Stability.AI, Midjourney, DeviantArt e outras empresas por trás de IAs geradoras de imagens. Não vai dar em nada, o gênio saiu da garrafa, é impossível fazer todo mundo parar de disponibilizar, e muito menos usar essas ferramentas.

Há motivo? Sendo honesto, dependendo do artista, há sim. Uma quantidade relevante de jovens que desenham bem ganha um trocado no Tumblr e no DeviantArt desenhando por encomenda em geral imagens de animes, hentai, furries. Esse povo será dizimado pela IA, e aparentemente já está sendo. O Civitai.com, site NSFW que agrega modelos para o Stable Diffusion está lotado de modelos de anime, com os quais você consegue criar qualquer coisa, incluindo tentáculos.

O Buzzfeed anunciou que irá usar o ChatGPT para criar conteúdo. Ele é excepcionalmente bom para o conteúdo repetitivo sem imaginação e caça-cliques do Buzzfeed. Dá para criar listinhas e top 10s em escala industrial. Se eu fosse redator do Buzzfeed eu estaria me sentindo extremamente inseguro e temeroso de ser substituído a qualquer momento, mas essa é a realidade dos redatores do Buzzfeed: Eles são substituíveis e descartáveis.

E os Programadores, devem temer o AIpocalipse?

De novo, depende, eu estou vendo gente sem muita familiaridade com programação, em geral de outras áreas, como Ciências, adorando poder escrever seus programas de forma ágil e eficiente, sem precisar depender de terceiros, e mesmo entre profissionais de TI, o povo está adorando o CoPilot e similares.

Agora, ao invés de ir no Stack Overflow copiar código, o GPT4 gera o código pra gente, um senhor avanço, que se reflete em produtividade, mas cria o medo da caixapretização da programação.

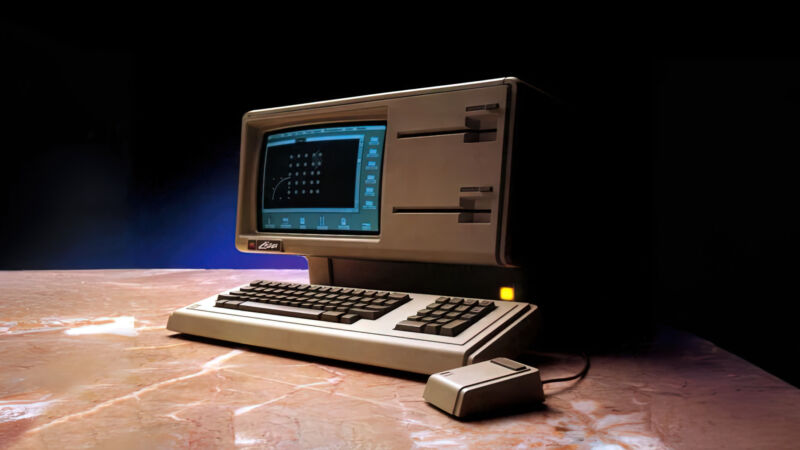

Há quem alerte que deixar a IA fazer o trabalho todo afasta o programador da máquina, ele não terá ideia do que o programa está fazendo internamente. Eu vou contar um segredo: Esse barco já partiu faz tempo.

Hoje um programador Python usa um monte de módulos que não faz a menor ideia de como funcionam por dentro. O alvo da ve são os programadores de framework, que não sabem desenvolver nada do zero, atrelados a seu framework de estimação.

Antes deles a crítica era aos programadores de IDE, que não sabiam usar linha de comando, faziam tudo de dentro do Eclipse, do Visual Studio e do Codewarrior.

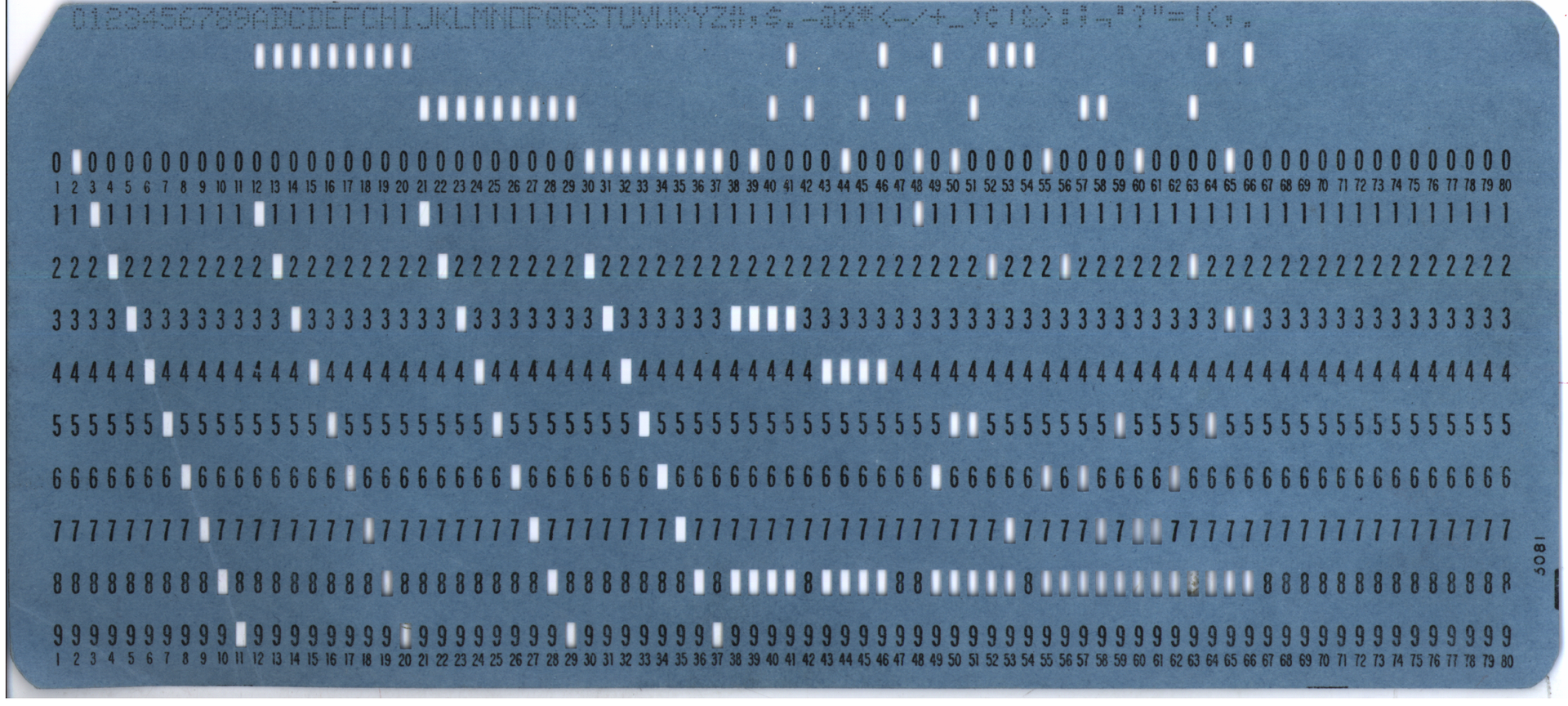

Nas linguagens, havia uma disputa de pureza, muita gente não considerava linguagem de programação de verdade se não acessasse o hardware diretamente. Por muito tempo o limite era o povo que programava em linguagem de máquina, eu adorava soltar que escrevia em Assembler Z80 (na época a gente chamava de assembler, e vai ficar assim), até que descobri que existem loucos que programam em microcódigo, escrevendo para CPUs, e nem vou entrar na insanidade do FPGA.

O venerável Z80 (Crédito: Wikimedia Commons)

A IA é mais uma ferramenta, é mais uma camada. Ela vai acabar com todas as outras? Sinceramente, ninguém sabe, mas ela vai acabar com uma classe importante: O desenvolvedor júnior.

É mais rápido para um analista experiente produzir código usando IA, do que especificar funções e algoritmos, repassar para os juniores e depois lidar com o trabalho de revisar e certificar o código de cada um.

O senso comum aponta o contrário, faria sentido ter menos profissionais caros, e mais iniciantes usando a IA para tirar dúvidas e produzir código de melhor qualidade, mas não é assim que a banda toca.

Existe uma máxima na Informática: Um computador faz o que você manda ele fazer, não o que você quer que ele faça, e saber o que pedir é muito mais complicado do que parece.

Para começo de conversa, o cliente não sabe o que ele quer. Ele não sabe especificar, não sabe definir as regras de negócio e não conhece seu fluxo operacional. É preciso um profissional para entrevistar, auditar e especificar o sistema que o cliente precisa, não o que ele imagina querer.

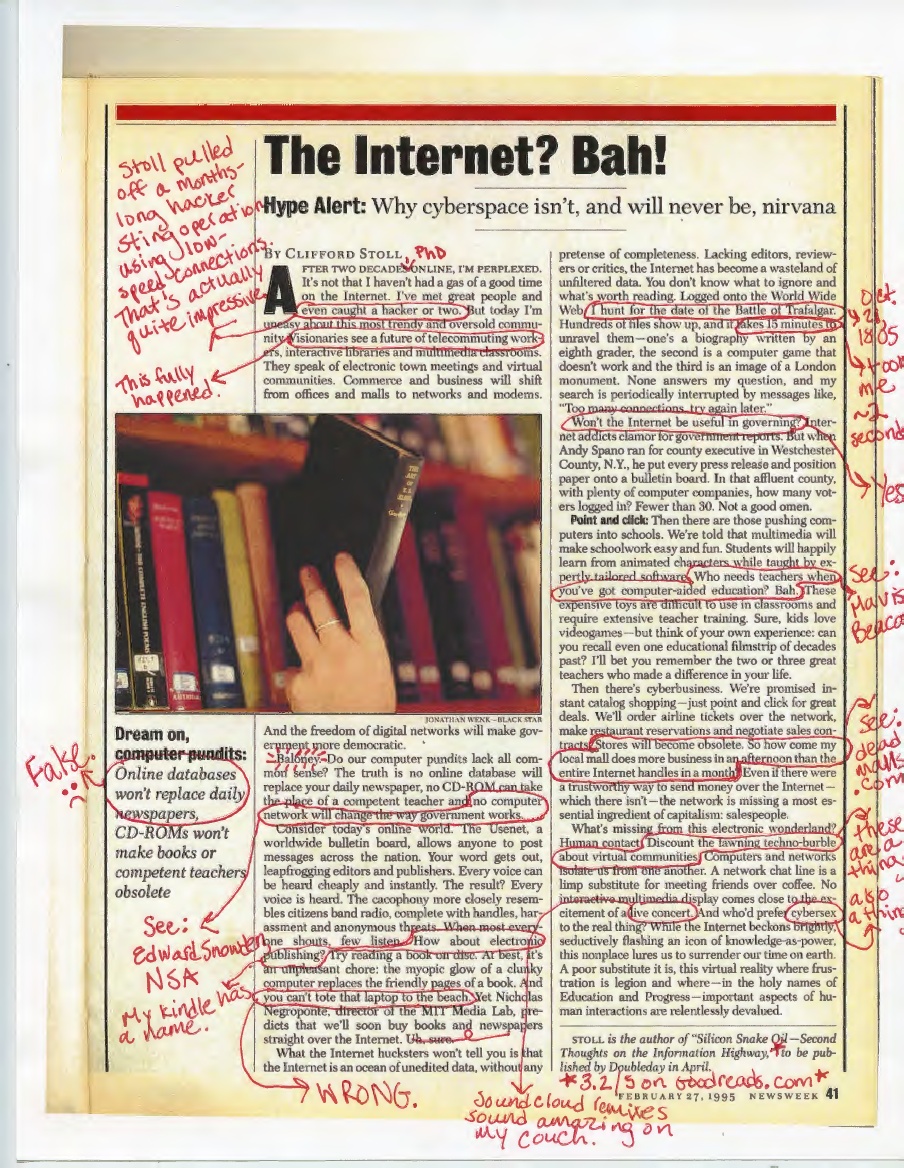

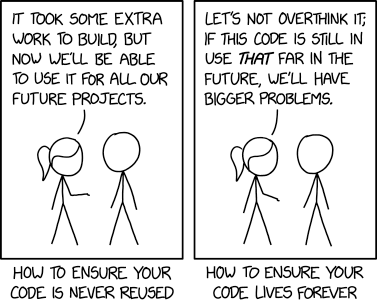

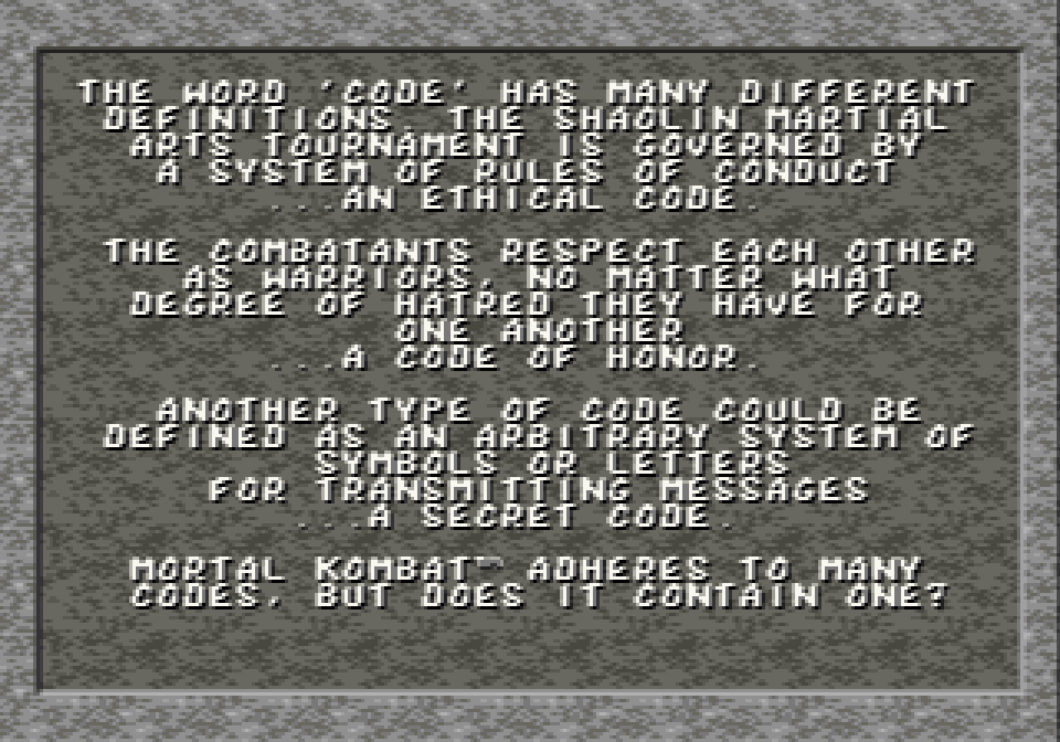

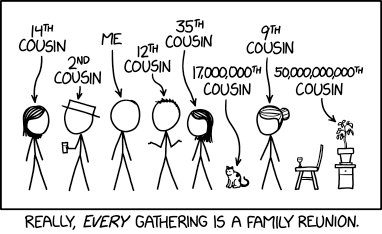

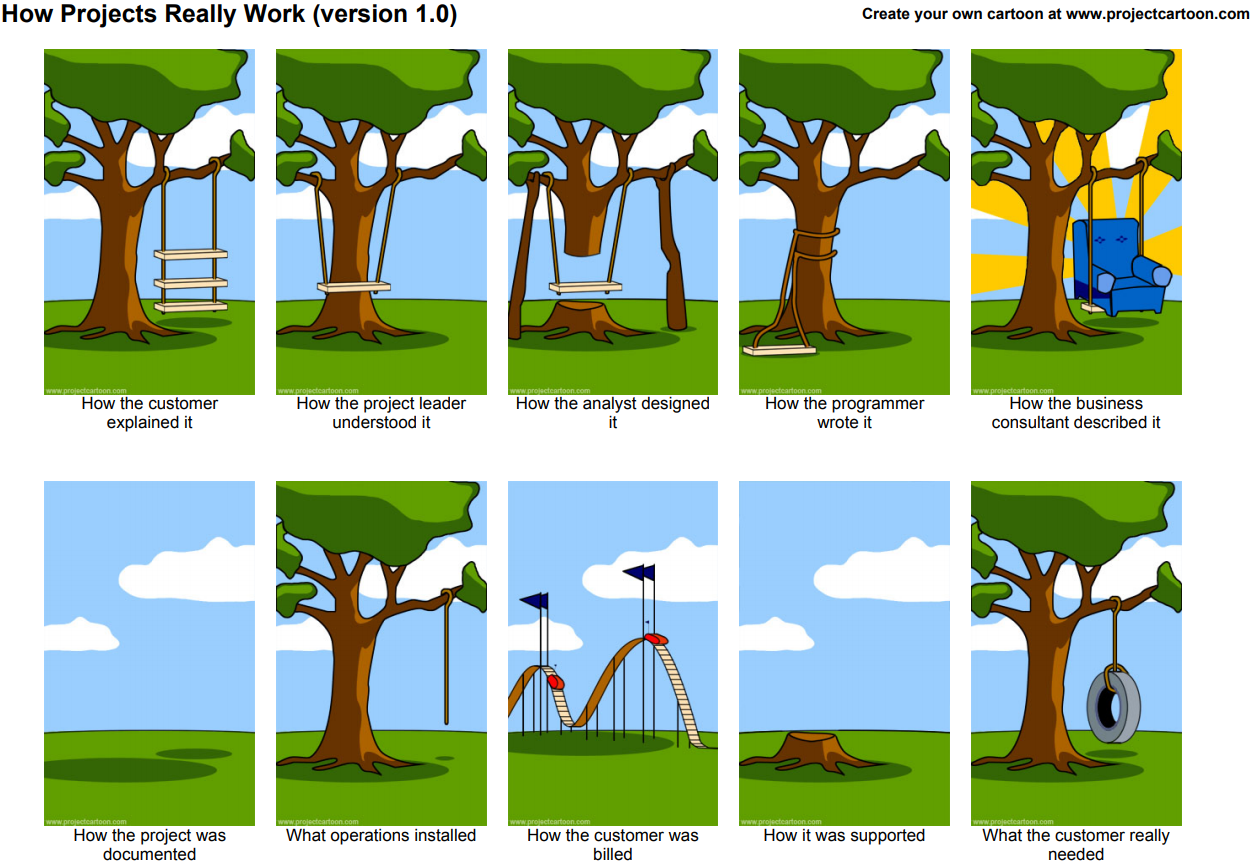

Um clássico. (Crédito: Reprodução Internet)

Descrever um algoritmo complexo é mais complicado do que codificá-lo. É preciso saber o que você quer, e saber descrever de forma que a IA entenda, isso demanda imaginação e conhecimento, características não tão comuns entre o afegão médio.

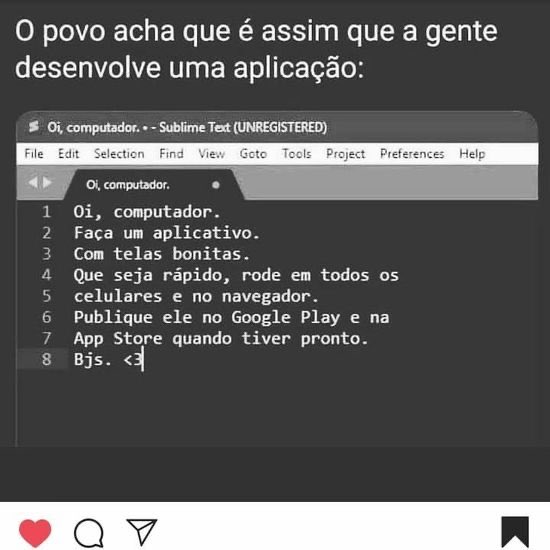

Prevejo grandes oportunidades de emprego e crescimento profissional para engenheiros de software com bastante imaginação e capacidade de comunicação. E isso vale para todas as áreas. Você vai precisar se comunicar com a IA, ela não tem poderes mágicos para adivinhar o que você quer fazer. Aquele velho meme, que agora dizem que envelheceu mal, continua perfeitamente atual:

O tal meme (Crédito: Reprodução Internet)

“Faça um aplicativo” não quer dizer nada, do mesmo jeito que “folha de pagamento” é apenas uma classificação genérica.

Uma pessoa que nunca cozinhou na vida dificilmente conseguiria instruir um cozinheiro novato a fazer um bolo, já o Gordon Ramsey vai xingar bastante, repetir muitos passos mas o novato produzirá um bolo excelente.

O problema aqui é que leva anos até um profissional de TI conseguir montar o arcabouço de conhecimento necessário para especificar sistemas e algoritmos de forma eficiente, e o AIpocalipse está mirando nos novatos.

Há um risco real dos iniciantes não conseguirem entrar no mercado de trabalho, e mesmo entrando, não adquirirem os conhecimentos necessários. Os mais experientes eventualmente sairão do mercado, sobrará um vácuo com excelentes IAs mas sem gente para instruí-las.

Quem Viver, verá

Uma velha maldição chinesa diz “Espero que você viva em tempos interessantes”, mas dessa vez exageraram. Todo mundo já estava agitado o suficiente vendo (mais) uma Guerra Mundial gestando na Europa, agora essas aplicações de Inteligência Artificial caem de paraquedas no colo da gente. E ainda estamos em março!

Ninguém sabe o que fazer com a IA. O Google diz que vai diminuir a relevância de sites que usem textos gerados pelo ChatGPT, mas por quanto tempo vão fazer isso? Quando todo mundo estiver usando, a penalização do Google se tornará irrelevante.

Há listas com mais de 400 aplicações usando a API do ChatGPT, todo dia surgem novas e criativas ferramentas, todas ainda apenas arranhando a superfície.

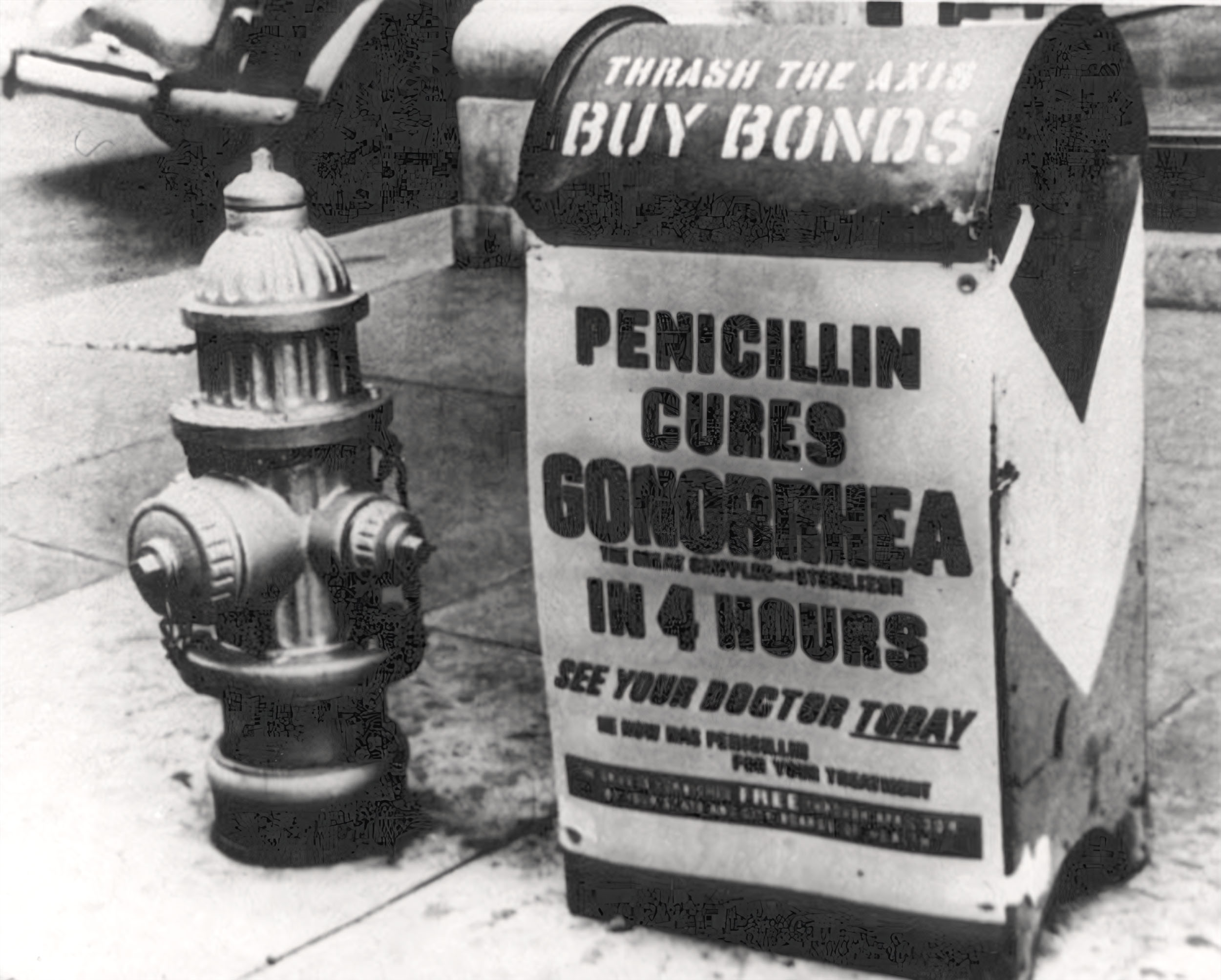

Em 1943 uma menina chamada Patricia Malone tinha dois anos e idade e alguns dias de vida restante até sucumbir a uma sepse. Um jornalista fez uma campanha-relâmpago para que o Governo dos EUA recolhesse todas as doses disponíveis da altamente experimental Penicilina, e tratassem Patricia. Isso foi feito, e em algumas horas ela estava se recuperando.

O CEO da Pfizer acompanhou o caso. Ele não acreditava muito na Penicilina, mas vendo o caso, e tendo uma filha que morreu da mesma doença, instruiu a empresa investir massivamente na nova droga. Hoje tratamos em casa doenças que seriam fatais 50 anos atrás.

Satya acha que a IA será uma revolução como o iPhone. Eu acho que ele está sendo conservador. A IA tem potencial de mudar o mundo como a eletricidade ou os antibióticos.

Fikadika (Crédito: Domínio Público)

O que não foi boa notícia para acendedores de lampião, fabricantes de velas e bactéria.

A lição é: Não seja uma bactéria. Entre em modo Full Darwin, estude como a IA irá mudar sua área de atuação, descubra como torná-la uma aliada, como você pode agregar a IA ao seu trabalho, crie uma simbiose. Não perca tempo brigando, tentando mostrar a IA como o inimigo. Ela é inevitável, e não tem engrenagens para você jogar seus tamancos.

A IA tem potencial de afetar todos os ramos da sociedade e da cadeia produtiva. Resistir a ela é fútil, logo teremos aplicações de IA em todos os cantos, de Call Centres a elevadores.

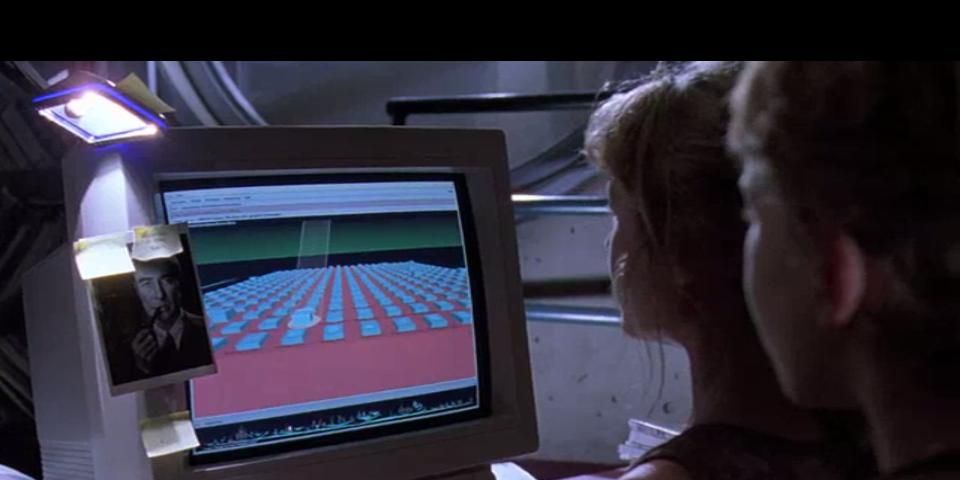

Em uma cena da última temporada de Westworld, a roboa Dolores está trabalhando em uma indústria de entretenimento, escrevendo histórias. Ela descreve os personagens e situações de forma bem genérica, e o computador cuidado do resto, preenchendo as lacunas, criando imagens e contexto.

Quem diria que uma cena que em 2022 era ficção científica o bastante para se passar em 2058 estaria prestes a se tornar realidade em 2023. Estamos prestes a migrar para uma Era onde informação deixará de ser escassa, a IA responderá muitas perguntas práticas, e talvez até algumas filosóficas.

Depende de cada um escolher se lutar contra a IA, se recusar a usar os serviços atrelados a ela, e manter seu trabalho como está, o que inevitavelmente levará ao AIpocalipse, ou se vai surfar essa nova onda na crista, se adaptando e usando a IA como uma ferramenta maravilhosa, o que poderá nos levar a uma UtopIA.

A única certeza é que no futuro da IA ninguém encerrará um texto com um trocadilho horrendo desses.

AIpocalipse: Vamos todos perder o emprego ou a IA trará a Utopia?