PIK-Direktor Hans Joachim Schellnhuber: [5] Im Mittelpunkt des Politikpapiers steht die Frage, wie eine zeit–gerechte Transformation gestaltet werden kann … Verursacher des Klimawandels in die Pflicht nimmt… Rechtsschutz schaffen für all jene Menschen, die von den Folgen des Klimawandels geschädigt werden; einen Klimapass für die menschenwürdige Migration derer, die aufgrund des Klimawandels ihre Heimat verlassen müssen sowie einen Transformationsfonds für einen gerechten Strukturwandel..

So steht es im aktuellen WBGU-Politik-Strategiepapier [5]: Zeit–gerechte Klimapolitik: Vier Initiativen für Fairness,

welches die an die Unkenntnis und Faktenignoranz ihrer Vorgängerin nahtlos anknüpfende Svenja Schulze (Langzeitstudium: Germanistik und Politikwissenschaft) und der Staatssekretär im BMBF, Georg Schütte (Studium: Medien- und Kommunikationswissenschaftler) vom Forschungsministerium, trotz seiner teils abstrusen Aussagen huldvoll annahmen.

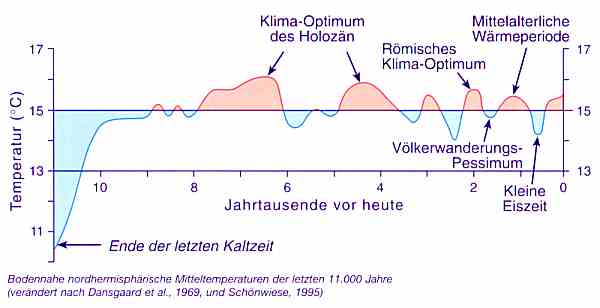

Dieses WBGU „Strategiedokument“ behauptet im Kapitel „Klimawissenschaftlicher Hintergrund“, dass alleine der menschliche CO2-Ausstoß für die jüngeren Klimabewegungen verantwortlich ist, obwohl sich die abrupt seit ca. einer Millionen Jahre ca. alle 100.000 Jahre regelmäßig wiederkehrenden Eiszeiten ohne CO2-Einfluss entwickelten:

[18] … Die Deglaziation wird nicht durch CO2, sondern durch Orbitalzyklen angestoßen.

CO2 verstärkt jedoch das Ausmaß der Erderwärmung, das nicht durch Orbitalzyklen allein erklärt werden kann und sorgt zudem für eine Verteilung der Erwärmung über den gesamten Globus.

Und obwohl inzwischen bekannt ist, dass die häufige Aussage, in neuerer Zeit beobachtete Wetteränderungen seien in Häufigkeit und Geschwindigkeit in der Vergangenheit „noch nie dagewesen“, oft lediglich auf falschen Analysen beruhen. Das Strategiepapier jedoch „belegt“ dessen angeblich schlimmen Auswirkungen anhand von Studien, welche teils nichts anderes bieten, als neu parametrierte Simulationen, welche immer neue, noch schlimmere Klimazukunftsvisionen als alle bisher bekannten auszuspucken vermögen.

WBGU, Zeit-gerechte Klimapolitik: [5]: … Ein Beispiel für die schädlichen Auswirkungen sind Extremwetterereignisse. Global betrachtet haben in den letzten Jahrzehnten die Stärke und die Häufigkeit solcher Ereignisse zugenommen (Herring et al., 2018).

„Herring et al., 2018“ ist eine Publizierung von 166 Seiten, in denen verschiedenste, weltweite Wetter-Extremereignisse auf statistische Signifikanz menschengemachten Temperatureinflusses analysiert wurden. Oft, indem mittels Simulationsläufen das „wirkliche“ Ereignis (ohne Klimawandel-Einfluss) „ermittelt“ und die Differenz als Beleg für einen menschengemachten Einfluss ausgewiesen wird. Allerdings kann in vielen Fällen keine Signifikanz ausgewiesen werden, was in der Studie dann steht, allerdings nicht im WBGU-Papier.

Herring et al., 2018 (Auszüge):

Model simulations indicate that anthropogenic climate change has made extreme snowstorms less likely over the mid-Atlantic United States. Empirical evidence shows no decline since 1901, with recent storms colder than before.

Grob übersetzt: Modellsimulationen zeigen, dass der anthropogene Klimawandel extreme Schneestürme in den mittelatlantischen Vereinigten Staaten weniger wahrscheinlich gemacht hat. Empirische Beweise zeigen keinen Rückgang seit 1901, wobei die jüngsten Stürme kälter waren als zuvor.

Northeast Brazil experienced profound water shortages in 2016 due to a five-year drought. Using multiple methods, we could not find sufficient evidence that anthropogenic climate change increased drought risk.

Grob übersetzt: In Nordostbrasilien herrschte 2016 aufgrund einer fünfjährigen Dürre ein ausgeprägter Wassermangel. Mit mehreren Methoden konnten wir keine ausreichenden Beweise dafür finden, dass der anthropogene Klimawandel das Dürrerisiko erhöhte.

A warm winter 2015/16 followed by a wet spring enabled exceptionally high ecosystem gross primary productivity on the Iberian Peninsula. Climate-ecosystem model simulations show warming winters and increased CO2 availability benefit ecosystem productivity, but no increase in spring precipitation.

Grob übersetzt: Ein warmer Winter 2015/16, gefolgt von einem nassen Frühling, ermöglichte auf der Iberischen Halbinsel eine außergewöhnlich hohe Bruttoproduktivität des Ökosystems. Klima-Ökosystem-Modellsimulationen zeigen wärmende Winter. Eine erhöhte Verfügbarkeit von CO2 wirkt sich auf die Ökosystemproduktivität positiv aus. Die Niederschlagsmenge im Frühling steigt nicht an.

Das wundert nicht, denn so ist es auch dem IPCC seit dem AR5 (2014) [15] und aktuell wieder bekannt:

EIKE 11. November 2018: Zum jüngsten IPCC-Bericht SR-15 von 2018: Von Klimakatastrophen keine Spur!

Der WBGU vermittelt davon vollkommen unbeeindruckt, jedoch ausschließlich eine Aneinanderreihung alarmistischer Aussagen:

WBGU [5]: … Die bis heute beobachtete globale Erwärmung bringt bereits schwerwiegende Veränderungen mit sich, die

sich ganz unmittelbar auf die Lebensbedingungen der Menschen auswirken. Auch in einer 2°C-Welt sind besonders die ärmsten Bevölkerungsgruppen, die bislang am wenigsten von den Vorteilen der Moderne profitieren konnten, am heftigsten betroffen (King und Harrington, 2018).

Diese Studie (King und Harrington, 2018) nimmt einfach an, dass Extremereignisse zunehmen und simuliert darauf aufbauend „Betroffenheiten“:

King und Harrington, 2018 [13]: [12] … Climate change is increasing the frequency of heat waves, changing rainfall patterns, raising sea levels and damaging coral reefs through increasing bleaching events.

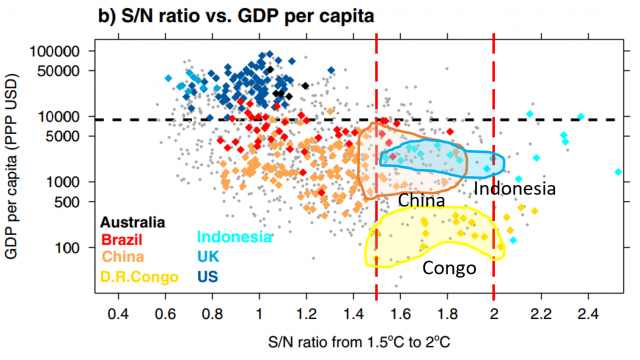

Aus Daten, wie sie das folgende Bild aus der Studie zeigt, „gelingt“ es den Studienautoren, zunehmende „Betroffenheiten“ zwischen einer Temperaturerhöhung von 1,5 Grad und 2 Grad „auszuweisen“.

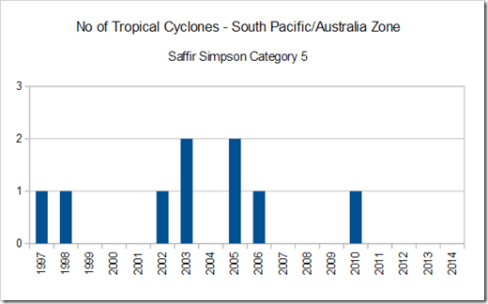

WBGU [5]: Zudem wird erwartet, dass die Stärke tropischer Wirbelstürme mit der Erwärmung weiter zunimmt – sowohl im Mittel als auch hinsichtlich der Zunahme von Stürmen der obersten Kategorie (Sobel et al., 2016).

Diese Studie „entdeckt“, dass derzeit zwar kein Trend mit zunehmender Intensität messbar ist. Aber sie „weiß“, dass dies nur daran liegt, weil in der Vergangenheit zu wenig Intensität vorlag. Und sie weiß auch den Grund: Aerosole haben die „wahren“ – also ohne die Aerosole viel höher ausgefallenen – Intensitäten unterdrückt. Die Studienautoren wissen angeblich ganz genau, was ihre Vorgänger falsch annahmen. Leider finden deren Nachfolger heraus, dass auch deren Annahmen noch viel falscher sein können:

Kaltesonne 15. November 2018: Klimamodelle rechnen mit falschen Rußdaten

Wie wurden die „richtigen“ Daten in „Sobel et al., 2016 „ermittelt? Durch Rückwärtssimulation. Da „klar“ ist, dass die Intensität mit steigender Temperatur zunehmen muss, fällt die simulierte Wirbelsturmzukunft nun natürlich viel schlimmer aus.

Irgendeine Reflexion, geschweige Erwähnung von Studien mit anderen Feststellungen dazu, ist im WBGU-Strategiepapier nicht zu finden, obwohl es davon ebenfalls genügend gibt:

kaltesonne 3.12.2013: Wer hätte das gedacht: Studien können keine Zunahme der tropischen Wirbelstürme im Indischen und Pazifischen Ozean feststellen

kaltesonne 21.12.2017: Neue Modellierungsergebnisse: Wirbelstürme werden in Zukunft wohl seltener und weniger intensiv

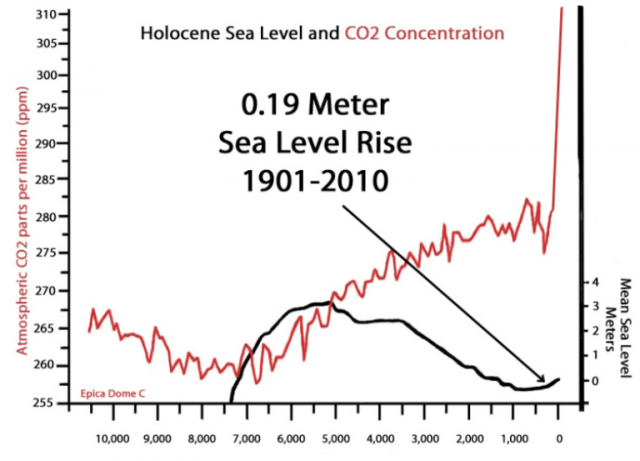

Weiter geht es mit den „Belegen“. Zum Meeresspiegelanstieg ist es nicht anders. Das „Wissensgremium“ textet dazu, dass die meisten Studien davon ausgehen, „dass sie bis mindestens Ende des 21. Jahrhunderts nur minimale Auswirkungen auf die Überschwemmungen haben werden“. Das entspricht allen Messungen, ist aber nicht alarmistisch. Also werden wieder Studien gelistet, welche es alarmistischer ausweisen.

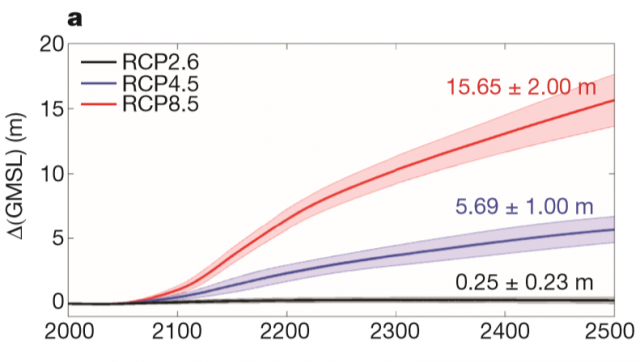

WBGU [5]: … Alleine das Schmelzen des antarktischen Eisschilds könnte bis zum Jahr 2100 über 1 m und bis 2500 über 15 m zum Meeresspiegelanstieg beitragen (DeConto und Pollard, 2016). Die höchsten Werte sind für die

Tropen zu erwarten, wo unter einem Business-as-usualSzenario ein Großteil der Atolle durch zunehmende

Überflutungen bereits bis Mitte des 21. Jahrhunderts unbewohnbar sein könnte (Storlazzi et al., 2018).

Liest man die zitierte Studie „DeConto und Pollard, 2016“, trifft man auf die Annahmen der Studienautoren, dass die Antarktis mit einer mittleren Landtemperatur von ca. -40 °C und einer bisher gemessenen Temperaturerhöhung von 1,2°C in hundert Jahren [11] auch vom Land her zu schmelzen beginnen könnte. Die Studienautoren geben zwar selbst zu, dass ihre Simulationsergebnisse rein spekulativ sind, aber als „Beleg“ ist so eine „Simulations-Spekulativstudie“ für die WBGU ausreichend, wissend, dass unsere Umweltministerin sicher niemals fachliche Hintergründe nachprüfen würde:

[6] DeConto and co-author David Pollard, a palaeoclimatologist at Pennsylvania State University in University Park, developed a climate model that accounts for ice loss caused by warming ocean currents — which can eat at the underside of the ice sheet — and for rising atmospheric temperatures that melt it from above.

Ultimately, he and Pollard tested how well different versions of their model simulated the past, and then used the ones that performed best to project future sea-level rise. They found that over time, atmospheric warming would become the main driver of ice loss.

“I think their processes are still a bit speculative, … suggests that Antarctic ice melt driven by rising greenhouse-gas emissions could boost global sea levels by up to 39 centimetres by 2100, and by as much as 3 metres by 2300.

Um die Verschlimmerung zu erreichen mussten die Autoren das Extremszenario RCP8.5 zusätzlich um alarmistische Annahmen erweitern. Das entsprechende Bild in „DeConto und Pollard, 2016“ sieht wie folgt aus:

Für das typische – zum Beispiel vom DWD in seinem Klimaatlas immer angezeigte – Szenario RCP2.6 liefert auch diese Studie für das Jahr 2100 nur einen simulierten Pegelanstieg von +11 (+-11 cm) und trifft damit gut den Wert, welchen der renommierte – aber nicht alarmistisch geneigte – Pegelfachmann, Prof. (Emeritus) Mörner als wahrscheinlichen Wert angibt.

Was in der Studie – aber nicht beim WBGU – steht: In vergangenen Warmzeiten war der Meeresspiegel bei gleicher CO2-Dichte auch schon 10 … 30 m höher als derzeit. Ohne auch nur entfernt zu wissen, woran das wirklich lag, wird einfach davon ausgegangen, dass bei den aktuellen, etwas über 400 ppm CO2 damit 30 m „zu wenig“ Pegel herrschen. Steigt das CO2 (oder auch nicht), „explodiert“ nach der CO2-Theorie folglich der Seepegel in den Simulationen.

Eine Kausalität, welche allerdings keinesfalls stimmen muss. Und auch nicht naheliegt, da es einen anderen Schluss zulässt: Der CO2 Gehalt hatte in der Vergangenheit (und damit auch heute) keinen signifikanten Einfluss auf den Meerespegel. Seine gravierenden Veränderungen um weit über 100 m haben andere Ursachen. Läge der Pegel im Jahr 2500 wirklich bei +15,65 m, würde sich lediglich wiederholen, was in vergangenen Eiszeiten ohne jegliches menschliche Zutun schon geschehen ist. Im Kampf gegen das CO2 wäre dann allerdings jeder Cent nutzlos vergeudet.

Hemmungslos wird nun allerdings wirklich alles gelistet, wenn es nur irgendwie einen Klimaalarm „belegen“ kann. Auf die Qualität der „Belegführung“ wurde dabei leider wenig geachtet:

WBGU [5]: … Auch der Anstieg des globalen Meeresspiegels hat sich durch die globale Erwärmung weiter beschleunigt (Chen et al., 2017; Nerem et al., 2018) und wird in den kommenden Jahrzehnten und Jahrhunderten die Lebensbedingungen vieler Millionen Menschen entscheidend prägen (IPCC, 2014)

Nehme man die Studie „Nerem et al., 2018“. Dieser „gelingt“ es wie üblich mit statistischen Tricks – eher Falschanwendung -, aus lange bekannten Daten „neue, bisher unbekannte Inhalte“ herauszurechnen, welche bisher angeblich alle Fachpersonen übersehen haben. Das Ergebnis: viel mehr Klimaalarm, als bisher geahnt wurde.

In einem Artikel wurde das vom Autor bereits rezensiert:

EIKE 06.03.2018: Flashcrash Klimaalarm. Wer Klimaalarm posaunt, bekommt immer recht (Teil 1)

kaltesonne informierte ebenfalls darüber: Der Meeresspiegel

Mitte Februar ging eine erschreckende Mitteilung durch alle Medien, auch die Tagesschau mahnte: Der Pegel steigt nicht linear sondern quadratisch und bis Ende des Jahrhunderts haben wir 65 cm zu erwarten! Bei linearem Anstieg mit den heutigen Raten von ca. 3mm/a wären es nur beherrschbare 25 cm. Was steckte dahinter? Die Eilmeldungen gingen zurück auf diese Arbeit unter Führung von Robert S. Nerem von der Universität Boulder/Colorado. Darin hatten die Autoren die Schwankungen des Meeresspiegels die ENSO erzeugt, aus den Beobachtungen heraus rechnen sollen. Ein ElNino lässt es im Ostpazifik viel mehr regnen und das viele Wasser im Ozean führt zu einem temporären Anstieg des globalen Meeresspiegels. Umgekehrt, bei einer LaNina, wird viel Regenwasser auf Land (besonders Australien) zwischengespeichert und dieser vorübergehende Mangel im Ozean ist auch global deutlich sichtbar.

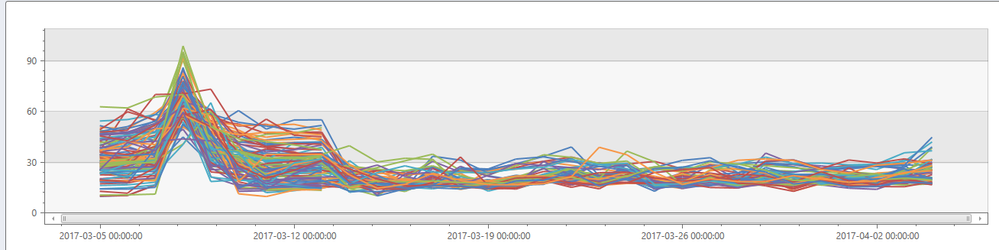

Wie Sie in Abb. 6 gut sehen können, hatten wir nahe dem Beginn der Satellitenaufzeichnungen 1998 einen Wasserüberschuss, nach 2010 einen Mangel und 2017 wieder zu viel. Die beteiligten Autoren entfernten jedoch diese natürlichen Schwankungen nicht vollständig, wie sich bald herausstellte. Dadurch ging der jüngste El Nino zumindest teilweise in die Rechnungen ein und beeinflusste den Trend, ebenso die LaNina 2011/12 und der ElNino 1997/98. Diese zeitliche Verteilung muss einen wachsenden Trend produzieren. Mit diesem Lapsus in den Daten legte man in Nerem et al (2018) einen quadratischen Fit und extrapolierte flugs bis 2100. Ein solches Verfahren impliziert einen Anfängerfehler, den man „Overfitting“ nennt. Eine viel zu kleine Datenbasis von 1993 bis 2017, hier auch noch fehlerbehaftet, erzeugt einen viel zu sicher geglaubten Trend bis 2100.

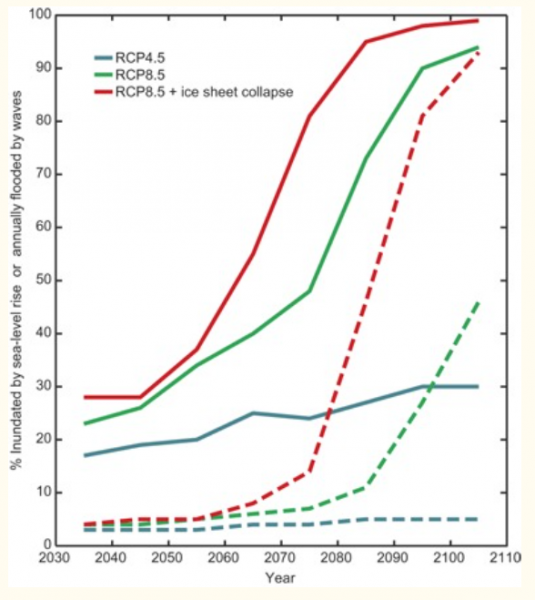

Weil auch dies immer noch nicht immer für einen großen Alarm „reicht“, dürfen beim WBGU Studien auch neue, schlimmer als die schlimmsten IPCC-Szenarien simulierende Zukunftsannahmen fabulieren: „scenarios, respectively (22–23); and RCP8.5+icesheet collapse“ ..

Entsprechend sind die Ableitungen der Anzahl Klimaflüchtlinge:

WBGU [5]: … Obwohl allein schon die Definition einer Migrationsentscheidung aufgrund des Klimawandels schwierig ist und deshalb auch die Zahlen in der Literatur stark voneinander abweichen (Adger et al., 2014), soll hier beispielhaft eine Abschätzung der Weltbank zu Binnenmigration genannt werden: Bis zum Jahr 2050 könnten in Afrika südlich der Sahara, Südasien und Lateinamerika mehr als 143 Mio. Menschen klimabedingt zum Aufbruch gezwungen werden (Rigaud et al., 2018).

Von der in der wissenschaftlichen Wirklichkeit diskutierten Problematik solcher Zählungen findet sich wieder keine Spur:

kaltesonne 14.3.2018: ETH Zürich zum Konzept eines klimawandelbedingten Flüchtlingsanstiegs: Spekulativ und nicht ausreichend durch solide Daten untermauert

kaltesonne: Ausführliche Kritiken an der Asyl-Prognose in „Science“

… In der aktuellen Ausgabe von „Science“ hatte ich eine Studie entdeckt, die mir seltsam vorkam. Anhand einer simplen statistischen Korrelation sagen die beiden Autoren die Auswirkung der globalen Erwärmung auf die Zahl von Flüchtlingen vorher, die aus Nordafrika nach Europa ziehen.

Meine Recherche ergab, dass die Studie tatsächlich äußerst zweifelhaft ist. Ich zitiere in meinem Artikel auf SPIEGEL ONLINE diverse Experten. Weil ich naturgemäß jeweils nur kleine Teile ihrer Aussagen zitieren konnte, stelle ich die interessanten Stellungnahmen der von mir befragten Wissenschaftler hier in voller Länge vor:

Weiterlesen im Blog von Axel Bojanowski.

Teil 2 des Weihnachtswunders steuerte der ansonsten in Klimafragen so unkritische Focus bei. Auch dort lehnte man die neue Arbeit ab und verwahrte sich gegen aktivistisch gefärbte Forschung. War Michael Odenwald bereits im Weihnachtsurlaub? Focus am 22. Dezember 2017:

“Hochspekulativ und dumm”: Forscher zerlegen Studie, die neue Flüchtlingswelle prognostiziert

[..] Doch nun regt sich in der wissenschaftlichen Gemeinde Zweifel an der Studie. William Briggs von der Universität Cornell sagte gegenüber dem “Spiegel“: “Die dümmste, idiotischste Anwendung von Statistik, die ich seit Langem gesehen habe.” Auch Tobias Ide vom Georg-Eckert-Institut in Braunschweig warnt davor, “den Zusammenhang zwischen wärmeren Temperaturen und Migration derart vereinfacht darzustellen”. Die Wissenschaftlicher der Columbia University hatten demnach lediglich analysiert, wie hoch und lange die Temperatur in den Maisanbaugebieten bestimmter Länder über 20 Grad gestiegen war – und dann festgestellt, dass in solchen Zeiten mehr Asylanträge aus diesen Ländern gestellt wurden.

Ganzen Artikel auf focus.de lesen.

Auffällig ist, dass das Hauptproblem vieler in den Vulnerabilitätssimulationen betrachteten Länder – die extreme Geburtenrate und zunehmend auch „Sozialleistungsmigration“ [16] – (bewusst?) keine Erwähnung und Betrachtung findet. Für die WBGU gilt für alle aktuellen und zukünftigen Übel als Ursache alleine das anthropogene CO2.

Zur Begründung wiederholt das Strategiepapier einfach alle bekannten Allgemeinplätze:

WBGU [5]: .. Im 21. Jahrhundert stehen wir am Beginn einer Flüchtlingskrise, die sich bezüglich Ursache und Dynamik nicht mit der des frühen 20. Jahrhunderts vergleichen lässt, aber schlussendlich zu noch größerem Leid führen könnte. Die Rede ist von der anthropogenen Erderwärmung, die den Meeresspiegel steigen lässt, den globalen Wasserkreislauf verändert, die Extremwetterregime verschärft ganze Vegetationszonen verschiebt und dadurch die Lebensgrundlagen von hunderten Millionen Menschen bedroht. Bereits heute, da die planetare Oberflächentemperatur nur um etwa 1°C gestiegen ist, kommt es zu klimabedingten Migrationsbewegungen (Ionesco et al., 2017; IDMC und NRC, 2017).

Die durch den Bürgerkrieg in Syrien ausgelöste Flüchtlingskrise im Nahen Osten und Europa dürft schon ursächlich mit dem Klimawandel verknüpf sein, denn eine Jahrtausenddürre im „Fruchtbaren Halbmond“ verschärft ab 2011 die sozialen und politischen Spannungen in der Region (Kelley et al., 2015, 2017).

Auch dazu keinerlei Erwähnung kritisch eingestellter Darstellungen:

EIKE 22.02.2016: SPIEGEL ONLINE: Der Klimawandel ist nicht für den Syrienkrieg verantwortlich

EIKE 21.09.2016: Ist der „Arabische Frühling“ wirklich wegen unserem CO2 gescheitert? Eine von Herrn Rahmstorf begrüßte Studie legt es nahe

kaltesonne 29.2.2016: Deutsches Klimakonsortium pfeift Rahmstorf zurück: Klimawandel ist nur ein Treiber von vielen im Syrienkonflikt

Und weiter geht es im ausschließlich klimaalarmistischen Stil.

WBGU [5]: .. Völlig unbestreitbar ist der kausale Zusammenhang zwischen dem menschengemachten Klimawandel und der Existenzbedrohung flacher Inselstaaten. Selbst wenn die Begrenzung der Erderwärmung auf 2°C gelingen sollte, dürft ein Meeresspiegelanstieg im Meterbereich ganze Territorien versenken – und damit nationale Identitäten im konventionellen völkerrechtlichen Sinn auslöschen (Storlazzi et al., 2018). Die entsprechenden Staatsvölker können ihr Überleben dann nur durch Verlassen ihrer schwindenden Länder sichern.

Während aktuell keine AGW-zuordenbare Bedrohung festgestellt werden kann:

EIKE 27. April 2018: SOS Südsee – Der Ozean steigt nicht übernatürlich, dafür umso stärker die Propaganda in der öffentlich-rechtlichen Berichterstattung (Teil 2)

„gelingt“ es dieser zitierten Studie „Storlazzi et al., 2018“ in Simulationen und unter Annahme besonders schlimmer Randbedingungen und Verstärkungseffekte, Zukunftsbedrohungen zu erzeugen.

Jeder Vernünftige (zumindest der Autor) würde das Papier postwendend zurückweisen und dem Beirat auferlegen, erst einmal eine neutral bewertende und damit glaubhafte Darlegung zu erarbeiten, beziehungsweise diesen Beirat als für solche Aufgaben wohl ungeeignet in Frage stellen. Dazu muss man kein Fachmann sein, sondern nur eben einige der zitierten, „belegenden“ Studien orientierend sichten und sich über den wirklichen Wissensstand, vor allem die weltweiten Messdaten informieren.

Wenn es um Klimapolitik geht, sucht man solches im Berliner Politikbetrieb leider vollkommen vergeblich. Und die Auswahl der Beiratsmitglieder erklärt es auch: Die „Fachwissenschaft“ Klima – hier allerdings nur im Rahmen von Klima-Simulationen, denn das PIK forscht nicht wirklich übers Klima – ist alleine durch Herrn Schellnhuber vom PIK repräsentiert, der Rest sind wohl ohne Übertreibung „Nachläufer“ zur Umsetzung seiner Visionen [10].

Beirat des WBGU

Prof. Dr. Sabine Schlacke (Vorsitzende): Rechtswissenschaftlerin

Prof. Dr. Dirk Messner (Vorsitzender): Politikwissenschaftler

Prof. Dr. Martina Fromhold-Eisebith: Wirtschaftsgeographin

Prof. Dr. Ulrike Grote: Agrar- und Entwicklungsökonomin

Prof. Dr. Ellen Matthies: Psychologin

Prof. Dr. Karen Pittel: Ökonomin

Prof. Dr. Dr. h.c. Hans Joachim Schellnhuber CBE: Physiker

Prof. Dr. Ina Schieferdecker: Digitalisierungswissenschaftlerin

Prof. Dr. Uwe Schneidewind: Nachhaltigkeitswissenschaftler

C. Roth ist dafür nur eines der vielen möglichen Beispiele. Wohl überall, wo man das Hirn abschalten und einem GRÜNEN, oder Antifa-Mainstream hinterherlaufen kann, ist sie dabei. Da dürfen die Klimaflüchtlinge nicht fehlen.

WELT 09.11.2018: [1] Vor dem Parteitag der Grünen hat Claudia Roth eine Ausweitung des Asylrechts etwa für Klimaflüchtlinge gefordert.

Vor dem Grünen-Parteitag in Leipzig fordert die frühere Vorsitzende Claudia Roth, das Asylrecht zu erweitern. „Wir müssen die Kriterien für das Recht auf Asyl ausbauen. Beispielsweise ist der Klimawandel mittlerweile eine Fluchtursache“, sagte die Bundestagsvizepräsidentin dem Redaktionsnetzwerk Deutschland. Die EU müsse als eine Hauptverursacherin der Klimakrise mit einer Initiative zur Aufnahme bedrohter Menschen vorangehen.

WELT 09.11.2018: [1] … Unterstützung bekam sie von Grüne-Jugend-Chefin Ricarda Lang. Erstes Ziel müsse sein, dass durch eine „radikale Klimapolitik“ Menschen am besten erst gar nicht in die Lage gebracht werden sollten, ihre Heimat zu verlassen. Für Inselstaaten wie Kiribati reiche das aber nicht mehr aus, sie würden bald unbewohnbar. „Diese Menschen müssen die Chance zur frühzeitigen und würdevollen Migration erhalten“, sagte sie …

Man würde meinen, im Zeichen von Internet und google kämen solche Personen irgendwann doch noch auf die Idee, sich die leicht erreichbaren Fakten anzusehen. Wenn es allerdings die WBGU-Beiratsmitglieder, welche sich alle als Professoren ausweisen schon nicht machen, und Umweltminister*innen, sowie die regelmäßig auf Spesen zu den Klimagipfeln eilenden ca. 30.000 „Fachpersonen“ ebenfalls nicht:

[17] EIKE 27.11.2017: Die Rede unseres Bundespräsidenten, F. W. Steinmeier auf COP23 über den Klimawandel war (k)eine investigative Sternstunde – Teil 1 (2)

Wie kann man es dann von politischen (möchtegern-)Größen erwarten. Leider summiert sich Halbwissen statistisch nicht und damit bleibt ideologiebedingt bestehen, was wir aktuell schon haben.

EIKE 15.04.2017: Im Klimawandel-Unterricht bitte üben, wie man unsere Regierung zum Bezahlen von Schutzgeldern auffordert

EIKE 12.06.2017: Fake News: Zuerst der SWR, nun der BR: Ein Südseeparadies versinkt im Meer. Öffentlich-Rechtliche Klimawandel-Agitation in Endlosschleife

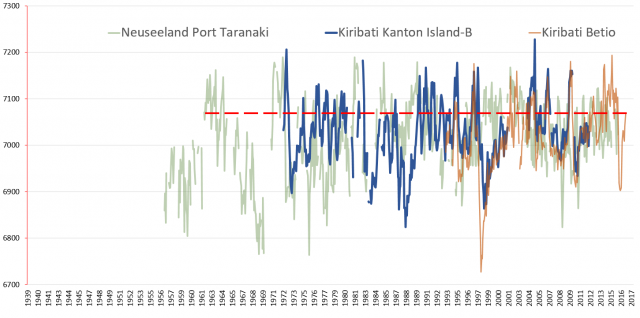

Es lässt sich zeigen, dass ausgerechnet das laut dieser Frau Lang „bald unbewohnbare“ Kiribati mit einem gemessenen Pegelanstieg von 0,58 mm/pa (5,8 cm in hundert Jahren) die niedrigste Anstiegsrate aller Pazifikinseln (und weit unter dem Weltdurchschnitt) aufweist. Einfach nur unverschämt, wie daraus abgeleitet wird, dass diese Atollgruppe „bald unbewohnbar“ würde (und es die Redaktion der „WELT“ unkommentiert weitergibt).

Jeder sollte sich die 10 Minuten Zeit nehmen und das Video der Präsentation dieser GRÜNEN Europawahl-Kandidatin ansehen.

Man muss sich allerdings trotzdem fragen, ob die GRÜNEN nicht zuletzt noch von einer inzwischen außer Kontrolle geratenen Kanzlerin überholt werden:

Tichys Einblick 13. November 2018: Migration – einklagbares Recht unter dem Dach der Bundesrepublik

Quellen

[1] WELT 09.11.2018: Claudia Roth fordert eine Ausweitung des Asylrechts

Stand: 09.11.2018

[2] Achgut 09.11.2018: Wenn das Klima in die Flucht treibt

[3] NDR Talkshow: Grünen-Vorsitzende Annalena Baerbock

[4] ScienceScepticalBlog 28. September 2018: Der Meeresspiegelanstieg

[5] PIK Nachrichten 31.08.2018:Zeit-gerechte Klimapolitik: vier Initiativen für Fairness

[6] DeConto und Pollard, 2016, Nature 2016: Antarctic model raises prospect of unstoppable ice collapse Sea levels could rise by more than 15 metres by 2500 if greenhouse-gas emissions continue to grow.

[7] EIKE Der jüngste IPCC-Bericht SR-15 von 2018: Von Klimakatastrophen keine Spur!

[8] Storlazzi et al., 2018: Most atolls will be uninhabitable by the mid-21st century because of sea-level rise exacerbating wave-driven flooding

[9] WBGU Politikpapier 9, 2018: Zeit–gerechte Klimapolitik: Vier Initiativen für Fairness

[10] EIKE 25.05.2018: Zu jedem Parteitag eine Freifahrt in der Klima-Geisterbahn

[11] Umweltbundesamt: Das Klima der Antarktis

[12] Resilience: King und Harrington, 2018 Exceeding 1.5C of Global Warming will Hit Poorest the Hardest

[13] King und Harrington, 2018: The Inequality of Climate Change From 1.5 to 2°C of Global Warming

[14] EIKE 12.06.2017: Fake News: Zuerst der SWR, nun der BR: Ein Südseeparadies versinkt im Meer. Öffentlich-Rechtliche Klimawandel-Agitation in Endlosschleife

[15] EIKE, 20.06.2017: Gegen Klimaflüchtlinge helfen nur noch C. Juncker und der Pariser Klimavertrag Alternativ: Nicht der Klimawandel bedroht uns, sondern unsere Politiker

[16] EIKE 09. Juli 2018: Überbevölkerungsprobleme bekämpfen wir ganz aktiv – durch noch mehr CO2-Reduktion

[17] EIKE 27.11.2017: Die Rede unseres Bundespräsidenten, F. W. Steinmeier auf COP23 über den Klimawandel war (k)eine investigative Sternstunde – Teil 1 (2)

[18] Klimafakten.de: Behauptung: „Der CO2-Anstieg ist nicht Ursache, sondern Folge des Klimawandels“

Der Studie von Laure Resplandy et al. zufolge, welche diesen Monat in dem angesehenen Journal Nature veröffentlicht worden ist, ist eine große Menge der fehlenden Wärme aus der globalen Erwärmung – 60% mehr als bislang gedacht – von den Ozeanen absorbiert worden.

Natürlich löste diese schockierende Entdeckung in den Mainstream-Medien viel Begeisterung aus. Umwelt-Korrespondenten auf der ganzen Welt sprachen von dem Beweis, dass die Globale-Erwärmung-Krise viel schlimmer als jemals ist.

Allerdings war diesem so bejubelten Untergangs-Szenario nur ein kurzes Leben beschieden. Ein unabhängiger Analyst, nämlich Nic Lewis, nahm die Studie unter die Lupe und erkannte sofort, dass sie auf einer völlig falschen Mathematik beruht.

Das Global Warming Policy Forum berichtet:

Der unabhängige Klimawissenschaftler Nicholas Lewis hat einen grundlegenden Fehler entdeckt in einer wissenschaftlichen Studie aus jüngster Zeit, welcher in den englisch-sprachigen Medien breiter Raum zur Verfügung gestellt wurde. Die Studie, durchgeführt von einem Team unter Leitung des Ozeanographen bei Princeton Laure Resplandy, behauptet, dass sich die Ozeane schneller erwärmt haben als ursprünglich gedacht. In den Nachrichten vieler Medien, darunter BBC, der New York Times, der Washington Post und des Scientific American, wurde berichtet, dass die Bedeutung dieses Ergebnisses darin liegt, dass sich die Erde sogar noch schneller erwärmen könnte als gegenwärtig eingeschätzt.

Allerdings hat Lewis herausgefunden, dass der Erwärmungstrend in der Resplandy-Studie erheblich von dem Trend abweicht, welcher sich aus den der Studie beigefügten Daten ergibt. Lewis hat viele begutachtete Studien zum Thema Klima-Sensitivität durchgeführt und mit einigen führenden Klimawissenschaftlern der Welt zusammengearbeitet.

„Berechnet man den Trend korrekt, ist der Erwärmungstrend keineswegs schlimmer als gedacht – er liegt vielmehr sehr auf der Linie früherer Schätzungen“, sagt Lewis.

Lewis zufolge sind tatsächlich auch einige andere Behauptungen in der Studie, die ebenfalls Eingang in die Medien gefunden hatten, ebenfalls falsch.

„Ihre Behauptungen zu der Auswirkung einer schnelleren Ozean-Erwärmung auf Schätzungen der Klima-Sensitivität (und damit der zukünftigen globalen Erwärmung) sowie bzgl. des Kohlenstoff-Budgets sind sowieso falsch, aber das ist ein zweitrangiger Punkt verglichen mit ihrem Berechnungsfehler, von dem wir jetzt wissen“.

Inzwischen hat einer der Ko-Autoren der Studie, nämlich Ralph Keeling, die Flucht nach vorn angetreten und den Fehler eingeräumt – und darauf hingewiesen, dass dieser Fehler die ganze Studie effektiv invalide macht:

„Unglücklicherweise haben wir hier Fehler gemacht“, sagte Ralph Keeling, ein Klimawissenschaftler beim Scripps und Ko-Autor der Studie. „Ich denke, die hieraus zu ziehende Hauptlehre ist, dass man so schnell wie möglich den Fehler fixieren muss, wenn man ihn gefunden hat“.

Keeling zufolge besteht das zentrale Problem darin, wie die Forscher mit der Unsicherheit in ihrem Messungen umgegangen waren. Als Folge davon werden die Ergebnisse beeinträchtigt durch zu große Zweifel, um definitiv die Schlussfolgerung der Studie darüber zu stützen, wie viel Wärme die Ozeane nun wirklich mit der Zeit absorbiert haben.

Die zentrale Schlussfolgerung der Studie – nämlich dass die Ozeane sogar noch mehr Energie zurückhalten als das Klimasystem der Erde in jedem Jahr – liegt auf einer Linie mit anderen Studien, welche zu ähnlichen Ergebnissen gekommen waren. Und das hat sich trotz der Fehler kaum geändert. Aber Keeling sagt, dass die falschen Berechnungen der Autoren bedeuten, dass tatsächlich eine viel größere Fehlerbandbreite in den Ergebnissen vorhanden ist. Das wiederum bedeutet, dass die Forscher diesen Ergebnissen viel weniger Gewicht beimessen dürfen als gedacht.

„Ich übernehme die Verantwortung für das, was hier geschehen ist, weil es meine Aufgabe ist sicherzustellen, dass jene Art von Details bekannt gemacht wird“. Soweit Keeling.

Es gibt hier aber noch weitergehende Lehren, welche – wie schon so oft zuvor – wahrscheinlich vom Klima-Alarmisten-Establishment vollständig verloren gehen.

Eine Lehre lautet, dass Klimaskeptiker keine wissenschaftlichen Ignoranten sind. Sie weisen eine große Vielfalt unabhängiger Experten auf wie Nic Lewis. Sie alle haben sich bei vielen Gelegenheiten als intellektuell gewandter und besser informiert erwiesen bzgl. Klimawissenschaft als die alarmistischen „Konsens“-Torwächter in Akademien und Institutionen wie NASA und NOAA.

Eine weitere Lehre ist – wie schon seit Klimagate klar ist – dass das Begutachtungs-Verfahren für wissenschaftliche Studien, besonders wenn diese etwas mit Klimawandel zu tun haben, ad absurdum geführt worden ist. Zu oft war es einfach ein kumpelhaftes Begutachtungs-Verfahren, in welchem man sich gegenseitig auf die Schultern klopfte ob der hervorragenden Leistungen. Der Appetit der Alarmisten auf „Beweise“, welche ihre Untergangs-These stützen ist: je ängstigender die Ergebnisse sind, umso wahrscheinlicher ist deren Veröffentlichung.

Eine dritte Lektion lautet, dass man den Mainstream-Medien einfach nicht vertrauen kann, dass sie irgendwie gearteten Zweifeln an alarmistischen Studien Raum geben. Kein Umwelt-Korrspondent verfügt über die erweiterten mathematischen Kenntnisse, welche Nic Lewis an den Tag legte beim Auffinden der Fehler in der Studie.

Aber es bleibt die Tatsache, dass es keinen einzigen Wissenschafts- oder Umwelt-Korrespondenten gibt in Verbindung mit einer Veröffentlichung in den Mainstream-Medien, der darauf vorbereitet ist, Angst erzeugende Studien bzgl. globaler Erwärmung angemessen zu beurteilen. Sie sind allesamt dem alarmistischen Konsens so verhaftet, dass sich fast nie die Mühe machen, eine Presseerklärung zu korrigieren.

Und schließlich, man erwarte nicht, dass dieser beschämende Widerruf auch nur ansatzweise so hervorgehoben wird wie die Original-Story. Genau so funktioniert nämlich die Angst-Masche: Die Hysterie wird stets nur gesteigert, aber niemals zurück gefahren.

Übersetzt von Chris Frey EIKE

Die Stimme: Tja, das liegt nun an dem CO2. In der Luft sind insgesamt etwa 0,4 Promille enthalten. Das ist natürlich nur ein Spurengas. Rechnen wir einfach jedes Jahr mit einer Zwei und Spurengas, also 2,0004 * 2,0004 und tun alles, was mehr als 4 ist, in eine extra Schachtel. Diesen Rest fügen wir unserem jährlichen Ergebnis hinzu. Dann sieht in den ersten Jahren alles so aus wie immer, den Inhalt der Schachtel können wir glatt vernachlässigen. Aber, bereits nach rund 645 Jahren ist der winzige Rest zu einer ganzen Zahl gewachsen und es kommt dann 2 x 2 + Rest = 5 raus! Und das ist eine Katastrophe: Keine Brücke würde mehr halten, kein Kraftwerk funktionieren und die Zivilisation würde zusammen brechen! Also, damit siehst Du, das auch solch kleine Spuren etwas bewirken, wenn es nur lange genug zum Wirken aufgehoben wird.

Ich: Das ist ja nur ein Taschenspielertrick und hat mit Mathematik gar nichts zu tun. Die Realität ist doch ganz anders. Genauso wie die Behauptung, die – wie auch immer errechneten – 0,7 Grad C /100 Jahre Temperaturerhöhung wären schlecht für die Menschheit. Wir wissen doch, dass es in der Vergangenheit viel größere Temperaturänderungen und auch schneller gab. In Warmzeiten ging es den Menschen gut, alle hatten genügend zu essen und konnten sich um Dinge kümmern, die nicht mit dem unmittelbaren Überleben zu tun hatten. Wie hart war es dagegen, als sogar die salzige Ostsee zugefroren war.

D.S.: Das mag sein, aber Du wirst doch nicht abstreiten, dass es heutzutage wärmer ist als damals. Und die Arktis ist eisfrei und die Eisbären kommen um, weil sie nicht genügend Eisschollen haben. Am Südpol ist auch zu wenig, die Pinguine verlieren ihre Feder, weil es denen zu warm wird.

Ich: Na, das kenne ich aber anders: Seit etwa 1960 haben sich die Eisbären von geschätzten 5.000 auf mehr als 25.000 vermehrt, außerdem brauchen sie keine Eisscholle zum jagen, sondern suchen ihre bevorzugten Robben immer in der Nähe des Ufers, egal ob Eisscholle oder nicht. Und am Südpol brüten die Pinguine zur dortigen Sommerzeit, wenn einige Ufergebiete eisfrei sind. Dann finden die auch mehr Nahrung.

Im Übrigen gab es bereits schon früher alarmistische Meldungen in den Medien “ Die Arktis ist eisfrei“, das war 1934. Später, um 1941, gerade als deutsche Soldaten nach Norden und Osten zogen, waren besonders strenge Winter bis zu minus 50°C angesagt, was denen gar nicht gut bekommen war.

1974 wieder, haben die Medien vor der nächsten Eiszeit gewarnt und Rudi Carrell sang darauf „Wann wird’s mal wieder richtig Sommer?“ Schau mal auf die Grafik der Eisbedeckung der Pole. Am Südpol, im Durchschnitt seit 1974 unverändert [2], am Nordpol etwas weniger [3], aber das darf man wohl erwarten, wenn damals gerade Angst vor der nächsten Eiszeit geschürt wurde.

D.S.: Du hast ja Recht, aber das wissen die damals gerade geborenen doch heute nicht mehr.

Der diktatorische Präsident der Malediven hielt medienwirksam unter Wasser eine Konferenz ab. Das hat Eindruck gemacht und die westlichen Staaten sollen Entwicklungshilfe zahlen.

Ich: Na hör mal, inzwischen müsste der für so eine Konferenz wohl tiefere Wasser aufsuchen, außerdem hat er den schon fertigen Bericht über die wissenschaftliche Untersuchung des Wasserpegel an seinen Inseln unterdrückt, wegen unliebsamer Ergebnisse. Der Pegel ist schon seit vielen Jahren nicht gestiegen, im Gegenteil gefallen.

Und wie ist es nun mit der Emissionsschutzverordung, wieso wird denn für CO2 Geld verlangt? Etwas das jedes Lebewesen ausatmet und die Bier- und Weinhersteller und vor allem die Vulkane?

D.S.: Tja, denk doch mal drüber nach, die Idee mit dem CO2 ist doch einfach genial. Das IPCC hat 2001 ausgewiesen, dass nur knapp 3% des gesamten CO2 auf der Erde den Menschen angerechnet wird [1]. Damit nicht auffällt, dass das so wenig ist, schreiben alle auch nur von gesparten Tonnen CO2 und nicht in Prozent zum Ganzen. Da wird für etwas, auf dem unser Leben auf der Erde basiert und das überall auftritt, Geld verlangt. Das hilft zwar nur den Geschäftemachern, aber macht wie der Ablasshandel ein gutes Gewissen. Du darfst nicht vergessen, unsere Regierung hat noch immer keine Rückstellung für die immer höher ausfallenden Beamtenpensionen. Hast Du eine Ahnung was uns die Banken noch kosten? Nur die Dummen dachten, dass die LKW Maut tatsächlich für die Reparatur der Straßen genommen werden.

Ich: Also ist es wie schon immer, die einen sitzen an der Quelle, haben viel Geld und hoffen auf noch mehr. Wie z.B. die Zerschlagung einer funktionierenden und bezahlbaren Energieversorgung: Die Windkrafthersteller haben die Milliardengrenze im Umsatz längst überschritten, die Solarzellenhersteller in Asien haben ebenfalls das lukrative Geschäft entdeckt. Die Banken machen mit der Finanzierung immer guten Gewinn ohne großes Risiko. Die vielen privaten Investoren hoffen auf gute Gewinne, abhängig von den Launen der Politik. Die bisher vom Kartellamt kontrollierten Energiekonzerne haben ebenfalls ihre Kosten gedeckt, denn die garantierten Abnahmepreise und Investitionen in neue, diametral entgegengesetzte Strukturen werden natürlich weitergegeben. Der einzige der dabei verliert ist der Verbraucher, der das alles zahlen muss, ob er will oder nicht. Warum gibt es z. B. keinen Tarif „Atom- und Kohlestrom“?

Wo dabei irgendwann mal bezahlbare, günstige Strompreise herauskommen sollen ist völlig unklar, denn die vielen, privaten Stromerzeuger werden ihre Einnahmen mit allem was sie haben verteidigen. Politiker wollen schließlich wieder gewählt werden.

Das UBA will dreimal soviel Windkraftwerke aufstellen lassen und die Hälfte der Dachflächen sollen Solarzellen bekommen. Die andere Hälfte soll Solarthermeanlagen tragen.

Der Bund Naturschutz kann dann die „Natur“ in seinem Namen streichen.

D.S.: Du siehst das alles zu hart. Denk doch mal an die vielen Arbeitsplätze, die dadurch geschaffen wurden. Da nach jeder Fertigstellung eines Windspargels nur noch wenig zu tun ist, muss natürlich weitergebaut werden.

Solange jedenfalls, bis jeder in Deutschland ein Investor ist und wir untereinander Tauschhandel betreiben, denn das Geld wird ja für Energie und Mehrwertsteuer aufgebraucht.

Damit haben wir in Optimierung der Ich-Ag’s keine Arbeitslosen mehr, nur Gewinner. Die paar Verlierer, die partout nicht investieren wollen sind selber schuld, auch wenn Sie nichts dafür können.

Neue Zeiten haben schon immer Anpassungen gefordert. Für die Welt sind wir bestimmt ein Vorbild, denn wir Deutsche werden bestimmt weniger werden, das bedeutet weniger Konsum aber auch weniger Exportüberschuss, außerdem müssen die paar unverbesserlichen Optimisten, die ihre Industrie noch nicht verlagert haben, zuverlässigen Strom aus dem Ausland beziehen. Diese Wertschröpfung verbessert die Handelbilanz. Du siehst also, das ist ein ganz großer Plan mit dem was alles dran hängt.

Ich: Das muss ich erst mal verdauen. Kannst Du mir denn zum Abschluss die nun richtige Temperatur der Erde nennen? Unsere Kanzlerin will doch den Anstieg auf 2 Grad begrenzen?

D.S.: Na ja, das ist nichts als eine politische Schaumschlägerei wie das Glühbirnenverbot und gibt es nur bei uns. Stell Dir mal vor, die Leute würden nachdenken, das IPCC gibt eine Klimawirksamkeit bei Verdoppelung des CO2 Gehaltes von 0,9 Grad an. Die Verdoppelung würde aber bedeuten, dass alle bekannten Kohle, Öl usw. Vorräte auf einen Schlag verbrannt werden würden. Was da dran ist, kannst Du Dir nun selber denken. Außerdem ziehe ich demnächst in Richtung Süden wo es wärmer ist. Der letzte kalte Winter war ein deutliches Zeichen für die abnehmende Temperatur, deshalb sprechen die Medien und ihre gefälligen, von Fördergeldern abhängigen Wissenschaftler nun nur von Klimaänderung. Damit passt es immer.

Nur nicht zuviel Ausbildung der Massen, denn physikalische Grundlagen und Fachwissen waren schon immer der Tod von grünen Visionen.

Ich: Andreas Demmig

Aufgeschrieben Anfang Sep. 2010 und m.e. noch immer nicht veraltet.

Damals war u.a. einem Amateur aufgefallen, dass der Satellit ‚NOAA-16‘ (amerikanischer Wetterdienst) bereits lange Zeit falsche Temperaturen meldet. Z.B. sollte das Wasser im Michigan See z.T. mehr als 100°C haben. Diese Daten werden automatisch ausgewertet und dienen der Argumentation einer trotz gefühlter Kälte weiter gestiegenen Erwärmung.

Das Neueste: Weil es wärmer wird haben wir tiefere Temperaturen! Und deshalb friert die Ostsee zu.

Das beste Beispiel ist der scheinbar erfolgreiche Einsatz eines TESLA Lithium-Ionen-Akkuspeichersystems in Südaustralien im November 2017. Bereits einen Monat später sprachen die Medien bereits von großem Erfolg:

„Mindestens zwei größere Energieausfälle konnten entschärft werden, die Batterien reagieren schneller als kohlebefeuerte Backup-Kraftwerke. Die Batterie von Tesla (Hornsdale Power Reserve) lieferte bereits nach nur 0,14 Sekunden nach einer der größten Braunkohle Kraftwerke Australiens, dem Loy Yang-Kraftwerk, das einen plötzlichen, unerklärlichen Produktionsrückgang erlitt.“

Ende 2017 und auch heute noch in Australien gibt es ein großes Problem – Wenn das Batteriespeichersystem von Tesla so effektiv ist -, warum hat die Financial Times Ende August 2018 festgestellt [Bezahlsperre]: „Die politische Krise in Australien hat seine Wurzel in der Energiefrage.“

Die derzeit eingesetzten Energiespeichersysteme sind nicht skalierbar, erschwinglich oder flexibel wie Erdgas, so sind viele Länder wie die Australier zu höheren Strompreisen verdammt, wie auch Deutschland und Dänemark beweisen. Stromausfälle und höhere Emissionen durch verstärkten Einsatz von backup-Kraftwerken; insbesondere Kohlekraftwerke sind unabwendbar. Wenn China behauptet, sie seien führend in grüner Energie, so täuscht es die politischen Führer der Welt und die Umweltschützer, die auf erneuerbare Energien und Energiespeicher abzielen, die jedoch nicht als Ersatz zuverlässiger Energieversorgung eingesetzt werden können.

China baut weitere Kohlekraftwerke in rasantem Tempo, während Australien, das auch das Pariser Klimaabkommen unterzeichnet hat, Kohle nach Asien exportiert.

Nach Auswertung vom Juni 2018 , wird Australien im Zeitraum 2017-2018 voraussichtlich 60,2 Milliarden US-Dollar mit Kohleexporten verdienen – das ist das höchste jemals erreichte Niveau -, darunter 182 Millionen Tonnen oder 37,5 Milliarden US-Dollar an metallurgischer Kohle und 200,5 Mio. Tonnen oder 22,7 Milliarden US-Dollar an thermischer Kohle.

Wenn die Energiespeicherung funktionieren würde, würden auch erneuerbare Energien funktionieren, da sich jede Technologie gegenseitig ergänzt. Erneuerbare Energien kommen ungeplant und nur zeitweilig und benötigen Energiespeicherkapazität und / oder die Sicherung durch zuverlässige Kraftwerke. Energiespeicherung ist derzeit oder in naher Zukunft nicht 24 Stunden an 365 Tagen bedarfsgerecht verfügbar [und bezahlbar].

Weitere Beispiele für einen fehlgeschlagenen Einsatz erneuerbarer Energien gibt es viele. Über Deutschland und Frau Dr. Merkels gescheiterte Klimaziele berichtete Bloomberg Mitte August

„Deutschland, die Nation, die mehr als jedes andere Land erneuerbare Energien zum Einsatz gebracht hat, wird ihre Ziele zur Reduzierung der „schädlichen“ Kohlendioxidemissionen wahrscheinlich sogar dann verfehlen, wenn bis 2025 weitere 500 Milliarden Euro für den Umbau des Energiesystems aufgewendet werden. Deutschland ist eine der Top-Volkswirtschaften der Welt, seine Ingenieurskunst ist seit über einem Jahrhundert legendär und sie haben einen politischen Konsens für grüne Energie, aber sie können erneuerbare Energien nicht mit den Emissionszielen in Übereinstimmung bringen. Der Grund dafür liegt in der launischen Natur der erneuerbaren Energien und es gibt keine ausreichenden Energiespeicher. Selbst in dem technologisch fortgeschrittenen Deutschland, das nach dem Tsunami und Ausfall von Fukushima Daiichi in Japan versucht, seine Atomkraftwerke stillzulegen, hat seine nicht gelösten Probleme:

„Durch die Schließung von Kernkraftwerken bleiben in Deutschland keine Erzeugungsanlagen, die an den dunklen Tagen im Winter arbeiten können, wenn Windparks und Solaranlagen nicht viel zum Netz beitragen – und die Nachfrage auf dem Höhepunkt ist.“

Zusätzliche Probleme treten für Benutzer und Netzbetreiber ohne ausreichende Energiespeicher in Deutschland auf: „Das Netz ist so stark mit Strom überschwemmt, dass die Preise auf dem Großhandelsmarkt oft unter null fallen.“

Was die politischen Entscheider in Deutschland, der EU, in China und der industrialisierten Welt zusätzlich beeinflusst ist, dass die deutsche Wirtschaft mehr dienstleistungsorientiert ist und weniger Energie verbraucht und weniger CO2 emittiert, im Gegensatz zu China und zunehmend den USA, deren Industrie und Fabriken einen größeren Anteil am BIP haben. Die Nutzung erneuerbarer Energien ist ohne skalierbare, erschwingliche und zuverlässige Energiespeichersysteme nicht zu erreichen.

Auch die Vereinigten Staaten (USA) sind ein Beispiel, wo die Preise ohne ausreichende Energiespeicherung gestiegen sind, Kalifornien hat darüber hinaus noch höhere Großhandelspreise und Einzelhandelspreise, da in diesem Bundesstaat überhaupt keine Energiespeicherung verfügbar ist. Minnesota lag in der Vergangenheit um 18,2% unter dem nationalen US-Durchschnitt der Energiepreise. Minnesota investierte in 2009 10 Milliarden US-Dollar für Windparks, modernisierte die Übertragungsleitungen und erließ eine Vorschrift des zu erreichenden Anteil der Stromversorgung aus erneuerbarer Energien:

„Die Energieversorger müssen 25-30% des Stroms aus erneuerbaren Quellen verkaufen, hauptsächlich aus Wind.“

All dies sollte ohne ein Speichersystem erreicht werden. Das Ergebnis: Die Energiepreise von Minnesota liegen seit Februar 2017 über dem nationalen Durchschnitt und sie haben die Treibhausgasemissionen im Vergleich zum US-Durchschnitt und die Umweltverschmutzung nicht verringert.

Hätte Minnesota keine nicht so sehr auf „erneuerbare Energie“ gesetzt und dann noch ohne Energiespeicher und wäre stattdessen bei seinem traditionellen Energiemix geblieben, wären den Strombeziehern von 1990 bis 2017 4,4 Milliarden Dollar erspart geblieben. Energiespeicherung ist unabdingbar neben zufälliger Lieferung von Energie aus Wind und Sonne.

Befürworter von erneuerbaren Energien, Batteriespeicherung, intelligenten Netzen [d.h., Verbraucher abschalten zu können] werden jedoch weiter daran glauben, dass die Technologie verfügbar, skalierbar, erschwinglich ist und die flexible Zusatzleistung wie Erdgas bietet. „Die heute verfügbaren handelsüblichen Großbatterien speichern jedoch nur zwischen zwei Minuten und maximal zehn Stunden lang Energie, d.h. Strom.“ Energiespeicher , die tatsächlich Stromausfälle von Tagen, besser zwei Wochen überbrücken könnten, sind weder in naher oder langfristiger Zukunft absehbar noch finanzierbar – obwohl Befürworter, Politiker und Teile der profitierenden Privatwirtschaft weiterhin auf erneuerbaren Energien und einer kohlenstofffreien Lebensweise bestehen.

Jede Art von lokalem, landesweitem, landesweitem, nationalem oder internationalem Ansatz für Energiespeichersysteme erfordert eine Strategie und Technologie, die Flexibilität, allgemein akzeptierte Planungsmethoden, bedarfsorientierte Verbraucherverwendung, national und international angeschlossene Übertragungsleitungen, Umfasst die Handhabung der variablen, intermittierenden Natur der erneuerbaren Erzeugung. Teil 2 der Reports des Energieministeriums vom Nov. 2016, noch Obama Regierung. Berücksichtigt werden muss auch die IT-Sicherheit einer Netzmodernisierung, damit die Energiespeicherung einen Beitrag dafür liefert, dass erneuerbare Energien und die CO2-freie Gesellschaft Realität werden.

Unter Punkt 3.2 im Report des Energieministeriums, findet man [nur wenige Phrasen] zur Energiespeicherung

Empfehlung 3.2: Festlegung eines Rahmens und einer Strategie für Energiespeicherung und Flexibilität. Es gibt bislang nur wenig Informationen zu den Vorteilen und Kosten eines Energiespeichers und zur Bereitstellung flexibler Ressourcen unterhalb des „bulk system level“, [Sinngemäß: … unterhalb des Speichervermögens / der Speicherkapazität, müssen back-up Energiequellen zuverlässig einspringen]. Der Report ergab, dass das Energieministerium Analysen der Speicherkapazität auf regionaler und Bundesland Ebene durchführen sollte. Die im März 2016 durchgeführte Studie „Bedarf und Reaktion integrierter Energiespeicher“ wurde in Zusammenarbeit zwischen dem Ministerium und den Nationalen Forschungslabors erstellt. Für das Geschäftsjahr 2017 wird vorgeschlagen, 2,6 Millionen US-Dollar im Rahmen der Netz Erneuerungs-Initiative (GMI )für die Zusammenarbeit mit Regulierungsbehörden für die Entwicklung von Analysen einzusetzen

Einheitliche Modellstandards für die Energiespeicherung werden regionale Vielfalt berücksichtigen. Die Modelle enthalten Risikoattribute der Energiespeicherung sowie der primären, sekundären und tertiären Energieflüsse.

Die Projekte werden auch mit Normungsgremien zusammenarbeiten, um die Definition von Energiespeichercodes und Standards in Bezug auf Sicherheit und Leistung zu erleichtern.

Bericht erschienen auf CFact vom 06.11.2018

Übersetzung und Interpretation durch Andreas Demmig

http://www.cfact.org/2018/11/06/energy-storage-isnt-ready-for-wide-deployment/

Der Generalsekretär der Vereinten Nationen, Antonio Guterres, sagte den pazifischen Inselführern, dass der Klimawandel bei einem Treffen mit den Führern des Pacific Island Forum (PIF) seine „absolute Priorität“ sei.

Im Gegenzug stellte eine Studie fest, dass die Inseln in ihrer Substanz stabil sind, einige sogar gewachsen. Dieses wurde im September in der Zeitschrift WIREs Climate Change veröffentlicht und trägt zu den wachsenden Beweisen bei, dass kleine Inselstaaten im Pazifik und im Indischen Ozean sich als widerstandsfähig gegen aufsteigende Meere erweisen, im Gegensatz zu Voraussagen, dass sie möglicherweise unbewohnbar werden.

„Insgesamt waren 88,6% der Inseln entweder stabil oder größer geworden“, schrieb die Autorin Virginie KE Duvat von der Universität La Rochelle in der Studie. [Das Original „Portal ist aufgrund eines urheberrechtlichen Anspruchs vorläufig nicht verfügbar“. Dafür habe ich das hier gefunden. Der Übersetzer]

„Wesentlich ist, dass Inseln in Meeresregionen, die von einem Anstieg des Meeresspiegels betroffen eher sind, weder eine Kontraktion noch einen ausgeprägten Rückzug der Küstenlinie zeigten. Das deutet darauf hin, dass sie möglicherweise noch nicht von den vermutlich negativen, dh. erosiven Auswirkungen des Meeresspiegelanstiegs betroffen sind.“

Diese Ergebnisse der Studie könnten sehr ungelegen kommen, angesichts von Vorhersagen, dass Pazifikinsulaner an Orten wie Kiribati, zu „Klimaflüchtlingen“ werden könnten. Und zwar wegen Anstieg des Meeresspiegels – für den klimagläubige Wissenschaftler die Treibhausgasemissionen der Menschen verantwortlich machen.

Als sich die Vereinten Nationen 2015 trafen, um das Pariser Klimaabkommen zu unterdrücken, forderte Kiribati gemeinsam mit anderen Inselstaaten ein internationales Abkommen auf, um die globale Erwärmung unter 1,5 Grad Celsius zu halten.

„Es ist eine Frage des Überlebens“, sagte der damalige Präsident von Kiribati Anote Tong, nach einem Treffen mit US-Präsidenten Barack Obama. Fast 200 Länder unterzeichneten schließlich das Pariser Klimaabkommen.

In CBS-News-zu Kiribati in 2017 wurde von Kiribatis Notstand berichtet und von Wissenschaftlern die vorhersagen, dass der Inselstaat „in Jahrzehnten unbewohnbar sein könnte“, und dass „Hochwasser ihre Häuser überschwemmt, sogar bereits ihr Wasser verschmutzt und ihre Ernten abtöten.“

Duvats Studie ergab jedoch, dass Kiribatis Inselkette im Norden der Tarawa-Insel sehr stabil ist, wobei die meisten Inseln an Landfläche zunahmen. Die South-Tarawa-Kette erfuhr sogar das größte Wachstum der untersuchten Atolle.

Für die Malediven prognostizierte ein Vertreter der Inselregierung, dass der Anstieg des Meeresspiegels diese ganzen 1196 kleinen Inseln im Indischen Ozean in den nächsten 30 Jahren vollständig bedecken würde“. Diese Warnung wurde 1988 unter erhöhter Dringlichkeit des Kampfes gegen die globale Erwärmung gemacht.

Duvat stellte stattdessen fest, dass mehr als 70 Prozent der Huvadhoo-Inseln der Malediven stabil sind, das 6 Prozent an Größe zugenommen und 23 Prozent an Größe verloren haben.

Inseln mit Landverlust sind und waren alle „sehr klein“, schrieb Duvat und fügte hinzu:

„Von den Bewohnern wurde bestätigt, dass keine Insel verschwunden ist. Die erneut analysierten globalen Daten zeigen, dass Atolle keine Landfläche verloren haben und dass 73,1% der Inseln in der Landfläche, einschließlich der meisten besiedelten Inseln, stabil waren, während 15,5% der Inseln zunahmen und 11,4% in der Fläche abnahmen“.

Wissenschaftler befürchten, dass die zukünftige Erwärmung Probleme für tief liegende Inseln verursachen könnte, von denen sich viele nur wenige Meter über dem Wasser befinden. Andere menschliche Eingriffe, Meeresströmungen und Stürme spielen jedoch wahrscheinlich eine noch größere Rolle als Klimaveränderungen.

Zum Beispiel stellte Duvat fest, dass „die Landgewinnung und der Bau von Dammwegen nicht nur in städtischen, sondern auch in ländlichen Atollen bedeutende Änderungen in der Inselfläche und -konfiguration verursacht haben.“ Auch die „Entfernung und Beseitigung der einheimischen Vegetation – verursachte deutliche Veränderungen in Inselkonfiguration und Destabilisierung der Küste auf einigen Inseln“.

Studien haben zunehmend gezeigt, dass trotz des steigenden Meeresspiegels ein weit verbreitetes Verschwinden von tief liegenden Atollen und Koralleninseln nicht festzustellen ist.

In dem jüngsten Bericht der Vereinten Nationen vom Oktober wurde darauf hingewiesen, dass „Modelle und andere Beweise darauf hindeuten, dass ungeschützte pazifische Atolle mit dem Meeresspiegel Schritt halten, bei nur geringer Verkleinerung der Landfläche oder gar einen Zuwachs an Land verzeichnet haben.“

Der neuseeländischen Forschers Paul Kench stellte in seiner Studie vom Februar fest, dass acht der neun Atolle von Tuvalu und drei Viertel seiner Riffinseln in den letzten vier Jahrzehnten gewachsen sind.

„Die Ergebnisse der Studie mögen kontraproduktiv erscheinen, da der Meeresspiegel in der Region im letzten halben Jahrhundert angestiegen ist, aber die vorherrschende Art des Wandels auf Tuvalu war Expansion und nicht Erosion“.

Der UN-Bericht warnt jedoch auch vor anhaltender Erwärmung: „Kleine Inseln sind an ihren Küsten voraussichtlich gefährdet und sehr empfindlich für den Klimawandel und anderen Stressfaktoren.“

Duvat fand nur auf Inseln, die kleiner als 25 Hektar waren, Instabilität, aber selbst dann, nahm nur eine kleine Anzahl der Inseln tatsächlich an Landfläche ab.

Gefunden auf The Daily Caller vom 30.10.2018

Übersetzt durch Andreas Demmig

https://dailycaller.com/2018/10/30/pacific-islands-growing-sea-level/

Ergänzung:

Auch auf Eike lasen Sie bereits öfter von Studien zu Meeresspiegeln und den Pazifikinseln, hier und hier

[Dort finden Sie auch meine Lieblings-Links zu: Malediven, 11 neue Flughäfen fertiggestellt, weitere fünf geplant.]

Auch Prof. Mörner war schon Gastredner auf der Internationale Klima- und Energiekonferenz von Eike. Hier berichtet er über die Fidschi Inseln.

Da das Meereswasser sich gleichmäßig in der Höhe verteilt (nach „lokaler Gravitation“!), hier die Pegelstände an deutscher Nordseeküste

Es geht um den Kaufkraftverlust und ständige Steuer- und Abgabenerhöhungen. Eine Strafsteuer auf den Kraftstoff der auch in unserem Nachbarland besonders beliebten Dieselautos war dann eine Erhöhung zu viel. Da fruchtete auch der Hinweis auf angebliche Bemühungen um die Luftreinheit nicht mehr. Die 51 Jahre alte Jacline Mouraud protestierte mit einem Video auf Facebook gegen die hohen Spritpreise und wurde zum Protest-Kult. Das Erkennungszeichen der Bewegung sind die gelben Warnwesten „Gilets jaunes“.

Den Deutschen ist so ein anarchischer Ausbruch wohl nicht zuzutrauen, aber das Murren hierzulande wird allmählich auch lauter. Auch bei uns werden Einschränkungen, Gängelungen und immer neue Belastungen stets so begründet, dass derjenige, der dagegen protestiert, sich moralisch ins Unrecht setzt. Wer kann schon was gegen saubere Luft in den Städten haben? Die Deutsche Umwelthilfe, ein Abmahnverein, der mit dieser Begründung gerade Deutschland lahm legt, strotzt nur so vor moralischer Selbstgerechtigkeit. Diese Leute haben keinerlei Bezug mehr dazu, was sie tatsächlich anrichten – und welches moralische Urteil später einmal darüber gefällt werden dürfte.

Und wieder ist es eine kleine, scheinbar nebensächliche Episode, die den ganzen Irrsinn wie in einer Nussschale konzentriert – und die Verhältnisse zum Tanzen bringen könnte. „Aus für Essener Tafel wegen Diesel-Fahrverbot?“ fragte die Bild-Zeitung vor zwei Tagen. Die Essener Tafel machte vor einiger Zeit Schlagzeilen, weil Ihr couragierter Chef, Jörg Sartor, nicht länger hinnehmen wollte, dass bei der Essensverteilung zunehmend das Recht des Stärkeren Einzug hielt – und aus diesem Grund bis auf weiteres keine weiteren Zuwanderer mehr akzeptieren wollte. Bis hinauf zur Bundeskanzlerin ging daraufhin Entrüstung durch die Reihen der Abgehobenen in diesem Lande, Jörg Sartor fand sich ruckzuck auf der Rassisten-Strafbank, obwohl er aus schlichter Notwendigkeit eine praktisch vernünftige Entscheidung durchsetzte.

Inzwischen „ist die Oma wieder da“, freut sich der Tafel-Chef. Statt dessen droht jetzt erneutes Ungemach. Und wieder sind es die Moralapostel in ihren Wolken-Kuckucksheimen, die die Existenz dieser von Freiwilligen getragenen sozialen Einrichtung gefährden. Sartor droht mit einer Schließung der kompletten Essener Tafel. Grund ist das Dieselfahrverbot in Essen, das ab 2019 gelten soll. Laut Sartor verfügt die Essener Tafel für den Transport von gespendeten Lebensmitteln über sechs Kühlfahrzeuge der Marke Mercedes Sprinter und zwei weitere Transporter. Die Fahrzeuge seien zwischen zwei und fünf Jahre alt und erfüllten lediglich die Euro-Normen 4 oder 5. Die Essener Tafel mit Sitz im Huttroper Wasserturm an der Steeler Straße liegt mitten drin in einer „Verbotszone“. Für neue Transporter fehlt das Geld, also müsste man dieses Projekt, das immerhin 22.000 Bedürftige in der Stadt mit Lebensmitteln versorgt, aufgeben. Ob es eine Ausnahmegenehmigung geben wird, steht in den Sternen.

Und damit wären wir bei der Moral der Geschichte. Zweifelhaft ermittelte Grenzwerte für Stickoxide, deren Einhaltung mit noch zweifelhafteren Messstellen überprüft wird, gipfeln in absolut zweifelhaften Hochrechnungen „vorzeitiger Todesfälle“. Diese wiederum werden von einem zweifelhaft finanzierten Abmahnverein genutzt, um seiner Kampagne gegen das Auto Schwung zu verleihen. Das führt dann ganz unzweifelhaft zur Enteigung hunderttausender Autofahrer, die man im übrigen jahrelang verleitet hat, sich ein Dieselauto zu kaufen, weil das mit seinem niedrigeren CO2-Ausstoß besser fürs Klima sei.

Aber es sind eben nicht nur die Autofahrer. Willkürlich herbeigeführte Wohlstandsverluste treffen immer die Ärmsten der Armen am schlimmsten. Und das wären in diesem exemplarischen Fall die 22.000 Menschen in Essen, die sich noch nicht einmal mehr den Einkauf von Lebensmitteln leisten können. Menschen im übrigen, die bereits unter exorbitanten Strom- und Heizungspreisen leiden, die ebenfalls im Dienste einer höheren Moral, nämlich einer dubiosen „Klimarettung“ aufoktroyiert wurden – von den gleichen dubiosen Weltrettern, die jetzt mit der Luftreinhaltungskeule das Auto abservieren wollen. Unter der Mustertapete der hohen Moral modert die gute alte Feindschaft gegenüber der Industriegesellschaft.

Das Beispiel Tafel Essen zeigt noch zwei weitere Charakterisika dieser zutiefst antihumanen und misanthropischen politischen Agenda: Private Initiative und bürgerschaftliches Engagement werden unterminiert, das Individuum gilt nichts. Es soll weder selbstbestimmt fahren können, wohin es will, noch helfen können, wem es will. Die entsprechenden Gesetze, die die Voraussetzungen dafür schaffen, werden stets unter dem Deckmantel eines noblen Anliegens verabschiedet, so sie denn nicht ganz unter dem Radar der öffentlichen Wahrnehmung gehalten werden. Gerne spielt man dabei auch über die europäische Bande oder „unverbindliche“ UN-Resolutionen. Auf dem Weg von dort oben nach unten verkehren sich die guten Vorsätze dann nach und nach ins Gegenteil.

Gerd Held hat dieser Tage auf Achgut.com in seinem Beitrag „Die Industrie-Verabschiedungskultur“ geschrieben: „Es wird so getan, als fände auf deutschen Straßen eine Art Weltkrieg oder eine organisierte Massenvernichtung statt. Es soll ein Klima der Angst und der Empörung geschaffen werden, in dem keine vernünftige Abwägung von Belastungen und Erträgen mehr stattfinden kann. Die Argumentation entzieht sich jeder Verhältnismäßigkeits-Vernunft. Auf diesem Weg kann jeder industriellen Aktivität die Legitimität entzogen werden“.

Genau das stellen die Vorgänge um die Essener Tafel nun ganz lebenspraktisch unter Beweis. Bei dieser Gelegenheit sollte man auch noch einmal das sogenannte „Vorsorge-Prinzip“ ansprechen. Wenn man es richtig handhabt, dann darf man nämlich nicht nur die Folgen der Anwendung einer Technik betrachten, sondern muss sie gegen die Folgen ihrer Nicht-Anwendung abwägen. Im Falle des Diesels sollte die Entscheidung gar nicht so schwer fallen. Unzählige Menschen wurden und werden mit Fahrzeugen oder Aggregaten gerettet, die von Dieselmotoren sparsam und zuverlässig angetrieben werden. Jedes Krankenhaus hat ein Diesel-Notstromaggregat im Keller. Eine noch viel größere Rolle spielt die indirekte Funktion des Dieselmotors als Wohlstandsmaschine und Überlebenshilfe. Jeder, der einmal in Afrika oder Australien reiste, kennt das nächtliche Tuckern des Dieselaggregats, das den Kühlschrank kalt und die Glühbirne hell werden lässt.

Dieser nachweislich millionenfachen lebensrettenden Funktion stehen hypothetische und wissenschaftlich nach wie vor umstrittene Studien gegenüber, die entgegen der Kolportagen nicht in der Lage sind, einen kausalen Zusammenhang zwischen Stickoxiden und Erkrankungen nachzuweisen. Eine Abwägung von Nutzen und Schaden findet nicht mehr statt. Es geht nicht um Abgase und schon gar nicht um Menschen. Es geht um eine Ideologie der tabula rása.

Der Beitrag erschien zuerst bei ACHGUT

Was ist üblicherweise mit Klima-Sensitivität gemeint? Um das zu erklären, muss ich einen kleinen Umweg machen. Erstens, einfallende Strahlung [Downwelling].

„Downwelling“ in der Klimawissenschaft bedeutet die auf die Oberfläche des Planeten treffende Strahlung. Einfallende Strahlung ist die Gesamtstrahlung in Richtung Erdoberfläche. Sie setzt sich zusammen aus Sonnenlicht (kurzwellig) plus thermischer Strahlung aus der Atmosphäre (langwellig). In der Klimawissenschaft nennt man diesen Parameter, also die gesamte einfallende Strahlung „Antrieb“ [Forcing F].

Das zentrale Paradigma der modernen Klimawissenschaft lautet, dass wenn sich die Stärke der einfallenden Strahlung (Forcing) ändert, sich auch die Temperatur an der Oberfläche notgedrungen ändert. Es wird behauptet, dass sich alles andere heraus mittelt, und falls das Forcing sich verstärkt, muss sich auch die Oberflächentemperatur ändern, um das globale Energie-Gleichgewicht zu erhalten. Sie muss sich ändern! Sie muss!

Kurz gesagt lautet das zentrale Paradigma der modernen Klimawissenschaft:

Langfristig ist die globale Temperaturänderung proportional zur Änderung der globalen Forcings.

Die vermeintlich konstanten Proportion zwischen beiden Größen, also Temperatur-Änderung dividiert durch Forcing-Änderung, nennt man „Klima-Sensitivität“.

Klima-Sensitivität wird oftmals ausgedrückt als die mutmaßliche Temperaturänderung bei einer Änderung der einfallenden Strahlung von 3,7 Watt pro Quadratmeter (W/m²). Die Berechnung dieser so genannten „Klima-Sensitivität“ ist eine zentrale Frage, die sich rund um das Paradigma erhebt, dass Temperaturänderung proportional zu Temperaturänderung ist.

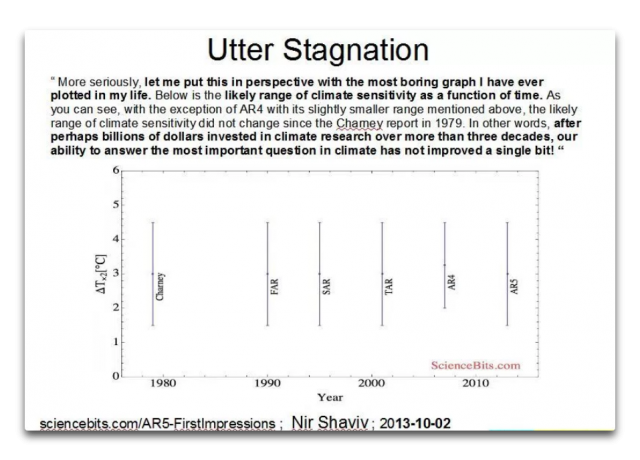

Und das bringt mich zu der höchst langweiligen Graphik unten. Sie zeigt die Änderungen der Schätzung des Wertes der Klima-Sensitivität über die Zeit:

[Bildinschrift oben in der Graphik: UTTER STAGNATION – Dr. Shaviv schreibt: „Lassen Sie mich das in eine Perspektive bringen mit der langweiligsten Graphik, die ich je in meinem Leben geplottet habe. Die Graphik zeigt die wahrscheinliche Bandbreite der Klima-Sensitivität als Funktion der Zeit. Wie man sieht, hat sich die wahrscheinliche Bandbreite der Klima-Sensitivität seit dem Charney-Report aus dem Jahr 1979 nicht verändert, wenn man vom AR 4 mit einer etwas geringeren Bandbreite absieht. Mit anderen Worten: Nach vermutlich Milliarden Dollar, welche über mehr als drei Jahrzehnte in die Klimaforschung gepumpt worden waren, hat sich unsere Fähigkeit, die wichtigste Frage bzgl. Klima zu beantworten, nicht einmal ansatzweise verbessert!“]

Es ist der Erwähnung wert, dass seit dem Jahr 1979 gesamte neue Wissenschaftsbereiche wie die DNA-Analyse erstmals aufkamen und inzwischen erstaunliche Niveaus der Entwicklung erreicht haben … und das über die gleiche Zeit, in der die von Dr. Shaviv als die „bedeutendste Frage bzgl. Klima“ bezeichnet keinerlei Entwicklung aufweist. Überhaupt keine.

Seit 1979 ist die Rechenleistung der uns zur Verfügung stehenden Computer explodiert, sowohl individuell als auch bei großen Organisationen. Mein zuverlässiger PowerMac hat mehr Rechenleistung als den meisten Universitäten im Jahre 1979 zur Verfügung stand. Die Kosten sind ebenfalls gesunken, von 100.000 Dollar pro MIPS (Millionen Befehle pro Sekunde) auf weniger als 1 Dollar pro MIPS heute. Und die Geschwindigkeit der Rechenleistung hat alle Grenzen gesprengt, laufen doch über die Super-Computer Klimamodelle mit über einer Billion Rechen-Operationen in jeder Sekunde. Auch die Anzahl der sich mit der Erforschung des Wertes der Klima-Sensitivität befassenden Personen hat mit der Zeit zugenommen. Und Milliarden über Milliarden Dollar wurden aufgebracht, um die Frage zu beantworten.

Fazit: Seit dem Charney-Report im Jahre 1979 bzgl. Klima-Sensitivität gab es eine ebenso horrende wie unsinnige Zunahme bei:

● Computerleistung bzgl. der Frage

● Stunden intensiver Forschung bzgl. der Frage

● Diskussionen, Debatten und Interesse bzgl. der Frage

● Aufgebrachtes Geld bzgl. der Frage

Und trotz dieser ungeheuren Steigerung von Zeit, Arbeit, Diskussionen und Computerleistung hat sich die Untersuchung der Frage nach dem Wert der Klima-Sensitivität genau Null Millimeter bewegt. Keinerlei Fortschritt.

Wie können wir diese wissenschaftliche Eigenartigkeit einordnen? Was steckt dahinter, dass all die aufgebrachte wertvolle Zeit, Geld und Mühen genau nichts erreicht hat? Ich meine Null. Gar nichts. Keinerlei Bewegung. Die langweiligste Graphik.

Ich schlage mal als Grund vor, dass die Klimawissenschaft das Opfer von etwas ist, das ich das „Picasso-Problem“ nenne. Pablo Picasso sagte nämlich einmal etwas, das mir noch sehr lange im Kopf herumging:

„Welchen Nutzen haben Computer? Sie können doch nur Antworten geben“.

Ich selbst habe mein erstes Computerprogramm im Jahre 1963 geschrieben, also vor mehr als einem halben Jahrhundert. Damals war ich sechzehn Jahre alt. Ich ließ es auf einem Computer von der Größe eines kleinen Raumes laufen. Seitdem programmiere ich Computer. Ich habe Programme für alles geschrieben, von Stoffdesign für große Zelte [catenary tents ?] über die Berechnung der Gezeiten des nächsten Jahres aus den Gezeiten-Tabellen dieses Jahres bis hin zur Erstellung der Graphiken in diesem Beitrag. Und mit den Jahren habe ich auch ziemlich Kohle gemacht mit meiner Erfahrung bzgl. Computer.

Wenn ich also lese, dass Picasso Computer mit jener Feststellung abschreibt, lautete meine spontane Antwort „Was?! Computer sind großartig! Worauf will dieser verrückte Künstler hinaus? Ich habe viel Geld verdient mit meinen Computern. Wie können sie unnütz sein?“

Aber nach gründlicherem Nachdenken erkannte ich, dass Picasso recht hatte. Er meinte Folgendes:

„Selbst der allerbeste Computer kann keine richtige Antwort geben, wenn man ihm zuvor nicht die richtige Frage stellt“.

Das war für mich eine grundlegende Erkenntnis, eine, die mich über viele meiner wissenschaftlichen Unternehmungen geleitet hat – man konzentriere sich nicht zu sehr auf die Antworten. Man muss auch die Fragen in den Mittelpunkt rücken.

Betrachtet man nun also die Klimawissenschaft – welches ist die falsche Frage, welche die richtige? Auch hier möchte ich wieder ein wenig abschweifen.

Mein Interesse an der Klimawissenschaft wurde um die Jahrtausendwende geweckt, und zwar wegen der inflationären Zunahme von Untergangsprophezeiungen eines drohenden ThermageddonTM. Also begann ich, mich mit den Grundlagen zu befassen und zu lernen, wie der schlecht bezeichnete „Treibhauseffekt“ die Erde weit wärmer hält als es auf dem Mond ist, der etwa die gleiche Entfernung von der Sonne hat.

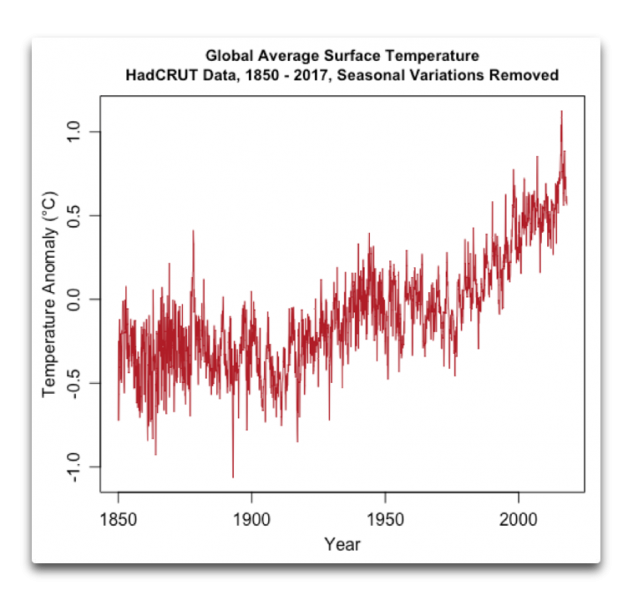

Allerdings habe ich im Zuge dieses Interesses gelesen, dass das Best Estimate der Erwärmung über das gesamte 20. Jahrhundert in der Größenordnung von 0,6°C aufgetreten war. Da kam mir spontan der Gedanke „Was – weniger als ein Grad?! All dieses Brimborium, und die Temperatur hat sich um weniger als 1 Grad geändert?“

Ich war überrascht wegen meiner Erfahrung mit der Reparatur von Maschinen mit einem Regler und aufgrund meiner Erfahrung mit Sonnenenergie. Ich betrachtete das Klima als eine gigantische, von der Sonne angetriebene Wärmemaschine, wobei die Sonnenenergie konvertiert wird zu der unablässigen Bewegung der Atmosphäre und der Ozeane gegen die bremsende Wirkung der Reibung und vielem mehr.

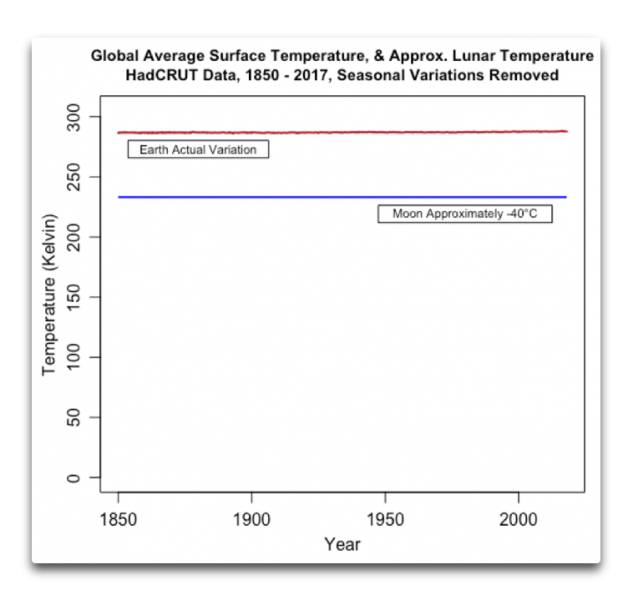

Wenn man die Effizienz oder andere Charakteristika einer Wärmemaschine analysiert, oder wenn man Dinge wie die Stefan-Boltzmann-Gleichung verwendet, um Temperatur in das Äquivalent thermischer Strahlung zu konvertieren, muss man die Kelvin-Temperaturskala (K) heranziehen. Diese Skala beginnt am absoluten Nullpunkt. Temperatur ist eine Funktion der Bewegung von Molekülen oder Atomen, und am absoluten Nullpunkt hören diese Bewegungen vollständig auf.

Man kann für derartige Berechnungen nicht die Celsius- oder die Fahrenheit-Skala heranziehen, weil beide willkürlich gewählte Nullpunkte haben. Nur mit der Kelvin-Skala funktionieren diese Berechnungen. Kelvin hat die gleichen Abstände der Einheiten wie Celsius und lediglich einen anderen Nullpunkt, nämlich minus 273,15°C.

Nun beträgt die mittlere Temperatur an der Erdoberfläche größenordnungsmäßig 14°C – oder 287 Kelvin. Und mit dieser mittleren globalen Temperatur von 287 Kelvin macht die globale Temperatur-Variation von 0,6 K über das 20. Jahrhundert gerade mal ein Fünftel von einem Prozent aus.

Dies war die Seltsamkeit, die mich bei meinen Untersuchungen bzgl. Klima begleitete … über einen Zeitraum von 100 Jahren hat die Temperatur nur mit etwa einem Fünftel eines Prozentes variiert. Das war für mich umwerfend. Ich hatte viel Erfahrung mit geregelten Systemen wegen meiner Arbeit mit elektrischen Generatoren. Diese müssen genau geregelt werden, damit ihre Geschwindigkeit konstant bleibt trotz der sich ändernden Last des Systems. Und bei dieser meiner Arbeit habe ich herausgefunden, dass es ziemlich schwierig ist, innerhalb eines Prozents regelnd in ein mechanisches System einzugreifen.

Und jetzt: Trotz Dürren und Überschwemmungen, trotz großer Vulkanausbrüche, trotz sich konstant ändernder globaler Wolkenbedeckung, trotz aller Arten von Änderungen des Antriebs, trotz hemisphärischer Temperaturänderungen um ~13°C zweimal pro Jahr in jedem Jahr, trotz des Ausgleichs des Globus‘ bzgl. eines Treibhauseffektes, der den Planeten um rund ~50°C wärmer hält als den Mond … trotz all dieser Änderungen und Variationen variierte die mittlere Temperatur der Erde nicht stärker als ein Viertel Prozent im Laufe eines ganzen Jahrhunderts.

Das ist eine erstaunlich enge Regelung. Hier folgt ein Beispiel aus der realen Welt, warum mich diese Stabilität überrascht hat.

In meinem Auto gibt es einen Geschwindigkeits-Regler. Den kann man auf eine bestimmte Geschwindigkeit einstellen, die dann stur gehalten wird, egal ob das Auto beladen ist oder nicht. Bei starkem Gefälle ändert sich die Geschwindigkeit geringfügig um plus/minus 1 km/h. Das heißt, diese vom Computer gesteuerte Regelung hält die Bandbreite der Geschwindigkeit innerhalb 2% … aber die Temperatur der Erde ist sogar noch viel besser reguliert. Sie schwankt innerhalb von plus/minus einem Zehntel Prozent.

Zu jener Zeit war diese thermische Stabilität für mich ein untrügliches Anzeichen für die Existenz irgendeines unbekannten natürlichen thermostatischen Prozesses, der auf sehr effiziente Art und Weise die Temperatur innerhalb dieser geringen Bandbreite hält. Also sah ich es als meine Aufgabe im Bereich Klimawissenschaft, das Phänomen zu finden, welches diese enge Bündelung der planetarischen Temperatur über Jahrhunderte hinweg bewirkt.

Was ich in eine eigentümliche Lage brachte. Alle etablierten Klimawissenschaftler versuchten und versuchen immer noch herauszufinden, warum sich die Temperatur so stark ändert. Sie verbrachten Zeit damit, auf Graphiken wie die Folgende zu starren, welche die Variationen der Temperatur auf der Erde zeigt:

Andererseits wollte ich als jemand mit Interesse für Wärmemaschinen und Regler versuchen herauszufinden, warum sich die Temperatur so wenig geändert hat. Dabei zog ich genau die gleichen Daten heran wie in Abbildung 2, habe sie aber anders dargestellt:

Und das bringt mich nach dem Beackern dieses entfernt liegenden Bereiches zurück zu der Frage nach der Klima-Sensitivität und der weitsichtigen Frage von Picasso: „Wozu sind Computer nütze? Sie können doch nur Antworten geben!“

Meine Aussage: Der Grund dafür, warum wir Jahrzehnte lang überhaupt keine Fortschritte gemacht haben, die Klima-Sensitivität zu berechnen oder zu messen ist, dass wir unsere unermessliche Computerleistung bemühen, um die Antwort auf die Frage zu finden, warum sich die globale Temperatur so stark ändert.

Für mich ist das die völlig falsche Frage. Stattdessen sollten wir viel eher die folgende Frage stellen:

Warum ändert sich die globale Temperatur nur so geringfügig?

Nach vielem Nachdenken und noch mehr Forschung erkenne ich, dass der Grund für die nur so geringe Änderung der globalen mittleren Temperatur NICHT die Proportionalität derselben zu irgendwelchen Antrieben ist, wie allgemein angenommen wird. Als Ergebnis ist die so genannte „Klima-Sensitivität“ keine Konstante, wie vermutet wird … und weil das so ist, ist der Versuch, den exakten Wert zu berechnen, vergebliche Mühe, weil es keinen festen Wert gibt. Darum auch können wir auch nicht den geringsten Fortschritt erzielen, sie zu messen … weil es eine Chimäre ist auf der Grundlage eines falschen Verständnisses dessen, was vor sich geht.

Stattdessen lautet meine Hypothese, dass die Temperatur durch eine Vielfalt von Phänomenen innerhalb dieser geringen Bandbreite gehalten wird. Sie kühlen die Erde, wenn es zu warm wird, und erwärmen sie, falls es zu kalt wird. Ich habe eine große Vielfalt von beobachteten Beweisen gefunden, dass dies tatsächlich der Fall ist. Siehe dazu auch die Links zu vielen Beiträgen, die ich zu diesem Thema bereits geschrieben habe*.

[*Siehe unten]

Aber das ist jetzt nur meine Antwort. Und ich bekenne sofort, dass diese durchaus falsch sein kann … aber zumindest ist es eine Antwort auf die richtige Frage. Das wirkliche Mysterium des Klimas ist dessen erstaunliche thermische Stabilität.

Und schließlich, wie kommt es, dass ein ganzer Wissenschaftsbereich sich abmüht zu versuchen, die falsche Frage zu beantworten? Ich sage, dass dies die Folge der Erschaffung des IPCC seitens der UN ist.

Im Jahre 1988 war der Bereich Klimawissenschaft ein ganz neuer Bereich. Trotzdem jedoch waren die UN bereits davon überzeugt, dass man genau wusste, um welches Problem es sich handelt. Typische bürokratische Arroganz. Als Folge davon heißt es in der Resolution 43/53 der Vollversammlung aus dem Jahre 1988 (die das IPCC hervorbrachte):

Die Vollversammlung ist besorgt hinsichtlich menschlicher Aktivitäten, welche das globale Klima verändern können, wodurch gegenwärtige und zukünftige Generationen von ernsten ökonomischen und sozialen Konsequenzen bedroht sind.

Man nimmt besorgt zur Kenntnis, dass Beweise zunehmend darauf hindeuten, dass die fortgesetzte Zunahme der Konzentration von „Treibhaus“-Gasen eine globale Erwärmung hervorrufen könnte mit einem eventuellen Anstieg des Meeresspiegels, deren Auswirkungen katastrophal für die Menschheit sein können, wenn nicht rechtzeitig in allen Bereichen Gegenmaßnahmen getroffen werden.

Und als Erwiderung sprang man sofort zu der Frage, ob sie wissenschaftlich korrekt war oder nicht; und man ging direkt dazu über, Maßnahmen gegen etwas zu ergreifen, von dem die Vollversammlung nicht die geringste Ahnung hatte. Die Resolution sagte, dass …

…die Vollversammlung rechtzeitig notwendige Maßnahmen ergreifen sollte, um das Problem Klimawandel innerhalb eines globalen Rahmens anzugehen.

Rufe nach Maßnahmen machen Bürokraten immer glücklich. Also wurde das IPCC, eine ausgesprochen politische „zwischenstaatliche“ Organisation, de facto zur Führungskraft einer gesamten Wissenschaftsdisziplin … was sich als ein gewaltiger Fehler herausstellte.

Bis zu jener Zeit und auch danach bis jetzt gab es in allen anderen Bereichen der Wissenschaft erstaunliche Fortschritte hinsichtlich des Verständnisses ohne irgendein globales „zwischenstaatliches“ Gremium zur Anleitung ihrer Bemühungen. Es gab begeisternde Erfolge mit der gewöhnlichen wissenschaftlichen Methodik, wobei viele Wissenschaftler involviert sind, die ziemlich unabhängig auf der ganzen Welt irgendwelchen wissenschaftlichen Fragen nachgehen, manchmal in Kooperation, manchmal im Wettbewerb, ohne dass sie irgendjemanden brauchen oder haben wollen, der „die Wissenschaft zusammenfasst“, wie es das IPCC zu tun behauptet.