Im Rahmen des bayrischen Mobilfunkpaktes konnte von der Telekom das Funkloch in Weiding im Bayerischen Wald geschlossen werden.

Im Rahmen des bayrischen Mobilfunkpaktes konnte von der Telekom das Funkloch in Weiding im Bayerischen Wald geschlossen werden.

Arndt Dibi

Shared posts

"Es werde Netz": Weiding im Chambtal hat jetzt Mobilfunk

Im Rahmen des bayrischen Mobilfunkpaktes konnte von der Telekom das Funkloch in Weiding im Bayerischen Wald geschlossen werden.

Im Rahmen des bayrischen Mobilfunkpaktes konnte von der Telekom das Funkloch in Weiding im Bayerischen Wald geschlossen werden.

Volkswagen: VW droht neuer juristischer Ärger wegen Verkaufs von Vorserienautos

Apple Pay startet am Dienstagmorgen in Deutschland

Ab morgen früh ist Apple Pay auch in Deutschland verfügbar. Der offizielle Start ist für 7.30 Uhr geplant.

Ab morgen früh ist Apple Pay auch in Deutschland verfügbar. Der offizielle Start ist für 7.30 Uhr geplant.

9 Schritte weg vom festen Job hin zum Vollzeit-Freelancer

Freelancer verdienen sechsstellige Beträge, reisen um die Welt – oder kämpfen jeden Monat aufs Neue darum, die Miete zahlen zu können. Die Wahrheit liegt natürlich irgendwo dazwischen.

Freelancing kann eine sehr attraktive Alternative zu einem geregeltem Job sein. Es gibt dir mehr Freiraum bei der Wahl, welche Arbeit du machen willst, und mehr Flexibilität, wenn es darum geht, wo und wann du arbeitest. Du kannst im Schlafanzug von zu Hause aus arbeiten, du kannst entscheiden, wie viel du arbeiten willst und wie viel du dafür verlangst. Zudem gibt es keinen Chef, der dir sagt, ...

weiterlesen auf t3n.deÜberwachung: Australien kegelt sich aus dem IT-Weltmarkt

Ab Januar müssen Unternehmen australischen Geheimdiensten und Strafverfolgungsbehörden Zugriff auf verschlüsselte Inhalte wie zum Beispiel Kommunikations- oder Bestandsdaten geben. Das ist der Anfang vom Ende des IT-Standorts Down Under - und Deutschland debattiert fröhlich in die gleiche Richtung. Ein IMHO von Jan Weisensee (Crypto Wars, Datenschutz)

Ab Januar müssen Unternehmen australischen Geheimdiensten und Strafverfolgungsbehörden Zugriff auf verschlüsselte Inhalte wie zum Beispiel Kommunikations- oder Bestandsdaten geben. Das ist der Anfang vom Ende des IT-Standorts Down Under - und Deutschland debattiert fröhlich in die gleiche Richtung. Ein IMHO von Jan Weisensee (Crypto Wars, Datenschutz) Vernehmung, die 2.

Manche Dinge muss man nicht verstehen. Zum Beispiel die Ladung zu einer Vernehmung vor dem Landgericht, die meinen Mandanten heute erreicht hat. Er soll als Zeuge aussagen, nächste Woche schon.

An sich ist das natürlich nichts Ungewöhnliches. Wenn mein Mandant nicht schon vor Wochen ausgesagt hätte. Oder besser: nicht ausgesagt hat. Der Mandant war zwar zu seiner letzten Vernehmung erschienen, machte aber von seinem Auskunftsverweigerungsrecht nach § 55 StPO Gebrauch. Er ist in dem fraglichen Tatkomplex nämlich ebenfalls Beschuldigter, allerdings hat er ein eigenes Verfahren bekommen. Dieses Verfahren, das wegen des Wohnsitzes meines Mandanten auch noch vor einem anderen Gericht geführt wird, ist aber noch nicht rechtskräftig beendet.

Im letzten Vernehmungstermin bestand eigentlich Einigkeit, dass mein Mandant nichts sagen muss. Jetzt soll er schon wieder kommen, obwohl sich in der Sache rein gar nichts geändert hat. Einschließlich des Entschlusses des Mandanten, lieber nichts zu sagen.

Aber o.k., wenn ich das jetzt nicht noch abgebogen kriege, fahren wir halt noch mal 350 Kilometer durch die Republik. Ich bin als Zeugenbeistand beigeordnet und werde deshalb ohnehin aus der Staatskasse bezahlt. Nur der Zielort eignet sich irgendwie nicht für eine Lustreise. Aber man kann ja nicht alles haben.

I Have an Exclusive Lock, My Row Is Safe, Right?

Note: This is an update of a blog I posted in 2006 with a lot of additional information (I was less wordy in my 30s apparently). It is just as relevant today.

I have a presentation I do occasionally on concurrency entitled “Let Me Finish” that covers many of the different types of concurrency behaviors that SQL Server uses, both in the on-disk and in-memory tables (you can get that from the latest link here). One of the demos that gets the most attention is probably the least typical scenario, having a reader not blocked by an exclusive lock.

The in-memory engine doesn’t use locks, so this will not pertain with any in-memory tables. But for on-disk tables, it seems obvious that anything exclusively locked will not be touchable by any other user, since an exclusive look (XLOCK) is incompatible with all other lock types, right?

Note: READ UNCOMMITED and the NOLOCK hint are also generally not blocked by an exclusive lock, but let’s try to believe that doesn’t exist.

Well, not exactly, and the reason for this lies in the actual name of the default isolation level READ COMMITTED. Data that is on a page that has not been marked as dirty will (generally, for reasons to come) be available because SQL Server knows that the page has not been changed as that point, so it reads through the exclusive lock (which are most often used by the query processor to mark when a page is being written to).

Note, too that SQL Server has a setting to allow READ COMMITTED isolation level to read the last committed version of a row using statement level snapshot isolation level with the database setting READ COMMITTED SNAPSHOT, in which case even a dirty page would be skipped by a reader. I will discuss that further later in the blog.

For example. say you have the following database:

USE master GO CREATE DATABASE TestReadCommitted GO ALTER DATABASE TestReadCommitted SET READ_COMMITTED_SNAPSHOT OFF; --To make 100% sure GO USE TestReadCommitted;

Then we create the following schema and table with a single row to give us something to lock:

CREATE SCHEMA Demo; GO CREATE TABLE Demo.Test ( TestId int PRIMARY KEY ) GO INSERT INTO Demo.Test(TestId) VALUES(1);

Now, in one connection to SQL Server, run this following command:

SET TRANSACTION ISOLATION LEVEL SERIALIZABLE; BEGIN TRANSACTION; SELECT * FROM Demo.Test WITH (XLOCK);

By using the SERIALIZABLE isolation level, we have applied the most strict isolation level such that no other user can make any changes to this table. No new (phantom) rows, and no changed (non-repeatable read) rows either. Without the XLOCK hint, our row would have shared range locks on all existing rows, as well as any preventing any new rows in the table, but all users would have access to the row. Adding in the XLOCK hint to the query, and now all locks will be exclusive locks.

For more reading on this subject, go check Rodney Landrum’s blog here on the topic, which has techniques to see the locks, including using sp_lock and sys.dm_tran_locks.

Now, if you execute either of the following statements on a different connection:

SET TRANSACTION ISOLATION LEVEL READ COMMITTED; SELECT * FROM Demo.Test WITH (XLOCK); GO SET TRANSACTION ISOLATION LEVEL READ COMMITTED; UPDATE Demo.Test SET TestId = TestId;

You will be blocked from running your query. The first because the exclusive lock is not compatible with the already exclusively locked row. The second for the same reason, except we are actually trying to change the row.

However, if a typical reader were to come in and run a typical query:

SET TRANSACTION ISOLATION LEVEL READ COMMITTED; SELECT * FROM Demo.Test;

You will find that the SELECT statement executes, ignoring the exclusive lock, because it is not a write lock, and the data on the page has not been changed.

The main reason people try to do this is to force access to a row in a single threaded manner. For example, building their own sequence number, either in a row they update, or by trying to do MAX() on all of the data in a table to make sure only one reader gets the same value.

This is generally a bad idea, since locking an entire table is a generally bad idea, but if you needed to block readers, you can couple the XLOCK with a PAGLOCK. So, change the first reader to:

BEGIN TRANSACTION; SELECT * FROM Demo.Test WITH (XLOCK,PAGLOCK);

And retry the experiment. Now you will find the reader is blocked (Again thanks to Tibor Karazi for pointing this one out to me oh so many years ago, and it has been a lesson I still remember).

Just bear in mind that in a normal usage of a statement like this, you are probably trying to lock a single row. But by adding the PAGLOCK hint, you have now blocked 8060 byte exclusively. Maybe not an issue, but certainly could be in a highly contentious database with smaller row size.

In the start of this blog, I noted READ COMMITTED SNAPSHOT had an effect on being able to read exclusively locked rows. If we turn this setting on for the database, no user in READ COMMITTED isolation level will be blocked when reading this row.

ALTER DATABASE TestReadCommitted SET READ_COMMITTED_SNAPSHOT ON;

Now, even if the user executes, making the page the row sits on marked as dirty, and the row exclusively locked:

BEGIN TRANSACTION; UPDATE Demo.Test SET TestId = TestId * 100;

No matter if this user leaves the transaction open for all day, any user in the default isolation level of READ COMMITTED will not be blocked and will see the original value of 1 until the transaction is committed. (Ideally, your transactions are kept short so the version store can be flushed of needless versions, but long running transactions happen):

BEGIN TRANSACTION; SELECT * FROM Demo.Test;

I include the BEGIN TRANSACTION for the second query to make a finer point about READ COMMITTED SNAPSHOT. If you use the full SNAPSHOT isolation level, readers will get the same result back every time once their transaction has started (meaning they have read anything from the database.) So:

SET ISOLATION LEVEL SNAPSHOT; BEGIN TRANSACTION; SELECT * FROM Demo.Test; SELECT * FROM Demo.Test;

No matter how many times you run that SELECT statement in that same transaction, the results will be the same, or your transaction will be cancelled. The extends to other tables as well, your view of all of the tables in the database container (all of the on-disk tables in a database) will look like they did when your first statement accesses data (not when the transaction occurs).

However in READ COMMITTED SNAPSHOT readers are only guaranteed consistent results at the statement level. Once the rows are returned, the results of the UPDATE will be visible to the reader.

So in the case of:

SET ISOLATION LEVEL READ COMMITTED; BEGIN TRANSACTION; SELECT * FROM Demo.Test; SELECT * FROM Demo.Test;

Once your query starts, it will see the table as it was when the statement started, but the second SELECT statement may return a completely different set of data if between the start of the first SELECT the data has changed.

Summary

The main thing to take away here is that locking is complicated, and the relational engine creators will do anything they can to improve performance. If you need certain guarantees of how your data is protected from change to your readers, you need to understand the isolation levels well enough to protect yourself.

Exclusively locked rows are not really exclusively locked from all other users. Just more exclusively locked than shared locks. (And READ UNCOMMITTED isn’t always allowed to see data in any scenario, such as seeing a table and data that is being created using SELECT INTO.) Be sure and test your code for how it will behave in concurrent processing scenarios, and when testing in a query tool, use WAITFOR statements to slow down time. For most situations you can devise a manner to slow down time and see what two statements will do to one another.

The post I Have an Exclusive Lock, My Row Is Safe, Right? appeared first on Simple Talk.

Wann darf der Chef eigentlich Überstunden einfordern – und wie viele?

Die Deutschen arbeiten wie verrückt: Jeder Fünfte macht mehr als zehn Überstunden die Woche – laut einer Xing-Umfrage. Doch wie sieht eigentlich die Rechtslage dazu aus?

Jeder kennt das Szenario: Die Deadline rückt immer näher. Das Projekt muss heute noch eingereicht werden, doch die Uhr tickt gegen einen. Was bleibt also übrig, als in den sauren Apfel zu beißen und Überstunden in Kauf zu nehmen. „Der Yoga-Kurs muss erst einmal warten“, ruft der Chef und klatscht dabei motivierend in die Hände. Doch so einfach ist es dann doch nicht. Denn anders als viele ...

weiterlesen auf t3n.deBMW Werk Leipzig: Interner Transport mit Wasserstoff-Zügen

Fahrzeuge mit Wasserstoff-Antrieb waren im BMW Werk Leipzig schon 2013 im Einsatz, nun wird die Flotte deutlich ausgebaut: 70 neue Routen-Züge mit Wasserstoff-Antrieb versorgen die Montagebänder mit den von Zulieferern bereitgestellten Komponenten. Die Indoor-Schlepper sollen die Transporte innerhalb des Werks so zukunftsfähig, nachhaltig und zugleich wirtschaftlich wie möglich machen.

Die BMW Group arbeitet dafür in einem Konsortium mit Fronius, Linde Material Handling, Günsel Fördertechnik und der TU München zusammen. Auch das Bundesministerium für Verkehr und digitale Infrastruktur unterstützt das Konsortium, weil es sich von der Entwicklung und Erprobung der Wasserstoff-betriebenen Logistik-Helfer auch Lösungen für viele andere Unternehmen erhofft. Ziel ist es, den Industriestandard H2Ready zu etablieren und die Nutzung von Wasserstoff- und Brennstoffzellen-Technik zu standardisieren.

Hans-Peter Kemser (Leiter BMW Group Werk Leipzig): „Die Wasserstoff-Indoor-Flotte ist ein weiterer Meilenstein der Nachhaltigkeitsstrategie des BMW Group Werks Leipzig. Damit kommen wir dem Zukunftsbild einer CO2-freien Produktion wieder einen Schritt näher. Für unser Strategiefeld „Grünes Werk“ arbeiten wir darüber hinaus an weiteren Projekten. Hierzu gehört der Einsatz von Wasserstoff-LKWs, die Umrüstung weiterer Gebäude und Strukturen für den Einsatz von Wasserstoff bis hin zu Untersuchungen einer CO2-freien Wasserstofferzeugung vor Ort mit der Nutzung der Windkrafträder auf unserem Werksgelände.“

Thomas Herndler (CTO Fronius): „Die Mobilität der Zukunft basiert auf grünen Antriebslösungen, fossile Brennstoffe sollen im Zuge der Energiewende nach und nach durch erneuerbare Energieträger ersetzt werden. Fronius treibt diese Entwicklung mit seinen Produkten und Lösungen seit vielen Jahren aktiv voran. Die Technologieplattform HYLOG FLEET ist seitens Fronius über viele Jahre hinweg im Rahmen mehrerer Demonstrations- und Forschungsprojekte entwickelt worden. Mit diesem Flottenversuch können wir endgültig beweisen, dass der Einsatz von Wasserstoff als Energieträger in verschiedenen Applikationen in Zukunft wirtschaftlich darstellbar ist. Generell stellt die Wasserstofftechnologie bei Fronius eine wichtige Rolle zur Sektorenkopplung dar. Besonders die dezentrale, verbrauchernahe Erzeugung von grünem Wasserstoff aus erneuerbaren Energieüberschüssen bietet enormes Potential. Anwender können sich damit vor Ort selbst den Treibstoff für die mit Brennstoffzelle ergänzten Elektrofahrzeuge erzeugen und zusätzlich die entstehende Abwärme nutzen.“

Christophe Lautray (CSO Linde MH): „Die Vorteile, die Wasserstoff als Energieträger und die Brennstoffzelle für den Einsatz in der Intralogistik bieten, hat Linde Material Handling als erster Hersteller erkannt. Wir sind dabei fest davon überzeugt, dass sich der Einsatz von Wasserstoff als nachhaltige Alternative in den kommenden Jahren etablieren wird. Daher haben wir bereits jetzt das breiteste Produktportfolio mit serienmäßig verfügbaren Brennstoffzellen für unsere Fahrzeuge. Mittlerweile sind diese für 80 Prozent unserer Elektrofahrzeuge erhältlich und wir erweitern unser Angebot kontinuierlich.“

René Günsel (Geschäftsleiter Günsel Fördertechnik): “Mit dem Projekt „Wasserstoffbetriebene Flurförderzeuge“ erhoffen wir, dazu beitragen zu können, unseren Kunden eine langfristige CO² neutrale Antriebstechnologie für ihre Linde MH Elektrostapler und Lagertechnikgeräte anzubieten. Wir freuen uns sehr, bei diesem Vorhaben mit dabei sein zu dürfen.”

Wolfgang Axthammer (Geschäftsführer NOW GmbH): „Die Intralogistik ist eine wachsende Branche in Deutschland, Europa und der Welt. Zwar herrscht hoher Preisdruck, dennoch gibt es zunehmendes Streben nach Dekarbonisierung von Logistik-Standorten und Flotten. Dem trägt die Einbeziehung der Intralogistik in die Förderung der Bundesregierung im Nationalen Programm Wasserstoff- und Brennstoffzellentechnologie Rechnung. Dieses Beispiel gebende Projekt wurde mit rund 2,8 Mio. Euro Fördergeld des Bundesverkehrsministeriums unterstützt.“

Prof. Johannes Fottner (TU München): „Das Forschungsprojekt untersucht und zeigt die Eignung der Brennstoffzellentechnologie auch für größere Flurförderzeugflotten. Damit kann eine weitere Technologie, die bei bestimmten Randbedingungen klare Vorteile bietet, industriell eingesetzt werden. Sie erweitert das bereits bestehende Portfolio und kann einen Beitrag zur optimalen Systemgestaltung leisten.“

Wie Böden das Klima beeinflussen

Dem Max-Planck-Institut für Biogeochemie in Jena ist es gelungen, eines der begehrten Projekte des Europäischen Forschungsrats (European Research Council ERC) im Umfang von einer Million Euro zu gewinnen. Das Projekt QUASOM, das sich der Rolle des Bodens für das globale Klima widmet, konnte sich europaweit bei einer Förderquote von nur drei Prozent gegen mehr als 9000 Konkurrenten durchsetzen. Es wird von der Europäischen Union über fünf Jahre gefördert.

Diese Karte zeigt, wieviel organischer Kohlenstoff weltweit in Böden vorhanden ist

Das Projekt, das Nachwuchsgruppenleiter Markus Reichstein zusammen mit seinen Kollegen am Max-Planck-Institut Gerd Gleixner, Marion Schrumpf, Christian Beer und Thomas Wutzler beantragt hatte, widmet sich der Rolle des Bodens für das Klima. „Die Böden der Erde enthalten mehr als doppelt soviel Kohlenstoff wie die Atmosphäre“ erklärt Markus Reichstein, „und jedes Jahr strömen global schätzungsweise 60 bis 80 Gigatonnen (1 Gigatonne = 1 Million x 1 Million Tonnen) als Kohlendioxid vom Boden in die Atmosphäre, also etwa zehnmal so viel wie die aktuellen CO2-Emissionen durch den Menschen.“ Allein das macht die Bedeutung der Böden für den Kohlenstoffkreislauf und damit für das Klimasystem deutlich. „Die Repräsentation des Bodens in heutigen Klimamodellen, wie sie auch vom Weltklimarat (IPCC) angewendet wurden, ist jedoch erstaunlich simpel und vernachlässigt wichtige, insbesondere biologische Prozesse. Diese Lücke wollen wir helfen, zu schließen“, sagt Markus Reichstein.

Das Projekt kann dabei auf eine hervorragende Infrastruktur am Institut und in der durch die Max-Planck-Gesellschaft geförderten „Selbstständigen wissenschaftlichen Nachwuchsgruppe“ sowie auf reichhaltiges Wissen aus den Institutsabteilungen Biogeochemische Prozesse (Ernst-Detlef Schulze; detaillierte Ökosystemprozessstudien) und Biogeochemische Systeme (Martin Heimann, globale Beobachtung des Kohlenstoffkreislaufs) aufbauen. Nicht zuletzt erhoffen die Antragsteller auch eine Intensivierung der Zusammenarbeit und Synergien mit den ausgezeichneten Boden- und Umweltwissenschaftlern der FSU Jena (z. B. Institute für Geowissenschaften, für Geographie, für Ökologie und für Mikrobiologie), die insgesamt zu einer weiteren wesentlichen Stärkung des umweltwissenschaftlichen Profils am Standort Jena führen werden.

Hue Lightstrip Outdoor im Test: Smarte LED-Leiste kämpft mit Zigbee-Beschränkungen

Nach der Lichtleiste für drinnen hat Philips nun auch eine Hue-Variante für den Außeneinsatz im Sortiment. Wir haben die Hue Lightstrip Outdoor getestet und sind dabei auf lästige Beschränkungen gestoßen. Teilweise sind diese auch vom Hersteller selbst verschuldet. Ein Test von Ingo Pakalski (Hue, Philips)

Nach der Lichtleiste für drinnen hat Philips nun auch eine Hue-Variante für den Außeneinsatz im Sortiment. Wir haben die Hue Lightstrip Outdoor getestet und sind dabei auf lästige Beschränkungen gestoßen. Teilweise sind diese auch vom Hersteller selbst verschuldet. Ein Test von Ingo Pakalski (Hue, Philips) Verkehrsregeln: Muss ich wirklich an jedem Stoppschild halten?

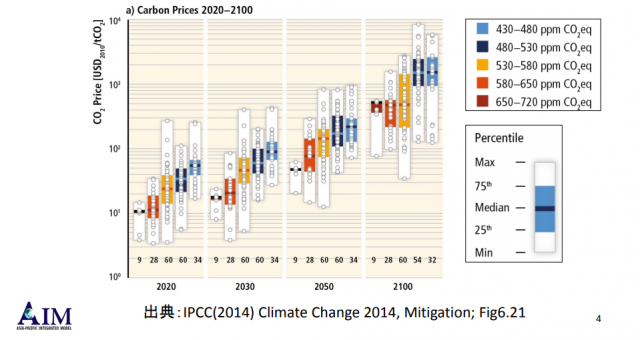

Frankreich verzögert nach Protesten zusätzliche CO2 Steuern, die die Globale Erwärmung bekämpfen sollen – Die UN will noch viel mehr

Frankreichs geplante Kohlendioxidsteuer auf Diesel hätte 37 USD pro metrische Tonne betragen. Aber das ist ungefähr die Hälfte der von der UNO geforderten CO2-Steuer, um die globale Erwärmung unter 2 Grad Celsius zu halten, so der Umweltökonom Richard Tol.

Richard Tol auf Twitter (gezeigte Grafik nachfolgend)

Macron versuchte, eine Dieselsteuer in Höhe von 37 USD / t CO2 zu erheben, für Benzin 22 USD / t CO2.

Laut IPCC sollte die CO2-Steuer 50-60 $ / tCO2 betragen, um überhaupt die Chance zu haben, die mittlere Oberflächentemperatur der Luft unter 2 Grad Celsius über dem vorindustriellen Niveau zu halten.

Obige Grafik im Original als PDF auf einer japanischen Seite gefunden – nicht im Bericht der UN enthalten

Titelfolie:

Ausschuss für allgemeine Ressourcen und Energieforschung

Arbeitsgruppe zur Überprüfung der Stromerzeugungskosten (2. Sitzung)

Dokument 8

Auf Preiseinstellung für Kohlendioxid

Toshihiko Masai

Nationales Institut für Umweltstudien

Arbeitsgruppe zur Überprüfung der Stromkosten (2)

3. März 2015

(Übersetzt mit Google translate)

Der Bericht der UN zur Emissions Gap [.. Lücke] deutet darauf hin, dass eine CO2-Steuer von 70 USD je Tonne die Kohlendioxidemissionen, die für die globale Erwärmung verantwortlich gemacht werden, weiter senken wird.

„Studien zeigen, dass eine CO2-Steuer von 70 USD / tCO2 zusätzlich zu den bestehenden Maßnahmen die Emissionen in einigen Ländern von knapp über 10 Prozent auf über 40 Prozent in anderen Ländern reduzieren könnte“, so der Report: CO2 Emissions Gap Report der Vereinten Nationen.

Die französische Regierung kündigte an, die Einführung der CO2-Steuern um Wochen später zu verschieben. Bei den Protesten wurden mindestens drei Menschen getötet, mehr als 100 wurden verletzt und die Polizei verhaftete Hunderte mehr.

Zehntausende von Gilets Jaunes oder „gelbe Westen“ gingen auf die Straße der großen französischen Städte, darunter in Paris, um gegen hohe CO2-Steuern und damit gegen Erhöhung der Treibstoffpreise zu protestieren. Viele Demonstranten sagen, sie leiden bereits sehr unter gestiegenen Energie- und Wohnkosten.

Während Macron vorerst keine CO2-Steuern erhöht , wird er seine Verpflichtung zur Erreichung der Ziele des Pariser Klimaabkommens wahrscheinlich nicht aufgeben.

Frankreich ist Vertragspartei des Pariser Klimaabkommens, das die globale Erderwärmung durch Emissionssenkungen bis 2100 unter 2 Grad Celsius halten soll. Die Vereinten Nationen drängen jedoch darauf, die künftige Erwärmung bis 2100 unter 1,5 Grad zu halten – ein Plan, der laut Aussage noch höhere Steuern erfordern würde.

Der im Oktober veröffentlichte Klimabeschluss der Vereinten Nationen stellte fest, dass bis 2030 eine CO2-Steuer in Höhe von 5.500 USD je Tonne erforderlich sein müsste, um die zukünftige Erwärmung zu begrenzen. Dies entspricht einer Treibstoffsteuer in Höhe von USD 49 USD pro Gallone. (3,6 L)

Eine CO2-Steuer müsste bis Ende des Jahrhunderts auf bis zu 27.000 USD pro Tonne steigen, um das 1,5-Grad-Ziel zu erreichen. Das entspricht einer Treibstoff-Steuer von 240 USD pro Gallone im Jahr 2100. (entspricht dann 66,7 Euro / L)

Wenn die Franzosen gegen eine Kohlendioxidsteuer aufstehen und protestieren, die nur einen Bruchteil des von der UN-Forderung geforderten beträgt, ist es unwahrscheinlich, dass eine Regierung eine derart hohe Steuer durchsetzen würde.

In Frankreich machen Steuern bereits rund 60 Prozent des Kraftstoffpreises aus. (in Deutschland fast 70%) Die durchschnittlichen Kosten für das Auffüllen Ihres Tanks in Frankreich belaufen sich auf knapp 7 US-Dollar pro Gallone.

Gefunden auf The Daily Caller vom 04.12.2018

Übersetzt durch Andreas Demmig

https://dailycaller.com/2018/12/04/france-global-warming-taxes-un/

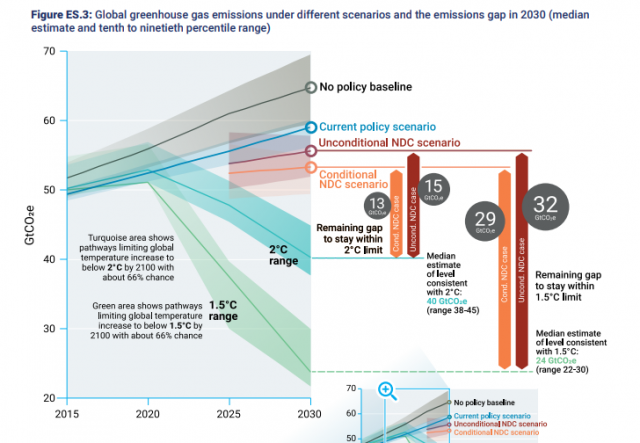

Ergänzung durch weitere Grafiken aus o.g. Emissions Gap Report der Vereinten Nationen

Szenarien, 66% Chance, die Temperatur bis 2100 unterhalb von 2°C / 1,5 °C … zu begrenzen – unbeeinflusst steigt die Temperatur bis 2100 um 2,9 bis 3,4 °C (im Text, S. 10)

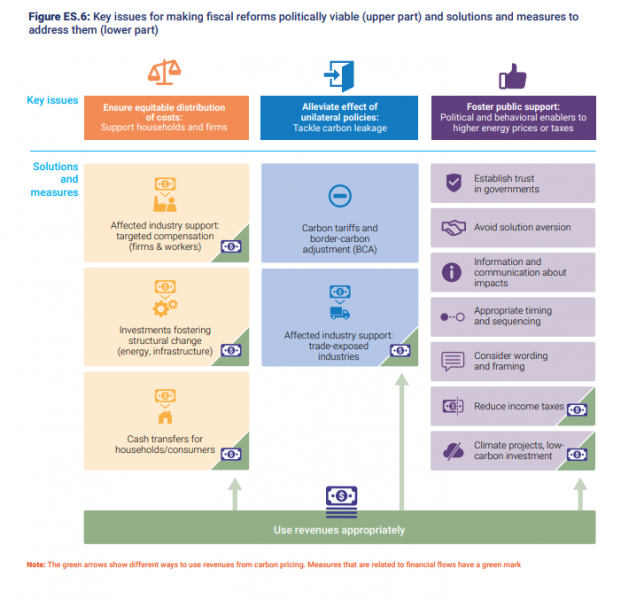

Die Schlüsselthemen, zur Erreichung der CO2 Reduktionen.

Hier sei nur ein Punkt heraus gegriffen (oben rechts): establish trust in goverments – schaffen Sie Vertrauen in die Regierung

Stiftung Warentest: Jedes vierte Produkt für Kinder mangelhaft

Scrum: Was ist eine Story-Map?

Die Story-Map ist eine Visualisierungsmethode aus dem Bereich der agilen Softwareentwicklung und dient zur übersichtlichen Darstellung von Anforderungen und dem besseren Verständnis der Benutzerbedürfnisse.

Wie funktioniert eine Story-Map? Grundsätzlich verfügt eine Story-Map über zwei verschiedene Elemente: Epics und User-Storys. Bei den Epics handelt es sich um die Zusammenfassungen ähnlicher User-Storys, die die Anforderungen auf einer hohen Abstraktionsebene beschreiben. Die User-Storys hingegen dienen zur Darstellung der einzelnen Schritte, die zur Durchführung der Epics stattfinden müssen. Das...

weiterlesen auf t3n.deSecure access to Office 365 with Active Directory Federation Service 2019

Microsoft offers three different sign-in methods for your users to Office 365 applications:

- Password-hash synchronization

- Pass-through Authentication

- Active Directory Federation Services, otherwise known as “AD FS”

The following diagram shows the difference between the available sign-in methods:

Many large organizations, mostly enterprise-scale, already use AD FS for other on-premises or cloud applications. The underlying principles behind AD FS are the use of claims-based authentication and federated trusts. These establish a mechanism by which one environment, for example, your on-premises Active Directory can securely transmit a token of authentication to another environment, such as Microsoft Azure Active Directory.

You can expand your issuer’s capabilities to accept a security token from another issuer, instead of requiring the user to authenticate directly. Your issuer would issue security tokens and accept security tokens from other issuers that it trusts. This enables you to federate identity with other realms, which are separate security domains. In other words, a federation trust is the embodiment of a business-level agreement of partnership between two organizations.

The federated partner’s Identity Provider (IdP), i.e. Azure Active Directory and Active Directory Federation Services, sends claims that reflect its users’ identity, groups, and attribute data. Therefore, your organization no longer needs to revoke, change, or reset the credentials for the partner’s users, since the credentials are managed by the partner organization. You reconfigure one issuer, and many downstream applications become accessible to many new users. Additionally, if a partnership needs to be terminated, it can be performed with a single trust policy change, e.g. change, disable, or remove the trust policy. Without AD FS, individual accounts for each partner user would need to be deactivated.

Defending against Password Spray Attacks

One common way that online accounts are breached is password spray. The attackers try the most common passwords across many different accounts and services to gain access to any password-protected asset they can find. Usually, the span targets many different organizations and identity providers to enumerate all the users and then tries different passwords against all of all those accounts. A commonly available toolkit is Mailsniper. At Ignite 2018, Anand Yadav showed the common passwords in password spray attacks:

Attackers know that there are some very common passwords out there. Even though the most common passwords account for only 0.5 – 1.0% of accounts, the attacker will get a few successes for every thousand accounts attacked, and that’s enough to be effective.

To avoid password spray attacks within your organization, a good approach is to disable legacy authentication from the extranet. You can disable basic authentication in Exchange Online, which is currently in preview. Basic authentication in Exchange Online accepts a username and password for client access requests, and blocking basic authentication can help protect your Exchange Online organization from brute force or password spray attacks.

Another way to block legacy authentication from the extranet is Conditional Access. For example, SharePoint Online and Exchange Online supports the legacy authentication protocol to access the service in Office 365.

Of course, you can configure issuance authorization rules to enable or block traffic at the AD FS level as well. For example, to block legacy traffic from the extranet you could configure three rules in the issuance authorization rules either in the AD FS management console or via Windows PowerShell:

Rule 1: Allow all intranet traffic<br>@RuleName = "Allow all intranet traffic"<br>c1:[Type == "http://schemas.microsoft.com/ws/2012/01/insidecorporatenetwork", Value == "true"]<br>=> issue(Type = "http://schemas.microsoft.com/authorization/claims/permit", Value = "true");

Rule 2: Allow Exchange ActiveSync<br> @RuleName = "Allow Exchange ActiveSync"<br> c1:[Type == "http://schemas.microsoft.com/2012/01/requestcontext/claims/x-ms-client-application", Value == "Microsoft.Exchange.ActiveSync"]<br> => issue(Type = "http://schemas.microsoft.com/authorization/claims/permit", Value = "true");

Rule 3: Allow extranet browser and browser dialog traffic<br> @RuleName = "Allow extranet browser and browser dialog traffic"<br> c1:[Type == "http://schemas.microsoft.com/ws/2012/01/insidecorporatenetwork", Value == "false"] &&<br> c2:[Type == "http://schemas.microsoft.com/2012/01/requestcontext/claims/x-ms-endpoint-absolute-path", Value =~ "(/adfs/ls)|(/adfs/oauth2)"]<br> => issue(Type = "http://schemas.microsoft.com/authorization/claims/permit", Value = "true");

Legacy client apps from the extranet will be blocked at the AD FS level.

Active Directory Federation Services Smart Lockout

Smart Lockout enables AD FS to differentiate between sign-in attempts that look like they are from the valid user and sign-ins from what may be an attacker. As a result, AD FS can lock out attackers while letting valid users continue to use their accounts. It also protects against brute force password-guessing attacks. Extranet Soft Lockout was introduced in AD FS on Windows Server 2012 R2, Windows Server 2016 introduces Extranet Smart Lockout, and Windows Server 2019 provides additional advantages of Extranet Smart Lockout, like:

- Set independent lockout thresholds for familiar and unfamiliar locations

- Enable audit mode for smart lockout while continuing to enforce previous soft lockout behavior

Your infrastructure must meet some pre-requisites, depending on your AD FS version and Forest Functional Level. More details on the pre-requisites and how to configure different AD FS Smart Lockout features can be found in the docs.microsoft.com article.

Multi-Factor Authentication (MFA)

From a security perspective, all your admin accounts should have MFA enabled. Security breaches of an Office 365 subscription, including information harvesting and phishing attacks, are typically done by compromising the credentials of an Office 365 global administrator account. Also, every user and admin access from the extranet should be secured with a second factor, like Azure MFA or other third-party solutions. For even more security, you can use Azure MFA to require multi-factor authentication for your users all the time, both in cloud authentication and AD FS. While this requires your users to always have an additional device, for example, a mobile phone, and perform multi-factor authentication more frequently, it provides the most security for your enterprise.

Since AD FS 2016, you have the ability to use Azure MFA as primary authentication for passwordless authentication, which means you don’t have to provide a username and password, for example from extranet connections. This is great to guard against password spray and password theft attacks. Additionally, you can use form-based authentication with username and password as the second factor only after your OTP (one time password) has been validated with Azure MFA. This method keeps your internal network “clean” from attackers because they first must provide the Azure MFA authentication prior to accessing your AD FS infrastructure.

Azure Active Directory Identity Protection

Identity Protection detects risk events involving identities in Azure Active Directory that indicate that the identities may have been compromised. This can be used with federated identities as well, but only Sign-in risk policy is included, User risk policy is currently not supported for federated domains. All of Identity Protection’s risk event types are covered for federated identities, which means you can see if botnet infections, TOR networks, or location anomalies are present in your federated sign-ins. Note that leaked credentials detection requires that you have enabled password hash sync in your federated tenant.

Azure Active Directory currently detects six types of risk events:

- Users with leaked credentials

- Sign-ins from anonymous IP addresses

- Impossible travel to atypical locations

- Sign-ins from infected devices

- Sign-ins from IP addresses with suspicious activity

- Sign-ins from unfamiliar locations

For more information about the different policy types and how to configure Azure Active Directory Identity Protection, visit the following docs.microsoft.com article.

Azure Active Directory Password Protection

Azure AD Password Protection (currently in public preview) enhances password policies in your organization, in the cloud and on-premises.

Microsoft uses a global banned password list, which means the Azure team continually look for commonly used and compromised passwords and block passwords that are deemed too common. Cyber-criminals also use similar strategies in their attacks, therefore Microsoft does not publish the contents of this list publicly.

Some organizations may want to take security one step further by adding their own customizations on top of the global banned password list, which is called custom banned list.

It is also possible to install Azure AD password protection agents on-premises (currently in preview) to extend the banned password list to your existing infrastructure. Now users and administrators who change, set, or reset passwords on-premises are required to comply with the same password policy as cloud-only users.

Microsoft provides a lot of different ways to secure your access to Office 365, even if you are using cloud-only or federated identities. This blog has covered some of the features offered by Microsoft to protect your organization from attackers for your federated identity hybrid cloud environment.

The post Secure access to Office 365 with Active Directory Federation Service 2019 appeared first on Practical 365.

Office | “Zuletzt verwendet” und OneDrive

Ich war mir nicht sicher, ob dies nur eine neue Funktion von Office ist, oder ob da der Next Generation Snyc Client (NGSC) ebenfalls etwas beisteuert. Aber auf diese Intelligenz habe ich schon sehr lange gewartet.

Problembeschreibung

1. Ich erstelle ein Dokument (Word)

2. Ich speichere das Dokument (A.docx)

3. Ich schließe die Anwendung (Word)

4. Ich ändere den Namen des Dokumentes im Windows Explorer von A.docx in B.docx)

5. Ich starte die Anwendung (Word)

In den zuletzt benutzen Dokumenten steht natürlich A.docx

Ist eigentlich logisch. Aber wir haben mittlerweile unzählige Änderungen in den Office Paketen erfahren, und bis vor kurzem wurde ich noch mit einer Fehlermeldung konfrontiert, wenn ich auf den Eintrag A.docx klicke, um ihn zu öffnen.

Und jetzt?

Jetzt öffnet sich B.docx und sie können sofort damit arbeiten. Allerdings funktioniert das nur unter bestimmten Umständen. In der ‘Zuletzt verwendete Daten” Liste der Office Pakete steht nämlich danach B.docx

Funktioniert das überall?

Nein, weil nämlich der Next Generation Sync Client in der jeweiligen Site Collection von SharePoint Online nachschaut, ob er etwas findet. Und natürlich hat der Sync Client die Namensänderung im Windows Explorer in die Cloud transportiert.

Das bedeutet also

a) Es wird die Office Version (C2R) 1811 Build 11029.20070 oder höher benötigt

b) Next Generation Sync Client Version 18.212.1021.0007 oder höher benötigt

c) Speicherort muss eine SharePoint Bibliothek oder OneDrive for Business sein.

Offene Fragen:

1. Funktioniert das auch, wenn die Historie ausgeschaltet ist?

2. Funktioniert das auch, wenn eine Datei in einen anderen Ordner verschoben wird (innerhalb einer Dokumenten-Bibliothek)

a. Im Explorer Ja

b. Im Web-Browser (MOVE): Ja

3. Funktioniert das auch, wenn eine Datei von einer Dokumenten-Bibliothek in eine andere Dokumenten-Bibliothek verschoben wird?

a. Im Explorer: Nein

b. Im Web-Browser (MOVE) Nein

Zusammenfassung

bei nachstehender Tabelle bedeuten die Spalten

Web: die Aktion wird in einem Browser durchgeführt, und das Ergebnis danach in Word (nicht Word Online) betrachtet

Historie W: bleibt die Historie bei der in Web durchgeführten Aktion erhalten?

Explorer: wie Web, jedoch wird die Aktion im Windows Explorer ausgeführt

Historie E: bleibt die Historie bei dieser Aktion erhalten?

|

Beschreibung |

Web |

Historie W |

Explorer |

Historie E |

|

Umbenennen einer Datei |

J |

J |

J |

J |

|

Verschieben innerhalb der aktuellen Bibliothek |

J |

J |

J |

J |

|

Verschieben in eine andere Bibliothek *1) |

N |

J |

N |

N |

*1) Die Fehlermeldung: Upload Error

Frage:

Funktioniert das auch mit anderen Dateien wie z.B. Bilder

Antwort:

Nein, weil der Dialog zuletzt verwendet bei Nicht Office Anwendungen nicht in der Form I existiert.

Frage:

Funktioniert das auch mit Office 2013

Antwort:

Nein, dort ist der Dialog zwar vorhanden, aber die eingebaute Funktion nicht

Frage:

Funktioniert das mit einem MSI Paket von Office

Antwort:

Ja und Nein, in den alten MSI-Pakten ist die Funktion noch nicht eingebaut gewesen, in den neuen, die es noch nicht gibt, dann schon.

Frage:

Funktioniert das auch bei OneDrive (Consumer/Personal)?

Antwort:

Bisher nicht. Eigentlich arbeiten doch viele Privatanwender auch mit Office.

Zusammenfassung

Endlich muss ich mir keine Gedanken machen, ob ich ein Office Dokument umbenannt oder verschoben habe. Es wird einfach geöffnet. Ein paar Fragen sind noch offen. Ich habe bei Microsoft nachgefragt, und man arbeitet dran.

Die Signale der nächsten Blackouts: Ruhiges Wetter & Sonnenuntergang sorgen für erneuerbares Chaos in Australien

Im vergangenen Sommer kam es in Südaustralien, Victoria und New South Wales zu Stromausfällen. Energiehungrige Unternehmen wie Aluminiumhütten und sogar Krankenhäuser wurden an Tagen und Nächten, in denen die Temperaturen steigen und die Windleistung sinkt, zum Stillstand gebracht: Australien schließt Kohlekraftwerke: Krankenhäuser werden gezwungen, den Stromverbrauch zu reduzieren, bei in die Höhe schießenden Energiepreisen

In diesem Sommer wird die Motivation zum Holzkohlegrill buchstäblich eine weitere Runde des sogenannten „Bedarfs-Managements“ sein: Energierationierung, ein wesentlicher Bestandteil des lächerlichen Versuchs Australiens, mit Sonnenschein und Wind zu überleben. Wenn es nicht tödlich ernst wäre [Vorbild: DISASTER MANAGEMENT IN GERMANY], wäre es fast komisch.

STT legte, vor etwa einer Woche, den Finger auf die Wunde – Die Hölle in den Sommerferien: Stromverbraucher erleben steigende Kosten, wenn der Wind nicht weht – Denn in Australien sind Klimaanlagen sehr verbreitet. Hier die Überlegungen von JoNova, die sich mit demselben Thema befasst.

Südaustralien und Victoria sind in diesem Sommer von Stromausfällen bedroht.

Jo Nova, 18. November 2018

Sogar der australische Energielieferant AEMO warnt vor Stromausfällen, da die Wettervorhersage heiße, trockene Bedingungen ankündigt. El Nino ist auf dem Weg und ich höre Gerüchte, dass die Wasserstände in unseren Talsperren nicht besonders sind (Snowy Hydro Dam).

In diesem Sommer wird es Stromausfälle geben, wenn nichts getan wird, warnt der AEMO-Bericht

Stephanie Dalzell, ABC News

In Victoria und Südaustralien besteht in diesem Sommer ein hohes Risiko für erzwungene Stromausfälle, wenn nach dem jüngsten Bericht des australischen Energiemarktbetreibers (AEMO) keine Maßnahmen ergriffen werden.

Nicht genügend elektrische Energie? Schmeißen Sie eine weitere Million Dollar in den Ofen:

Um dies zu verhindern, hat der AEMO Notstromreserven angeschafft, die dem Markt normalerweise nicht zur Verfügung stehen und nur eingesetzt werden, wenn das Angebot nicht mit dem Bedarf übereinstimmt.

Diese Notfallreserven – auch als Reliability and Emergency Reserve Trader (RERT – Notstromreserve] bezeichnet – sind nicht billig.

Es kostet nur Geld:

Im Bericht zum letzten Sommer heißt es, dass der „Notstrom“ die Verbraucher in Victoria und Südaustralien fast 52 Millionen Dollar kostete.

Dies entsprach einem durchschnittlichen Aufpreis von 6 USD je Haushalt.

Das ist noch Garnichts. Im vergangenen Januar summierte sich die zweitägige Hitzewelle auf 400 Millionen Dollar – 45 Dollar in Victoria und 70 Dollar in Südaustralien, jeweils pro Einwohner. Und das für nur zwei Tage Strom. Familien mussten 200 Dollar für zwei Tage Strom bezahlen. Das ist ein Notfall.

Warum ist die angegebene Kapazität nicht verfügbar?

Andrew White von The Australian erklärt, ein Teil des Energie- Engpasses ist darauf zurückzuführen, dass der Betreiber eines Kohlekraftwerks der AEMO gerade mitgeteilt hat, dass 240 MW (Reserveleistung) nicht wie erwartet für den Sommer verfügbar sind.

Die Reserven wurden in dieser Saison durch den Verlust von 240 Megawatt thermischer Erzeugung reduziert. Der Eigentümer des Kraftwerks gab bekannt, dass diese Leistung nicht für kurzfristige Nachfragespitzen im nationalen Elektrizitätsmarkt NEM zur Verfügung stehen wird.

Die AEMO strebt eine Reserveleistung von bis zu 930 MW an, um den nationalen Energiemarkt zuverlässiger zu machen. Es wird ein heißer, trockener Sommer und eine frühe Buschfeuersaison erwartet.

Das gesamte Australische Energienetz verfügt über eine Nennkapazität von 55.000 MW . Der Ausfall von 240 MW soll jedoch einen Notfall verursachen? Etwas passt hier nicht zusammen …

Was wäre, wenn ab morgen keine 5.000 MW Wind- oder Solar- (Nennleistungs-) kapazität verfügbar wäre? Das ist kein Notfall, es ist wie inzwischen gewöhnt. Jeden Tag zahlen wir für Reserve-backup Kraftwerke, fall sich mal der Wind und die Sonne einen Tag frei nehmen.

Zur den Notmaßnahmen gehören… „die Erinnerung an eingemottete Gaserzeugungsanlagen in Tasmanien, Queensland und Südafrika, Dieselgeneratoren und“ Maßnahmen zur Nachfragesteuerung „, um die Nutzer zu bezahlen, wenn sie ihre elektrischen Geräte ausschalten.“

Was wird [durch unsere Regierung] getan, wenn erneuerbare Energien die Unzuverlässigkeit des Stromnetzes und Preisspitzen verursachen – ob Sie es glauben oder nicht, unsere Regierung plant weitere Wind- und Solaranlagen hinzu zufügen:

Der Stromnetzbetreiber AEMO erklärte, dass weitere Energieerzeuger und Speicherkapazitäten rechtzeitig zum Sommer an das Netz angeschlossen werden. Bis Dezember kommen bis zu 2100 MW neue Energiekapazität – hauptsächlich mit Wind- und Sonnenzellen – an das Netz.

Weitere 2 GW an erneuerbaren Energieanlagen kommen schon im nächsten Monat. Genau das, was wir brauchen!

****

Erkennen Sie das Problem??…

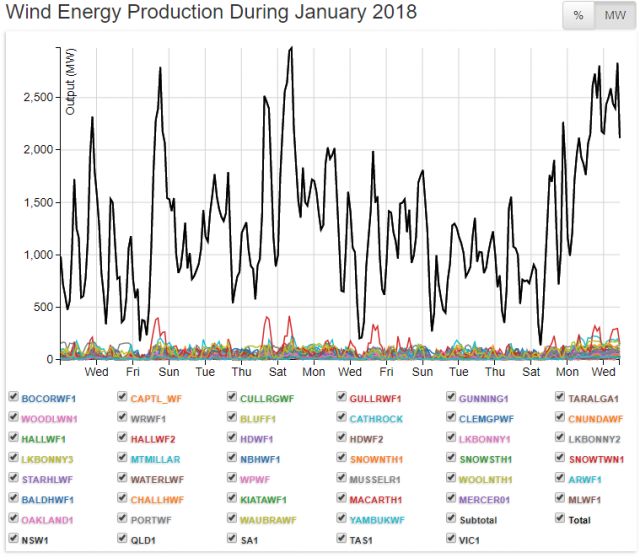

AEMO, Die bunten Kästchen, sind die obiger Grafik berücksichtigten „Wind-Industrieparks“ und deren tatsächlich verfügbare Leistungen

Beitrag gefunden auf Stopthesethings vom 27.11.2018

Zusammengestellt und übersetzt durch Andreas Demmig

***

Der AEMO-Sommerbereitschaftsplan ist da.

Es ist jedoch nicht so, dass es nur 12 Tage Sommer sind ….

AEMO Sicherheits- und Zuverlässigkeitsplanung

Neben vielen Worten, fielen mir die Maßnahmen zur Verbesserung der Energieflusssteuerung besonders auf: So ähnlich konnte man es auch in Deutschland schon lesen – Wind und Sonnenschein werden nun besser vorausgeplant !? der Übersetzer

Verbesserungen bestehender Systeme zur Bedarfsprognose: [Seite 17, § 3.1 ff]

- [alle] 5-Minuten- Prognosen, um sicherzustellen, dass die Modellschätzungen die jüngsten Änderungen der Nachfragemuster widerspiegeln und dadurch verbesserte Prognosegenauigkeit.

- Anpassung der Gewichtung von Variablen innerhalb von Bedarfsvorhersagemodellen, mit denen die Modelle auf Schwankungen im täglichen Bedarfsprofil reagieren. Dies wird die Leistung von Intraday verbessern, und den Marktteilnehmern stabilere Prognosen und ein höheres Maß an Sicherheit bieten.

- Erhöhen der Daten-Grundlage durch das Hinzufügen von 17 [weiteren] Wetterstationen in wichtigen Bevölkerungszentren. Damit sind Daten von 40 Wetterstationen verfügbar, die in den nationalem Energienetz verteilt sind. Dieser Ausbau verbessert die Korrelation von Wetterbeobachtungen und -prognosen mit dem Lastbedarf und führt zu einer verbesserten Prognoseleistung.

SAP-Marketing-Chefin: „Empathie und Führung nimmt uns keine Technik ab!“

Wie SAP seine Markenwahrnehmung im Zeitalter der Digitalisierung verändern will und warum künstliche Intelligenz keine Marketing-Abteilung ersetzen kann, erklärt Kerstin Köder, Marketing-Leiterin bei SAP, im Interview.

Seit Januar 2018 ist Kerstin Köder verantwortlich für das Marketing von SAP in Deutschland, Mittel- und Osteuropa sowie der GUS-Region. Wir sprachen mit ihr darüber, welchen Einfluss die Digitalisierung auf das Marketing des Software-Herstellers hat und wie nah B2B- und B2C-Marketing inzwischen beieinanderliegen. t3n: Frau Köder, bevor Sie Marketing-Chefin bei SAP wurden, leiteten Sie das ...

weiterlesen auf t3n.deMilder Oktober 2018 – Eine bloße Laune der Natur?

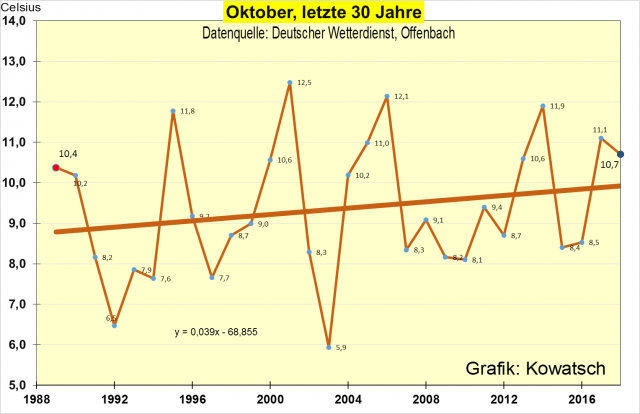

Die Trendlinie der letzten 30 Jahre sieht in Deutschland bei den über 1800 DWD-Wetterstationen dann so aus:

Die Entwicklung der Oktobertemperaturen in Deutschland

Zunächst lohnt ein Blick auf die langfristige Entwicklung der Oktobertemperaturen und deren Ursachen. Die vom Deutschen Wetterdienst (DWD) veröffentlichten Temperaturdaten reichen allerdings nur bis 1881 zurück. Es handelt sich um Durchschnittsdaten von vielen hundert Stationen über ganz Deutschland verteilt; die neuerdings in ein 1×1 Km²- Rastermittel umgerechnet werden. 1881 standen diese Stationen, welche dafür die Ausgangswerte liefern, natürlich an ganz anderen Orten und Plätzen als heute; Deutschland war zudem viel dünner besiedelt und viel weniger bebaut. Im Vergleich zu heute ein armes Land mit geringem Energie- und Wärmebedarf.

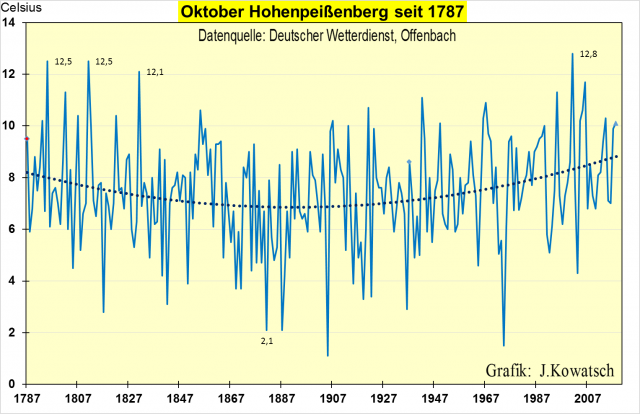

Wir können für einen noch längeren Zeitraum als bis 1881 jedoch auf Einzelstationen zurückblicken, dabei ist zu gewährleisten, dass sich deren Umgebung nicht wesentlich verändert hat, denn jede Ortsänderung oder eine umfangreiche Umgebungsbebauung würde auch die Vergleichbarkeit der Daten einschränken.

Die Station des DWD auf dem 988m hohen Hohenpeißenberg erfüllt nicht ganz die von uns aufgestellten Bedingungen. Natürlich hat sich der Berg in den letzten 200 Jahren auch verändert und die Station wurde von der Nordwand der unbeheizten Klosterkirche ab 1936 über Umwege in das heutige moderne DWD-Klimazentrum HPB mit mehreren Gebäuden verlegt. Die Messhütte ist heute ganztägig sonnenbeschienen –wenn die Sonne scheint. Zudem ist der neue Standort etwas tiefer gelegen. Hinzu kommen Wärmeinseleffekte durch Versiegelungen und Tourismus. Aber im Vergleich zu München oder vielen anderen bewohnten Orten ist das nur eine minimalere Umgebungsveränderung.

Oktobertemperaturen Hohenpeißenberg über die letzten 230 Jahre

Wir stellen fest: Das Startjahr 1881 des DWD für seine heutigen Deutschlandbetrachtungen lag inmitten eines Kältetales. (2,1 C auf dem HPB). Über die Ursachen dieser kälteren 50 Jahre in der 2. Hälfte des 19. Jahrhunderts liegen nur Vermutungen vor. Von der CO2-Treibhauskirche wird dieser Zeitraum gar nie thematisiert. Seit 1881 bis heute zeigt der Hohenpeißenberg eine stetige und deutliche Erwärmung. Mit einem früheren Betrachtungsbeginn 1787 bis heute wäre lediglich eine sehr moderate und keinesfalls beängstigende Erwärmung festzustellen, wobei 2001 der wärmste Oktober war. Und nicht vergessen: bis 1936 stand die Messstation zudem an einem kälteren Platz als heute.

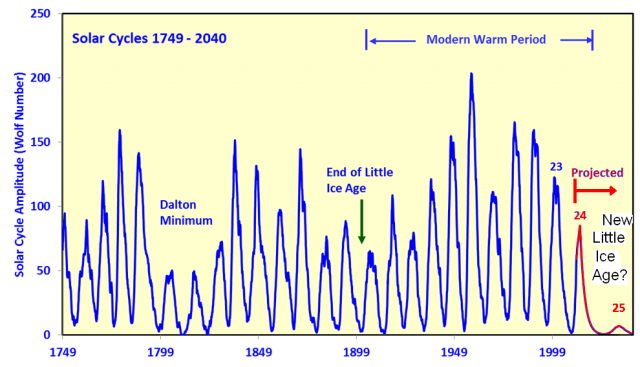

Die CO2-Erwärmungsgläubigen führen die Erwärmung seit 1881, also aus dem Kältetal heraus bis heute, ausschließlich auf die steigende CO2-Konzentration zurück. Dabei können sie auf keinerlei Versuchsbeweise zurückgreifen, denn in wissenschaftlichen Versuchsreihen kann die behauptete CO2-Erwärmung nicht bewiesen werden. Es gibt auch keinerlei technische Anwendungen für einen CO2– Erwärmungseffekt. Für neutrale Beobachter wäre die Frage interessant, welche Klimafaktoren haben die hundertjährige Abkühlung vor 1881 bewirkt? Die Erwärmungsgläubigen ignorieren diesen Zeitraum schlichtweg. Immerhin begann die Industrialisierung in Deutschland ab etwa 1830, und die Oktobermonate wurden zunächst noch kälter. Aufgrund fehlenden Datenmaterials können wir diese Frage der Abkühlung nach 1850 nicht beantworten, sondern nur aufwerfen. Vielleicht wurde diese Kaltphase durch verschieden starke Vulkanausbrüche im 19 Jahrhundert verstärkt und verlängert. Außerdem war die Sonnenaktivität zwischen etwa 1860 und 1910 geringer; als zur Mitte des 19. und im späteren 20. Jahrhundert, was an den niedrigeren Maxima der SCHWABE- Zyklen sichtbar wird. Manche Klimaforscher rechnen diesen Abschnitt noch zur „Kleinen Eiszeit“, welche erst um 1900 endgültig vorbei war:

Die Oktobermonate in Deutschland ab 1881

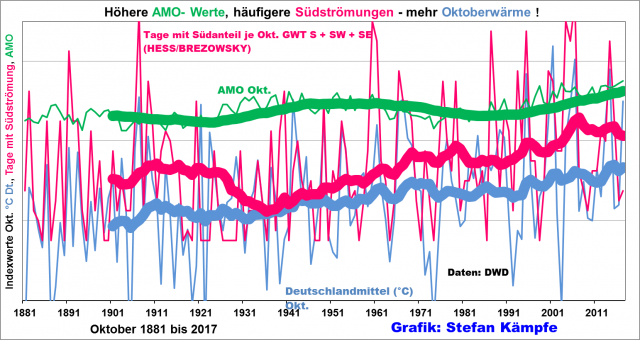

Von 1881 bis 2018 erwärmte sich der Oktober in Deutschland um fast 1,6 Kelvin (1 Kelvin = 1°C) und damit viel deutlicher, als der September. Zwei mögliche Erwärmungsursachen, eine leichte Häufigkeitszunahme der Großwetterlagen mit südlichem Strömungsanteil sowie die insgesamt gestiegenen AMO- Werte (ein Indexwert für die Wassertemperaturen im zentralen Nordatlantik), zeigt die folgende Grafik gleich mit. Eine dritte mögliche Ursache, die Verstädterung sowie die geänderte Landnutzung („Wärmeinseleffekte“ im weitesten Sinne) wurden hier bei EIKE schon oft erläutert und sollen an dieser Stelle bloß erwähnt werden. (Im 2. Teil des Artikels gehen wir näher auf den WI-Effekt ein.)

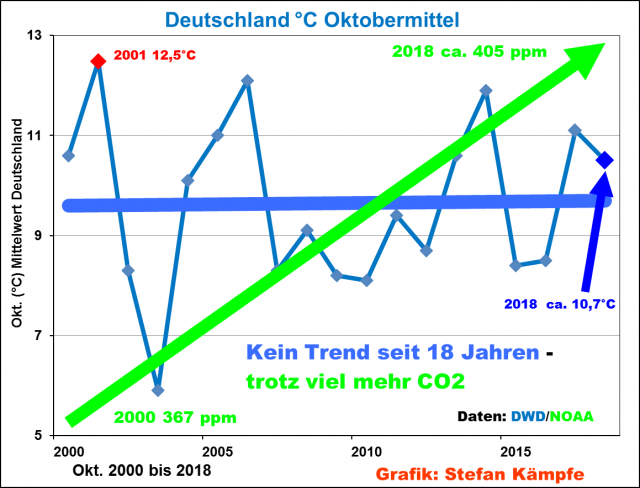

Doch seit dem Jahr 2000, in der Gegenwart stagniert die Oktober- Erwärmung in Deutschland- und das trotz stark gestiegener CO2– Konzentrationen. Damit verhält sich der Monat Oktober genauso wie die anderen Monate. Wir leben somit keineswegs in einer starken Erwärmungsphase, sondern in einer Temperatur-Stagnationsphase:

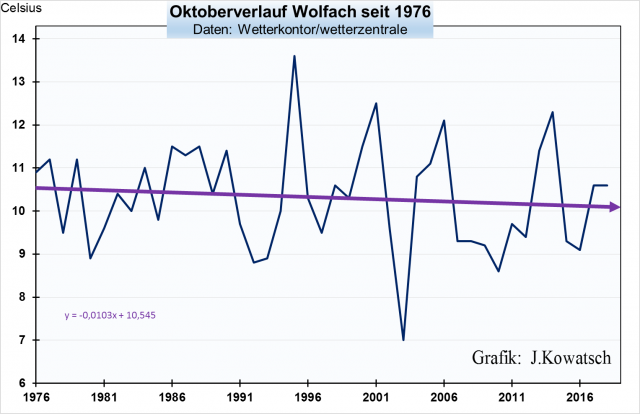

Bei den in der Umgebung fast unverändert gebliebenen ländlichen Stationen mit geringen Wärmeinseleffekten stagnieren die Oktobertemperaturen natürlich schon länger. Wir greifen hier auf Wolfach im Schwarzwald zurück. Die Station steht etwas außerhalb der Stadt. Wir könnten genauso gut die Zugspitze, den Hohenpeißenberg, Amtsberg im Erzgebirge Alfhausen in Niedersachsen, Netzstall bei Nürnberg oder Lahr in der Oberrheinebene wählen.

Die angenehme Oktobererwärmung seit 1881 ist auf dem Lande, das immerhin 85% der Fläche Deutschlands ausmacht, schon vor mehr vier Jahrzehnten zu einem Ende gekommen. Seit 20 Jahren haben wir bei vielen ländlichen Messstationen, deren Umgebungen weitgehend unverändert blieben, noch deutlicher sinkende Temperaturen. Dem Leser nur zur Erinnerung: Auf dem Lande und in der freien Natur ist die CO2-Konzentration in den letzten 40 Jahren natürlich genauso gestiegen wie in der Stadt. Gleicher CO2-Anstieg, aber stagnierende bzw. sinkende Temperaturen. Das passt nicht zusammen und zeigt einmal mehr, dass CO2 in diesen geringen Konzentrationen von 400 ppm gar keinen oder nur einen unbedeutenden Anteil am Temperaturgeschehen hat.

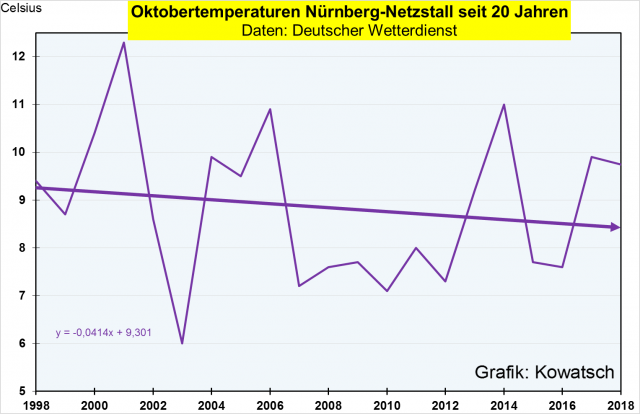

Gegenwart: In der Gegenwart kühlt der Oktober noch mehr ab. Das zeigt auch die DWD-Wetterstation Nürnberg-Netzstall. Die Wetterstation steht bei einem Aussiedlerhof umgeben von Naturflächen. Man beachte die Formel der fallenden Trendlinie. Im gleichen Zeitraum zeigt die Wetterstation in der Stadt eine geringe Erwärmung um fast 0,4 C.

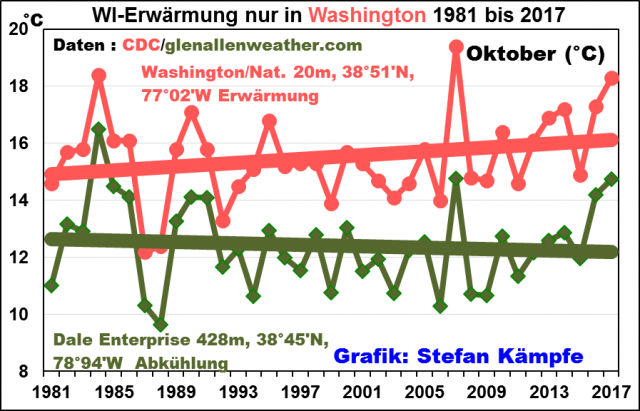

Ein besonders schönes Beispiel findet sich in den USA, wo sich die Bundeshauptstadt Washington D.C. im Oktober seit 1981 erwärmte, das ländliche, auf gleicher geografischer Breite gut 100 Km weiter westlich gelegene Dale Enterprise aber abkühlte:

Wir kommen zum Ergebnis 1:

Der Herbstmonat Oktober zeigt in Deutschland außerhalb der Wärmeinseln in freier Natur seit 40 Jahren keinen Erwärmungstrend, trotz ständig gestiegener CO2-Konzentrationen. Seit 20 Jahren zeigen Stationen in unveränderter ländlicher Umgebung sogar eine deutliche Abkühlung.

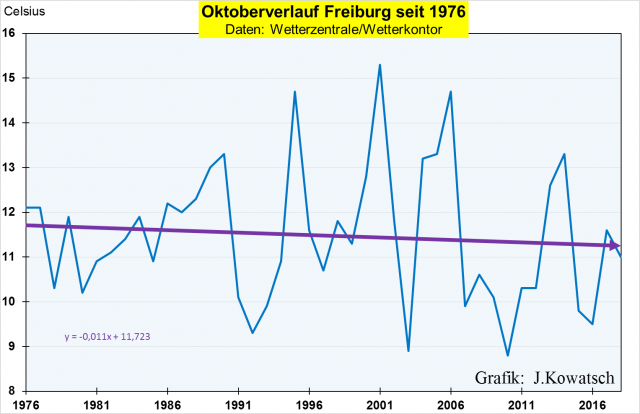

Ironischerweise könnte man verlangen, der DWD muss lediglich seine Messstationen aus den Wärmeinseln raus in die Außenbezirke stellen und schon ist die Klimaerwärmung beendet. Ein schönes Beispiel hierfür ist die südbadische Landeshauptstadt Freiburg:

Und die Reaktion der Klimaalarmisten auf unsere Grafiken? Antwort: Gar keine Reaktion, die Leute reden nur von einer ständigen Erwärmung und werden niemals von den Medien aufgefordert, eine bestätigende Grafik zu liefern. Und wenn Beispiele gebracht werden, dann sind dies stets Großstadtwetterstationen mit wachsender Bebauung und steigendem Flugverkehr: Frankfurt, Stuttgart, München, Berlin, Köln, Leipzig, usw. Schreiben unsererseits an die Medien bleiben ohne Antwort

Oktober- Trends in anderen Regionen

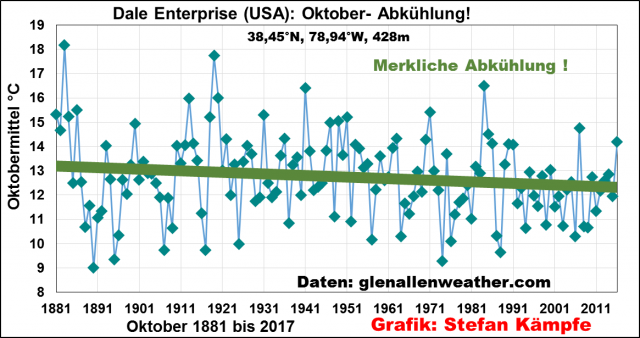

In Zentralengland (CET) erwärmte sich der Oktober sowohl kurz- als auch langfristig merklich; er unterscheidet sich damit deutlich vom Verhalten der meisten anderen Monate in England. Anders sieht die langfristige Entwicklung an der schon erwähnten Dale Enterprise- Station bei einer Farm in Virginia/USA aus; die Werte liegen ab 1881 vor:

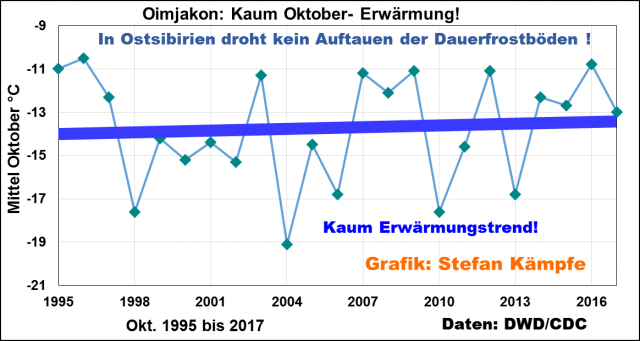

In Oimjakon (Ostsibirien) zeigt sich seit 1995 ein ähnliches Verhalten wie in Deutschland (fast Stagnation); freilich auf viel niedrigerem Niveau, denn im Indigirka-Hochtal herrscht im Oktober bereits strenger Dauerfrost:

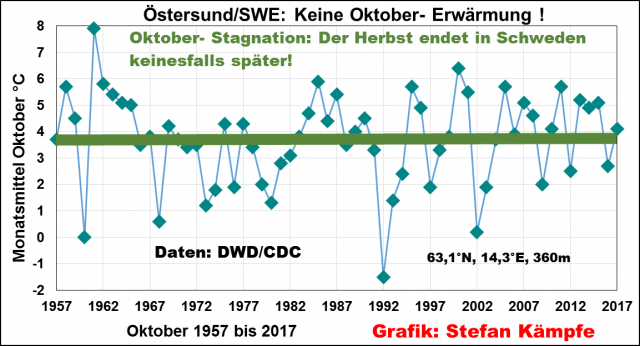

Und in Mittelschweden, wo im Oktober ähnliche Temperaturverhältnisse herrschen wie im deutschen November, stagnieren die Oktoberwerte bereits seit gut 60 Jahren:

Ergebnis 2: Trotz eines starken Anstiegs des „Treibhausgases“ CO2 zeigt der Monat Oktober in den ländlichen Gebieten dieser Welt oft seit Jahrzehnten keine Erwärmung mehr.

Es gibt viele Ursachen und Gründe, die das Klima auf der Erde bestimmen, und der Mensch ist beteiligt durch die weltweite tägliche Vergrößerung der Wärmeinseln, was letztlich eine Naturzerstörung ist. Überall wo sich Wärmeinseln ausbreiten werden die Regionen wärmer und genau das zeigen die dortigen Messstationen. Eindeutig eine Erwärmung, für die nicht CO2 verantwortlich sein kann. Will man die Klimaerwärmung bekämpfen, dann müsste man die Ausbreitung und Vermehrung der Gattung Mensch eindämmen und den Lebensstandard deutlich senken. Wollen wir das?

Verirrter Vorreiter

Die Arroganz der Ahnungslosen

Kaum ein anderer Teil der Wirtschaft wird in Deutschland politisch so reguliert wie die Energiewirtschaft. Technologiescharfe politische Entscheidungen wie der Ausstieg aus der Kernenergie und die auf das Zehntelcent genaue Festlegung von Fördersätzen sind planwirtschaftlich angelegt und verhindern Wettbewerb. Politiker maßen sich an, Energietechnologien in Unkenntnis kommender Entwicklungen für die nächsten Jahrzehnte festschreiben zu können. Eine Globaltemperatur am Ende des Jahrhunderts gilt als Beschluss, während die Inbetriebnahme eines Flughafens nur mit Vorsicht terminiert wird.

Ziele sind das Eine, ihre Erreichung das Andere. Fast alle bisher angestrebten Meilensteine des Energiewendevorhabens per 2020 werden mehr oder weniger deutlich verfehlt. Der Primärenergieverbrauch sollte um 20 Prozent zurückgehen. Dies ist außer Reichweite gelangt, denn die Konjunktur ist gut und die Bevölkerung wächst. Auch die Senkung des Bruttostromverbrauchs um 10 Prozent funktioniert nicht. Zwar ist das Wirtschaftswachstum vom Energieverbrauch weitgehend entkoppelt, die vorgesehene Steigerung der Energieproduktivität von 2,1 Prozent wird aber nicht gelingen, denn über den begonnenen Weg der „Sektorkopplung“ sollen künftig alle Energiesektoren strombasiert betrieben werden. Dies würde voraussetzen, dass Elektrizität in großen Mengen billig, sicher und umweltfreundlich verfügbar ist. Man kann alles vorhersagen – dieses bestimmt nicht. Die Sektorkopplung treibt den Bedarf der am höchsten veredelten und damit teuersten Energieform, der Elektrizität, um etwa das Dreifache in die Höhe.

Der Endenergieverbrauch im Verkehrssektor wie auch der Wärmebedarf des Gebäudebestands werden auch nicht um 10 beziehungsweise 20 Prozent sinken.

Die Emissions-Reduktionsziele (fälschlich „Klimaziele“ genannt) werden ebenfalls nicht erreicht. Zähneknirschend und vom Wolfsgeheul der Grünen und der Front der NGOs begleitet, entschloss man sich spät in den schwarz-roten Koalitionsverhandlungen, das Absehbare offiziell zu machen. Wenn man Ziele nicht erreicht, hat jemand versagt. Vielleicht waren die Ziele aber nicht realistisch oder die Bedingungen haben sich geändert?

Die 40-Prozent-Reduzierung wurde 2007 beschlossen, also lange vor dem Tsunami in Fukushima. Mit dem Atomausstiegsbeschluss 2011 war klar, dass ein Teil des wegfallenden Atomstroms durch fossilen Strom wird ersetzt werden müssen. Wer das damals laut sagte, wurde vom grünen Sozialenergiefachmann Trittin darauf hingewiesen, dass das nur „Propaganda der Atomlobby“ sei. Nun ist die Atomlobby im Grunde nicht mehr existent und der grüne „Abschalten“-Chor ruft in Richtung der Kohle weiter. Noch sind neun Gigawatt Kernkraftwerksleistung am Netz – zuverlässig und regelbar. Die Ziele für 2030 sollte man realistisch versuchen zu kalkulieren und auf „Fachleute“, die Kostensteigerungen in Maßeinheiten wie Eiskugeln vorhersagen, besser nicht hören.

Die Energiebranche hat ihre Hausaufgaben gemacht und Emissionen gesenkt, hier wirkt auch der europäische Emissionshandel, während Verkehrs- und Gebäudesektor kaum reduzierten. Das Gegenteil tritt bei der Mobilität ein. Die Verteufelung der Dieseltechnologie treibt Vielfahrer zum Benziner, keinesfalls zum Stromer, und erhöht die CO2-Emissionen. Politische Zwangsmaßnahmen gegen Autofahrer lassen sich bei uns schwerer umsetzen als in China. Die Chinesen, nicht wir, realisierten übrigens die bisher weltweit erfolgreichste „Klimaschutzmaßnahme“: Die Ein-Kind-Politik.

Dilettantischer Ausstieg

Niemand bezweifelt indes, dass der Kernenergieausstieg termingemäß kommen wird. Begleitend werden noch einige Milliarden an Steuergeld verbrannt auf Grund der rechtswidrigen Brennelementesteuer und zu entschädigender Reststrommengen. Dies wirft ein bezeichnendes Licht auf die Qualität unserer Regierungen im Gesetzgebungsverfahren. Gerichte müssen korrigieren, was hunderte Juristen in Bundestag und Regierung nicht rechtssicher auf die Reihe bekamen. Eingefangen haben sie sich indes alle Kosten für die Endlagerung, die der Steuerzahler nun schultern muss. Einige hundert Millionen oder sogar einige Milliarden werden wohl noch an Vattenfall als dem einzigen ausländischen Kernkraftbetreiber in Deutschland gehen. Das internationale Schiedsgericht ICISD, ursprünglich eingerichtet zum Investorenschutz in Drittweltländern, könnte die Stilllegungsverfügung der Vattenfall-Reaktoren in Krümmel und Brunsbüttel als Enteignung werten. Deutschland auf einer Anklagebank, auf der auch Länder wie Ecuador und die Philippinen in anderen Verfahren sitzen. Das ist keine Werbung für Investitionen in ein vorgeblich rechtssicheres Hochindustrieland Deutschland.

Der geplante Anteil regenerativ erzeugten Stroms am Strommix ist das einzige Ziel, das übererfüllt wird. Bereits heute haben wir den Wert für 2020 erreicht. Daran zeigt sich das erfolgreiche Wirken der Ökolobby, die den exzessiven Ausbau volatiler Anlagen gegenüber abgewogenen Entscheidungen zum Netzausbau durchgesetzt hat. Ein fehlender Masterplan und die unterlassene, zwingend nötige Kopplung an den Netzausbau und den Einstieg in Speichertechnologien haben die Entwicklung aus dem Ruder laufen lassen. Das wichtigere Ziel hingegen, den Anteil am Primärenergieverbrauch zu 18 Prozent aus den Regenerativen zu gewinnen, wird um mindestens drei Prozent verfehlt werden.

Halbjährlich untersucht McKinsey den Fortgang der deutschen Energiewende und bildet sie durch einen Index ab. Die Platzierungen im weltweiten Vergleich sind ernüchternd. Im Gesamtranking landet Deutschland auf Platz 16 unter 114 betrachteten Ländern. Die Kennziffer „Systemperformance“, die die Einhaltung des energiepolitischen Zieldreiecks aus Wirtschaftlichkeit, Versorgungssicherheit und Umweltschutz abbildet, führt uns auf Rang 44, hinter Länder wie Paraguay und Indonesien. Nennt man einen aus dem Mittelfeld tatsächlich „Vorreiter“?

Noch nie ist eine Energiestrategie irgendeiner Bundesregierung zielgerecht umgesetzt worden. Ob die jetzige erfolgreich sein wird, ist bei Betrachtung des handelnden Personals eher zweifelhaft.

Oberster Wirtschaftsbeamter ist mit Peter Altmaier ein Jurist, der schon optisch das Primat der Politik über den Markt verkörpert. Er diente der Kanzlerin als Allzweckwaffe, unter anderem als parlamentarischer Staatssekretär, Kanzleramtsminister, Flüchtlingskoordinator und Talkshow-Gast. „Er kann reden, ohne etwas zu sagen“, so der FOCUS. Jetzt soll er als Wirtschafts- und Energieminister die Kastanien aus dem verdammt heißen Feuer verbrennender Energiewende-Illusionen holen. Mildernd ist anzumerken, dass er kein gut bestelltes Feld übernahm. Vorgänger Gabriel ließ seinem grünen Staatssekretär Baake weitgehend freie Hand, so dass dieser die Bedingungen der Ökostromproduzenten ohne Rücksicht auf übergreifende Zusammenhänge profitoptimal gestalten konnte. Angesichts des neuen Koalitionsvertrages sah der seine Möglichkeiten eingeschränkt und stieg im März aus. Bisher gibt es keinen Nachfolger. Kaum zu vermuten, dass Altmaier nicht um die Bedeutung dieses Postens weiß, eher dürften die durchaus vorhandenen Kandidaten diesen heißen Stuhl meiden. Viel Feind und wenig Ehr` bei Gefahr des vollständigen Reputationsverlusts.

Altmaier setzt nun den Verlust einiger tausend Arbeitsplätze in Bergbau, Energie und Industrie über Zwangsstilllegungen von Kraftwerken und steigende Strompreise um. Wir sehen, Politik kann sehr wohl Arbeitsplätze vernichten, aber nur sehr begrenzt neue, marktfähige schaffen. Öffentlich äußert er, „Arbeitsplätze zu den Menschen“ bringen zu wollen. Wir sind gespannt.

Auf dem Gebiet der „Zukunftsenergien“ wird dies eher schwierig. Fest ist der Glaube daran, aber falsch die gebetsmühlenartige Wiederholung, bei den „Erneuerbaren“ würden stetig neue Arbeitsplätze entstehen. Der Faktencheck enthüllt, dass das Maximum der dort Beschäftigten im Jahr 2012 mit etwa 400.000 teils prekären Stellen sein Maximum erreicht hatte und es seit Platzen der Solarblase stetig abwärts geht. Derzeit sind es etwa 330.000, wobei die Abgrenzung schwierig ist. Werden in der konventionellen Energiewirtschaft nur die direkt Beschäftigten gezählt und Zulieferer und Service unter indirekte Beschäftigung fallen, zählt bei den Regenerativen auch der Dachdecker und Elektriker dazu, der hin und wieder Hand an ein Solarpanel legt. Nun zeichnet sich weiterer Jobabbau in der Windbranche ab. Die Erkenntnis, dass subventionierte Stellen immer temporär sind, ist in der Wirtschaft und besonders in der deutschen Steinkohle schon lange bekannt, bei den „Erneuerbaren“ noch nicht.

Ohne Moos nix los

113 Milliarden Euro flossen zwischen 1960 und 2016, also innerhalb von 56 Jahren, in die deutsche Steinkohle als Subvention. In nur 16 Jahren (2000 – 2016) gingen 149 Milliarden Euro an die Betreiber der „Erneuerbaren“, die indirekten Kosten nicht mitgerechnet. Perspektive: Unabsehbar. Der Bundesrechnungshof kritisierte schon im Vorjahr, dass Finanzfragen vom BMWi nicht beantwortet werden können. Abgesehen von Organisationsmängeln im Ministerium ist es allerdings in der Tat schwierig, alle direkten und indirekten Kosten zu erfassen. Welcher Netzausbau ist zusätzlich nötig zu dem, der ohnehin erforderlich gewesen wäre? Was kosten künftig die heute noch völlig imaginären Stromspeicher?

Immerhin erkennt Altmaier, dass der weitere Ausbau der Regenerativen ohne adäquaten Netzausbau kontraproduktiv ist. „Wir sind beim Netzausbau katastrophal in Verzug.“ Über 1,4 Milliarden Euro wurden 2017 verschwendet, um das Ungleichgewicht im Netz durch den vorauseilenden Ausbau volatiler Einspeiser gegenüber nachhängendem Netzausbau auszugleichen.

Um auch öffentlich deutlich zu machen, wie wichtig ihm dieses Problem ist, begab er sich im August auf eine „Netzreise“, auf der er den „Aktionsplan Stromnetz“ vorstellte. Wirklich Neues steht darin nicht und inwieweit sich die Genehmigungsverfahren in unserem Hochbürokratieland vereinfachen lassen, ist offen. Wenn betroffene Bürger erst erkannt haben werden, dass Erdkabel wieder unbewachsene Todesstreifen quer durch Deutschland mit sich bringen, wird der Unmut erneut wachsen. Ohnehin ist die Landbevölkerung in Zwietracht. Im Norden verdienen Landbesitzer an den Pachteinnahmen für Windkraftanlagen mehr, als sie je mit Feldbestellung hätten erreichen können. Weiter südlich müssen die Bauern Slalom fahren um die Masten der Hochspannungstrassen oder Mindererträge durch Erdkabel für diese spitzenvergüteten Strom hinnehmen.

Dann wird wieder von den Benachteiligten die Wunderwaffe „Dezentralisierung“ ins Spiel gebracht.

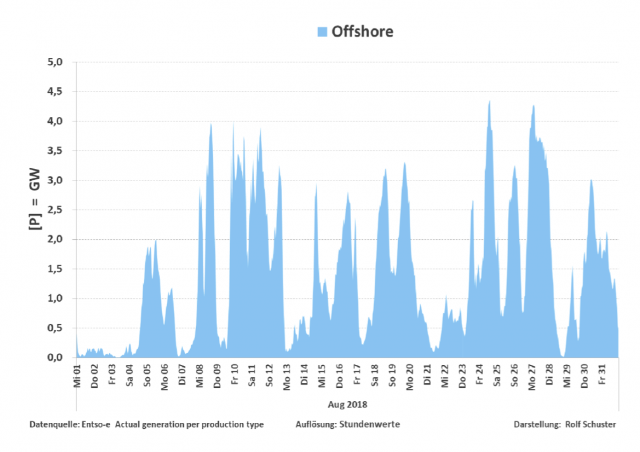

Typisch für die deutsche Energiepolitik ist es, die teuersten und marktfernsten Technologien am meisten zu fördern. Jahrelang war die Fotovoltaik das Lieblingskind (heute gibt man die Überförderung zu) und man nahm üppige CO2-Vermeidungskosten von 400 und mehr Euro pro Tonne hin. Heute ist es die Offshore-Windenergie, mit der Altmaier auf weitere Zentralisierung setzt. Er bezeichnet Offshore-Windkraftanlagen als „Kathedralen der Energiewende“ und vergisst dabei, dass dies die maximal zentralisierte Stromerzeugung darstellt. Nirgendwo sonst ist der Weg zum Stromverbraucher weiter als von See her. Gebündelter Windstrom kommt in dicken Kabeln hinter den Dünen hoch und muss über das ganze Land verteilt werden. Dazu kommt: Auch dieser Windstrom schwankt stark.

Bild 1

Diese Erkenntnis ist selbst Herrn Homann fremd, dem Chef der Bundesnetzagentur. Er formulierte anlässlich des nötigen Netzausbaus: „Der Strom aus den Windparks kommt nicht zuverlässig nach Süddeutschland.“ Die Begriffe „Windstrom“ und „zuverlässig“ in einem Satz zu verarbeiten, zeigt systemisches Unverständnis. Natürlich müssen die Leitungen Strom zuverlässig Strom transportieren, die wichtigste Frage ist doch aber: Wer sorgt dafür, dass der Strom zuverlässig in die Leitungen kommt? Wie ein Pawlowscher Reflex kommt auf entsprechende Fragen von den Wendebewegten die Antwort: Speicher.

Es gehört schon ein gediegenes Maß Arroganz dazu, stets die Notwendigkeit von Speichern zu betonen und gleichzeitig nichts zu unternehmen, die regulatorischen Bedingungen für Stromspeicher günstig zu gestalten. Noch immer zahlen Pumpspeicherwerke Netzgebühren, obwohl sie stabilisierend wirken. Die Politik fördert leicht gebremst die massenhafte volatile Einspeisung weiter und produziert damit steigende Systemkosten. Die Subventionierung von Massenproduktion verhindert zudem Innovation, wie schon die von der Bundesregierung eingesetzte Expertenkommission „Forschung und Innovation“ 2014 feststellte.

Es gibt nur ein Ereignis, dass die deutschen Emissionssenkungsziele nach heutiger Methode erreichbar machen könnte, nämlich eine fulminante, länger anhaltende Wirtschaftskrise. Eine „Versöhnung von Ökonomie und Ökologie“ ist auf dem eingeschlagenen deutschnationalen Weg nicht erreichbar.

Eine schon religiös zu nennende „Klimaschutzaufgabe“ macht den bisher hoch bewerteten Umweltschutz platt. Die Grünen, keine Friedenspartei mehr und noch nie eine soziale Partei gewesen, haben nun auch mit dem Klimaschutz ihren Gründungsmythos Umweltschutz verraten. Windkraftanlagen in Wäldern sind maximierter Umweltfrevel. Keine Tonne CO2 wird infolge des „Wasserbetteffekts“ über den europäischen Emissionshandel damit eingespart, im Gegenteil. Wald als CO2-Senke wird vernichtet. Während überall in Deutschland für die Windkraft losgeholzt wird, kämpfen scheinheilige Ökos gegen die lange geplante und genehmigte Rodung des Hambacher Forstes mit Gewalt und Gewaltsolidarität. Die Grünen sind die gewissenlose Speerspitze der hinter ihnen stehenden Lobby.

Bild 2

Viele Länder dieser Welt versuchen, ihren Energiemix zu verbreitern. Das schafft mehr Versorgungssicherheit und mindert die ökologischen Auswirkungen. Nur Deutschland will Menschen und Wirtschaft in ein mittelalterlich zu nennendes System, das von den Launen der Natur dominiert wird, zurück befördern. Der Optimismus ist so groß und der Wohlstand so üppig, dass Versorger wie die Technischen Werke Ludwigshafen jetzt veganen Strom anbieten. Der enthält nicht nur keinen Atom- und Kohlestrom, sondern auch keine Windkraft, keinen Wasser- oder Biomassestrom. Wer das „Vegawatt“-Angebot annimmt, erhält Strom fast ausschließlich aus Fotovoltaik mit der Einschränkung, dass die Module nicht auf den Dächern von Mastanlagen installiert sein dürfen. Auch auf dem Freiland dürfen sie wegen dem Flächenverbrauch und der Einschränkung des Lebensraums für Tiere nicht stehen. Als Versorger will man halt auch Kunden mit teils sektiererischer Veganerkultur an sich binden. Ob dieser Tarif Ausdruck eines besonders hohen Niveaus der Energieversorgung ist oder spätbürgerlicher Dekadenz, ist Ansichtssache.

Wir Deutschen sind die Besserwessis dieser Welt. Wir isolieren uns durch moralische Überhöhung gegenüber jenen, die zunächst ihre Grundbedürfnisse erfüllen wollen – 24 Stunden Strom am Tag und genug Wärme zum Kochen und Wohnen. Wir wollen Weltmeister der CO2-Vermeidung sein und Entwicklungsländern verbieten, billige Kohle zu nutzen. Wir wollen durch Haltung und Vorbild die Welt überzeugen von einem energiepolitischen Weg, der schon im eigenen Land nicht erfolgreich ist.

Indessen haben wir uns von dem verabschiedet, was den einst guten Ruf deutscher Technik und Ingenieurskunst begründete – dem Technologieexport. Fotovoltaik- und Windkraftanlagen kommen heute gleichwertig, aber billiger aus China, Kernkraft ebenso, die können wir nicht mehr. Für die Ertüchtigung alter Kohlekraftwerke in der dritten Welt gibt es keine KfW-Kredite und Hermes-Bürgschaften mehr. Sollen sie doch räuchern, das belastet unsere national betrachtete „Klimabilanz“ nicht. Bergbautechnik, gern von uns gekauft für Schächte und Tagebaue, werden wir künftig nicht mehr liefern können mangels eigener Verwendung. Auch die Technologie zur Abscheidung und Speicherung von CO2(CCS), die wir kurzzeitig vorantrieben, ist politisch abgewürgt. Nun erklärt das IPCC, dass die Klimaziele 2050 ohne diese Technologie, die negative Emissionen ermöglicht, nicht werden erreichen können.

Wenn wir also global außer einer selbst zugesprochenen Vorreiterrolle nichts zur Emissionsminderung beitragen können oder wollen, bleibt als einziges Trostpflaster, die eigenen Emissionen zu senken. Gelänge es, unseren zweiprozentigen globalen Anteil komplett wegzusparen (der übrigens im Bereich der chinesischen Meßungenauigkeit liegt), kann eine Reaktion der Atmosphäre in Form eines nicht mehr stattfindenden Klimawandels nur von Naivgläubigen erwartet werden. In spätestens zwei Jahren hätte der globale Emissionsanstieg unsere Senkung ausgeglichen. Wir würden trotz grünökologisch korrekter Dekarbonisierung weiter vom Klimawandel „bedroht“.

In der DDR gingen mit schöner Regelmäßigkeit erfüllte Planzahlen durch die Einheitsmedien: Tonnen an Roheisen, Walzstahl, beförderten Gütern oder gefangenem Fisch. Der Wohlstand war dennoch bescheiden und man nannte diese Form der Politik auch Ergebnis der „Tonnenideologie“. Fragt man heute nach dem Ziel der Energiewendebemühungen, werden Millionen Tonnen CO2-Einsparung genannt. CO2-Fußabdrücke werden errechnet für den Flug in den Urlaub oder die Autofahrt zum Bäcker, wo man doch das Fahrrad hätte nehmen können. Die CO2-Minderung ist zum Selbstzweck hochstilisiert und verkommen. Keiner der sich im Vollbesitz der Wahrheit wähnenden Klimawissenschaftler rechnet die Millionen Tonnen vermiedener Emissionen in vermiedene Temperaturerhöhung um.

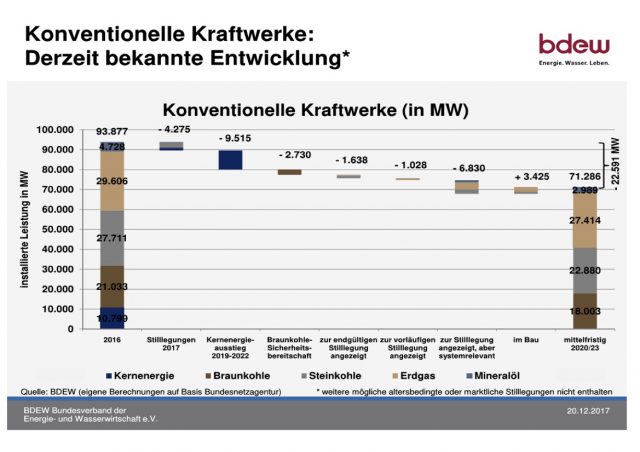

Inzwischen wirken die Gesetze und Planungen zur Stilllegung konventioneller Kraftwerke:

Bild 3

Dies ist der verbindliche Rückgang der gesicherten Kapazitäten bis 2023. Spätestens dann wird es eng, die Spitzenlast im Land aus eigenen Kraftwerken abzudecken. Im Gegensatz zu dieser genauen Terminierung gibt es keinerlei konkreten Ansatz, wann und wo welcher Strom-Großspeicher mit welcher Technologie, von wem gebaut, betrieben und bezahlt in Betrieb geht.

Auch in unseren Nachbarländern gehen die gesicherten Kapazitäten zurück. Zusätzlich steigen ab 2021 etwa 3.500 Windkraftanlagen aus der EEG-Förderung aus und es kann damit gerechnet werden, dass ein Teil von ihnen mangels Rentabilität stillgelegt werden wird. Hinzu kommt eine besondere Netzsituation südlich der Main-Linie durch den Kernenergieausstieg und fehlende Leitungen.

Die Regierung ist ein Zauberlehrling, der die Eigendynamik des selbstverursachten Strom-Voodoo staunend beobachtet. Wer „Aussteigen“ ruft, muss auch sagen, wo er einsteigt. Stattdessen wird weiter der sinnlose Versuch unternommen, Kohle- und Kernkraft durch Manchmal-ist-Windstrom zu ersetzen. Regierungspolitik will mit EEG, Energiewirtschaftsgesetz und anderen das Induktionsgesetz, das Ohmsche Gesetz und das Kirchhoffsche Gesetz überlisten. Dass auf lange Sicht die Naturgesetze die menschengemachten Gesetze schlagen, diese Erkenntnis muss offenbar noch reifen.

Niemand überblickt mehr dieses Projekt „Energiewende“, das nicht mehr als eine angefangene Stromwende ist, in Gänze. Jede Lobbygruppe bearbeitet ihren Sektor ohne Rücksicht auf die fundamentalen Zusammenhänge. Politik reagiert, indem sie am Monstergesetz EEG mal hier und da eine Schraube dreht und es immer weiter verschlimmbessert. Professor Kobe von der TU Dresden brachte es so auf den Punkt:

„Die Energiewende hat nur einen einzigen Feind: Die Unwissenheit über die physikalischen Gesetze, die ihr zugrunde liegen.“

Arroganz, gepaart mit Ahnungslosigkeit, führen uns immer weiter in eine Sackgasse hinein. Über die so genannte „Sicherheitsbereitschaft“ geht zum Oktober ein Braunkohleblock in der Lausitz außer Betrieb. Dies bedeutet den Verlust von etwa 1.500 tariflich bezahlten direkten und indirekten Arbeitsplätzen. Die damit einhergehende Emissionsreduzierung ist global vernachlässigbar und nur durch grüne Homöopathen psychosomatisch festzustellen. Die vom Arbeitsplatzverlust Betroffenen werden sozial flankiert, aber sie wissen, dass ihr Job für Symbolpolitik und Zeichensetzung geopfert wird. Dafür, dass die deutsche Delegation beim Klimagipfel in Katowice ein paar Zahlen ins Schaufenster stellen kann. Arroganz am Rand zur Menschenverachtung und Ahnungslosigkeit über grundsätzliche naturgesetzliche Zusammenhänge zeigen eine Regierung, die ihre Aufgaben nicht erfüllt.

Wie Al Gore den Globale-Erwärmung-Betrug inszenierte

Al Gores überzogene Rhetorik ist natürlich völlig unsinnig. Aber seine übertriebenen Behauptungen werfen doch eine Frage auf: Wie hat das alles eigentlich angefangen?

Im Laufe der siebziger Jahre des vorigen Jahrhunderts tauchten in Medienbeiträgen immer regelmäßiger Berichte über unmittelbar bevorstehende Probleme durch Klimawandel auf. TIME und Newsweek brachten vielfach Titelgeschichten des Inhalts, dass Ölunternehmen und der kapitalistische Lebensstil in den USA dem Klima der Erde katastrophale Schäden zufügen. Es wurde behauptet, dass Wissenschaftler fast einhellig der Meinung sind, dass ein vom Menschen verursachter Klimawandel die landwirtschaftliche Produktivität im restlichen Jahrhundert deutlich reduzieren würde.

In der Ausgabe von Newsweek vom 28. April 1975 wurden Lösungen vorgeschlagen, die sogar schon die internen Verbrennungsmotoren verbieten sollten. Das klingt schon der heutigen Klimawandel-Debatte sehr ähnlich – nur ging es während der siebziger Jahre um eine vom Menschen verursachte Abkühlung, nicht Erwärmung.

Auf der Titelseite des TIME-Magazins vom 31. Januar 1977 fand sich die Story mit dem Titel [übersetzt] „Wie man die kommende Eiszeit überleben kann“. Darin fanden sich dann auch „Fakten“ wie etwa die Prophezeiung von Wissenschaftlern, dass die so genannte Mitteltemperatur der Erde um etwa 10°C sinken könnte infolge der menschengemachten globalen Abkühlung. Dr. Murray Mitchell von der NOAA warnte die Leser, dass „der Temperaturrückgang zwischen 1945 und 1968 bereits zu einem Sechstel auf den Weg zur nächsten Eiszeit gebracht habe“.

Globale Abkühlung erregte beträchtliche Aufmerksamkeit in der allgemeinen Öffentlichkeit. Aber dann begann sich der Planet, wieder zu erwärmen anstatt sich abzukühlen, wie es so lange von den Befürwortern eines menschengemachten Klimawandels prophezeit worden war. Es musste dringend etwas getan werden, um die Klimawandel-Agenda vor einer totalen Katastrophe zu bewahren. Da trat Al Gore auf den Plan.

Al Gore Senior, ein mächtiger Senator aus Tennessee, sorgte dafür, dass sein Sohn in das Repräsentantenhaus gewählt wurde, dem er von 1977 bis 1985 angehörte. Danach wechselte er zum Senat bis zum Jahr 1993. Das primäre Thema von Gore Jr. war seine Überzeugung, dass die Erde untergehen werde, falls wir nicht fossile Treibstoffe eliminieren.

Gore stieg zum Vizepräsidenten unter Präsident Bill Clinton auf, wo er in der Lage war, eine Politik und direkte Finanzierungen in Kraft zu setzen um sicherzustellen, dass die Klimawandel-Agenda oberste Priorität in der US-Regierung erhielt. Gores Mission erhielt einen gewaltigen Schub, als Clinton ihm die Leitung des neu geschaffenen Präsidenten-Beratergremiums zu nachhaltiger Entwicklung übertrug [Council on Sustainable Development].