Um in Kontakt mit unserer Angst zu kommen, müssen wir uns ihr stellen. Ist sie fiktiv? Ist sie real? Wie wirkt Angst auf mich? Der Artikel stammt von Ruth Scheftschik, Therapeutin für Logotherapie und Existenzanalyse. © Ruth Scheftschik

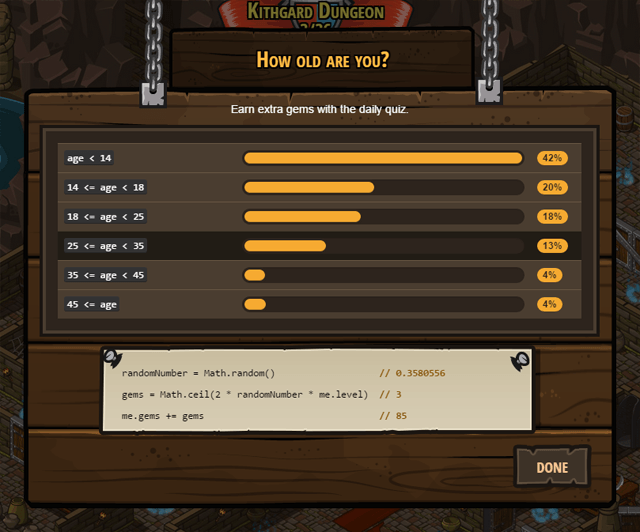

Wer will nicht glücklich sein? – Ein großes Hindernis bei der Suche nach unserem Lebensglück ist die Angst, die uns immer wieder in die Enge treibt und die uns daran hindert, unser Leben kraftvoll zu entfalten. Verfolgt man statistische Untersuchungen, kann man erkennen, dass sehr viele Ängste unter der Oberfläche des Alltags verborgen liegen und von dort ihre Wirkung entfalten.

Gerade unsere komplexe Zivilisation hat eine ganze Reihe von neuen Ängsten hervorgebracht, die es in früheren Jahrhunderten nicht gab: insbesondere Existenz- und Versagensängste wie Angst vor dem Verlust des Arbeitsplatzes; Angst, den allgemeinen Lebensstandard nicht halten oder den beruflichen Anforderungen nicht mehr Folge leisten zu können; aber auch Angst einem körperlichen Schönheitsoder einem sozialem Leistungsideal nicht zu entsprechen.

Ein großes Thema unserer heutigen Zeit ist Angst vor Beziehungsverlust in partnerschaftlichen Verbindungen, da in diesem Bereich heute eine wesentlich größere Flexibilität besteht als zu anderen Zeiten. In größerem Rahmen findet sich Angst vor allgemeinen wirtschaftlichen Krisen, Angst vor Krankheiten insbesondere Krebs, Aids, Vogel- und Schweinegrippe; Angst vor Terrorismus, vor Atomkraft, usw. Ängste werden aber auch geschürt durch die Medien mit dem zentralen Fokus auf Negativmeldungen oder durch den Hinweis auf neueste Forschungsergebnisse, die alte, bisher als abgesichert angepriesene Erkenntnisse ablösen.

Werbung und wissenschaftliche „Neumeldungen“ enthalten in ihrer betonten Dringlichkeit häufig auch ganz subtil einen Unterton von Bedrohung, oft mit dem Ziel, dass weitere Medikamente, weitere Versicherungen, vermeintlich noch bessere und sichere Produkte verkauft werden können. Genau betrachtet ist unsere gesamte Gesellschaft einschließlich der politischen Führung besessen von dem Streben nach Sicherheit. Dahinter steckt die massive Angst vor dem Verlust des einmal errungenen Wohlstandes und damit auch Angst vor Wandel und vor dem Sich-Einlassen auf neue Möglichkeiten, die insgesamt dem System gut täten, und Ungleichgewichte, Ungerechtigkeiten und Missstände beseitigen würden.

Angst vor Wandel beinhaltet auch Angst vor Risiko. Lieber bewahrt man das Alte. Da weiß man, was man hat, auch wenn es nicht angenehm ist. Diese Einstellung betrifft die Gesellschaft im Ganzen als auch viele der einzelnen Teilnehmer in ihrem persönlichen Leben. Das Sicherheitsstreben erzeugt auf politischer Ebene immer neue Gesetze, die das Leben zunehmend in die Starre führen und neue Ängste schüren. Denn stehen die Gesetze erst einmal, folgt Angst vor deren Übertretung und somit werden Selbstbestimmung und Kreativität der einzelnen Mitglieder der Gesellschaft immer mehr gelähmt.

Auch das Gefühl für Eigenverantwortung und für eigene Möglichkeiten schwindet. Der Bürger fühlt sich durch die überzogene Gesetzgebung immer mehr kontrolliert, immer weniger frei und äußerlich immer mehr in die Enge getrieben. Die äußerliche Enge führt mit der Zeit auch zu einem Gefühl von innerer Enge, welches den idealen Nährboden für Angst darstellt. Zu viele Gesetze machen den Menschen unmündig, sodass er den Bezug zu seiner eigenen Stärke verliert. Das Gefühl für die eigene Stärke, aber, ist eines der wirksamsten Mittel gegen die Angst.

Die ‚modernen‘ Ängste stehen nicht immer unmittelbar greifbar im Vordergrund. Ab und zu treten sie deutlicher zum Vorschein bei akuten Anlässen, wie z. B. bei örtlich begrenztem Ausbruch von Tier-

Epidemien, Börsenschwankungen, Ereignissen wie in Fukushima, usw. Schaut man also genauer hin, kann erkannt werden, wie sehr unser Leben von Angst diktiert ist. Daneben gibt es eine unendliche Anzahl individueller Ängste. Sehr viele Entscheidungen, mehr als wir letztendlich ahnen und wahrhaben wollen, werden von uns aus tief liegender, unbewusster Angst heraus getroffen.

Sofern wir sie doch wahrnehmen, ist es in der Regel ein Tabu, über sie zu reden. In der Gesellschaft ist ein idealisiertes Bild vom Menschen im Umlauf, das ihn als starkes, souveränes Individuum hochstilisiert, welches sein Leben unter Kontrolle zu haben scheint. Ein solcher Mensch hat einfach keine Ängste zu haben. Das schickt sich nicht. Und wenn er sie trotzdem hat, ist es verpönt, sie zu zeigen, denn Angst geht tatsächlich zunächst einmal einher mit einem Gefühl von Hilflosigkeit, von eingeschränkter Handlungsfähigkeit.

Das bedeutet Schwäche und Verlust von Souveränität. Doch dazu muss gesagt werden, dass das Leben nun einmal unausweichlich seine zwei Seiten hat: Hell und Dunkel, Warm und Kalt, Stärke und Schwäche, usw. Wenn wir nur das Helle und das Starke akzeptieren, lehnen wir die andere Hälfte des Lebens ab und verneinen es somit in seiner Gesamtheit. Das führt dazu, dass es sich uns gegenüber verschließt. Das will heißen: setzen wir uns nicht auch mit dem Schwierigen und Unangenehmen auseinander, entstehen Blockaden.

Denn, wenn diese Aspekte des Lebens verdrängt werden, lösen sie sich nicht einfach auf und verschwinden, sondern sie wandern in den Untergrund, ins Unbewusste, von wo aus sie mit unverminderter Stärke ihre Wirkung entfalten. Sie beeinflussen unser Denken, Fühlen und Handeln und erzeugen dadurch nicht selten Probleme in unserem Umfeld oder in uns selbst, wie z. B negative Gedanken, Gefühle der Unruhe, inneren Druck.

Wenn wir den Verdrängungszustand dauerhaft ignorieren, kann sich die ihm innewohnende Kraft mit der Zeit intensivieren, ohne dass wir die eigentlichen Zusammenhänge noch erkennen können, mit deren Symptomen wir dann zu kämpfen haben. Ein sehr einfaches Beispiel ist „heruntergeschluckter“ Ärger. Er rumort im Untergrund und explodiert dann irgendwann unangemessen in einer Situation, in die er überhaupt nicht hinein gehört.

So steht es auch mit verdrängter Angst. Durch die Verdrängung ist sie nicht verschwunden. Im Gegenteil: sie wird im Unbewussten zum Nährboden für weitere Angst. Das Ausmaß kann so groß werden, dass die Angst unvorhergesehen zu vollkommen ungünstigen Zeitpunkten an die Oberfläche drängt, z.B. in Form von nicht verstehbaren Panikattacken oder von einem unterschwelligen dauerhaften Angstempfinden, das das gesamte Leben lähmt.

Wenn sich zu viel Angst anhäuft, haben wir irgendwann auch Angst vor der Angst. Je mehr wir versuchen Der Angst auszuweichen, desto mehr führt sie uns in innere und äußere Blockaden und macht sich bemerkbar, indem sie sich andere Kanäle sucht, durch die sie sich äußert, z.B. als Aggressivität, körperliche Erschöpfung, depressive Verstimmung, Schlafstörungen, psychosomatische Erkrankungen oder als Süchte in vielerlei Formen.

Unbewusste Konflikte und ebenso auch Ängste können nur aufgelöst werden, wenn wir sie hervorholen, sie uns anschauen. Nachdem wir uns ihnen zugewandt und sie soweit als möglich verstanden haben, können wir sie bewusst loslassen. Deshalb ist es so wichtig, nicht vor der Angst davonzulaufen. Sich diesem Prozess zu stellen ist nicht einfach, insbesondere, wenn es sich um massive Ängste handelt.

Wen die Angst erst einmal völlig in ihrem Würgegriff hat, den lässt sie so schnell nicht mehr los. Hier ist es unumgänglich, sich professionelle Hilfe zu holen. Wir sollten uns davor nicht scheuen, sondern uns bewusst machen, dass wir große Befreiung und einen ungemein hohen Gewinn für ein erfüllendes Leben daraus ziehen können, wenn wir uns auf den Weg machen, uns von der Angst zu befreien.

In der therapeutisch-beratenden Arbeit lässt sich immer wieder feststellen: Wer sich wirklich von Angst befreien will, der schafft es auch. Aber leider kommt auch immer wieder das vor: dass Menschen zwar einerseits die Angst nicht mehr wollen, aber andererseits die Mühe und Geduld scheuen, die damit verbunden ist, sich mit ihr auseinander zu setzen. Sie halten lieber aus Bequemlichkeit an der Angst fest oder weil sie sich schlichtweg an sie gewöhnt haben. So paradox das klingt: In diesen Fällen gibt die Angst diesen Menschen eine – wenn auch vermeintliche – Sicherheit. Es ist teilweise auch die Symptomatik der Angst selbst, die zu dieser grotesken Einstellung führt. Es gibt eine Angst davor, die Angst aufzugeben.

Somit ist es weder für den Therapeuten noch für den Betroffenen eine ohne weiteres einfache und bequeme Arbeit, massive Ängste aufzulösen. Wer jedoch die feste Entscheidung trifft: „Ich will da durch“, der wird die Erfahrung machen, dass hinter der Angst noch etwas Stärkeres liegt: da sind Mut zum Sein und Freude am Leben zu finden. Und so kann es gelingen, die Ängste zu überwinden.

Es hilft also nicht, Angst zu verdrängen, damit wir sie nicht spüren. Es führt nicht weiter, ihr auszuweichen, sie zu leugnen, sie zu betäuben oder sie auf die Dauer mit Medikamenten wegzudrücken. Mut, Vertrauen, Hoffnung und Glauben sind Eigenschaften, auf die wir uns ausrichten können, um Angst zu überwinden. Um diese Gegenkräfte in ausreichendem Maß hervorrufen zu können, ist es sinnvoll und gewinnbringend, sich erst einmal prinzipiell mit dem Wesen der Angst vertraut zu machen und ihre Struktur und Wirkungsmechanismen zu begreifen.

Darum soll es in diesem Beitrag gehen. Viele Bücher sind bereits über Angst geschrieben worden. Hier soll in kompakter Weise das Wichtigste dargestellt werden.

Grundsätzliche Aspekte der Angst

Wenn wir die Funktionsweise der Angst zu analysieren beginnen, müssen wir erstaunt feststellen: so eindeutig sie für uns spürbar ist, so vielschichtig ist sie, wenn wir sie verstehen wollen. Zunächst können wir auf alle Fälle einige grundsätzliche Eigenschaften entdecken:

Angst lässt sich nicht gänzlich vermeiden

Angst ist erfahrungsgemäß ein ständiger Begleiter unseres Lebens, ein immer wiederkehrendes, zentrales Erlebnis der Menschheit. Sie ist ein Grundphänomen des Lebens, ebenso wie es die Liebe ist in allen ihren Ausformungen. Liebe will das Leben erhalten und fördern; Angst jedoch stört und zersetzt Leben. Deswegen kann gesagt werden, dass das Gegenteil von Liebe Angst ist. Wut und Hass sind Folgen der Angst.

Sie sind sekundär und sind Abwehr- und Verteidigungsmechanismen, die aus Angst heraus entstehen. Liebe und Angst sind die beiden großen Grundkräfte, die unser Leben bestimmen. Alle anderen Emotionen, die wir erleben, gründen auf diesen beiden. Angst völlig aus der Welt verbannen zu können, ist eine Utopie.

Es ist aber durchaus möglich, sie auf ein Minimum zu reduzieren. Und darum sollten wir uns kümmern. Denn Angst schränkt elementar die intellektuelle Lernleistung ein und blockiert Neugier und Erkundungsverhalten und somit Entwicklungsmöglichkeiten des Lebens. Sie beeinträchtigt das Selbstwertgefühl. Sie ist ein Schatten, der alles blockiert: unsere Liebe, unsere wahren Gefühle, unser Glück, unser ganzes Sein.

Wann setzt Angst ein und was geschieht in diesem Moment?

Angst taucht unvermittelt auf, wenn etwas passiert, auf das wir keinen Einfluss haben. Verbunden damit ist, dass wir glauben, dass ein Verlust, Schaden oder Misserfolg eintreten werden. Angst tritt auf, wenn wir etwas, das uns sehr wertvoll erscheint, als bedroht sehen. Es kann sich auf unseren Körper beziehen – entweder auf seine Gesundheit oder überhaupt auf seine Existenz. Die Ängste können materielle Werte betreffen, Beziehungen zu für uns wichtigen Menschen, Situationen, Pläne, Ziele, usw.

Grundsätzlich gilt für Angst, dass sie ohne Ausnahme den negativen Ausgang der Situation festlegt. Das heißt, wir nehmen von vorne herein an und rechnen damit, dass ein Verlust oder Nachteil eintreten wird und dass wir keine angemessenen Reaktionen zur Verfügung haben werden, um das negative Ergebnis abwenden zu können.

Somit können wir erkennen, dass Angst immer auf die Zukunft gerichtet ist und sei es nur auf den nächsten Moment. Angst bezüglich Vergangenem gibt es nicht. Dabei ist die Vorstellung, dass neben dieser negativen Perspektive auch noch andere Entwicklungsmöglichkeiten bestehen könnten, vollkommen ausgeblendet. Angst ist somit eine einseitige gedankliche Vorwegnahme. „Gedanklich“ bedeutet, dass Angst im Kopf beginnt, auch wenn wir ihre Auswirkungen vorrangig körperlich spüren. Diese Tatsache stellt einen äußerst wichtigen Ansatzpunkt dar, um Angst ausschalten zu können. Dazu später mehr.

Auslösende Quellen

Angst hat zwei auslösende Quellen. Entweder wir reagieren auf Ereignisse außerhalb von uns oder auf ungelöste Konflikte, die in unserem Inneren bestehen. Letztere sind z. B. sich widersprechende Bedürfnisse, einander entgegengesetzte Gefühle, Schwierigkeiten in der Entscheidungsfindung aufgrund von nebeneinander gleichwertig existierenden Wertsetzungen.

Zeiträume des Auftretens von Angst

Angst entsteht entweder einmalig in einer einzelnen Situation oder sie kann sich auch in speziellen Situationen regelmäßig wiederholen. Oder sie taucht – wie bereits erwähnt – unvermittelt in Form von Panikattacken auf. Bei manchen Menschen zeigt sie sich aber auch in einer grundsätzlichen, konstanten Hintergrundschwingung im Leben, die sich frei und diffus hin und her bewegt. Durch solche chronischen Angstzustände können komplette Lebensentwürfe blockiert werden.

Angst kann sich aber auch in besonderen, zeitlich begrenzten Lebensphasen verstärkt zeigen oder bei Lebensumbrüchen, wenn also über lange Zeit Gewohntes zu einem Abschluss kommt und Neues, noch Unbekanntes, ansteht. Sie bildet aber auch fest umrissene Formen aus, die als krankhafte oder pathologische Störungsbilder definiert werden, wie z. B. die Panikattacken oder Phobien aller Art.

Formen der Angst

Angst nimmt die unterschiedlichsten Formen an. Sie verbirgt sich hinter sehr vielfältigen Masken, sodass wir nicht immer unmittelbar erkennen und wahrnehmen können, dass Angst mit im Spiel ist. Es gibt Menschen, die bewusst die Gefahr suchen – zum Beispiel im Extremsport – um damit ihre Ängste abzuwehren. Sie wollen diesen durch ihren Wagemut zuvorkommen.

Angst und Furcht

Angst wird häufig mit Furcht gleichgesetzt. Oder es werden beide Begriffe unterschieden in der Weise, dass Angst mehr allgemein und übergreifend gesehen wird und Furcht ein klares Ziel hat. Wir haben Furcht ‚vor‘ etwas, wie z.B. Furcht vor Spinnen, Furcht vor dem Fliegen, Furcht vor der Reaktion eines Menschen. Manchmal wird unklare Angst auch vom Unterbewusstsein in Furcht ‚vor‘ etwas umgewandelt. Dadurch können wir besser mit ihr umgehen, da wir „den Feind im Auge haben“. Das bedeutet in diesen Fällen, dass hinter der Furcht vor etwas Speziellem, Angst in einem größeren Zusammenhang steht.

Angst und Schmerz

Angst und körperlicher Schmerz liegen eng beieinander. Körperlicher Schmerz zeigt an, dass in unserem Körper Fehlfunktionen bestehen; Angst deutet auf Ungleichgewichte im seelischen Bereich hin. Bei körperlichem Schmerz sind wir darauf erpicht, ihn so schnell wie möglich loszuwerden, um frei, unbeschwert und kraftvoll unser Leben weiterleben und genießen zu können.

Ist das bei Ängsten auch so? Anscheinend ist Angst für uns so selbstverständlich, sodass wir ein großes Stück weit daran gewöhnt sind, mit ihr zu leben, sie als notwendiges Übel zu betrachten. Wollen wir körperlichen Schmerz grundsätzlich beheben und nicht nur die Symptome dämpfen, wird der Arzt nach den Ursachen suchen. Wollen wir Angst nicht nur betäuben, sollten wir ebenso versuchen herauszufinden, wo ihre Wurzeln liegen, selbst wenn wir auch hier möglicherweise fachliche Hilfe benötigen sollten.

Indem wir das tun, befreien wir uns von Blockaden, sodass m e h r aus uns selbst – also aus unserer Persönlichkeit – und mehr aus unserem Leben werden kann; wir also auch hier uns freier und unbeschwerter durchs Leben bewegen können. Wir sollten uns ebenso so engagiert um unser Wohlergehen kümmern, wenn wir mit Ängsten zu tun haben, wie wenn uns körperlicher Schmerz zusetzt.

Verhaltensmöglichkeiten bei Angst

Um mit Angst umzugehen, stehen uns vier verschiedene Verhaltensweisen zur Verfügung: Flucht, Angriff, Erstarrung, besonnenes Handeln.

Symptome der Angst

Die körperlichen als auch die seelischen Symptome, die Angst auslöst, sind sehr vielfältig. Auch wenn sie keinem fremd sind hier einige von ihnen in Aufzählung: Körperlich: Herzrasen, beschleunigte Atmung aber auch Atemnot, Schweißausbrüche, Halszuschnüren und Sprachprobleme, Zittern, Herzbeschwerden, Störung von Blasenfunktion und Verdauung, Schwindel, Bluthochdruck, Schlafstörungen, Appetitlosigkeit aber auch Heißhunger, gestörte Sexualfunktionen, Muskelverspannungen und einiges mehr.

Seelisch: Gefühl von ständigem bedroht sein, starke bis überstarke Sicherungstendenzen, Fluchttendenzen, chronifizierte Sorge, Nervosität, Unruhe, Fahrigkeit, Aggressivität, Entscheidungsschwäche, fortwährendes Kränkeln, Weinerlichkeit, schnelle Ermüdbarkeit und allgemeines Schwächegefühl, Mut- und Hoffnungslosigkeit, extrem verzerrte Realitätswahrnehmung, Grübeln über Vergangenheit und bzgl. Zukunft und vieles Weitere mehr.

Ängste als Folge von rein körperlichen Erkrankungen

Es kann auch vorkommen, dass Ängste bzw. Angstzustände ihre Ursache in rein körperlichen Erkrankungen haben. Eine psychotherapeutische Behandlung wird hier keine Ergebnisse erzielen. Mit der medizinischen Behandlung der Grunderkrankung verliert sich auch die Angst wieder.

Beispiele für organische Erkrankungen, die undefinierbare Ängste hervorrufen, sind z. B. Erkrankungen des Herzen und der Schilddrüse, Entgleisungen im Hormon- und Stoffwechselhaushalt. Etwas anderes ist es, wenn wir uns Sorgen machen um die äußeren Umstände und um die Zukunft, weil bei uns eine schwere

Erkrankung festgestellt wurde. – Manchmal können Ängste auch als Nebenwirkung von Medikamenten auftauchen und häufig bei Drogenmissbrauch.

Ängste als pathologisch definierte Störungsbilder

Als pathologische, psychisch bedingte Störungsbilder definiert sind folgende Ängste: Die generalisierte Angststörung, Panikstörungen, speziell die Agoraphobie, bei der der Betroffene sich letztlich nicht mehr aus dem Haus wagt; die Posttraumatische Belastungsstörung, Phobien aller Art.

Die Soziale Phobie – die Befürchtung vor negativer Bewertung durch die Mitmenschen – ist sehr häufig und sehr vielen Menschen aus eigener Erfahrung bekannt, ohne dass sie unbedingt als pathologisch bezeichnet werden muss. Es kommt jedoch auf den Ausprägungsgrad an, der sehr stark variiert. Die pathologischen Ängste gehören unbedingt in die Hände von professionellen Begleitern. Aber auch bei anderen psychischen Belastungen können parallel dazu Ängste auftreten. Depressionen z. B. können von Ängsten begleitet sein.

Individuelle Ängste

Darüber hinaus hat jeder von uns ganz individuellen Ängste. In ein und derselben Situation ängstigt sich der eine, ein anderer jedoch nicht. Dies resultiert aus unserer persönlichen Lebensgeschichte, mit den Prägungen und Erlebnissen in der Kindheit, mit unserem sozialen Umfeld, in dem wir aufwuchsen; auch mit unserer charakterlichen Grundstruktur. Manche Ängste können wir auch nur gelernt haben – von Eltern oder anderen uns nahe stehenden Menschen übernommen, da sie uns diese Ängste vorlebten.

Hier können wir wieder sehen, dass Angst ein gutes Beispiel für die Macht des Denkens über Seele und Körper ist, da viele Ängste letztlich auf Erinnerungen beruhen und mit der gegenwärtigen Situation nicht viel zu tun haben müssen. Oder sie resultieren aus falschen Schlussfolgerungen, die wir als Kinder selbst gezogen haben, da uns die Welt noch zu wenig vertraut war.

Gefühle und Angst

Ein kaum zu unterschätzender, angstauslösender Aspekt stellen unsere verdrängten Gefühle dar, nicht nur die negativen sondern ebenso die positiven. Selbst wenn sich in den letzten zwei bis drei Jahrzehnten einiges diesbezüglich verbessert hat, ist es in unserer verstandesbetonten Gesellschaft und insbesondere in der Arbeitswelt wenig oder auch überhaupt nicht erwünscht, Gefühle zu zeigen.

Es geht darum, möglichst gut zu „funktionieren“ und dabei sind Emotionen hinderlich, wie die hinter dieser Einstellung stehende Überzeugung unausgesprochen lautet. Und so beginnen bereits ganz früh in der Erziehung der Kinder die Abwertung und das Zurückdrängen der Gefühle zugunsten des Vernunftdenkens, sodass sehr viele Erwachsene kaum mehr Zugang zu ihrer Gefühlswelt haben und sich sogar vor ihr fürchten, da sie sie unbewusst als etwas Verbotenes empfinden.

Letzteres zeigt sich immer wieder ganz deutlich in der therapeutischen Arbeit, und es ist ein Prozess, der viel Geduld erfordert, bis die Betroffenen die Angst vor ihren Gefühlen loslassen und sie sie willkommen heißen können. Verdrängte, nicht wahrgenommene Gefühle sind Ursache für viele Schwierigkeiten und Blockaden im Leben und eben auch deutlich Ursache für Angst.

Angst als sogenannte „gesunde“ Angst

In der Literatur ist immer wieder zu lesen, es gebe auch eine sinnvolle, gesunde Form von Angst. Es handelt sich um die Angst bei realen Gefahren, Angst als Alarmsignal, das uns aktiviert, um uns zu schützen. Ich selbst sehe allerdings in der Formulierung „gesunde Angst“ einen fatalen Denkfehler. Ich betrachte es als alles andere denn als hilfreich, Angst

in irgendeiner Weise positiv zu bewerten, denn das verharmlost sie und schwächt unsere Bereitschaft, uns ihr zu widersetzen.

Mit einem anschaulichen Beispiel will ich meinen Standpunkt erklären. Ich nehme hierfür die Situation, wenn ich bei einer Bergwanderung auf einem schmalen Pfad gehe und dicht neben mir der Berg steil in den Abgrund fällt. Was ich da spüre, fühlt sich zwar wie Angst an, ist in meinen Augen jedoch keine Angst, sondern einzig eine erhöhte Aufmerksamkeits- und Bewusstseinslage. Sie ist die Voraussetzung dafür, dass ich extrem wachsam bin, da ich weiß, dass diese Situation einen schädlichen Ausgang für mich haben könnte.

Das muss sie jedoch nicht zwangsläufig! Meine Hoffnung ist es ja gerade, dass es nicht so eintrifft. Die erhöhte Bewusstseinslage verwandelt sich genau in jenem Moment tatsächlich zur Angst und wird dadurch extrem gefährlich, wenn ich den Fokus hauptsächlich auf den negativen Ausgang lege, wie es Angst ja grundsätzlich tut; wenn also ständig der Absturz in den Abgrund in meinen Gedanken vor mir auftaucht.

Angst fixiert meinen Blick auf das Schlimme, das passieren könnte, also hier auf den Absturz. Dadurch werden die typischen Angstsymptome, z.B. Zittern, weiche Knie, angespannte Atmung, Fahrigkeit, usw. aktiviert, was mich in ein Gefühl der Kraft- und Hilflosigkeit, also in die Schwäche treibt. Das bedeutet in besagtem Beispiel, dass das Risiko tatsächlich abzustürzen, sich durch Angst erhöht. Angst ist verbunden mit Unklarheit und vermindert meine Reaktionsfähigkeit.

Bleibe ich jedoch besonnen und konzentriert und lasse mich durch die Gefahrensituation nicht irritieren, so sind alle meine Sinne aktiv und ich kann bewusst auf meine körperlichen Ressourcen zurückgreifen und sie dann zum Einsatz bringen. Ich richte meinen Blick auf das sichere Ziel oder auf den positiven Ausgang. Auf diese Weise wird meine Kreativität angeregt, sodass mir sinnvolle Lösungsmöglichkeiten für die heikle Ausgangslage einfallen; Stärke und Stabilität werden mobilisiert, um die gefundenen Möglichkeiten umsetzen zu können.

Ich sehe es als gefährlich an, diese erhöhte Bewusstseinsqualität bzw. Aufmerksamkeitslage als Angst zu titulieren, dazu noch als „gesunde Angst“. Allein schon das Wort ‚Angst‘ in einer solchen Situation zu denken oder auszusprechen, birgt die Gefahr, sie zu aktivieren. Es schwächt uns und bringt unter Umständen einen Kreislauf in Gang, in den wir uns immer mehr hineinsteigern.

Die Gefahr, auf eine selbsterfüllende Prophezeiung zuzusteuern, wächst. Wenn wir diesen Zustand von erhöhter Aufmerksamkeit als einen solchen erkennen können und so auch bezeichnen, gelingt es uns eher, uns auf das rettende Ziel auszurichten und uns auf unsere Ressourcen zu besinnen. Insofern gibt es für mich keine „gesunde“ Angst.

Angst als Herausforderung zur Persönlichkeitsentwicklung

Eine zweite Aussage, die Angst als positiv bewertet, ist auch immer wieder anzutreffen. Auch sie will ich kritisch hinterfragen. Sie sagt, dass Angst uns zur Persönlichkeitsentwicklung herausfordere, wenn hinter ihr eingefahrene, ungünstige Verhaltensmuster liegen. Dass Angst auf diese Muster hinweist, ist richtig.

Dennoch hört es sich auch hier so an, als ob wir der Angst dankbar für ihr Auftauchen sein sollten, sie somit auch positiv sei. Ebenso hier wird Angst durch die Art der Definition aufgewertet und damit verharmlost. Abgesehen davon kann man immer wieder Menschen begegnen, die sich von den Begriffen ‚Persönlichkeitsentwicklung, Reifung und Wachstum‘ nicht besonders angesprochen fühlen.

Mancher fühlt sich dadurch sogar persönlich angegriffen und mag sie deshalb für sich nicht in Anspruch nehmen. Meine Infragestellung lautet: Sind wir für das Auftauchen von körperlichem Schmerz denn auch dankbar? Bewerten wir sein Auftreten auch als positiv? In der Regel wollen wir ihn schnellstmöglich wieder loswerden und kümmern uns auch in der Mehrzahl der Fälle darum, dass die Ursache des Symptoms behoben wird. Parallel dazu würde es bezüglich der Angst bedeuten, auch schnellstmöglich nachzuforschen, was es mit ihr auf sich hat, um die Ursachen auflösen zu können, anstatt verbal ihrem Auftreten zu huldigen.

Die Gefahr, sich schicksalsergeben an angstvolle Zustände zu gewöhnen, ist recht groß, weil es sich ja „nur“ um psychische Angelegenheiten handelt und „nur“ um Persönlichkeitsentwicklung. Nochmals die Frage: Sind wir bereit, uns ohne weiteres an körperlichen Schmerz zu gewöhnen? Die Mehrheit der Menschen wird das mit einem eindeutigen ‚Nein‘ beantworten.

In Bezug auf Angst hingegen sind wir träge. In unserem Alltagsleben sind wir so an Ängste gewöhnt, dass wir sie viel eher hinnehmen als körperlichen Schmerz, ohne zu erkennen welch begrenzende Auswirkungen sie auf unser Leben haben. Wir sind eher bereit, Einschränkungen unseres Lebens durch Ängste hinzunehmen, denn durch körperlichen Schmerz.

Hinzu kommt die eingangs genannte Scham, sich zu Ängsten zu bekennen. Es ist heutzutage immer noch so, dass es uns wichtiger ist, uns um unseren Körper zu kümmern als um unser seelisches Wohlergehen. Psychische Schwierigkeiten zu haben, ist in unserer „aufgeklärten“ Gesellschaft immer noch zu großen Teilen ein Makel, insbesondere Ängste. Dagegen wird – wie immer wieder mitzuerleben ist – über körperliche Erkrankungen und Operationen ausführlich und mit einem unterschwelligen Stolz berichtet. Besonders en vogue sind seit Jahren Sportverletzungen.

Ich sehe es so: dass seelisches Ungleichgewicht so massive Formen annimmt, dass sie zur Angst führen, ist genaugenommen tragisch und traurig genug. Besser wäre es eigentlich, sowohl im körperlichen als auch im seelischen Bereich, wenn wir unser Leben von vornherein so achtsam und bewusst führen könnten oder würden, dass weder körperlicher Schmerz noch Angst als Hinweis notwendig wären. So finde ich es nicht weiterführend, wenn an dieser Stelle von Angst so gesprochen wird, dass wir letztlich noch froh über ihr Auftreten sein sollten.

Ich erkenne zwar durchaus, dass die Formulierung, Angst dankbar als Herausforderung zur persönlichen Entwicklung anzusehen, als trostvolle Entlastung für massiv Betroffene gedacht ist. Ihnen wird dadurch jedoch subtil die Opferrolle untergeschoben. Sie sollten dagegen ermutigt werden mit dem Hinweis auf eine verdeckte Stärke in sich, die es zu finden gilt und die es ermöglicht, Ängste zu überwinden. Schmerz und Angst sind einzig Symptome, die Hinweis-Charakter haben. Der Fokus sollte nicht auf den Symptomen liegen, sondern sollte sich von dort unverzüglich auf den Ort, an dem die Ursachen zu finden sind, verlagern.

Ich weiß natürlich, dass das Leben nicht perfekt ist. Deshalb sind körperliche und seelische Schieflagen nicht gänzlich unvermeidbar, sodass zwangsläufig Schmerz und Angst entstehen. Aus einem wohlgesonnenen und achtsamen Mitgefühl für uns selbst heraus sollten wir uns jedoch unmittelbar auf den Weg machen, den Heilungsprozess auch bei Ängsten einzuleiten; gemäß den einleitenden Worten dieser Ausführungen: Wer will nicht glücklich sein? Am Ende des Beitrags werde ich einige Hinweise geben, deren Beachtung dazu beitragen kann, dass Angst weniger Raum in unserem Leben findet.

Existentielle Grundängste und grundsätzliche Existenzangst

Es gibt noch einen besonderen Angst-Bereich, der unbedingt der Erhellung bedarf: es sind die existentiellen Grundängste, mit denen ein jeglicher Mensch konfrontiert ist, als Erwachsener allerdings in unterschiedlicher Intensität. Es sind Ängste, die insgesamt eine große Tragweite haben. Sie hängen auf fundamentale Weise mit dem Menschsein als solchem zusammen und führen bei genauer Betrachtung zu der einzigen, sämtlichen Ängsten zu Grunde liegenden Angst, zu der Angst vor dem Tod (grundsätzliche Existenzangst).

Alle Ängste – auch die vielen kleinen Alltagsängste – haben ihre Hauptwurzel in dieser einen Angst. Andersherum formuliert: es geht bei jeder Angst prinzipiell immer um unser Überleben. Da wir grundsätzlich erst einmal nicht einverstanden sind mit der Endlichkeit unseres Lebens bzw. mit seinem Ausgang (Tod), ängstigt uns jegliche Entwicklung, in der der Verdacht enthalten ist, sie könne uns an die Grenze zum Tod führen. Das Gesagte wird gleich deutlicher werden.

Der Gegenpol zur grundsätzlichen Existenzangst ist der Selbsterhaltungstrieb. Er ist unser stärkster Trieb. Es ist bekannt, dass in extremen Lebenslagen die Sexualität, die ebenso eine höchst lebensbestimmende Kraft ist, dennoch zum Erliegen kommt zugunsten der Selbsterhaltung.

Selbsterhaltung ist biologisch wichtiger als Fortpflanzung. Ein großer Teil dieser Grundängste belastet insbesondere stark die zwischenmenschlichen Beziehungen, deshalb auch Beziehungsängste genannt. Diese Grundängste sind folgende:

a. Beziehungsängste: Trennungs-, Verlassenheits-/ Verlustangst, Liebesverlustangst, Angst vor Nähe,

Angst vor Individuation (Entwicklung der Individualität), Gegen-Aggressionsangst

b. Angst vor Veränderung

c. Angst vor dem Endgültigen

d. Kontrollverlustangst

e. Autoritätsangst, Gewissens-/Schuldangst und mit beiden verbunden eine tief unbewusste Angst

vor Bestrafung.

f. Selbstwertängste

g. Ängste bei Lebensübergängen (Verlassen des Elternhauses, Heirat, Ruhestand, Umzug, etc.)

Ohne den tatsächlichen Grund dieser Ängste in einer konkreten Problem-Situation zu ahnen – z.B. bei einem Partnerschaftskonflikt oder bei sozialer Angst – ist die Berührung mit der Todesangst hier besonders eng. Die vielfältigen kleineren Alltagsängste sind erst einmal oberflächlich bezogen auf konkret sichtbare Problemkonstellationen, sodass die Verbindung zur grundsätzlichen Existenzangst erst einmal ziemlich verdeckt ist.

Wenn wir die Spur nach ihren Ursachen aber tiefer verfolgen, erkennen wir eine Spirale, die sich hinab bewegt bis zur Angst vor unserer Vernichtung. Wenn wir das einmal verstanden haben, können wir auch an dieser Stelle einen Ansatzpunkt finden, an dem wir die Angst aushebeln können. Hierzu im Schlussteil mehr.

Da an den existentiellen Grundängsten die Verbindung zur Todesangst noch am deutlichsten nachvollziehbar ist, will ich anhand von ihnen die Angstspirale nach unten erklären. Speziell bei den Beziehungsängsten liegt dieser Zusammenhang noch deutlich an der Oberfläche. Die existentielle Bedrohung zeigt sich hier zunächst als ein Gefühl von emotionaler Vernichtung, wenn z. B. die Beziehung zu zerbrechen droht. In extremer Weise kann dieses Empfinden so stark werden, dass der Betreffende meint, daran sterben zu müssen. Oder aber er entwickelt in der ersten abgrundtiefen Enttäuschung die paradoxe Idee, selbst aktiv den Tod zu suchen, um der Schmach „der Vernichtung durch eine andere Person“ zu entgehen.

Der Ursprung der Beziehungsängste, mit denen wir erfahrungsgemäß auch im Erwachsenenleben zu tun haben, liegt in der Kindheitsentwicklung. Damals waren wir auf den Schutz, die Fürsorge und die emotionale Zuwendung durch die Erwachsenen unbedingt angewiesen, um wachsen und gedeihen zu können, ja, um überhaupt überleben zu können. Als Kind durchlaufen wir ab der Geburt genetisch festgelegte Entwicklungsstufen: von dem noch bestehenden Einheitsgefühl mit der Mutter in den ersten Wochen nach der Geburt verläuft die Entwicklung über die Krabbelphase zum Laufen und damit zum selbstständigen Erkunden der Welt.

Es folgt die Entwicklung der ‚Ich‘-Wahrnehmung bis hin zur Pubertät mit einsetzender Geschlechtsreife und Identitäts-Findung bzgl. des zukünftigen Erwachsenenlebens. Diese Stufen beinhalten immer mehr Eigenständigkeit und Individuation und somit genau genommen immer mehr Abtrennung von anderen Menschen, was immer auch ein gewisses Angstpotential enthält, trotz dem Wunsch nach Selbstständigkeit. Für ein Kind bedeutet Liebesverlust die Gefahr, verlassen zu werden, und den Verlust der wichtigsten Versorgungspersonen sowohl in körperlicher als auch in emotionaler Hinsicht.

Daran würden sich als nächstes anschließen Isolierung, Schutzlosigkeit, Hilflosigkeit und die Gefahr alleine nicht zurechtzukommen. Am Ende steht die Möglichkeit des Todes. Diese Ängste werden wieder aktiviert, wenn Beziehungen schwierig werden oder zu zerbrechen drohen.

Je reibungsloser wir diese Entwicklungsstufen in der Kindheit bewältigen konnten, je weniger einschränkende Einflüsse unsere Kindheit belasteten, desto weniger haben wir mit diesen Ängsten im Erwachsenenleben zu kämpfen. Sind wir als Erwachsene stark mit Beziehungsängsten belastet, dann deutet dies darauf hin, dass schwierige Kindheitserfahrungen diesbezüglich nicht aufgearbeitet und geheilt sind.

Dennoch stehen wir alle unser Leben lang in dem Spannungsfeld zwischen Individualität und der Sehnsucht nach Verbundenheit. Das ist immer wieder Nährboden für Angst, denn beide sind starke Kräfte, die an uns ziehen und ihr Recht fordern. Angst vor Nähe hat damit zu tun, dass das Empfinden besteht, dass zu große oder zu viel Nähe zu einem „verschlungen werden“ führen könnte, also zu einer vollständigen, dauerhaften Auflösung der eigenen Identität und somit auch zur Vernichtung.

Angst vor Individuation weist darauf hin, dass ein Mensch befürchtet, abgelehnt und aus der Gemeinschaft verstoßen zu werden, wenn er seine Individualität zum Ausdruck bringt. Daraus würde auch wieder Isolierung folgen mit allen möglichenBegleiterscheinungen bis hin zum Tod.

Auch bei den weiteren Grundängsten geht es letztlich wieder um die prinzipielle Existenzangst: Bei den sozialen Ängsten steht im Vordergrund, von anderen Menschen negativ bewertet und verstoßen zu werden. Die Angst redet uns ein, die Abwertung könne so massiv werden, dass wir dann von „Gott und der Welt“ verlassen da stehen würden, wiederum letztlich mit der letzten Folge der möglichen Vernichtung.

Autoritätsängste, Schuldängste und unbewusste Strafängste haben mit einer Selbstwertproblematik zu tun. Als Strafe droht letztlich auch wieder Ausschluss mit Tod.

Ängste an Lebensübergängen hängen damit zusammen, dass uns das Neue unbekannt ist. Es könnte Gefährliches beinhalten oder wir könnten scheitern, weil wir glauben, nicht die nötigen Ressourcen und Kompetenzen zu besitzen, um die neue Situation zu meistern, was in letzter Konsequenz auch wieder zum Tode führen könnte.

Ähnlich den Ängsten bei Lebensübergängen sind die Ängste vor Wandel und vor dem Endgültigen. Angst vor Wandel sagt uns, Veränderung könne Gefahr beinhalten, die zur Vernichtung führe. Wenn sich etwas endgültig anfühlt, steht neben einer positiven Bewertung des Gewohnten die Assoziation von Unveränderbarkeit, Unbeweglichkeit, Unlebendigkeit, was nicht weit entfernt liegt von der Vorstellung der Endgültigkeit des Todes.

Letztlich können wir alle Ängste herunterrechnen auf die Angst vor der existentiellen Auslöschung. Sie ist zutiefst in jedem Menschen verankert, auch in jedem Tier. Ich denke, bereits bis hierher wird deutlich erkennbar, in welchem Ausmaß Angst eigentlich unser Leben bestimmt und auch, dass wir sie nicht immer bewusst wahrnehmen. Daraus können wir schließen, wie enorm wichtig es ist, Angst in ihrem Wesen zu verstehen, damit wir sie so weitreichend wie möglich identifizieren können. Außerdem wird nun verständlich, dass wir Angst nicht gewohnheitsgemäß akzeptieren sollten, wenn uns eine sinnvolle und erfüllenden Lebensgestaltung lieb und teuer ist.

Theorien zur Entstehung

Sowohl die Naturwissenschaften als auch die Geisteswissenschaften setzen sich mit dem Phänomen der Angst auseinander, um verstehen zu können, was es mit ihr auf sich hat und wie sie entsteht. Es haben sich verschiedene Theorien entwickelt, wobei gesagt werden kann, dass keine die andere ausschließt, sondern jede Perspektive ihre Berechtigung hat. Die Entstehung der Angst hat verschiedene Komponenten.

Die Theorien stammen aus der Evolutionsforschung, Neuropsychologie, Kognitionspsychologie, Tiefenpsychologie, der Entwicklungspsychologie des Kindes, aus dem Bereich der Lerntheorien und aus der Philosophie. Genannt wird z. B., dass sowohl ungelöste Konflikte, frühere gefahrvolle Erlebnisse – die als Erinnerung abgespeichert sind -, Verhaltensweisen, die von anderen Menschen gelernt wurden, als auch irrationale, gedankliche Schlussfolgerungen, ebenso wie genetische und hirnphysiologische Gegebenheiten eine Rolle spielen. Auch die Religionen und spirituelle Lehren haben ihre Erklärungen bezüglich des Ursprungs von Angst.

Der gemeinsame Nenner aller Theorien ist jedoch, dass Angst damit zu tun hat, dass wir uns in unserer Existenz bedroht sehen.

Wie viel Angst ist wirklich nötig?

Wenn wir die erhöhte Bewusstheits- und Aufmerksamkeitslage in realen Gefahrensituationen nun – wie vorhin dargestellt – nicht mehr als Angst bezeichnen, dann bleibt letztlich nur ein grundlegender Wirkmechanismus, der Angst steuert, übrig, gleichgültig auf welcher Grundlage er entstanden ist. Es ist der, dass Angst gedankliche Vorwegnahme von ungünstigen Ergebnissen darstellt, in deren Folge sich körperliche und psychische Symptome einstellen, die in massiver Weise auch die Gefühlsebene beeinflussen.

Bei starken Angstzuständen greifen diese Ebenen auf vielfältige Weise ineinander, sodass sie sich kaum noch voneinander getrennt wahrnehmen lassen. Bezüglich der negativen gedanklichen Vorwegnahme vergessen wir, dass die Realität nicht zwangsläufig so aussehen muss und auch nicht so aussieht, wie die Angst uns das weismachen will.

Wenn wir genau hinsehen, können wir feststellen, dass die meisten Ängste letztendlich Fantasien und Einbildungen sind. In unserem Kopf spielt sich ein Gedankenprozess ab, der einem Horrorszenario in einem Film gleicht. Es gibt noch andere Perspektiven, doch wir lassen uns von der Filmhandlung völlig aufsaugen und gestatten der Angst in uns Platz zu nehmen. Wir glauben ihr auch noch ungeprüft das, was sie uns einflüstert. Angst ist manipulatives ‚Kopf-Kino‘. Deshalb können wir mehr gegen sie unternehmen, als wir ahnen, indem wir immer mehr lernen, die Angstbilder als Film zu identifizieren, aus dem wir jederzeit aussteigen können.

Und indem wir uns angewöhnen, uns gleichzeitig daran zu erinnern, dass es neben der Film-Story eine Realität gibt, in der auch noch andere Entwicklungsmöglichkeiten existieren. Angst ist also nicht notwendig. Sie wendet nicht die Not.

Wir können nach allem Gesagten feststellen: Angst an und für sich ist nicht notwendig. Sie wendet in keiner Weise die Not, sondern verstärkt sie nur. Angst ist ein weit verbreitetes Übel. Wir sollten uns nicht an sie gewöhnen. Sie ist, um ein glückliches Leben zu finden und zu gestalten, schlicht und einfach hinderlich.

Ich selbst habe viele Ängste durchkämpft, um zu dieser heilsamen Einsicht zu gelangen. Wir müssen uns Auf unsere Stärke besinnen, die auch in uns vorhanden ist und mit ihr weitergehen mit dem Blick auf die positiven Entwicklungsmöglichkeiten im Leben. Nur das hilft. Der Widerstand, der häufig dieser These entgegen gesetzt wird, lautet: „Ja, aber da ist doch gerade dieses und jenes und das ist einfach beängstigend. Es ist eben einfach so; da kann ich nichts machen.“ Wenn wir so tatsächlich denken wollen, dann wird es auch so sein: wenn wir der Angst Macht über uns geben, dann kann sie uns packen.

Und wenn sie das einmal umfassend geschafft hat, nützt aller Verstand nichts. Dann sind wir ihr erst einmal vollkommen ausgeliefert. Deswegen sollten wir uns in angstfreien Zeiten grundsätzliche Gedanken über sie machen, wozu dieser Beitrag anregen soll. Wenn wir das Wesen der Angst einmal verstanden haben, können wir ihr, wenn sie auftaucht, wesentlich kraftvoller entgegentreten als vorher. Sie kann uns dann nicht mehr in einer Weise packen, die uns im wahrsten Sinne des Wortes den Verstand verlieren lässt.

Wir sollten uns zudem um ein achtsames, bewusstes Leben bemühen, um Ängsten keinen Nährboden zu geben. Die häufige Nachlässigkeit, bei der wir der Angst zu viel Raum in unserem Leben geben, beruht darauf, dass wir dermaßen an sie gewöhnt sind, dass sie zu einer Selbstverständlichkeit geworden ist und sie uns deshalb – so widersprüchlich es klingt – damit ein Stück weit Halt gibt, eine Form von Identität. Wir können uns eine in weiten Strecken angstfreie Lebensperspektive kaum vorstellen.

“Wo kämen wir denn hin, wenn wir so gut wie keine Angst mehr hätten! Wären wir dann noch ‚normale‘ Menschen?“ Einer der Gründe, aber nicht der einzige, hierfür ist, dass unterschiedlichste Autoritäten – einzelne Menschen, Institutionen, Gruppierungen verschiedener Art – über die Jahrtausende hinweg Angst als Druckmittel eingesetzt haben. Sie tun es immer noch. Sie benutzen sowohl subtile als auch offene Drohgebärden und Einschüchterungsmaßnahmen. So manifestiert sich Angst als ein gängiges Lebensgefühl.

Selbst in der modernen Erziehung wird immer wieder unachtsam mit Angst gearbeitet. Ein kleiner Satz als Beispiel: „Wenn du jetzt nicht gehorchst, dann hat Mami dich nicht mehr lieb.“ Aber, was tun wir denn eigentlich gegen die Angst? – Wir machen Überstunden, um ausreichend Geld zur Verfügung zu haben, um einen Teil unseres Glückes kaufen zu können, wir rennen zu Ärzten, Masseuren und Physiotherapeuten, schlucken Medizin, suchen Fitnessstudios auf. Aber unsere Ängste nehmen wir schicksalsergeben hin!

Eine weitere Begründung für die These, dass Angst genau genommen überflüssig ist, lautet – und mancher wird sie empört zurückweisen – ‚Angst zu haben kann auch ein recht bequemer Weg sein‘. Sich von Angst bestimmen zu lassen, kann ein Ausweichen vor den Erfordernissen des Lebens sein, ein Ausweichen vor dem Leben selbst und vor der eigenen Stärke. Wir sind es gewohnt und wurden durch die Erziehung so geprägt, dass wir eher unsere Unvollkommenheiten wahrnehmen als unsere Stärken. Deshalb können wir oft unsere eigene Stärke nicht erkennen. Oder, selbst wenn wir sie erahnen, wollen wir sie nicht in Anspruch nehmen oder uns bemühen, sie wirklich zu finden. Uns in der Opferrolle zu sehen, ist einfacher und bequemer. Insofern übernehmen wir an dieser Stelle keine Verantwortung für unser Leben, wenn wir uns der Angst ausliefern.

Was können und sollten wir also tun?

Ich möchte noch einmal ausdrücklich betonen: Wenn massive Ängste vorliegen oder wir das Gefühl haben, schon zu sehr in angstauslösende Probleme verstrickt zu sein, werden wir es kaum schaffen uns alleine daraus zu befreien. Dann sind gezielte therapeutische Maßnahmen unumgänglich. Ich will hier keine konkreten Sofortmaßnahmen und Heilverfahren schildern. Es gibt unterschiedliche Herangehensweisen und Methoden. Diese sind durch den Therapeuten zu erfahren.

Wichtig ist mir, grundlegende Aspekte und Hinweise zu nennen, die uns helfen können, unseren Alltagsängsten allmählich eine Abfuhr zu erteilen, sodass sie überhaupt nicht die Chance bekommen, sich in umfassendem Maße in unserem Leben einzunisten. Es geht darum, dem Auftreten der Angst und ihrer Ausbreitung vorzubeugen.

Hilfreiche Hinweise gegen die Angst

Gedanken über Tod und Endlichkeit

Da uns nun bewusst ist, wie sehr alle Ängste mit der Todesangst verbunden sind, ist es von großem Nutzen, sich Gedanken über die persönliche Einstellung zu Tod und Endlichkeit zu machen. Wenn wir dahin kommen können, ruhig und gelassen den Tod zu akzeptieren, ihn nicht mehr zu fürchten und aus unserem Leben auszugrenzen, kann dies mit der Zeit allen Ängste die Kraft entziehen. Der regelmäßige Blick auf den Tod soll uns nicht ängstigen, sondern soll Anlass dafür sein, unsere Lebenszeit bewusst zu erkennen und als wertvoll zu betrachten, um sie mutig, kraft- und sinnvoll zu gestalten, solange es möglich ist. Und dabei ist die Angst nur hinderlich.

Kopf-Kino Angst

Ein ganz entscheidend wichtiges Hilfsmittel ist, uns immer wieder deutlich zu machen, dass die Angst weitgehend „Kopf-Kino“ ist. Es geht darum, wenn Angst zu spüren ist, ihr nicht einfach vorbehaltlos zu folgen, sondern innezuhalten – regelrecht einen Stopp zu setzen – und in sich hinein zu spüren, um den Film, der da läuft, zu identifizieren. Als nächstes sollten wir uns um eine realistische Sichtweise bemühen und unmittelbar nach einer positiven Gegenperspektive Ausschau halten.

Es gibt keine Regel, die besagt, dass ein Ereignis, das derzeit seiner Realisierung harrt, eine negative Richtung nehmen muss. Der negative Ausgang existiert nur als Möglichkeit in den Gedanken. Also sollten wir auch eine positive Entwicklung in Betracht ziehen. Dann steht es zumindest 50:50 und wir können die Angelegenheit entspannter angehen. Wir sollten auch gedanklich nicht zu viel mit der Zukunft

beschäftigt sein und diesbezügliches Grübeln vermeiden. Das öffnet der Angst die Türen. Besser ist es, sich immer wieder ins Hier und Jetzt zurückzuholen und sich auf das zu fokussieren und Freude daran haben, was gerade jetzt möglich ist.

Dialog mit sich selbst

Eine Möglichkeit, Ursachen von Ängsten auf die Spur zu kommen, kann ein mitfühlender Dialog mit sich selbst sein. Wenn wir Angst aufsteigen spüren, reden wir mit uns wie mit einem Kind oder wie mit Freund oder Freundin: „Da ist Angst. Meine Liebe/mein Lieber, was ist mit dir? Was macht dir so zu schaffen? In welchem Konflikt befindest du dich gerade. Wie sieht er aus? Was arbeitet da gerade in dir gegeneinander? Was verunsichert dich?“ Dabei hilft, sich selbst gegenüber der Angst einen Namen zu geben, sie zu benennen und dies durchaus laut auszusprechen. Dabei wird die Angst-Stimme mit den entsprechenden bildlichen Szenarien in unserem Kopf deutlicher, von denen wir uns dann distanzieren können, indem wir realisieren, dass da gerade ein Film in uns läuft.

Suche nach gelungenem Leben

Lohnenswert ist es, sich an bisherige Lebenssituationen zu erinnern, deren Ausgangslage schwierig war und die uns dennoch gelungen sind. Des Weiteren sollten wir uns auch offen und ehrlich diejenigen Situationen vor Augen führen, bei denen Ängste überflüssig waren, weil die von ihnen prophezeiten negativen Folgen nicht eingetreten waren.

Das eigene Leben leben

Angst kann auch viel damit zu tun haben, dass ich zu wenig mein eigenes Leben lebe; meiner Identität und meiner Individualität zu wenig Entfaltungsraum zugestehe. Dass ich mich zu sehr nach anderen Menschen ausrichte, mich abhängig von ihnen und ihrem Urteil mache. Dass ich mich zu sehr auf sie beziehe und konzentriere; dass ich zu sehr mein Glück durch sie erhoffe.

Damit gebe ich mich ein ganzes Stück weit selbst auf. Unbewusst erinnert mich diese teilweise Aufgabe einer eigenen Identität an Auslöschung. Irgendwo in mir ahne ich auch, dass ich mich nicht absolut auf die anderen Menschen verlassen kann, finde aber auch keinen Halt in mir selbst, da ich die Beziehung zu mir selbst verloren habe. Hier kann sich Angst ganz leicht einklinken.

Ähnlich ist es, wenn ich mich selbst zu wenig kenne, dass ich zu wenig weiß, wer ich eigentlich bin, was ich tatsächlich kann, fühle, denke, wünsche. Wir meinen häufig zu wissen, wer wir sind. Wenn dann aber etwas tiefer nachgefragt wird, fehlen schnell die Antworten. Dann sind da innere Leerräume und es bestehen Gräben zwischen dem eigenen (falschen) Selbstbild und der Beziehung zur Welt.

Wenn ich mir meiner selbst nicht sicher bin, mich nicht in mir selbst sicher fühlen, habe ich weder Vertrauen in mich noch in die Welt und habe Schwierigkeiten, mit den Anforderungen des Lebens zurechtzukommen. Daraus resultieren diverse Ängste. Damit kann Angst auch Zeichen sein, dass wir nicht mit uns selbst verbunden sind.

Andersherum: Mit sich selbst verbunden zu sein, führt in die eigene Stärke und vermindert so die Angriffsfläche für Angst. Mich auf die Suche nach mir selbst zu machen, mich in mir selbst gut auszukennen, führt zu einem stabilen Selbstgefühl und zu Selbstvertrauen. Meinen eigenen Weg zu gehen, mein Eigenes zu leben, mich nach dem Leben zu fragen, das in mir steckt, mich damit vertraut zu machen und es zur Sprache zu bringen, gibt meinem Leben Sinn und damit inneren Halt.

Wenn ich mutig mein Eigenes lebe, bejahe ich mich selbst und erlebe Freude. Ich wende mich damit dem Leben zu und erkenne, dass ich die Welt mit meiner Individualität bereichere. Dagegen kommt die Angst nicht so ohne weiteres an. Die Fragen an mich sollten an dieser Stelle lauten:“ Ist da ungelebtes Leben in mir? Welches Leben in mir lebe ich nicht aus?“

Es geht auch darum, sich nicht nur an materiellen Werten auszurichten, die jederzeit verloren gehen können, sondern auch innere Werte zu leben, geistiges Potenzial, das wir bleibend in uns tragen.

Den Rhythmus des Lebens erkennen und anerkennen

In den Jahrhunderten, in denen sich die Naturwissenschaften und in der Folge die Technik in all ihren Spezialgebieten in rasantem Tempo entwickelten, haben wir neben der natürlichen Welt eine künstliche Parallelwelt erschaffen, die unseren heutigen Alltag bestimmt. Die Natur hat weitgehend nur noch eine sekundäre Bedeutung als Erholungswert. Ansonsten dient sie zur Produktion von Nahrungsmitteln und zur Lieferung von Bodenschätzen und sonstigen Materialen, die wir weiterverarbeiten.

Wir haben uns zum größten Teil aus ihrem Rhythmus herausgenommen und uns unseren eigenen geschaffen. Wir arbeiten nachts, schlafen teils tagsüber, verbringen viel Zeit in virtuellen Welten, bewegen uns verhältnismäßig wenig, halten uns hauptsächlich in geschlossenen Räumen auf; wir essen unregelmäßig und ungesund – nur um ein paar Beispiele zu nennen.

Unser Körper konnte dieser Entwicklung bislang nur sehr begrenzt folgen und hat weitgehend die alte „Takt“frequenz beibehalten. So existieren wir in zwei Welten mit unterschiedlichen Rhythmen. Auch dieser Spagat ist ein Nährboden für Angst. Tief in uns spüren wir noch die Verbindung zur Natur und zu ihren ausgewogenen Rhythmen und unsere Sehnsucht danach.

Auf der anderen Seite leben wir gegensätzlich zu diesem Empfinden. Wir dürfen uns nicht wundern, dass in infolgedessen die medizinischen und psychotherapeutischen Praxen voll und Termine erst nach einigen Wochen zu erhalten sind. Unsere verstandesbetonte Welt denkt und handelt weitgehend nach dem Prinzip

‚Entweder – Oder‘. Wenn wir etwas genauer hinsehen und hin spüren, merken wir, dass es ein sehr einengendes, statisches Prinzip ist.

Das Leben selbst und die Natur bewegen sich jedoch in einem fließenden Prozess weiter, in dem die Regel ‚Sowohl – Als auch‘ gilt. Es wechseln sich periodisch Werden und Vergehen ab. Es gibt Zeiten der Aktivität und der Ruhe, des Einatmens und des Ausatmens; so entstehen eine gewisse Harmonie und ein Gleichgewicht. Dies zu erkennen und es auch anzuerkennen, und uns diesem natürlichen Rhythmus wieder etwas mehr anzuschließen, reduziert ein Stück weit die Tendenz zu Ängsten, weil wir uns dann mit unserer Existenz in den Kreislauf des Lebens eingebettet und in ihm geborgen fühlen können.

Uns wird dadurch gewahr, dass vieles im Leben sich auch selbst regulierten kann und wir nicht fortwährend kontrollieren und eingreifen müssen. Und so gilt es, das eigene Leben daraufhin zu durchsuchen, an welchen Stellen wir uns wieder mehr dem Prozess des Fließens hingeben können.

Entscheidung gegen die Angst

Eine sehr kraftvolle Maßnahme ist die radikale und konsequente Entscheidung, Angst nicht mehr zuzulassen. Es gelingt jedoch meistens erst, wenn Wesen und Wirkmechanismus der Angst begriffen worden sind. Es geht hier darum, sich von seiner Angst nicht mehr alles gefallen zu lassen und – eine Stufe weiter – sich eben prinzipiell gegen sie zu entscheiden, sobald zu spüren ist, dass sie sich anschleicht.

Ich mache mir bewusst, dass da Angst ist und weise sie entschieden vom Platz. Ich bleibe besonnen, konzentriere mich auf meine Stärke und richte mich auf eine positive Entwicklung aus. Die Vorstellung, sich erfolgreich gegen die Angst entscheiden zu können und ihr nicht hilflos ausgeliefert zu sein, mag zunächst befremdlich wirken. Vielleicht ist es nach folgenden Ausführungen besser nachzuvollziehen.

Uns entscheiden zu können, ist eine Fähigkeit, die wir den Tieren voraushaben, welche nur ihrem Instinkt folgen können. Wir benutzen sie leider viel zu wenig bewusst. Dennoch müssen wir sie von Minute zu Minute anwenden, da unser Leben sich sonst nicht vorwärts bewegen könnte. In der unermesslichen Vielfalt dieser Welt müssen wir ständig auswählen und entscheiden. Ob wir einen Kaffee kochen oder nicht, hängt ebenso von einer Entscheidung ab, wie, ob wir aufstehen oder sitzenbleiben, ja, sogar, ob wir einen Arm heben oder senken.

Sehr viele Entscheidungen laufen unbewusst ab. Bewusst entscheiden wir uns bei größeren Lebensveränderungen. So leben wir von Entscheidung zu Entscheidung und formen die Gestalt unseres Lebensweges. Nutzen wir doch auch hinsichtlich der Angst bewusst diese Möglichkeit! Nach allem, was wir bis hierher in Erfahrung bringen konnten, ist Angst überflüssig! Entscheiden wir uns also gegen sie –

immer und immer wieder, sodass sie uns immer weniger die Kraft und Lebensfreude nehmen und uns immer weniger in der sinnvollen Lebensentfaltung blockieren kann.

Spiritualität und Angst

Vergessen will ich nicht, dass auch in religiösen und spirituellen Lehren kraftvolle Unterstützung gegen die Angst gefunden werden kann, selbst wenn hier insbesondere in den institutionalisierten Religionen, aber auch in anderen spirituellen Ausrichtungen, und bis in die Familien und in die Erziehung hinein im Laufe der Jahrhunderte und Jahrtausende einiges fürchterlich schief gelaufen ist.

Angst wurde und wird immer wieder noch weltweit auch im religiösen Kontext als Druckmittel eingesetzt. Die Lehren erfuhren im Verlauf ihres Bestehens eine massive, Ängste auslösende Verzerrung, sodass damit Macht ausgeübt werden konnte. Doch haben sie ebenso das Potential, das Leben positiv zu unterstützen, es zu bejahen und der Angst damit entgegen zu wirken.

Aus der Kraft der Liebe leben

Wir stellten bereits zu Beginn fest, dass das Gegenteil von Liebe Angst sei. Somit ist andersherum das Gegenteil von Angst: Liebe. Gegenteile schließen einander aus. Wo das eine ist, kann das andere nicht sein. Das bedeutet dann, dass wir, je mehr wir in der Kraft der Liebe sind, Angst bei uns keinen Raum findet. Wie kann das konkret verstanden werden?

Neben den verschiedenen Formen der zwischenmenschlichen Liebe – Eltern-Kind-Liebe, partnerschaftliche Liebe, Geschwisterliebe, etc. – gibt es die Liebe zur Natur, zur Kunst, zu Tätigkeiten aller Art, zum Beruf, usw. Auch wenn uns abstrakte Werte wichtig sind wie z. B. Toleranz, Freundschaft, Humor, Authentizität, Freundlichkeit, etc., enthält diese Haltung Liebe, sonst würden wir sie nicht anstreben. Es gibt die Liebe zum Leben ganz allgemein, trotz dessen Gegensätzlichkeiten und Problematiken. Hieraus entstehen auch das Engagement und das Einstehen für das Leben, wenn Missstände auftreten.

Liebe bedeutet immer für das Leben zu sein und nicht dagegen. Wenn wir gegen Unangenehmes und Schmerzhaftes revoltieren, immer wieder unzufrieden sind mit dem, was wir gerade haben, immer mehr wollen und alles mit Kritik überhäufen, dann bedeutet das Widerstand gegen das Leben. Zum Widerstand zählen ebenso überzogene Selbstkritik und zu hohe Perfektionsansprüche an sich selbst, also mangelnde Selbstliebe.

Ich möchte nochmals zusammenfassen: Wenn wir nur die positiven Seiten des Lebens bejahen und nicht das Leben grundsätzlich in seiner Gesamtheit – mit seinen hellen und mit seinen dunklen Seiten – dann fehlt uns Liebe zum Leben, dann sind wir nicht bereit, uns voll und ganz auf es einzulassen und uns für es zu engagieren. Wir stehen in Opposition zu ihm. Dann werden die Welt und das Leben zu unserem „Feind“ und wir fühlen uns unsicher, bedroht und misstrauisch. Und das lädt Angst ein.

Dem Leiden und dem Unangenehmen des Lebens mit Liebe zu begegnen, bedeutet nicht, dass wir beides willkommen heißen müssen, sondern es heißt so viel, dass wir dies zunächst einmal annehmen und akzeptieren, so, wie es ist, um uns dann mit Mitgefühl und Besonnenheit so gut wie möglich um Lösungen zu bemühen. Daneben sollten wir auch das Positive, das schon in unserem Leben vorhanden ist, mit in den Blick nehmen. Das alleine schon bringt Beruhigung und Stabilität in die Situationen und trägt somit dazu bei, dass Angst keine Angriffsfläche findet. Liebe ist immer ein ‚Ja‘. Sie will das Leben. Angst ist ein ‚Nein‘ und lenkt den Blick auf die Vernichtung.

Deshalb ist es heilsam und Angst vermeidend, wenn wir dem Leben in seiner Gesamtheit mit Liebe oder zumindest mit Mitgefühl begegnen. Wenn wir immer mehr in alle Aspekte des Lebens unsere Liebe und ein mitfühlendes Gewahrsein fließen lassen können, wirkt und wird es versöhnlicher für uns. Wir können erkennen, dass es uns auch trägt und dass wir deshalb auch Vertrauen wagen können. Wo Liebe, Vertrauen, Hoffnung und Glaube an das Gute, welches auch immer neben allem Schwierigen und Schlimmen existiert, Raum gegeben wird, da findet Angst keinen Platz und hat keine Bedeutung mehr.

www.sinnundwerte-praxis.de

Ruth Scheftschik ist Therapeutin für Logotherapie und Existenzanalyse. Weitere Schwerpunkte Ihrer Tätigkeit sind die Wertorientierte Imaginationsarbeit nach Dr. Uwe Böschemeyer und das Enneagramm der Persönlichkeiten. Bei Seminaren und Vorträgen legt Sie besonderen Wert auf die Bereiche Achtsamkeit, Selbstwert/Selbstbewusstsein, Sinn und Werte.

The post Angst verstehen, Angst auflösen appeared first on Leben ohne Limit.

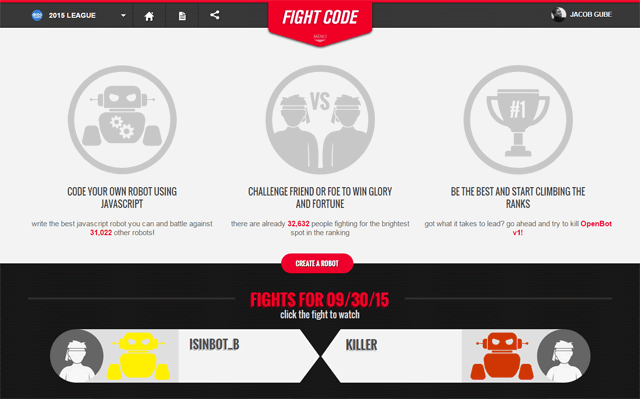

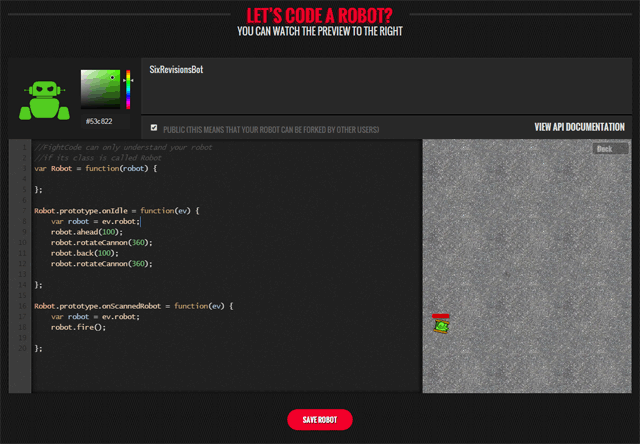

Jacob Gube is the founder of Six Revisions. He’s a front-end developer. Connect with him on

Jacob Gube is the founder of Six Revisions. He’s a front-end developer. Connect with him on  Assuming the

Assuming the

In this case the

In this case the

Aristotle once said that we are what we repeatedly do. Therefore, if you want to live a successful life, you need to have the right mindset and habits. On the other hand, it should be noted that human as we are, we have faults that prevent us from reaching our full potential. This is where the need to improve oneself comes in. With this, you can experience personal growth, pursue your passion, live a more meaningful life, help others, and so much more! Obviously, such task is not a walk in the park, but the good thing is: there are straightforward tips regarding the said matter. Some of which are elaborated below. 1. Go online and promote yourself Promoting yourself online is a must, especially […]

Aristotle once said that we are what we repeatedly do. Therefore, if you want to live a successful life, you need to have the right mindset and habits. On the other hand, it should be noted that human as we are, we have faults that prevent us from reaching our full potential. This is where the need to improve oneself comes in. With this, you can experience personal growth, pursue your passion, live a more meaningful life, help others, and so much more! Obviously, such task is not a walk in the park, but the good thing is: there are straightforward tips regarding the said matter. Some of which are elaborated below. 1. Go online and promote yourself Promoting yourself online is a must, especially […]

A Game of Thrones: The Graphic Novel: Volume One: Daniel Abraham, George R. R. Martin, Tommy Patterson: 9780440423218: Books

A Game of Thrones: The Graphic Novel: Volume One: Daniel Abraham, George R. R. Martin, Tommy Patterson: 9780440423218: Books