I occasionally find someone asking this question in my inbox. I’ve learned that for every person that bothers there are a bunch more with the same question, so I thought I’d take a break from relentlessly plugging my side hustle Later for Reddit to answer it publicly.

Shared posts

What programming language should I learn? (2017 edition)

Dilemas de PO: como definir OKRs em equipes ágeis

Continuando a série de posts referente aos dilemas da vida de gerentes de produto, gostaria de compartilhar uma técnica para que você e a sua equipe possam se planejar melhor.

É comum no ambiente de equipes que trabalham com a construção ou evolução de produtos a necessidade da definição de objetivos, a projeção de resultados esperados e o planejamento de entregas. Se você convive com tais desafios, confira a seguir uma dinâmica na qual obtive ótimos resultados no processo de concepção de OKRs.

O que é OKR e para o que serve

Bom, antes de escrever sobre o assunto, vale a pena definir o termo OKR.

Segundo definição do pessoal da Lean Performance, OKR — do inglês Objectives and Key Results –, utilizado no Silicon Valley por empresas como Google, Facebook, Linkedin, Intel etc, é um framework para definir metas. Trata-se de um sistema simples para criar alinhamento e engajamento em torno de metas mensuráveis e dinâmicas, tipicamente definidas trimestralmente.

OKRs são uma ótima forma das organizações criarem e comunicarem objetivos e resultados. Seu maior propósito é promover conexão entre os objetivos da empresa, do time e dos indivíduos a partir de resultados mensuráveis, fazendo com que todos se movam na mesma direção.

Em resumo, utilizar OKRs adequadamente auxilia no aumento do alinhamento e do engajamento entre as pessoas, e torna o processo de planejamento estratégico mais ágil, com maior cadência de revisão, adaptação e participação de toda a equipe.

O alinhamento e engajamento entre as pessoas aumentam, pois o time passa a fazer parte do direcionamento do produto, gerando maior senso de pertencimento em cada um.

Certa vez, no projeto de um dos nossos clientes, após a equipe definir os OKRs, fui informado pelo QA que o bug que estava ocorrendo no ambiente de produção iria impactar diretamente um dos OKRs, se não fosse corrigido imediatamente. Esse fato me deixou realmente surpreso, pois jamais veria uma ação assim se não compartilhassemos a responsabilidade com todo o time.

Com a aplicação de OKRs, ganhamos mais uma ferramenta na priorização do backlog e, mais importante, temos o escopo direcionado para um objetivo comum.

Ao aplicar dinâmicas de OKRs, espera-se que a empresa, equipe ou pessoa tenha em mãos:

- Objetivos: Possuem, por essência, característica qualitativa, inspiracional, com prazo definido e apontem para metas, ou seja, dizem para onde se deve ir.

- Key results: Quantificam toda a ideia inspiracional. Devem ser atingíveis, mensuráveis e realistas. Em outras palavras, indicam como será possível atingir os objetivos.

Beleza Raphael, entendi os conceitos e percebi que isso pode ser útil, mas você pode dar um exemplo?

Objetivo: Aumentar o número de clientes a partir de melhor experiência de uso do aplicativo.

Período: Primeiro trimestre de 2017.

Key results:

- Aumentar a taxa de conversão mobile global de 5% (último trimestre de 2016) para 10%.

- Aumentar o volume de sessões entrantes de 161 mil (último trimestre de 2016) para 240 mil.

- Vender 10.000 mil licenças básicas.

- Vender 500 licenças premium.

De onde vamos tirar esses indicadores?

Aqui vai um ponto importante: para definir bons key results, que sejam mensuráveis e reflitam a situação real, é essencial que a organização seja orientada a dados e indicadores. Basicamente, a empresa deve possuir métricas de produto que assegurem uma tomada de decisão assertiva, dando a real noção de direção e esforço; e não somente baseada em intuições e experiências. Esses dados ajudam a definir as estratégias do próximo período com maior segurança e a otimizar os recursos empreendidos.

Os dados devem direcionar as seguintes questões:

- Quais desafios temos à frente? Quais indicadores estão ruins? O que devemos fazer para melhorar tal indicador? Ex: Diminuir o churn, aumentar prospects e leads, melhorar os processos operacionais etc.

- Qual frente do produto precisamos melhorar para atingir o objetivo X da organização?

- Quais riscos esses dados evidenciam e onde devemos manter a atenção?

Feita essa introdução, vamos para a dinâmica de definição dos OKRs para que você possa aplicá-la e aprimorá-la.

Parte 1 – Compreendendo o negócio

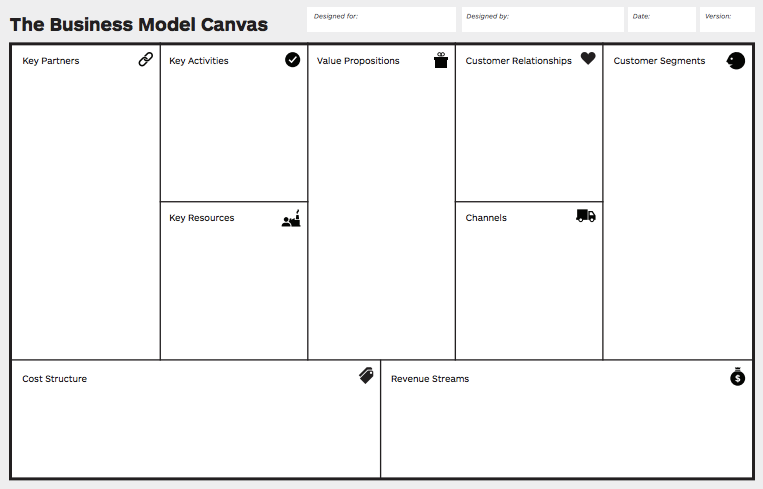

O primeiro tópico a ser discutido diz respeito a revisão ou criação do modelo de negócios do produto.

Baseado nas personas, a equipe poderá analisar os canais, formatos de relacionamento com o cliente, fontes de receita, atividades chave, recursos chave, parceiros chave e estrutura de custo.

Para levantar tais informações, sugiro que você leve as seguintes perguntas:

- Personas: qual o perfil de clientes que utilizam o produto?

- Canais: como os clientes chegam ao produto, geralmente?

- Formatos de relacionamento: como ocorre o relacionamento dos usuários com o produto atualmente?

- Fontes de receita: quais são as fontes de receita atuais?

- Atividades chave: quais as principais atividades que precisam ser realizadas no dia a dia da operação para que o produto possa entregar o valor que se propõe?

- Recursos chave: o que o produto possui de diferencial competitivo?

- Parceiros chave: quais parceiros ajudam a empresa a viabilizar/alavancar o produto?

- Custos: qual a estrutura necessária para tornar a operação do produto viável?

Assim, a equipe terá maior clareza sobre o estágio atual do produto. Caso o produto não possua um modelo de negócios, não deixe de desenvolver um. Uma dica de leitura para que você possa construir um é o livro Business Model Generation.

Após a revisão do modelo de negócio, o próximo passo será analisar as principais métricas do produto. Cada pessoa da equipe poderá explorar o produto a partir de:

- Informações financeiras: churn, ticket médio, custo de aquisição do cliente etc;

- Comportamento de acesso: número de acessos, taxa de saída, tempo despendido nas páginas do fluxo de venda, origem do tráfego, dispositivo utilizado para acessar o fluxo de venda etc;

- Perfil do cliente: dados demográficos, nível de serviço contratado, faixa etária etc.

A partir das métricas de produto, cada membro da equipe deverá identificar pontos de melhoria e pontos onde o produto aparenta estar bem.

A partir das métricas de produto, cada membro da equipe deverá identificar pontos de melhoria e pontos onde o produto aparenta estar bem.

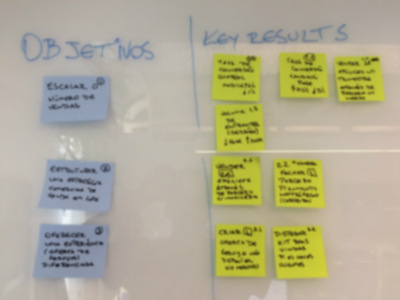

Parte 2 – Definindo os OKRs

Feita a análise das métricas de negócio e do modelo de negócio, levante com a equipe os potenciais objetivos que serão trabalhados no período de tempo (exemplo: próximo trimestre).

Se você estiver facilitando a discussão, tenha em mãos as seguintes dicas antes da equipe determinar os objetivos:

- Tenha poucos objetivos (de 3 a 4). Motivo? O trimestre, por exemplo, é curto para se assumir muitos objetivos.

- Relacione os objetivos do produto com os objetivos da empresa.

- Relacione os objetivos com problemas e necessidades reais.

- Utilize as métricas de negócio para definir os objetivos.

Caso os objetivos levantados sejam complexos ou grandes, vale a pena fomentar discussões para que a equipe simplifique. O mantra que deve ser pensado aqui é: pequenos incrementos que geram valor econômico para o negócio.

Para medir os objetivos, a equipe deverá elencar quais serão os key results que serão acompanhados ao longo do período. Para que a equipe tenha um norte:

- Defina poucos key results (de 3 à 4). Motivo? Se o objetivo precisa de muitos itens para ser medido é provável que ele seja complexo demais.

- Os key results devem ser expressos através de números.

- Quais resultados garantirão que alcancemos nossos objetivos?

Parte 3 – Definindo um roadmap

Dado que os objetivos e os key results estão definidos, a equipe pode se questionar: bom, e agora, o que vamos fazer para atingir nossos OKRs?

Sugiro como última parte da dinâmica o desenvolvimento de um roadmap, a fim de identificar entregáveis macro e quando eles deverão ser entregues ao longo do período (ex: trimestre).

Técnicas de brainstorming e story mapping ajudam a ter uma ideia de cronologia e dependência entre as possíveis funcionalidades que serão construídas para alcançar os OKRs.

Antes que alguém me crucifique dizendo que não estou sendo lean, gostaria de deixar algo claro. O roadmap criado será uma referência que COM CERTEZA (repita, C-O-M C-E-R-T-E-Z-A) sofrerá alterações ao longo do tempo por conta das mudanças e experimentações que acontecerão para atingir os objetivos e key results definidos.

Conclusão

A estrutura de OKR pode ser replicada no nível empresa, equipe e, até mesmo, indivíduo. Uma dica que sempre compartilho é: comece com poucos objetivos e trace em torno de 3 à 4 key results. O motivo? Foco. Quanto mais direcionado, mensurável e acionável for a sua estrutura de OKR, maiores serão as chances de alcançar o planejamento desenvolvido.

Lembre-se que os OKRs devem ser revistos com frequência para que o time possa tê-los sempre em mente e, juntos, decidirem onde despender esforços para caminharem na direção correta.

É essencial que a empresa possua uma cultura questionadora, desapegada de ferramentas e soluções revolucionárias e tenha um ambiente que promova aprendizado com as falhas, pois certamente haverão erros no início.

A dinâmica que apresentei teve como objetivo conectar negócio, resultados atuais e futuro (OKRs + funcionalidades).

E você, como tem aplicado dinâmicas de OKR? Compartilhe os resultados e desafios.

Até próximo dilema

Algumas referências:

Métricas para Projetos Agile

Curso gratuito em 7 e-mails, elaborado pelo autor do livro “Métricas Ágeis”, Raphael Albino.

Indicado para Agile Coach, Gerente de Produtos, Gerente de Projetos, Product Owner, Scrum Master e CTO/CIO.

Why We Argue: Style

This post originally appeared in my Chainline Newsletter.

I've been thinking about why we argue about code, and how we might transform vehement differences of opinion into active forces for good.

My thoughts spring from a very specific context. Ten or twelve times a year I go to an arbitrary business and spend three or more days teaching a course in object-oriented design. I'm an outsider, but for a few days these business let me in on their secrets.

Here's what I've noticed. In some places, folks are generally happy. Programmers get along. They feel as if they are all "in this together." At businesses like this I spend most of my time actually teaching object-oriented design.

Other places, folks are surprisingly miserable. There's a lot of discord, and the programmers have devolved into competing "camps." In these situations the course rapidly morphs away from OO Design and into wide-ranging group discussions about how to resolve deeply embedded conflicts.

Tolstoy famously said that "Happy families are all alike; every unhappy family is unhappy in its own way." This is known as the Anna Karenina Principle, and describes situations in which success depends on meeting all of a number of criteria. The only way to be happy is to succeed at every one of them. Unhappiness, unfortunately, can be achieved by any combination of failure. Thus, all happy businesses are similar, but unhappy ones appear unique in their misery.

Having now taught a fair number of classes, I've experienced various unhappy shops and am beginning to discern some common criteria for happiness. In this newsletter I'll discuss just one on them, with more to follow in future newsletters.

Today I'm interested in choices of syntax, i.e whether or not your shop has agreed upon and follows a style guide. If you're surprised that I'm starting with this apparently mundane issue, consider yourself lucky in your choice of workplace. If you're shaking your head in rueful agreement about the importance of this topic, I feel your pain.

Why Have A Style Guide?

I firmly believe that all of the code that I personally have to examine should come to me in a consistent format. Code is read many more times than it is written, which means that the ultimate cost of code is in its reading. It therefore follows that code should be optimized for readability, which in turn dictates that an application's code should all follow the same style. Adhering to a common style saves you money.

What Style Is Best?

Most programmers agree with the prior paragraph, but here's where things begin to break down. As far as I'm concerned, my personal formatting style is clearly the best. However, I'm quite sure that you feel the same. It's easy for a group of programmers to agree that all code should follow a common style, but surprisingly difficult to get them to agree on just what that common style should be.

The truth is, many stylistic choices are arbitrary, and purely a matter of personal preference. Choosing a style guide means building agreements in areas where we have strong differences of opinion about issues of little significance. It's not style that matters, but sameness of style.

Why Can't Teams Agree?

As I've already said, if you don't have a style guide, it's costing you money. However, if you can't agree on a style, the money may be least of your problems.

I have visited businesses where failure to come to agreement on this issue tore teams apart. The programmers had long since ceased verbal negotiations, choosing instead to employ change requests as an excuse to convert adjacent sections of code into their own preferred style. Code regularly flipped-flopped between competing styles. This not only made it difficult to discern actual changes in behavior, but it also infuriated the person who last touched the code the next time they looked at it.

These "style wars" are ostensibly about formatting code, but are actually about power. In mild forms, the wars create tension and cost money. In virulent forms, they poison team morale.

Don't I Deserve To Have My Own Way?

Well, no.

This is really a question of who gets to decide, and your approach to answering it lays bare the fissures in your shop. It's common to have three distinct lobbies, each with their own opinions about styling.

There's often a group of senior programmers who are convinced that they are right and that they deserve to have their own way. These folks attempt to rule by fiat, and when fiat fails, they feel empowered to ignore group agreements and employ their own stylistic preferences. After all, who's gonna fire them?

It's also common to see a group of programmers who came from another language writing Ruby in a style more suited to that other language. These programmers make choices that help them understand the code, disregarding the fact that their styling choices confound everyone else.

Finally, there are the newbies who don't yet have firm opinions about style. Because they are experimenting with all the styles, their code is characterized by inconsistency. Bless 'em, they mean well, but they're confusing everyone and need an intervention.

I've listed only three groups, but if your business has splintered in this way you're likely contending with many more variants of style. Once divisions form everyone goes their own way and you end up with as many styles as programmers. In shops like this, when I ask "Can you tell who wrote a piece of code by looking at it," everyone answers "Yes."

How Can Teams Reach Consensus?

The styling problem is actually twofold. First, everyone has to agree on a guide. Next, everyone has to follow it.

If you're in a shop with a history of conflict, it's best to outsource the guide. The community has throughly beaten the what-should-code-look-like horse; there's no reason for you to duplicate this effort. Just search for "Ruby (or language of choice) Style Guide" and choose one.

Using an external guide allows you take advantage of the wisdom of the crowd while side-stepping internal squabbles. Most guides please and disappoint in equal measure, and so require compromises from all. Choosing an external guide means it's not personal when someone doesn't get their way.

It's not enough to just select a guide--once you do so everyone must follow it. The easiest way to enforce this is to put automatic processes in place to alert folks to violations in their own code. For Ruby, have a look at RuboCop, configured however works best for you.

Avoid appointing a human "style cop", which just forces someone to be an increasingly ill-tempered nag. Instead, supply programmers with the information they need to remedy their own transgressions. By the time a pull request is submitted, mis-stylings should long since have been put right. Pull request conversations ought to be about what code does rather than how code looks.

As a personal aside, I've been experimenting with Elm. My desire to format code like intentional Elm instead of awkward Ruby led me to install an automatic Elm formatter in my editor. I initially hated the look of the auto-reformatted code, but over the last few weeks I've transitioned from active dislike to genuine fondness. Repeated exposure to standard Elm styling gradually taught me to prefer it, proving again that normal is what you're accustomed to, and that it's easier to act your way into a new way of thinking than vice versa.

What About Code That Already Exists?

Ignore it. You don't have to re-style all existing code, just do better from this day forward. Defer updating old code until you touch it for other reasons.

Following this strategy means that the code you most often work on will gradually take on a common style. It also means that some of your existing code might never get updated, but if you never look at it, who cares?

If you choose to re-style code that you otherwise have no need to touch, you're declaring that changing the look of this old code has more value to your business than delivering the next item on the backlog. The opportunity cost of making a purely aesthetic change includes losing the benefit of what you could have done instead. The rule-of-thumb is: Don't bother updating the styling of stable, existing code unless not doing so costs you money.

What If I Hate the New Style Guide?

If you disagree with the style guide upon which your team agrees, you have only two honorable options.

First, you can obey the guide despite your aversion. As with me in the Elm story above, this act is likely to change your thinking so that over time you come to prefer the new style. It's possible that if you follow the guide you'll begin to like it.

Alternatively, you can decide you will not obey the style guide. Making this decision demands that you leave your current job and find some other business whose guide matches your preferred style. Go there and follow that one.

Notice that both of these choices have you following a guide. This part is not optional.

The moral of this story? It's more important for all code to be formatted the same than it is for any one of us to get our own way. Commit to agreeing upon and following a style guide. And if you find that your team cannot come to an agreement, step away from this problem and start a discussion about power.

Best,

Sandi

News: 99 Bottles of OOP in JS, PHP, and Ruby!

The 2nd Edition of 99 Bottles of OOP has been released!

The 2nd Edition contains 3 new chapters and is about 50% longer than the 1st. Also, because 99 Bottles of OOP is about object-oriented design in general rather than any specific language, this time around we created separate books that are technically identical, but use different programming languages for the examples.

99 Bottles of OOP is currently available in Ruby, JavaScript, and PHP versions, and beer and milk beverages. It's delivered in epub, kepub, mobi and pdf formats. This results in six different books and (3x2x4) 24 possible downloads; all unique, yet still the same. One purchase gives you rights to download any or all.

How to Create a Language Hacker’s Cheat Sheet

By failing to prepare, you are preparing to fail. - Benjamin FranklinCan you feel confident during your first conversation in another language? I believe you can. Don’t get me wrong - feeling nervous is normal. But you can overcome this fear. How? A key factor is being prepared. In this post, I’m going to show you how to create a cheat sheet to help you prepare for your first conversation in a new language.

Proper Preparation Prevents Poor Performance

You’ve found a conversation partner or language tutor for your new language. And you’ve scheduled your first conversation. What’s next? It’s time to prepare. Being prepared will mean you can take full advantage of your time with your conversation partner. Preparing starts a snowball effect. When you’re prepared, you speak with more confidence. And when you speak with confidence, you’ll have a more productive conversation. Which leads to your confidence growing even more! See that positive snowball growing? With good preparation, you can have your first conversation soon after you’ve started learning a new language. Maybe even within a few hours. Will you speak perfectly? Probably not. But I’ve always found that having that first conversation early on helps me get a little more of a feel for the language and breaks some kind of invisible barrier. While it might not necessary to speak so soon, I’ve always found it to be a good way to get the ball rolling and get me excited about learning more. Besides, most of us learn a language in order to speak it, right? Well, why not get into the fun of conversation from the very beginning?Why I Use a Cheat Sheet to Prepare for Conversations in a New Language

When I’m preparing for that first conversation, I like to create a ‘cheat sheet’ I can study from to learn some basic introductory words and phrases. I do this because it means I can:- Gather all the information I need in one place

- Keep the cheat sheet on hand in case I get stuck in my conversation!

- Use the template again and again to learn the basics in any language

What Should You Learn Before Your First Conversation?

When choosing what words to learn, you need to think about the kind of conversation you want to have. If this is your first conversation in your target language, you’re likely to focus on introducing yourself and on asking introductory questions to your conversation partner. That’s the conversation we’re going prepare in this article, but obviously the techniques that I write about could be applied equally well to conversations on any subject. I’ve used the same methods to prepare for conversations about subjects as varied as food and technology, so talk about what you like talking about! So, let’s assume this is your first conversation. What’re the first things you usually talk about when you meet somebody new? Most of us talk a little bit about ourselves and ask a little bit about the other person. No matter what language you’re speaking, you’ll find yourself having some form of this conversation over and over again. So let’s consider what phrases you need to learn for this kind of conversation. Run through the conversation in your mind in English and note down what information you want to be able to share and ask for. Why not grab a pen and paper and jot some ideas down now? Here are some of the main things I always have at the top of my list:- Hello

- How are you?

- My name

- My profession

- Where I’m from

- Where I live

- My interests

- Why I’m learning [target language]

- How to ask about the other person their name, profession, nationality and interests

- This is my first conversation in …. [language].

The Must-Ask Questions for Your Cheat Sheet

Conversations are a two-way street! As well as talking about yourself, you’ll need to ask questions. Make sure that if you learn how to say something about yourself, you also learn how to ask your partner the same thing. This helps extend the conversation, and makes the conversation more like one you’d have in your native tongue. Don’t worry if you can’t remember all of the questions you need; in most languages a simple ‘and you?’ will work perfectly when you’re stuck. For example, you might say something like ‘I’m from Ireland. And you?’ This little catch-all phrase is super useful and it sounds really natural too. And in most languages it’s as simple as learning two or three little words!Your “Get Out of Jail Free” Phrases

I also like to have another section on my cheat sheet for what I call the ‘Get Out of Jail Free’ phrases! These are the phrases I use when I need to say that I don’t understand something or ask the other person to repeat a word. These phrases will get you out of tricky situations over and over again. They keep you in control of the conversation even if you can’t remember or don’t understand something. Here are some of the main ones I always learn:- How do you say …. in [target language]?

- I don’t understand

- Can you repeat that please?

- Can you speak more slowly please.

- Can you type that for me please? (If you’re talking on Skype)

Where Can You Find the Words and Phrases for Your Cheat Sheet?

Once you’ve thought about your script in English, the next step is to actually find out how to say these things in your target language! There are lots of different sources you can use and which one you choose doesn’t really matter. Just make sure you get your translations from a source you trust and that you know has been checked by native or proficient speakers of the language. For this reason, Google Translate is not something I would suggest relying on! It’s really useful as a quick tool for checking words and phrases, but it’s not something to depend too much on because the translations are provided by a computer, with contributions from users who may not always know what they’re doing. Most of us work with some kind of textbook or self-study book when we begin learning a new language, so if you have one of these it’s a great starting point for looking up these phrases. I’ve used both Teach Yourself and Colloquial books as sources for looking up words and phrases for past conversations. I know they’ve been double and triple checked by editors and native speakers so I can steal introductory phrases from them without having to worry! Another source that I use every time I’m preparing one of these cheat sheets is Omniglot. This amazing site is an online encyclopedia of languages and it has a great section on useful phrases that you can use to look up what you need. On Omniglot there are about 250 languages to choose from so you’ll almost certainly find what you need for the language you’re learning! Best of all, Omniglot also contains audio for a lot of the phrases so you can hear how they sound.

On Omniglot there are about 250 languages to choose from so you’ll almost certainly find what you need for the language you’re learning! Best of all, Omniglot also contains audio for a lot of the phrases so you can hear how they sound.

What if You Can’t Find a Phrase that You Need?

What should you do when you need to use a sentence that you can’t find in a book or on a site like Omniglot? There’s a good chance this will happen. A phrase like ‘I’m learning Russian because I’m interested in Russian history’ probably isn’t going to be in your book or on Omniglot. Every language is different, which is why you can’t just look up words and piece them together using Google Translate. This is where you need to recruit the help of a native speaker. The first thing I’ll do is look up the words I need myself and try my best to piece together a version of the sentence I want to learn. Once I’ve done this, I’ll try to get it corrected by a native speaker. There are lots of places you can get help with this, but my favourites are italki and Facebook because you normally get a quick response! On italki, just go to the ‘notebook’ section of your account and write a short entry with the phrases you want to get corrected. Normally, you’ll start to receive a couple of corrections from natives, teachers and advanced learners within a couple of hours! Facebook can also be a good option for rapid corrections. There are so many great groups for language learners and in most of them people will be very happy to help you out. Search for a group for learners/teachers of your target language and leave a short post asking if anyone can help you correct your phrases. If you’ve posted in an active group, you’ll be amazed by how many helpful people will be happy to respond! I normally start by noting down the words and phrases I want to learn in a notebook. As I add more phrases, I start to create dialogues using these phrases to help get an idea of how the conversation might go. [caption id="attachment_20224" align="aligncenter" width="1024"] My German cheat sheet, written out by hand.[/caption]

Once I’ve drawn up this ‘paper’ version, I’ll get it checked by a native speaker using the resources I discussed above. Finally, I like to create a digital cheat sheet that I can print out and keep beside me during my conversation.

[caption id="attachment_20227" align="aligncenter" width="1024"]

My German cheat sheet, written out by hand.[/caption]

Once I’ve drawn up this ‘paper’ version, I’ll get it checked by a native speaker using the resources I discussed above. Finally, I like to create a digital cheat sheet that I can print out and keep beside me during my conversation.

[caption id="attachment_20227" align="aligncenter" width="1024"] My printed cheat sheet.[/caption]

Note: I’ve included a free PDF cheat sheet template you can download at the end of this article that you can fill out in advance of your first conversation.

The reason I write out my notes on paper first is that is helps me bring extra attention to the words I’m learning and get them to stick in my memory.

It’s also very useful to write out your dialogues in advance so that you begin to get a feel for the likely structure of the conversations you’re going to have. Seeing the phrases as building blocks in the context of a conversation makes them easier to learn.

My printed cheat sheet.[/caption]

Note: I’ve included a free PDF cheat sheet template you can download at the end of this article that you can fill out in advance of your first conversation.

The reason I write out my notes on paper first is that is helps me bring extra attention to the words I’m learning and get them to stick in my memory.

It’s also very useful to write out your dialogues in advance so that you begin to get a feel for the likely structure of the conversations you’re going to have. Seeing the phrases as building blocks in the context of a conversation makes them easier to learn.

Get Your Pronunciation Right With This Simple Trick

Learning a new language doesn’t just mean learning new words and grammar. It also means learning a new sound system and sometimes even a new alphabet! Before you start memorising the words from your cheat sheet it’s essential that you know how they sound. You don’t want to waste your time learning how to say them the wrong way! If you used Omniglot to look up your phrases, you’ll be able to access audio recordings simply by clicking on the phrases on the website. But what do you do if you can’t find the audio you need there? My favourite pronunciation tool is Forvo. This amazing website is, quite simply, a pronunciation dictionary. Want to know how a word is pronounced? Just type it into Forvo and you’ll be given a list of recordings made by native speakers that you can listen to!

How to Memorise New Words and Phrases

One of the biggest challenges many of us face when learning a language is memorising new vocabulary. There are just so many new words to learn and sometimes it can seem completely overwhelming. There are so many different (and effective) approaches you can use to learn new words, but for the purposes of this post, I’m going to focus on on mnemonics. What are mnemonics? Mnemonics are words, associations or images that you use to memorise things. These images can be as simple or as complex as you like but the most important thing is that they help you remember three key elements of a word:- The word itself

- Its meaning

- Its sound.

Emperor Nero, without the bran flakes.[/caption]

The word itself and its sounds come from 3 different words or elements that I’ve included in my mnemonic: Nero, bran and vat; the meaning comes from the action that Nero is taking.

Is it a ridiculous image? Of course. But the more ridiculous and vivid your mnemonics are, the more likely you are to remember them and the words they represent. Don’t be afraid to make your mnemonics a little crude or violent - it makes them stick in your mind even more. I’ve found Looney Tunes-style cartoon violence (ACME anvils and dynamite galore!) to be particularly effective for making my mnemonics vivid.

Emperor Nero, without the bran flakes.[/caption]

The word itself and its sounds come from 3 different words or elements that I’ve included in my mnemonic: Nero, bran and vat; the meaning comes from the action that Nero is taking.

Is it a ridiculous image? Of course. But the more ridiculous and vivid your mnemonics are, the more likely you are to remember them and the words they represent. Don’t be afraid to make your mnemonics a little crude or violent - it makes them stick in your mind even more. I’ve found Looney Tunes-style cartoon violence (ACME anvils and dynamite galore!) to be particularly effective for making my mnemonics vivid.

The “Talk to Yourself” Technique for Practising Conversations

A great way to get comfortable with what you’re learning is to practise the conversations with yourself. I like to create conversations in an ‘ask and answer’ format from the material in my cheat sheet. Once I’ve written out the conversation, I’ll practise it with myself in my mind. This may sound silly but it’s actually incredibly effective! By visualising yourself having the conversation you’re not only repeating the new vocabulary, but you’re preparing yourself mentally for the conversation. If you can visualise yourself speaking confidently, you’re going to have more confidence when it comes time to have the conversation for real! You can also practise your pronunciation in advance by recording yourself on your phone. Listen to some audio of the words you want to pronounce and then recorded yourself copying these words. Doing this will not only help you pronounce words more correctly, but it will help you sound more natural too. The reason we sometimes struggle to say words correctly when we speak foreign languages is that they use a different variety of sounds to our own. As an example, this is why the French ‘R’, the uvular consonant, is difficult for English speakers. This sound doesn’t exist in our language so it takes us time to actually build up the muscle memory to be able to produce it correctly. Copying the pronunciation of native speakers and recording yourself is a good way to get used to sounds like this and iron out any major mistakes you’re making in your speech.Time to Speak! Get Ready to Use Your Cheat Sheet

Now that you have your cheat sheet ready and you know how to say the phrases on it, it’s time to schedule your first conversation. There are plenty of ways and places to do this but I generally prefer to hire a ‘community tutor’ on italki for my first few conversations. Community tutors are native speakers, normally with no formal teaching qualifications, who offer you the opportunity to speak with them and receive correction and help for a small fee. If you don’t want to pay or are not in a position to do so, you can try setting up a language exchange instead, but I do feel that working with community tutors is the best option. I have two main reason for this:- You spend all of your time speaking in your target language, whereas in an exchange you only get to practise for half of the time.

- Community tutors normally give you more feedback and correction than a language exchange partner but they’re cheaper than professional teachers.

Stop Trying to be Perfect - Communicate!

Communication is more important than perfection. Don’t get me wrong, we all want to speak as fluently and correctly as possible, but in reality languages are about communication, not perfection. In fact, I’d go as far as to argue that perfect fluency in a language doesn’t even exist. Languages are living breathing mediums that are evolving constantly. You’ve created your cheat sheet and learned the phrases you need. The next step is to simply take action and have a conversation in your target language - perfect or imperfect. After all, the only way to get better is by making a few mistakes along the way. And besides, you can always keep your cheat sheet on hand in case you get stuck! Want to create your own cheat sheet? Sign up below, and we’ll send you the Fluent in 3 Months cheat sheet template to get you started.The post How to Create a Language Hacker’s Cheat Sheet appeared first on Fluent in 3 months - Language Hacking and Travel Tips.

Java 8: Lambda ou method reference? Entenda a diferença

O Java 8 trouxe algumas novas funcionalidades e dentre elas a possibilidade de usarmos lambdas e method references. Caso ainda não esteja familiarizado com esses recursos, talvez se interesse pelo nosso post de o mínimo que você deve saber sobre Java 8. As duas features são relacionadas e nos ajudam a reduzir a quantidade de código escrito, com uma abordagem um pouco mais funcional.

Para dar um exemplo de uso de cada uma delas, vamos supor que temos uma lista de nomes e que gostaríamos de imprimir seu conteúdo. Antes do lambda e method reference, o código ficaria dessa forma:

List<String> nomes = Arrays.asList(“Lucas”, “Rodrigo”, “Paulo”);

for(String nome : nomes) {

System.out.println(nome);

}

Que nos resultaria na saída:

Lucas Rodrigo Paulo

Esse mesmo código, com uso da expressão lambda e o método default forEach, poderia ficar assim, em uma única linha:

nomes.forEach(nome -> System.out.println(nome));

E daria para fazer o mesmo com o method reference, deixando ainda mais simples:

nomes.forEach(System.out::println);

Em todos os casos teríamos a mesma saída:

Lucas Rodrigo Paulo

Mas qual a real diferença entre essas abordagens? Qual das duas versões você prefere usar no seu dia a dia?

Existe uma opção melhor para todos os casos?

Ao perceber que as features fazem coisas parecidas é normal se perguntar qual delas é a melhor. A resposta seria depende, nenhuma delas é a melhor solução para todos os casos. Entender a diferença entre elas é fundamental para saber quando é o melhor momento de usar cada uma.

Podemos usar method reference sempre?

É importante ressaltar que nem sempre é possível substituir um lambda por um method reference. Para conseguir fazer uma chamada a um method reference é necessário que a invocação de método da direita receba os mesmos parâmetros da esquerda do lambda.

No exemplo abaixo temos a nossa lista de nomes e queremos criar uma nova lista apenas com apenas as primeiras 3 letras de cada nome.

List<String> nomes = Arrays.asList(“Lucas”, “Rodrigo”, “Alura”);

List<String> nomesReduzidos = nomes

.map(nome -> nome.substring(0, 3))

.collect(Collectors.toList());

Nesse caso não seria possível usar o method reference, uma vez que para chamar o método substring seria necessário passar um parâmetro externo, os números 0 e 3, que definem o início e fim da nova string.

Vantagens de se usar Method Reference

Apesar de não poder ser usado em todos os casos onde se usa a lambda, method references possuem algumas vantagens bem legais. A primeira delas está no fato de usar menos símbolos, o que facilita bastante a legibilidade do código.

Há uma outra vantagem, que é a facilidade de se entender o que está sendo manipulado, uma vez que o tipo do objeto fica sempre muito explícito. Para exemplificarmos: suponha que temos uma classe Pessoa e essa classe possui o método getName, utilizando lambda para chamar esse método faríamos algo do tipo:

p -> p.getName()

Veja que é necessário entender qual o contexto para poder entender o que é o *p*, enquanto com method reference, teríamos algo como

Pessoa::getName

Fica bem mais fácil identificar o elemento que está sendo manipulado, percebe? Está explicito.

Outros usos do method reference

Um uso para o method reference que nem sempre é de conhecimento geral é que ele também funciona em métodos que recebem mais de um parâmetro, contanto que a quantidade seja a mesma que a de atributo do objeto que estamos usando.

Imagine que temos um mapa de alunos e sua nota, e gostaríamos de passar isso para um outro mapa.

Usando lambdas, nosso código seria:

Map<String, Integer> novoMapaDeNotas = new HashMap<String, Integer>(); notasAlunos.forEach( (nome, nota) -> novoMapaDeNotas.put(nome, nota));

Veja que o lado esquerdo do lambda recebe dois parâmetros, o nome e a nota. O lado direito também recebe esses parâmetros, nessa mesma ordem. Que tal então fazer dessa forma, com method reference:

Map<String, Integer> novoMapaDeNotas = new HashMap<String, Integer>(); notasAlunos.forEach(novoMapaDeNotas::put);

E quanto a diferença de performance?

Pensando na questão de performance o lambda faz uma chamada de método a mais do que o method reference para executar o método, e as duas abordagens resultam em bytecodes diferentes, entretanto para a maioria dos casos essa diferença não chega a afetar performance. Só precisa ser levada em consideração em sistemas críticos onde a performance é essencial, não no forEach e manipulações simples do dia a dia.

E você, já tem usado Java 8 e esses recursos em seus projetos de produção? Aqui na Caelum e Alura usamos bastante. Tem até um curso dando uma visão bem legal sobre as novidades dessa versão.

Descobri o que me incomoda com Lisp-like languages

Não são só os parênteses. É a falta de pistas sobre o significado dos elementos (fora o primeiro de todos) das listas; e também porque tudo “cresce para dentro”, criando mais níveis de aninhamento. Quer uma variável? Põe mais um let ou um destructuring-bind e indente todo o resto do código mais um nível! (estou pensando principalmente em Common Lisp porque foi um dos Lisps que eu “tentei gostar”, mesmo sabendo que não seria o mais elegante de todos).

A falta de pistas é um caso interessante. À primeira vista, a linguagem parece incrivelmente regular: tudo é uma chamada com parâmetros, assim: (chamada param1 param2 param3). Funções, macros, formas especiais (*), tudo igual.

Mas daí você vê que num (if «condição» «código if true» «código if false»), nem tudo tem o mesmo valor. Não dá para começar a ler do meio, porque o terceiro parâmetro do if só executa se a condição for falsa, e não há separador entre as três partes (uma palavrinha “else” seria bem útil). Você vê (a 1) e isso pode ser a chamada da função “a”, ou pode ser a inicialização de uma nova variável, se estiver na posição correta dentro de um “let”, “do”, etc. Isso da “posição correta” é o que complica. Em linguagens como-C (C-like), é mais fácil começar a “ler do meio”. Tem uma palavra “else”? Você está no meio de um “if”, procure-o mais acima. Abriu/fechou {chaves}? Então você está dentro de um bloco, o que em Common Lisp seria um mais ou menos um “progn”. Encontrou um “=”? É uma atribuição a uma variável existente ou a uma variável nova. Você já sabe que o lado esquerdo não terá seu valor calculado, e sim alterado. Não há como surgir uma nova variável numa chamada(normal, com, parâmetros). Encontrou um ponto-e-vírgula? Descanse e comece de novo na próxima linha (descanse = faça um flush mental do seu parser de expressões).

Para um iniciante, no caso do let e suas inúmeras variantes (let*, letrec, aliás, para que tantas?), até dá para administrar, mas em construções usadas com menos freqüência como “do” ou “handler-case” dá um desânimo: quais parênteses são agrupadores da “sintaxe” e quais são parênteses normais?

Eu preferiria que houvesse algum indicativo mais claro para elementos como:

- Nova variável. Clojure faz isso com colchetes.

- Código “normal” de tamanho indeterminado. É o chamado “progn implícito” do Common Lisp, que pode surgir a qualquer momento.

- Decisões. Num cond os blocos de código ficam muito misturados com as condições, bastaria algo como when/then para melhorar a visualização.

- Símbolos. Em Lisp existe o quote (como em: ‘a), mas como as macros têm liberdade de fazer o que quiserem, e como colocar «’» em tudo ficaria feio de qualquer jeito, o uso do quote é inconsistente. Make-instance usa nomes ‘quotados, diversas outras construções (let, setf, handler-case, destructuring-bind) não usam.

- Tipos, anotações, valores default e qualquer coisa opcional. Lisps têm a mania de usar mais um nível de parênteses sempre que for necessário adicionar algo que era opcional.

- Variável num let? Você pode usar simplesmente o nome da sua variável. Ah, você queria inicializá-la, como normalmente é o caso? Então coloque-a entre parênteses junto com o valor.

- Parâmetro de função? Basta o nome. Ah, você quer colocar um valor default? De novo: parênteses adicionais. Quer colocar um tipo num parâmetro de defmethod? Parênteses.

- Slot dentro de um defclass? Lista de nomes entre parênteses. Atributos adicionais? Então agrupe cada slot com seus atributos em mais um nível de parênteses.

E não há necessariamente nenhuma lógica na escolha do que vai ser agrupado ou não. As variáveis de um let ficam entre parênteses no primeiro argumento, e o resto é código. Nada impediria que as variáveis e o código fossem separadas por um símbolo, como “in” (ML-like). Isso evitaria vários parênteses duplos. Ou o bloco de código (o progn implícito) é que poderia ter um delimitador (como parênteses ou chaves). Os slots de uma classe ficam entre parênteses, mas poderiam ser separados do resto com uma palavra, como “slots”.

A forma handler-case ilustra diversos pontos que incomodam: o primeiro parâmetro é o código protegido (o “try” de outras linguagens). Ele não é um progn implícito (mas poderia ser, por que não?), então se quiser fazer mais de uma coisa, você precisa colocar seu próprio progn. Depois vêm os tratadores de exceção (os “catch”), cada um entre parênteses. O primeiro item de cada é o nome da condition (sem nenhum indicativo especial, é tudo posicional). Depois, entre parênteses (precisavam de um delimitador, adivinha qual escolheram?), fica o nome da variável que receberá a condition. E então você tem um espaço livre para escrever seu código tratador de exceções usando os parênteses no seu significado normal.

É assim:

(handler-case

(progn

(do-stuff)

(do-more-stuff))

(some-exception (e)

(recover se)))

Quando poderia ser:

(handler-case

:try

(do-stuff)

(do-more-stuff)

:catch some-exception :as e :do

(recover se))

No exemplo hipotético acima, os parênteses são usados apenas para chamar funções/macros, enquanto que a estrutura dentro do handler-case é marcada de outras formas. Assim some-exception não fica parecendo uma chamada de função, a variável “e” é marcada com :as (que sugere ao leitor a ideia de um nome novo) e os blocos de código são marcados com :try e :catch/:do conforme seu propósito.

Dá para fazer isso com macros, claro que dá. Mas aí fica tão diferente da linguagem, que cada programador acaba tendo seu próprio dialeto. Se eu queria uma linguagem, acabei ganhando um kit de montagem em vez de uma linguagem usável.

O único lugar onde Common Lisp se permite usar algumas palavras a mais é no loop… Na verdade todas as ideias acima foram inspiradas no loop.

(*) Peraí, formas especiais? Pois é, nem Lisp escapa da necessidade de dar valor especial a certas formas. Fico agora pensando se TCL não acaba sendo mais regular…

Learn a Language Faster: 8 Simple Language Hacks

1. Avoid Shifting Gears Between Languages

A drop of water falling on an uneven surface will follow the direction of the steepest slope. The brain does the same with languages. In the presence of two messages in two different languages, the brain focuses on the easiest one, often blocking or ignoring the second one. The brain seems to work at different speeds with different languages. Changing from one language to another implies changing speed, like shifting the gear in a car. The moment I open a textbook and begin to study, my brain changes gear, which takes a small amount of effort. If for a moment I get distracted by a written text or an audio message in my mother tongue, my brain will shift gear again - no effort needed. In other words, it is easier to “shift gears” from a more difficult language to an easier one than the opposite. Here’s the simple lesson I learned: while learning languages, don't get distracted by anything in a language different to the one you are learning. This is more difficult at a beginner’s level, because you might need an explanation in a language you can understand, or you might need to check the dictionary. But I always try to create, as much as possible, an environment without distractions in other languages. Try it for yourself. Which language are you learning? French? Find a free day in your schedule. Try (as much as possible) not to read, listen or even say anything in a language other than French. From early in the morning (or even from the previous night) listen only to music in French, read the news (even if you understand just a bit) in that tongue, and make the effort to think, with simple phrases, in French. If you want, you can be more radical with this. Remove all material from your desk that is not in French, and set your computer and your phone to French, so when you sit down to study, there are no "slopes" that will change the gears of your brain to non-learning mode, even if it is just for some seconds. Try this, even for half a day, and you will notice the difference.2. Plan Exhaustion Into Your Study Goals

We’ve all had the experience of making a clear and decisive resolution: I will exercise twice a week, I will not lose my temper at the office, I will study Japanese every day. After a beginning full of energy and determination, our motivation fades out and we find ourselves in the same situation: no exercise, losing our temper and not studying Japanese. The problem might be bad planning, unrealistic goals or lack of motivation. But there is another aspect we can take into consideration: often we make plans and take decisions for the times in which we will have a lot of energy. Why not plan instead for those moments in which we will be exhausted? It is good to ask yourself: how do I rest? Walking in the forest? Reading novels? Listening to music? Watching sports? Doing handicrafts? Painting? Take your preferred way of relaxing, and add an element of your target language. Like walking in the park? What about listening a language podcast while you walk? Enjoy reading novels? Look for a book adapted to your level. Love listening to music? Have you tried learning a song in your target language? Is watching sports your thing? Then watch the same sports matches you usually would, but listen to commentary in your target language. If this isn’t possible, then look for sports you can watch with commentary in your target language. Is your favourite “hobby” spending time with friends? Then make a new friend interested in learning the same language as you. Learn together. Still stuck for ideas? Then listen to the radio, music or news while doing other things, even if you only understand ten percent of the content. At the beginning, these new ways of relaxing will feel unfamiliar - perhaps even difficult. You will need time to adapt, but after a while it will be as effortless as the way you used to rest before. And most importantly, your brain will work by itself without you noticing, and will store information that it will bring up again when needed. You might ask: isn’t it more effective to study with intensity, order and attention? This question is a trap. I am not saying that you should only study in ways that allow you to rest, but there are many moments in which this is the only way you can study. Make the most of your rest time!3. Before You Take Your First Step, Decide Where You Want to Go

What is my "level" in my mother tongue? Most probably I would say that it’s at least "advanced", or "native". But that is hardly a real description. Am I able to write a contract in precise legal terms? Do I understand the slang of my language from different countries or cities, or even age groups? Am I able to explain the intricacies of grammar to a foreigner? Each one of these abilities could be a goal to attain in my own language. In the same way, each time I decide that I will start (or continue) learning a language, besides finding a reason to learn the language, I need to set clear goals. Not only dreams, but clear specific goals, including the time and resources I am willing to spend on learning a new language. For example, it might be that I am learning Russian because I enjoy studying "something", and it happened that I found a Russian textbook at home. In this case my objective is to enjoy the act of studying. It is a valid objective and studying Russian is just a means to attain that goal. Perhaps I sing in a choir that sometimes performs songs with French, Italian and Latin lyrics. I would like to understand a bit of these three languages to make the singing more meaningful. In that case what I need is good pronunciation, together with some basic ideas about grammar and vocabulary. We can imagine a more demanding situation: I want to apply for a scholarship that requires a certain level in Japanese, or my boss just told me that in order to get promoted I need to be fluent (whatever that means) in Finnish. It is then necessary to set clear goals. Here are some examples of goals:- Within one month acquire vocabulary concerning seafood products.

- By 10th August be able to read in a loud voice fluently, without stammering, and clearly, even if I don't understand what I read.

- At the end of the year understand what the evening news is about in my target language.

- In three weeks decide what kind of materials I need to begin learning a language.

- Pass the intermediate level test in Quenya as a Foreign Language in February.

- Survive my trip to Inner Mongolia.

- Teach a university course in French next September.

4. Create Your Own Learning Activities

For some strange reason still unknown to me, at the language schools I’ve come across they always want to teach many different things, but very rarely do they want to teach you how to learn. In a restaurant this approach would make sense; we go to a restaurant to eat, not to learn to cook. In language learning, it does not make sense. From my experience of many failures (which led to later successes), one of the most useful things you can do is develop personal learning activities. This is especially necessary when you get beyond the basic level in a new language. Creating personal learning activities means you examine yourself and your progress (instead of the school examining you), and find direction in your study that’s relevant to you and your goals. How can you examine yourself? On a regular basis, ask yourself:- What is my weak point now?

- Which area do I want to strengthen now?

- In which field do I need to acquire vocabulary?

- Where do I commit more mistakes?

- What am I afraid of?

- Going to a shopping centre and trying to buy 101 different things, even if at the end I didn't buy anything. (Don't make the vendors waste much time.)

- Listening to music while reading the lyrics and singing aloud. Then singing without reading the lyrics.

- Creating a database of phrases and vocabulary from a novel, and reviewing the list using a free flashcards app.

- Reading an article every day in my target language, and talking about it at lunch with friends or colleagues. This worked much better when they didn't know I was doing it as a language learning activity.

- Keeping a diary in my target language. One or two phrases a day.

5. Love Mistakes and Laugh at Yourself

I was supposed to teach at the university. I had to pretend that I was able to teach an entire semester in the language in which I had failed so many times. I knew my pronunciation was just terrible and I had not mastered the vocabulary. So, I found myself in front of a classroom with almost one hundred students who were surprised to see that their new teacher was a foreigner hiding under a local name. I was so nervous that I had diarrhea that day, but that is another story. I tried to calm myself and began to speak. I greeted the students and thanked them for joining my class, but after some seconds a question came to my mind: "What are you doing here? This is ridiculous." Suddenly I got nervous again, blushed and started to sweat profusely. I survived the semester without using a single word in English (or any other language besides Chinese). Every week I had to give birth to a new lecture. It was both a very tiring and enriching experience. Did I perform well? Of course not. One year after the end of the semester I had dinner with one of the students, who is now a very good friend. He told me, laughing, that he didn't understand much of what I had said during class the year before. I loved that! It was another fantastic failure diploma, and coming from a friend it was a real treasure. I enjoy my classes. I don't know if the students always do, but I do. One of the things I like is that we laugh at my mistakes. Often I mispronounce words, I forget terms, or forget the right stroke of a Chinese character. Sometimes my students cannot understand my questions, or I cannot understand their answers to my questions. Often they just smile, sometimes they laugh, they imitate my tones, they try to correct me on the spot. There is only one way to survive, and that is to learn how to enjoy failure. This has many advantages. First, we laugh, and it is good to laugh. Second, because I visibly enjoy failure, my students are not ashamed to correct me. Third, I no longer feel afraid of making mistakes. There is a moment in which it’s particularly useful to laugh at yourself: on really bad days. We are not machines, we are not computers. In theory, once an app is installed on a phone it will work in spite of the weather and the day of the week. Human beings are not like that. It might happen that, for unknown reasons your Spanish is less fluent on Mondays. Don't get frustrated. Smile! Even if you make hundreds of embarrassing mistakes in one day, your friends are still your friends.6. Love Silence

Love silence, speak less. I know this sounds like poor advice. And I profoundly believe in the standard methods of language learning: listen more, speak more, read more, write more. Yes, and at the same time: love silence, and speak less. Love silence. After each failure (grammatical mistake, wrong pronunciation), big or small, don't ignore it so as not to lose motivation. Instead, stop, in silence, and ask yourself: what went wrong? What can I learn from this? Even better, write down your mistakes. Which important word were you not able to say? Loving silence, interior silence, enables you to be a better listener. I have seen trillions of learners who attain an intermediate level but don't progress any further. Even if they are often corrected by others, they don't notice it because they are too busy listening to themselves. Loving silence also enables you to think a microsecond before speaking. For some language learners who love talking, it is difficult to turn long, rich, complex phrases in their mother tongue as they appear in their brains, into the simple, poor, ugly phrases in the language they are learning, but it is necessary to pass through that step. I might want to say "Whether 'tis nobler in the mind to suffer the slings and arrows of outrageous fortune, Or to take arms against a sea of troubles, and by opposing end them." But if I want to translate that into the language I am just learning, I will fail. I need to learn to stop a bit, and turn that into something much simpler, like this: "I am tired. Should I sleep or work?"7. Don't Forget Memorisation

Memorisation has bad press. We have heard many times that good education, including language learning, is about understanding, creativity, practising, or many other things, but it’s certainly not about memorisation, as it was in the past, in the dark, oppressive, terrible past. Memorisation is the ugly duckling of learning. It’s boring, takes so much time, and so often is useless. These characterizations are partly true, but I would still say "train your memory". Then you might discover that memory is a fantastic realm to be explored. One of the best ways to train your memory is through image association. This technique has been used for millennia and is about far more than simply improving your memory. I would go as far as to say that it’s a way of living, of seeing reality, of "reading" the world around us. Image association not only helps you memorise and recall isolated facts. It helps you develop various habits of the senses and the imagination that reshape your brain. After you’ve entered into this realm of memory training, you’ll find that the way you learn is completely different and far more effective. You’ll also have little patience for phrases such as "I have bad memory". Because these techniques are about a new way of seeing the world, they take time to learn, and cannot be applied immediately. The time you invest will be repaid with a high interest rate.8. Master the Art of Language Exchange

"We are here in front of a cup of coffee for the first time, ready to help each other to learn a language. Now what?" This is a common scenario in the first session of a language exchange. How do you get past this awkward stage? After finding a language exchange partner, one of the first things I do is to establish a common goal. If we don't have a common vision, the language exchange will hardly work. In my case, language exchange partners come from two sources: friends-of-friends and websites. When you find people on websites, check out their profile to see why they want to learn a language. A person might write that he or she is interested in meeting new people, romance, or cultural experience. I avoid people who want these things. Instead, I search for people who want to learn a language, because that’s my focus. Also, I never contact anyone who wants to learn ten languages, because most probably they lack real motivation, and might not persevere. For reasons unknown to me, for the first session of face-to-face language exchanges, almost all my exchange partners choose a place more expensive than what their budget would allow for a habitual meeting. I almost always begin with: "let's go to a cheaper place." After we order a cup of coffee or dinner, I introduce myself and explicitly say that my focus is to learn a language. I let my exchange partner know that I have strong motivation, and that I have some experience teaching and learning. I also explain what I expect from them ("Don't worry if you don't have experience", "It's ok if you aren’t a grammar superhero", "If after some weeks you don't want to continue, just say it", etc.). Finally, I outline the rules of the game (one hour for your language, one hour for my language, frequency and time, etc.). I have been doing language exchanges for years. Other people might have different experiences, but in my case they evolve in one of two directions:- After a few meetings we both realise that we are not going anywhere and the exchange naturally dies.

- We meet for a long time, end up being friends, and after a while we don't care much about language.

What are Your Top Language Tips?

As I write these paragraphs, I’ve just moved to a new country. I want to be fluent in three months in the local language, but everything seems to be against this goal: I live surrounded by English, I don't have much time, and the language seems to be more difficult to me than Mandarin was when I began with it. Strictly speaking I don't need it as much as I needed Chinese few years ago. Will my "eight secrets" work? Any advice?The post Learn a Language Faster: 8 Simple Language Hacks appeared first on Fluent in 3 months - Language Hacking and Travel Tips.

Synchronous communication for microservices: current status and learnings

Since we started breaking our monolith and introduced a microservices architecture we rely a lot on synchronous request-response style communication. In this blog post we’ll go over our current status and some of the lessons we learned.

Finagle and jvmkit

Most of our microservices are built on top of Finagle and are written in Scala. Finagle is a highly extensible and protocol agnostic RPC framework developed by Twitter.

Finagle clients and servers use non blocking I/O on top of Netty. Non blocking I/O improves our scalability since we have a lot of scatter-gather style microservices or microservices that are I/O bound on external resources like databases.

Finagle is also highly configurable and extensible which means we can tailor it to work well with our infrastructure.

To make it easy for developers to build microservices that play nicely with the SoundCloud infrastructure and conventions we have an internal library called jvmkit which is maintained by our Core Services team. Some of the functionality jvmkit provides:

- Wrappers around Finagle HTTP, memcached and MySQL with reasonable default configurations and integration with Prometheus

- DNS based service discovery implementation

- HTTP request routing on top of Finagle

- JSON parsing support for request / response entities

- Logging support according to our standards

- API support for rollout our feature toggle system

Teams are responsible from development till running their microservices in production so they can decide not to use jvmkit as long as they stick to our standard protocol. In practice however most of our microservices do use jvmkit. By using jvmkit teams have more time to focus on delivering business features.

HTTP/1.1 + JSON

Almost all our services use HTTP/1.1 + JSON for communication.

The advantage of HTTP + JSON is that it is supported everywhere so we don’t lock ourselves into a specific technology or programming language.

There is very good tooling support for HTTP + JSON which makes it easy to debug and interact with our services.

The HTTP method indicates useful properties of requests. It indicates if a request is idempotent and safe (read-only). These properties tell us if requests can be safely retried or cached. We found this useful when replaying requests to test new revisions of a service. Indication of these properties are missing from other protocols we looked into.

Of course HTTP + JSON results in more overhead compared to other more optimized protocols. We have some services using Finagle ThriftMux and have thought about making ThriftMux the recommended protocol but we stepped away from that idea. ThriftMux is not ubiquitous and would lock us into Finagle if we want to get all the benefits.

Client side service discovery and load balancing

When we started using microservices we used separate load balancer processes as entry points for our services. With the increase in traffic we ran into failing load balancer processes which caused several outages. Our load balancers were single points of failure.

These outages made us move to client side service discovery and load balancing. We wrote a Java service discovery implementation that queries DNS SRV records to get the instances for a given service. Writing it in Java means it can be integrated in any JVM based language and framework that supports Service Discovery. We obviously integrated it in Finagle by using the Finagle Resolver api. Having support in Finagle means we have client side service discovery and load balancing support for HTTP, ThriftMux, MySQL and memcached.

Resilience against failures

When investigating the root cause of some of our outages we realized that we had to invest more in improving our resilience against failures. It quickly showed how important it is to use a mature library or system like Finagle which is already equipped with important features like:

- Timeouts: every request across the network needs realistic timeouts. This protects you from issues with the systems you depend on.

- Transport and application level Circuit Breakers: supports ignoring hosts that become unavailable or unhealthy with automatic recovery when they become healthy again. It protects you from issues with systems you depend on and allows them to recover.

- Conditional retries: retrying can be effective but you shouldn’t retry unconditionally as this can result in retry storms that can overload the systems you depend on. Retry budgets allow you to configure a percentage of requests that can be retried on top of a minimum number within a time frame.

- Limiting concurrent requests: If you know the capacity your service can handle you can protect it from overload by limiting the maximum number of concurrent requests and waiters (queue size).

Using and configuring these features have allowed us to better deal with failures which are inevitable in a distributed system like a microservices architecture.

We also introduced automated integration tests for jvmkit which show and document how our systems will react to failures. These tests also notify us about potential behavioural changes when upgrading Finagle.

No more client libraries

When we started implementing microservices teams who implemented a service typically also provided a client library that could be used by other teams to access their service. Those client libraries were implemented in the same programming language as the service and were hiding network communication and serializing / deserializing of requests and responses behind an easy to use api. The idea was that the code to access a service only needed to be written once and could be re-used by many.

After a while we noticed the client libraries approach also brings a lot of disadvantages:

- A client library brings in dependencies. It might bring in a HTTP library, JSON parsing library etc. This might result in conflicts with the libraries already used by your service. If you depend on more than 1 client library this problem only increases resulting in unnecessary dependencies and conflicts between teams.

- A client library might become bloated with custom logic. Using the client library might be the only way to successfully use the service and prevents it from being used by applications using other technologies. This imposes the use of a programming language and technology on other teams.

- A client library can have default error handling logic which is probably not a good fit for all use cases. Users of a service should be aware of the error scenario’s that can happen and act upon them in the best way for their use case.

- A client library will likely parse all returned fields of a response even if the client is only interested in a subset. This not only might have performance implications but also violates the tolerant reader principle.

We think these disadvantages far outweigh the benefits. The use of client libraries results in increased coupling and dependencies. Instead of publishing clients we encourage teams to publish their API’s. Consumers write their own clients in a way they find most appropriate using their technology of choice.

What’s next?

We hope to introduce Consumer Driven Contract tests soon. These tests will catch breaking changes between services and consumers during build time. Some teams are currently working on proof of concepts and are building out and validating the process.

A logical step for us would be to move from HTTP/1.1 to HTTP/2 as our default protocol. This would improve latency while sticking with a widely supported protocol without technology or programming language lock-in.

We might also replace JSON with a more efficient serialization protocol like protocol buffers. This would further improve performance and should result in less handwritten serialization and deserialization code but this still needs more experimentation and investigation.

Key points to consider when doing a software rewrite

As well as a big software refactor, a rewrite is not a simple thing either. After many years, we have gotten experience enough to point what you had better consider when planning and executing a rewrite process.

Will the two platforms live together for some time or not?

Are you planning to maintain the legacy and the new version in production? If so, for how long? You should avoid maintaining two versions in production for too long because of opportunity and operating costs.

Who will work on the rewrite and who will work on the legacy version?

Developers usually prefer to work on green field projects. You should take that into account when planning who will maintain the legacy version and who will work on the new one.

It’s not viable to rewrite every single feature at once

It’s not viable to have a 1 to 1 feature mapping between the legacy version and the new one. That said, what features should you start rewriting?

Take into account how current clients will be impacted by a product with fewer features.

A rewrite will slow down or stop the launch of new features in the legacy version

Chances are you won’t launch new features for the legacy version during the rewrite process. Not only will end-users not get new features, but neither will internal clients (commercial and product departments). Your internal clients and stakeholders will pressure you to deliver new features.

Make sure that the communication before and during the rewrite is clear, and that every stakeholder is aligned with the end goals.

Keep it secret or public?

Imagine you are a potential customer of a software product. You’re planning to buy it, but you just found out that a completely new version will be launched in three months. Would you buy the legacy version or wait for three months? Multiply that by dozens or hundreds of potential buyers. The provider could lose a lot of money.

That’s why if you’re the provider, you should think carefully about how and when you’re going to publicize the launch of a brand new version.

Data migration

A rewrite process is not just shipping features. You also need to plan the data migration. People usually underestimate the complexity and effort needed to migrate data from the legacy version to the new version. That activity should not be just one task on your board called “data migration.”

For example, imagine that you need to migrate your users’ accounts. If your legacy version is managed by a third-party, chances are you won’t have access to the users’ encrypted passwords, so you won’t be able to migrate them. You’ll have to ask every single user to reset their passwords in the new version. That’s part of the data migration process, too.

Prepare for a possible decrease in conversion rates

You’ll launch a new version with fewer features. Who guarantees that the conversion rates will stay the same? Conversion rates are vital in some domains, like in e-commerce.

Ideally, you should be able to keep both the legacy and the new version running for a while so that you have a backup plan in case there’s a huge decrease in conversion rates.

Plan time to train internal users

This is another overlooked subject. The rewrite plan needs to have a phase of internal user training before taking your new product to production. Don’t underestimate that, either. It can take a long time since your internal users will give you feedback about stuff that might need to be changed.

Internal users can be found in a variety of areas, such as help desk and inside sales.

What about you? Do you have any more tips on what to worry about when doing a rewrite? Share with us!

Posts of the Low Internal Software Quality series

- The Symptoms of Low Internal Software Quality

- Key points to consider when doing a big software refactoring

- Key points to consider when doing a software rewrite

Escola sem partido

Nem Ustra, nem Marighella

Sticky Footer, Five Ways

A brief history, if you will.

The purpose of a sticky footer is that it "sticks" to the bottom of the browser window. But not always, if there is enough content on the page to push the footer lower, it still does that. But if the content on the page is short, a sticky footer will still hang to the bottom of the browser window.

There is negative bottom margins on wrappers

There was a wrapping element that held everything except the footer. It had a negative margin equal to the height of the footer. That was the basis of this one.

<body>

<div class="wrapper">

content

<div class="push"></div>

</div>

<footer class="footer"></footer>

</body>html, body {

height: 100%;

margin: 0;

}

.wrapper {

min-height: 100%;

/* Equal to height of footer */

/* But also accounting for potential margin-bottom of last child */

margin-bottom: -50px;

}

.footer,

.push {

height: 50px;

}See the Pen Sticky Footer with calc(); by Chris Coyier (@chriscoyier) on CodePen.

This one required an extra element inside the content area (the ".push"), to ensure that the negative margin didn't pull the footer up and cover any content. The push was also clever because it very likely didn't have any bottom margin of it's own. If it did, that would have to be factored into the negative margins, and having those two numbers not in sync doesn't look quite as nice.

There is negative top margins on footers