Shared posts

Sánchez traslada el apoyo de España a la «propuesta» de Biden para que haya un alto el fuego en Gaza y acabe la guerra

Las «cloacas» privadas de Iglesias

Flaco favor han hecho el PSOE y Podemos a Pablo Iglesias al calificar como «asunto privado» su relación con el caso Dina Bousselham. Al describirlo de esta manera, ambos partidos han conseguido que el vicepresidente segundo no comparezca en el Congreso, pero, al mismo tiempo, lo han dejado sin la coartada de las «cloacas del Estado». O es privado o no lo es. O pertenece al ámbito de las relaciones personales de Iglesias o está sometido a la conspiración policiaca de turno. Y es cierto que se trata de un asunto privado, lo que no quiere decir que no sea turbio, colindante con varios delitos y progresivamente lesivo para el crédito que debe conservar un vicepresidente de Gobierno. También era privado, y totalmente legítimo, el litigio de Màxim Huerta con Hacienda y le costó el cargo de ministro de Cultura. También era privado el asunto del máster dudoso de Carmen Montón y tuvo que dejar el departamento de Sanidad. Iglesias tiene la bula de Sánchez y con eso basta para privilegiar al líder de Podemos con una impunidad política digna de la mejor casta.

El caso «privado» de Iglesias está en la mesa de un juez que ha retirado al vicepresidente segundo la condición de «víctima», porque no hubo robo alguno de teléfono. Y aquí empieza ya la sombra de una mentira en sede judicial, lo que hace del caso Iglesias un asunto un poco menos privado. Si, además, Iglesias revisó el contenido fotográfico íntimo guardado en la tarjeta de su excolaboradora, el asunto será privado, pero tiene una evidente trascendencia pública. Por eso, los letrados del Congreso no veían problema legal en que Iglesias compareciera, porque la vida privada de un miembro del Gobierno, cuando se oscurece tanto, afecta también a su dignidad como cargo público. Otra cosa es que Iglesias quiera para sí la inviolabilidad que niega a Don Juan Carlos, a quien sí quiso someter a investigación parlamentaria. Iglesias se está perdiendo en sus cloacas privadas.

Flaco favor han hecho el PSOE y Podemos a Pablo Iglesias al calificar como «asunto privado» su relación con el caso Dina Bousselham. Al describirlo de esta manera, ambos partidos han conseguido que el vicepresidente segundo no comparezca en el Congreso, pero, al mismo tiempo, lo han dejado sin la coartada de las «cloacas del Estado». O es privado o no lo es. O pertenece al ámbito de las relaciones personales de Iglesias o está sometido a la conspiración policiaca de turno. Y es cierto que se trata de un asunto privado, lo que no quiere decir que no sea turbio, colindante con varios delitos y progresivamente lesivo para el crédito que debe conservar un vicepresidente de Gobierno. También era privado, y totalmente legítimo, el litigio de Màxim Huerta con Hacienda y le costó el cargo de ministro de Cultura. También era privado el asunto del máster dudoso de Carmen Montón y tuvo que dejar el departamento de Sanidad. Iglesias tiene la bula de Sánchez y con eso basta para privilegiar al líder de Podemos con una impunidad política digna de la mejor casta.

El caso «privado» de Iglesias está en la mesa de un juez que ha retirado al vicepresidente segundo la condición de «víctima», porque no hubo robo alguno de teléfono. Y aquí empieza ya la sombra de una mentira en sede judicial, lo que hace del caso Iglesias un asunto un poco menos privado. Si, además, Iglesias revisó el contenido fotográfico íntimo guardado en la tarjeta de su excolaboradora, el asunto será privado, pero tiene una evidente trascendencia pública. Por eso, los letrados del Congreso no veían problema legal en que Iglesias compareciera, porque la vida privada de un miembro del Gobierno, cuando se oscurece tanto, afecta también a su dignidad como cargo público. Otra cosa es que Iglesias quiera para sí la inviolabilidad que niega a Don Juan Carlos, a quien sí quiso someter a investigación parlamentaria. Iglesias se está perdiendo en sus cloacas privadas.

El TJUE sentencia que se deben devolver los gastos de hipotecas vinculados a cláusulas abusivas

Las cantidades pagadas en concepto de gastos de hipoteca a raíz de una cláusula declarada abusiva deben ser devueltos al consumidor salvo que el derecho nacional disponga lo contrario, según una sentencia del Tribunal de Justicia de la Unión Europea (TJUE) dictada este jueves.

Según la Corte, si se declara nula una cláusula abusiva que impone al cliente el pago de todos los gastos de constitución y cancelación de una hipoteca, el Derecho comunitario se opone a que el juez nacional niegue al consumidor la devolución de las cantidades abonadas en virtud de esa cláusula.

Para el tribunal con sede en Luxemburgo, eso es así salvo que las disposiciones de Derecho nacional aplicables impongan al consumidor el pago de la totalidad o de una parte de esos gastos

Las cantidades pagadas en concepto de gastos de hipoteca a raíz de una cláusula declarada abusiva deben ser devueltos al consumidor salvo que el derecho nacional disponga lo contrario, según una sentencia del Tribunal de Justicia de la Unión Europea (TJUE) dictada este jueves.

Según la Corte, si se declara nula una cláusula abusiva que impone al cliente el pago de todos los gastos de constitución y cancelación de una hipoteca, el Derecho comunitario se opone a que el juez nacional niegue al consumidor la devolución de las cantidades abonadas en virtud de esa cláusula.

Para el tribunal con sede en Luxemburgo, eso es así salvo que las disposiciones de Derecho nacional aplicables impongan al consumidor el pago de la totalidad o de una parte de esos gastos

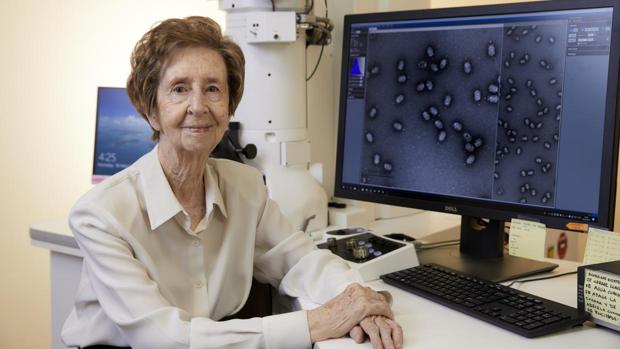

Muere la bioquímica Margarita Salas, la discípula de Severo Ochoa

La bioquímica Margarita Salas (Asturias, 1938), una de las científicas más destacadas en su campo a nivel internacional, ha fallecido este jueves a los 80 años en Madrid, tal y como ha confirmado el CSIC en un comunicado. Suya es la patente de la ADN polimerasa Phi29, una enzima muy importante por su capacidad para producir copias genéticas de forma precisa partiendo de rastros escasos, como por ejemplo, una simple gota de sangre. Este descubrimiento fue pionero y básico en la replicación del ADN, y supuso toda una revolución no solo en el ámbito científico, sino también en otros como el de la medicina forense.

Salas, profesora honoraria del Centro de Biología Molecular Severo Ochoa hasta ahora, ha sido la primera en presidir el Instituto de España, la primera española en ingresar en la Academia de las Ciencias de EEUU y la primera científica en entrar en la Real Academia Española de la Lengua, por citar sólo algunos de sus logros. Además, fue la primera mujer en recibir la medalla Echegaray, otorgada por la Real Academia de Ciencias Exactas, Físicas y Naturales. El último premio lo recibió hace apenas unos meses, en junio. La Oficina de Europea de Patentes reconocía a Salas en la categoría de «Logros a toda una vida», así como el jurado popular, que también la elegía como la mejor inventora de 2019.

«Se pensaba que no estábamos capacitadas. A mí se me discriminaba por ser mujer, no se me tenía en cuenta, era invisible… Ahora se habla de techos de cristal, pero entonces ni siquiera se contemplaba un techo», comentaba a ABC en una entrevista a raíz de aquel doble premio hablando sobre el papel de la mujer en la ciencia.

La discípula de Severo Ochoa

Nacida en Canero, Asturias, su padre, médico de profesión, alentó su pasión por las ciencias. A los dieciséis años se trasladó a Madrid para realizar las pruebas de acceso de Química y Medicina, ingresando en la facultad de Químicas. El verano de 1958 conoce a Severo Ochoa, quien tendrá influencia en su carrera y la orienta hacia la bioquímica. bajo su batuta realizará el mayor logro de su carrera, la amplificación del ADN.

«Margarita Salas es una pionera en el campo de la genética molecular y una referente para todas las mujeres en la ciencia», afirmó durante en la entrega del premio el presidente de la Oficina Europea de Patentes, Antonio Campinos, quien le otorgó el premio a toda una vida. «Su trabajo ha puesto la secuenciación de ADN al alcance de muchos más investigadores y científicos, y ha allanado el camino para nuevos avances en genética», agregó.

La bioquímica Margarita Salas (Asturias, 1938), una de las científicas más destacadas en su campo a nivel internacional, ha fallecido este jueves a los 80 años en Madrid, tal y como ha confirmado el CSIC en un comunicado. Suya es la patente de la ADN polimerasa Phi29, una enzima muy importante por su capacidad para producir copias genéticas de forma precisa partiendo de rastros escasos, como por ejemplo, una simple gota de sangre. Este descubrimiento fue pionero y básico en la replicación del ADN, y supuso toda una revolución no solo en el ámbito científico, sino también en otros como el de la medicina forense.

Salas, profesora honoraria del Centro de Biología Molecular Severo Ochoa hasta ahora, ha sido la primera en presidir el Instituto de España, la primera española en ingresar en la Academia de las Ciencias de EEUU y la primera científica en entrar en la Real Academia Española de la Lengua, por citar sólo algunos de sus logros. Además, fue la primera mujer en recibir la medalla Echegaray, otorgada por la Real Academia de Ciencias Exactas, Físicas y Naturales. El último premio lo recibió hace apenas unos meses, en junio. La Oficina de Europea de Patentes reconocía a Salas en la categoría de «Logros a toda una vida», así como el jurado popular, que también la elegía como la mejor inventora de 2019.

«Se pensaba que no estábamos capacitadas. A mí se me discriminaba por ser mujer, no se me tenía en cuenta, era invisible… Ahora se habla de techos de cristal, pero entonces ni siquiera se contemplaba un techo», comentaba a ABC en una entrevista a raíz de aquel doble premio hablando sobre el papel de la mujer en la ciencia.

La discípula de Severo Ochoa

Nacida en Canero, Asturias, su padre, médico de profesión, alentó su pasión por las ciencias. A los dieciséis años se trasladó a Madrid para realizar las pruebas de acceso de Química y Medicina, ingresando en la facultad de Químicas. El verano de 1958 conoce a Severo Ochoa, quien tendrá influencia en su carrera y la orienta hacia la bioquímica. bajo su batuta realizará el mayor logro de su carrera, la amplificación del ADN.

«Margarita Salas es una pionera en el campo de la genética molecular y una referente para todas las mujeres en la ciencia», afirmó durante en la entrega del premio el presidente de la Oficina Europea de Patentes, Antonio Campinos, quien le otorgó el premio a toda una vida. «Su trabajo ha puesto la secuenciación de ADN al alcance de muchos más investigadores y científicos, y ha allanado el camino para nuevos avances en genética», agregó.

Más de 1.000 bomberos luchan contra tres incendios en el centro de Portugal

Tres incendios forestales en el centro de Portugal han movilizado este domingo a 1.000 bomberos. Las autoridades han tenido que evacuar parcialmente una aldea como precaución, según ha indicado Protección Civil, quien ha informado de que siete bomberos han resultado heridos y una persona ha tenido que ser trasladada en helicóptero a un hospital de Lisboa con quemaduras de primer y segundo grado.

Una mujer estadounidense recibe una factura de la luz de 284.000 millones de dólares

Una mujer recibió una factura de electricidad por la desorbitada cantidad de 284.000 millones de dólares por el consumo de energía en su casa en Estados Unidos durante un mes, según informaron este martes medios locales.

Mary Horomanski, residente en el estado de Pensilvania, quedó impactada cuando abrió el sobre de la factura mensual por el consumo eléctrico y leyó la cantidad en cuestión: 284.460 millones de dólares.

Ese importe debía ser abonado antes de noviembre de 2018, aunque el primer pago a realizar no podía ser menor de 28.176 dólares, atendiendo a las instrucciones facilitadas en el recibo por parte de la compañía.

«Cuando lo leí, pensé 'bueno, al menos tenemos un año para conseguir esta cantidad multimillonaria», afirmó Horomanski en declaraciones a The Washington Post.

La mujer, de 58 años, optó por comprobar la enorme cuantía a través de internet, pero tampoco era diferente por lo que la afectada acudió a uno de sus hijos.

Este contactó con la compañía suministradora de energía, que rápidamente le informó del error ocurrido porque se habían equivocado con la puntuación al situar mal las comas, por lo que la deuda quedaba reducida de forma sustancial hasta 284,46 dólares.

Una mujer recibió una factura de electricidad por la desorbitada cantidad de 284.000 millones de dólares por el consumo de energía en su casa en Estados Unidos durante un mes, según informaron este martes medios locales.

Mary Horomanski, residente en el estado de Pensilvania, quedó impactada cuando abrió el sobre de la factura mensual por el consumo eléctrico y leyó la cantidad en cuestión: 284.460 millones de dólares.

Ese importe debía ser abonado antes de noviembre de 2018, aunque el primer pago a realizar no podía ser menor de 28.176 dólares, atendiendo a las instrucciones facilitadas en el recibo por parte de la compañía.

«Cuando lo leí, pensé 'bueno, al menos tenemos un año para conseguir esta cantidad multimillonaria», afirmó Horomanski en declaraciones a The Washington Post.

La mujer, de 58 años, optó por comprobar la enorme cuantía a través de internet, pero tampoco era diferente por lo que la afectada acudió a uno de sus hijos.

Este contactó con la compañía suministradora de energía, que rápidamente le informó del error ocurrido porque se habían equivocado con la puntuación al situar mal las comas, por lo que la deuda quedaba reducida de forma sustancial hasta 284,46 dólares.

«El secreto de Marrowbone»: ¿De qué huye la familia Marrowbone?

Jack, Billy, Jane y Sam son los cuatro hermanos Marrowbone que componen, junto a su madre, la familia protagonista de la primera película del cineasta Sergio G. Sánchez (guionista habitual de las películas de J. A. Bayona). En el clip que ABC Play ofrece en exclusiva, la familia llega a su nuevo hogar huyendo de algo que desconocemos. Para que no les encuentren, se cambian de apellido y borran, a través de una línea imaginaria, cualquier rastro de su pasado.

El secreto de Marrowbone

Sánchez perfiló con mucho mimo las personalidades de los cuatro hermanos. Jack, Billy, Jane y Sam representan diferentes maneras, a veces contrapuestas y en otras complementarias, de enfrentarse al trauma común que arrastran. De ahí que sus relaciones internas sean tan fascinantes y complejas.

El principal peso de la acción recae sobre Jack. Como hermano mayor se encuentra ante la responsabilidad de cuidar de sus hermanos. Se debate entre las inquietudes habituales de un joven de su edad –como su amor por Allie– y la carga que le ha dejado su madre al pedirle que mantenga a la familia unida.

Más allá de los cinco protagonistas interpretados por actores de carne y hueso, hay otro personaje que también resulta esencial: la casa donde viven recluidos los hermanos, el universo en miniatura que los libera y enjaula a un mismo tiempo, y que, pese a que en la película está ubicado en un punto ficticio de Maine, fue rodado en el Principado de Asturias. La casa del filme es, en realidad, el Palacio de Torre de Arango, en Pravia. Allí, los Marrowbone se esconden de aquello que les persigue. Un misterio que se revelará a partir de este viernes en los cines.

La sinópsis ubica a los Marrowbone en 1969, en la América rural. Cuatro jóvenes hermanos, Jack (George Mackay, «Captain Fantastik»), Billy (Charlie Heaton, «Stranger Things»), Jane (Mia Goth, «La cura del bienestar», «Nymphomaniac»), y el pequeño Sam (Matthew Stagg,«Macbeth») y su madre, Rose. Huyeron de Inglaterra dejando atrás a un padre violento y un pasado criminal, esperando empezar una nueva vida en un lugar donde nadie les conoce. Pronto entablan amistad con Allie (Anya Taylor-Joy, «Múltiple»), una chica local que trae luz a sus tristes vidas. Pero Rose muere de manera inesperada, dejando a sus hijos solos y sin recursos. Los hermanos deciden enterrar a su madre en el jardín y mantener su muerte en secreto para que no puedan separarles o mandarles de vuelta a Inglaterra. Mientras intentan sobrevivir sin la supervisión de un adulto, escondiéndose del mundo y sin otro lugar adonde ir, una amenazante presencia empieza a rondar la vieja casa.

Jack, Billy, Jane y Sam son los cuatro hermanos Marrowbone que componen, junto a su madre, la familia protagonista de la primera película del cineasta Sergio G. Sánchez (guionista habitual de las películas de J. A. Bayona). En el clip que ABC Play ofrece en exclusiva, la familia llega a su nuevo hogar huyendo de algo que desconocemos. Para que no les encuentren, se cambian de apellido y borran, a través de una línea imaginaria, cualquier rastro de su pasado.

El secreto de Marrowbone

Sánchez perfiló con mucho mimo las personalidades de los cuatro hermanos. Jack, Billy, Jane y Sam representan diferentes maneras, a veces contrapuestas y en otras complementarias, de enfrentarse al trauma común que arrastran. De ahí que sus relaciones internas sean tan fascinantes y complejas.

El principal peso de la acción recae sobre Jack. Como hermano mayor se encuentra ante la responsabilidad de cuidar de sus hermanos. Se debate entre las inquietudes habituales de un joven de su edad –como su amor por Allie– y la carga que le ha dejado su madre al pedirle que mantenga a la familia unida.

Más allá de los cinco protagonistas interpretados por actores de carne y hueso, hay otro personaje que también resulta esencial: la casa donde viven recluidos los hermanos, el universo en miniatura que los libera y enjaula a un mismo tiempo, y que, pese a que en la película está ubicado en un punto ficticio de Maine, fue rodado en el Principado de Asturias. La casa del filme es, en realidad, el Palacio de Torre de Arango, en Pravia. Allí, los Marrowbone se esconden de aquello que les persigue. Un misterio que se revelará a partir de este viernes en los cines.

La sinópsis ubica a los Marrowbone en 1969, en la América rural. Cuatro jóvenes hermanos, Jack (George Mackay, «Captain Fantastik»), Billy (Charlie Heaton, «Stranger Things»), Jane (Mia Goth, «La cura del bienestar», «Nymphomaniac»), y el pequeño Sam (Matthew Stagg,«Macbeth») y su madre, Rose. Huyeron de Inglaterra dejando atrás a un padre violento y un pasado criminal, esperando empezar una nueva vida en un lugar donde nadie les conoce. Pronto entablan amistad con Allie (Anya Taylor-Joy, «Múltiple»), una chica local que trae luz a sus tristes vidas. Pero Rose muere de manera inesperada, dejando a sus hijos solos y sin recursos. Los hermanos deciden enterrar a su madre en el jardín y mantener su muerte en secreto para que no puedan separarles o mandarles de vuelta a Inglaterra. Mientras intentan sobrevivir sin la supervisión de un adulto, escondiéndose del mundo y sin otro lugar adonde ir, una amenazante presencia empieza a rondar la vieja casa.

Gobierno y PSOE abren el camino al diálogo con Cataluña si se detiene el 1-O

Si la Generalitat de Cataluña quiere negociar con Madrid podrá hacerlo. Pero eso sucederá una vez superado el 1 de octubre o previa desconvocatoria del referéndum ilegal. Esta es la condición que marcan tanto el Gobierno como el PSOE subrayando que, en ningún caso, el Estado de Derecho puede ceder al chantaje y ofrecer a la Generalitat contrapartida alguna a cambio del abandono de la consulta.

Ahora bien, una vez de vuelta a la legalidad el Ejecutivo de Mariano Rajoy estará dispuesto a estudiar cualquier propuesta de negociación con Cataluña. Lo aseguraron ayer hasta tres ministros distintos: Íñigo Méndez de Vigo, Luis de Guindos y Rafael Catalá. Solo hay una línea roja: el referéndum. Todo lo demás será negociable, incluyendo una reforma de la Constitución, aunque desde el PP, Pablo Casado, concretó que su partido «no propone la reforma de la Constitución, pero si algún grupo quiere promoverla debe plantearlo en el Congreso», y que ellos participarán en ese debate.

El plan en que coinciden tanto PP como PSOE no apunta tanto a la Carta Magna como a la financiación autonómica. Y, en concreto, al Pacto Fiscal que en 2012 reclamó el expresdiente de la Generalitat, Artur Mas, al jefe del Gobierno, Mariano Rajoy, en La Moncloa. Aunque tanto PP como PSOE creen que hay margen para mejorar la financiación de Cataluña sin llegar tan lejos. «En 2012 estábamos en medio de una crisis y centrados en evitar el rescate de España... Pero ahora la situación ha cambiado, tenemos más espacio fiscal, tenemos una recuperación, y eso abre nuevas oportunidades para la discusión», subrayó Guindos en una entrevista concedida a Financial Times. En la misma recordaba que «Cataluña ya tiene mucha autonomía», pero abría la puerta a «una reforma del sistema de financiación y otros asuntos».

La respuesta de los independentistas no se hizo esperar: el único diálogo que esperan es sobre el referéndum. El portavoz del PDeCAT en el Congreso, Carles Campuzano, desdeño con un mal gesto cualquier oferta de aumentar la financiación y e insistió en tener lo mismo que en su día tuvieron Quebec y Escocia: un referéndum autorizado.

Para esta formación la vía del diálogo estará siempre abierta pero para conseguir este único objetivo. Aun así, Méndez de Vigo subrayó que tras el 1 de octubre el Gobierno abrirá una ronda de contactos con el resto de partidos para buscar fórmulas de encaje para Cataluña. El portavoz del Gobierno mencionó expresamente «que hay encima de la mesa una propuesta del PSOE» para constituir en el Congreso una comisión sobre el modelo territorial.

«El PP se ha movido»

En privado, fuentes de Ferraz expresan su satisfacción porque interpretan en el Gobierno y en el PP que «se han movido» en sus posiciones para defender espacios de diálogo. Ponen de ejemplo el apoyo de los populares a la creación de esa comisión, que ayer se aprobó definitivamente por la Mesa del parlamento. «Cuando se lo proponíamos hace semanas no querían ni oír hablar del tema», señalan fuentes de la Ejecutiva. Otro alto dirigente de Ferraz advierte «un antes y un después» en el PP tras el día de ayer, una vez las posibilidades logísticas para celebrar el referéndum parecen haber quedado definitivamente abortadas.

Gobierno y PSOE también coinciden en el mensaje a enviar a la Generalitat. Es quien ha salido de la ley quien debe volver a ella. Casado, en la misma línea, subrayó que aún hay tiempo para «parar el referéndum». Las elecciones anticipadas también forman parte del plan del Gobierno, que en privado confía en que se produzcan en un plazo de tres o seis meses. El número tres del PP, Fernando Martínez Maillo fue muy preciso respecto a los tiempos: «A partir del día 1, el dialogo dentro de la Constitución y las leyes es posible».

Este discurso está en la línea del que se quiere transmitir desde el PSOE. Tanto el secretario de Organización, José Luis Ábalos, como la presidente socialista, Cristina Narbona, insistieron en pedir al Gobierno de la Generalitat que «desconvoque el referéndum del 1 de octubre». Ese sería el paso previo para iniciar un «diálogo político». Que el 1 de octubre no haya nada parecido a una votación y que no haya una declaración unilateral de independencia son ahora los objetivos. Las apelaciones a que Puigdemont tire la toalla con la apuesta de abrir el diálogo como contrapartida es común en Ferraz y en Génova.

No la comparte de igual modo Ciudadanos, que pone el acento en que Oriol Junqueras y Carles Puigdemont ya no pueden ser interlocutores válidos de cara a un diálogo: «Sería un error como demócrata dialogar con los que no respetan la democracia». De hecho, Rivera plantea ya abiertamente que «Puigdemont y Junqueras no son parte del diálogo, ni pueden serlo», apuntando a que tampoco lo serán aunque el 1-O no se produzca porque «seguramente han cometido delitos».

Si la Generalitat de Cataluña quiere negociar con Madrid podrá hacerlo. Pero eso sucederá una vez superado el 1 de octubre o previa desconvocatoria del referéndum ilegal. Esta es la condición que marcan tanto el Gobierno como el PSOE subrayando que, en ningún caso, el Estado de Derecho puede ceder al chantaje y ofrecer a la Generalitat contrapartida alguna a cambio del abandono de la consulta.

Ahora bien, una vez de vuelta a la legalidad el Ejecutivo de Mariano Rajoy estará dispuesto a estudiar cualquier propuesta de negociación con Cataluña. Lo aseguraron ayer hasta tres ministros distintos: Íñigo Méndez de Vigo, Luis de Guindos y Rafael Catalá. Solo hay una línea roja: el referéndum. Todo lo demás será negociable, incluyendo una reforma de la Constitución, aunque desde el PP, Pablo Casado, concretó que su partido «no propone la reforma de la Constitución, pero si algún grupo quiere promoverla debe plantearlo en el Congreso», y que ellos participarán en ese debate.

El plan en que coinciden tanto PP como PSOE no apunta tanto a la Carta Magna como a la financiación autonómica. Y, en concreto, al Pacto Fiscal que en 2012 reclamó el expresdiente de la Generalitat, Artur Mas, al jefe del Gobierno, Mariano Rajoy, en La Moncloa. Aunque tanto PP como PSOE creen que hay margen para mejorar la financiación de Cataluña sin llegar tan lejos. «En 2012 estábamos en medio de una crisis y centrados en evitar el rescate de España... Pero ahora la situación ha cambiado, tenemos más espacio fiscal, tenemos una recuperación, y eso abre nuevas oportunidades para la discusión», subrayó Guindos en una entrevista concedida a Financial Times. En la misma recordaba que «Cataluña ya tiene mucha autonomía», pero abría la puerta a «una reforma del sistema de financiación y otros asuntos».

La respuesta de los independentistas no se hizo esperar: el único diálogo que esperan es sobre el referéndum. El portavoz del PDeCAT en el Congreso, Carles Campuzano, desdeño con un mal gesto cualquier oferta de aumentar la financiación y e insistió en tener lo mismo que en su día tuvieron Quebec y Escocia: un referéndum autorizado.

Para esta formación la vía del diálogo estará siempre abierta pero para conseguir este único objetivo. Aun así, Méndez de Vigo subrayó que tras el 1 de octubre el Gobierno abrirá una ronda de contactos con el resto de partidos para buscar fórmulas de encaje para Cataluña. El portavoz del Gobierno mencionó expresamente «que hay encima de la mesa una propuesta del PSOE» para constituir en el Congreso una comisión sobre el modelo territorial.

«El PP se ha movido»

En privado, fuentes de Ferraz expresan su satisfacción porque interpretan en el Gobierno y en el PP que «se han movido» en sus posiciones para defender espacios de diálogo. Ponen de ejemplo el apoyo de los populares a la creación de esa comisión, que ayer se aprobó definitivamente por la Mesa del parlamento. «Cuando se lo proponíamos hace semanas no querían ni oír hablar del tema», señalan fuentes de la Ejecutiva. Otro alto dirigente de Ferraz advierte «un antes y un después» en el PP tras el día de ayer, una vez las posibilidades logísticas para celebrar el referéndum parecen haber quedado definitivamente abortadas.

Gobierno y PSOE también coinciden en el mensaje a enviar a la Generalitat. Es quien ha salido de la ley quien debe volver a ella. Casado, en la misma línea, subrayó que aún hay tiempo para «parar el referéndum». Las elecciones anticipadas también forman parte del plan del Gobierno, que en privado confía en que se produzcan en un plazo de tres o seis meses. El número tres del PP, Fernando Martínez Maillo fue muy preciso respecto a los tiempos: «A partir del día 1, el dialogo dentro de la Constitución y las leyes es posible».

Este discurso está en la línea del que se quiere transmitir desde el PSOE. Tanto el secretario de Organización, José Luis Ábalos, como la presidente socialista, Cristina Narbona, insistieron en pedir al Gobierno de la Generalitat que «desconvoque el referéndum del 1 de octubre». Ese sería el paso previo para iniciar un «diálogo político». Que el 1 de octubre no haya nada parecido a una votación y que no haya una declaración unilateral de independencia son ahora los objetivos. Las apelaciones a que Puigdemont tire la toalla con la apuesta de abrir el diálogo como contrapartida es común en Ferraz y en Génova.

No la comparte de igual modo Ciudadanos, que pone el acento en que Oriol Junqueras y Carles Puigdemont ya no pueden ser interlocutores válidos de cara a un diálogo: «Sería un error como demócrata dialogar con los que no respetan la democracia». De hecho, Rivera plantea ya abiertamente que «Puigdemont y Junqueras no son parte del diálogo, ni pueden serlo», apuntando a que tampoco lo serán aunque el 1-O no se produzca porque «seguramente han cometido delitos».

Un camión especial para aspas eólicas [VÍDEO]

Si os habéis cruzado alguna vez con un transporte especial de los que portan el aspa de un aerogenerador os habréis dado cuenta de sus dimensiones descomunales y del problema que supone llevarlos de un lado a otro. En la región china de Baoding, a 140 km de la capital, se encontraron con el problema añadido de tener que llevar las aspas por una zona montañosa y llena de pequeñas aldeas. Así que los tipos que veis en la imagen le dieron vueltas a la cabeza y diseñaron unos camiones especiales en los que el aspa no va simplemente remolcada, sino que sobresale por la parte

Vía: @insiprationf

Pequeñas frustraciones [VÍDEO]

Es difícil transmitir mejor una idea en menos tiempo. brillante. Vía @carloselrojo

Los 100 Mejores Blogs Educativos

GilbmartinezPOt interesar?

¿Qué blogs se incluyen?

- Aquellos que posean contenido de calidad.

- Que traten de educación o se especialicen en un tema en concreto de este campo.

- Lo dirijan personas formadas en la rama educativa.

- Que tengan gran variedad de información.

¿En qué me baso para el orden?

¿Qué tipos de blogs aparecen?

Top 100 Mejores Blogs Educativos

Roser Batlle

El blog de Salvaroj

Justifica tu respuesta

Maestra de corazón

Celestino Arteta

María Acaso

El caparazón

El blog de Óscar González

El blog de Manu Velasco

Ayuda para maestros

Crea y aprende con Laura

Aula Planeta

Rosa Liarte

Lecciones de Historia

Boris Mir

Antonio Omatos

Juandon. Innovación y conocimiento

E- Aprendizaje

Pensar en la escuela

Fernando Trujillo

Alberto Bustos

Maestra Especial PT

El blog de Espe

La eduteca

Anibal de la Torre

La colina de Peralías

Educadores 21

Reflexiones Educativas

Sexo con nuestro antepasado desconocido

En los últimos años, la historia de nuestra especie se ha convertido en una interesantísima película de sexo y mestizaje. Primero nos enteramos de que Homo sapiens y neandertales no eran las dos especies aisladas que se pensaba, pues repetidamente se acostaron y tuvieron hijos fértiles hace unos 55.000 años. Por eso si lee estas líneas y no es usted de origen africano lleva en su interior unas gotas de ADN de neandertal. Después, el análisis genético de restos fósiles hallados en Siberia y el de humanos actuales desveló que nuestros ancestros también se acostaron con los denisovanos, de quienes hasta hace pocos años no se sabía ni que existían, hace unos 50.000 años. Su ADN está aún presente en australianos y habitantes del sur de Asia. Y ahora, un equipo de científicos españoles e indios publican pruebas de que hubo un tercer intercambio de fluidos y genes con otro antepasado cuyo rastro puede encontrarse aún en el genoma de los habitantes de las islas de Andamán, en India.

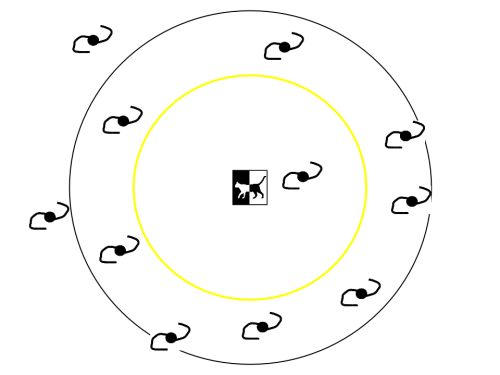

Recuerda: no es el firmamento el que gira [GIF]

Cuando los fotógrafos graban los vídeos time-lapse del cielo vemos las estrellas girar por el firmamento, en el recorrido que veríamos durante toda la noche si fuéramos capaces de apreciar los cambios a tan baja velocidad. Pero este tipo de imágenes pueden inducir al error de pensar que es el cielo el que gira alrededor de nosotros, cuando lo que vemos es producto del giro de nuestro planeta alrededor de sí mismo. En este vídeo estabilizado que publicaban esta tarde en Reddit se aprecia muy bien esta idea. La secuencia está grabada en el Parque Nacional de Crater Lake, en Oregón (EEUU). Hace unos años, en Fogonazos publicamos otro vídeo similar, pero quizá no es tan potente :)

Los misterios de la leche materna humana

Los humanos podríamos tener la leche materna más compleja de todos los mamíferos. La leche de una madre humana contiene más tipos de 200 moléculas de distintos azúcares, muy por encima de la media (de 30 a 50) que podemos encontrar, por ejemplo, en la leche de vaca o de ratona. El papel de cada uno de estos azúcares y por qué su composición cambia durante la lactancia es todavía un misterio para los científicos, pero está probablemente relacionado con el sistema inmune del bebé y el desarrollo del microbioma del intestino.

Seguir leyendo en: Los misterios de la leche materna humana (Next)

En la cima de un sueño

Disfrutad el momento, observad cada unas de estas fotografía como si fuera un tesoro de valor incalculable y soñad lo que sería explorar la superficie del helado y maravilloso Plutón. Porque estamos ya en la cima, el momento en que, 5 meses después del encuentro, las mejores imágenes que jamás veremos de este mundo están ya llegando a la Tierra. Se dijo que lo mejor aún estaba por llegar, y ahora podemos verlo finalmente. Y con ello apreciar aún más sus maravillosos paisajes, que nos golpean con su belleza inesperada y el misterio que los rodea, el enigma de algo que no debería estar ahí, pero ahí está, como si disfrutara de nuestra incredulidad.

Cada semana, forma regular, la New Horizons transmite los datos almacenados en sus grabadoras digitales, un lento envío que hace que, aún hoy, siga habiendo mucho más en lista de espera para iniciar su viaje que ya en la Tierra. Un lento goteo de información, todo siguiendo, como es lógico imaginar, un plan programado previamente, y que ahora llega a uno de los grandes momentos, quizás el más esperado por todos: La llegada de las imágenes con mayor resolución de toda su misión. Una primera tanda, que son parte de una secuencia que fue tomada cerca del momento de máxima aproximación a Plutón, con resoluciones de 77-85 metros por píxel. Es lo mejor que hemos visto nunca, y seguirá siendo lo mejor que habremos visto jamás.

"Estas nuevas imágenes nos dan una impresionante ventana de súper-alta resolución en la geología de Plutón", dijo el investigador principal de New Horizons, Alan Stern."Nada de esta calidad estaba disponible para Venus o Marte hasta décadas después de sus primeros sobrevuelos; sin embargo, con Plutón ya estamos allí, entre cráteres, montañas y campos de hielo, menos de cinco meses después del sobrevuelo! La ciencia que podemos hacer con estas imágenes es simplemente increíble!!".

Son solo las primeras, otras de igual resolución, igual de extraordinarias, deberán llegar los próximos días y semanas, elevando por un factor de 6 lo mejor que habíamos visto hasta ahora de la New Horizons. Pero ya no veremos nada superior a esto. Es la cima de un sueño, el momento es que tocamos el cielo de Plutón. No veremos nunca más nada mejor, al menos en un futuro previsible y sin ninguna nueva misión en el horizonte. Disfrutemos del momento, de la realización de un sueño de tantas décadas y de tantas generaciones. Cuando esto acabe, cuando las últimas gotas de información hayan abandonado finalmente el corazón de esta sonda, llegará la hora de soñar de nuevo, de volar con la imaginación a través del espacio y el tiempo, hacia un tiempo aún lejano en que podamos regresar a el. Y esta vez para quedarnos.

Cráteres estratificados y llanuras heladas: "Los cráteres de impacto son el equipo de perforación de la naturaleza, y las nuevas imágenes, de más alta resolución, parecen demostrar que la corteza helada de Plutón, al menos en algunos lugares, es claramente estratificada", explica William McKinnon, del equipo científico de New Horizons."Buscando en estas profundidades estamos mirando atrás en el tiempo, lo que nos ayudará en la reconstrucción de la historia geológica de Plutón".

La erosión y las fallas geológicas han esculpido esta porción de la corteza helada de Plutón.

En la línea costera de Sputnik Planum: Grandes bloques de la corteza de hielo de agua de Plutón aparecen aquí comprimidas en las conocidas como montañas al-Idrisi .Algunas laderas aparecen recubiertas de material oscuro, mientras que otras partes son brillantes. Varias de ellas parecen mostrar una clara estratifican , tal vez relacionada con las capas se ven las paredes de algunos cráteres. Otras zonas parecen aplastados entre las montañas, como si estos grandes bloques de hielo de agua, algunos de más de 3 Kilómetros de altura, se hubiera desplazado hacia atrás y adelante. Siguiendo una linea de separación perfectamente nítida, como si fuera la costa de un helado mas, aparece Sputnik Planum, donde los hielos blandos, ricos en nitrógeno, forman una superficie perfectamente lisa, que solo rompe las llamativas formaciones geométricas que la divide como si fueran las células de un organismo vivo, y zonas rugosas, que se creen fruto de la sublimación del hielo en las etapas más cálidas de su largo año de más de dos siglos terrestres.

Las mejores imágenes de Plutón.

New Horizons

El curioso caso de las integrales de Borwein

En matemáticas, muchas veces intentamos encontrar reglas generales a partir de ciertos valores que poseemos o de ciertos resultados que obtenemos. En unas ocasiones “acertamos”, refrendando nuestro “acierto” con una demostración (recordad: una creencia no es una demostración), pero en otras fallamos estrepitosamente (recordad: la intuición puede jugarnos una mala pasada). La cuestión que nos ocupa podría encuadrarse en este último caso: se trata de las integrales de Borwein.

Vamos a ver de qué va todo esto. En lo que sigue vamos a tratar con la función , para

, definiéndola como

para

si fuera necesario. Lo primero que queremos hacer es calcular la siguiente integral:

Se trata, como veis, de una integral impropia. Podéis intentar resolverla con las técnicas habituales de cálculo de integrales, pero no podréis. Y la razón es muy sencilla: la función con la que estamos tratando no tiene primitiva elemental. El caso es que con análisis complejo sí que se puede calcular su valor. En este caso obtendríamos que

Multipliquemos la función por y calculemos su integral. Aquí os voy a dar directamente el resultado. Es:

Mismo resultado que la anterior, curioso. ¿Y si multiplicamos la anterior por ? Pues obtenemos esto:

De nuevo el mismo resultado. ¿Y a que no imagináis qué ocurrirá si multiplicamos la función anterior por y calculamos la integral? Pues aquí lo tenéis:

También , inquietante…

¿Qué pasaría si metemos la función correspondiente al 9? Lo esperado:

¿Y si metemos la del 11? Ahí va:

¿Y añadiendo la del 13? Exacto:

¿E incluyendo la del 15? Pues…

valor que es algo menor que (aproximadamente

).

Esto…¿?¿?¿?¿?¿? ¿Qué ha ocurrido? ¿De dónde viene esta rotura tan brusca de la armoniosa regularidad que parecían seguir estas integrales?

Como es evidente, éstas son las conocidas como integrales de Borwein. En 2001, David y Jonathan Borwein (padre e hijo respectivamente) publicaron Some remarkable properties of sinc and related integrals en The Ramanujan Journal. En dicho trabajo estudiaban estas integrales y, entre otras cosas, descubrían esta curiosa propiedad. Concretamente demostraban que las citadas integrales tenían como resultado mientras la suma de los valores que multiplican a

(exceptuando el primero, 1) fuera inferior a 1. Efectivamente, se tiene que

pero

Por eso al añadir la fracción correspondiente al 15 la integral deja de valer .

Decía hace un momento que en su trabajo los Borwein descubrieron esa propiedad entre otras cosas. Con otras cosas me refería al descubrimiento de una propiedad del estilo para unas integrales del estilo a las anteriores. Concretamente para las integrales que se obtienen de las comentadas anteriormente al multiplicar las funciones por . Se tiene lo siguiente:

Y así sucesivamente hasta

Peeeeeeero

Lo que demostraron en este caso es que las integrales daban como resultado mientras los valores que multiplican a x (también exceptuando el 1, como antes) sumen menos de 2. Y tenemos que

pero

En realidad, en el paper de los Borwein enlazado antes no aparece este segundo problema en la forma descrita aquí, pero sí en una forma parecida. En dicho paper tenéis demostraciones de ambos resultados. La manera en la que aquí se describe el caso del segundo tipo de integrales está sacado del trabajo Two curious integrals and a graphic proof, de Hanspeter Schmid, donde también podréis encontrar demostraciones de los dos resultados comentados aquí.

Por cosas como éstas, y por muchas otras, es por lo que amo a las matemáticas. Por eso la imagen que encabeza este post, y por eso también artículos cómo éste.

Escribir un artículo sobre las integrales de Borwein estaba en cartera hace tiempo, pero me lo recordó esta publicación en The Math Kid. Si os ha interesado el tema, podéis echarle un ojo a otros papers que he encontrado cuya temática está relacionada con todo esto:

- Fun with very large numbers, de Robert Baillie.

- Surprising sinc sums and integrals, de Robert Baillie, David Borwein y Jonathan Borwein.

- More remarkable sinc integrals and sums, de Gert Almkvist y Jan Gustavsson.

Esta entrada participa en la Edición 6.6: números vampiro del Carnaval de Matemáticas, cuyo anfitrión es el blog Scire Science.

Órbita Laika #1: El rosa no existe

* Agradecimientos: Para la demostración con las linternas me ayudó el divulgador británico Steve Mould, que me explicó la receta para que saliera bien. Podéis ver su explicación mucho más tranquila y detallada en este vídeo. Gracias, Steve! :)

** Fe de errores: Como veréis en la explicación comento que el nanómentro es la milmillonésima parte de un metro (correcto), pero luego me baila un cero y digo que es la diezmillonésima parte de un milímetro. En realidad es la millonésima parte del milímetro ;)

Neutrino, what’s next? — Organizando partículas 2

Ilustración de Raquel Garcia Uldemollins (http://mati.naukas.com/2013/10/01/27-kilometros-para-entender-la-masa/)

Seguimos con la clasificación de las partículas elementales. Ya vimos en las entrada anterior de esta serie la clasificación establecida en términos del espín de las partículas. Ahora nos toca clasificar las partículas bajo otro criterio, las interacciones que sienten y generan.

Para describir partículas y sus interacciones hay que recurrir a la teoría cuántica de campos. Sin duda alguna, esta teoría es muy elaborada tanto desde el punto de vista físico como desde el punto de vista matemático. Sin embargo, se puede entender algunas de sus particularidades sin necesidad de meternos en berengenales. Espero ser capaz de transmitir la preciosa imagen que nos proporciona esta teoría.

Esta entrada es la continuación de:

Neutrino History, what’s next? — ¿Neutrinos?

Neutrino History, what’s next? — Organizando partículas 1

Las interacciones entre partículas

Las partículas se pueden relacionar de diferentes formas conocidas como interacciones. En la física que nos rodea hay cuatro interacciones que hemos sido capaces de describir y parece que no hay más, por el momento.

Las partículas pueden interactuar bajo una o bajo varias interacciones. Las propiedades que hacen a dichas partículas sensibles a sentir y generar una interacción se denominan genéricamente “carga”. Así pues cada interacción tiene una carga asociada.

Las interacciones conocidas hasta la fecha son:

- La gravedad – Interacción universal cuya carga es la energía. Dado que todo en física tiene energía, todo siente y genera gravedad. Seguramente tenemos en la cabeza que es la masa lo que genera y siente la gravedad, pero eso solo es la mitad de la historia. La carga gravitatoria es la energía en general y sabemos que la masa no es más que una forma de energía. Es una interacción que usualmente es atractiva, y digo usualmente porque sabemos que existen tipos de energía, la energía oscura, que tiene un efecto gravitatorio repulsivo.

- El electromagnetismo — Esta interacción es debida a las cargas eléctricas. Las partículas que sienten y generan la interacción electromagnética se dicen que tiene carga eléctrica. La carga eléctrica se divide en dos tipos, positivas y negativas, aparte del valor que tenga. Por supuesto hay partículas neutras, sin carga, que por tanto no sienten esta interacción. También entendemos esta interacción en términos de atracciones y repulsiones.

- Interacción fuerte — Sin duda, la interacción que domina en el núcleo atómico. Es una interacción que está asociada a una carga denominada color. El color, que es un nombre inventado porque los que hacen ciencia son muy inventivos, es una carga que existe en tres variedades denominadas rojo, verde y azul. Es una interacción atractiva de muy alta intensidad pero de muy corto alcance. Solo opera a niveles nucleares y subnucleares. De hecho, es una interacción que disminuye cuanto es menor la distancia entre las partículas con carga de color y aumenta mucho si intentamos separar dichas partículas coloreadas.

- Interacción débil — Posiblemente la interacción más loca de todas, esta interacción no se entiende como atracciones o repulsiones como estamos acostumbrados. Esta interacción se encarga de cambiar unas partículas en otras, literalmente, una partícula de un tipo se convierte en una partícula de otro tipo. Lo mejor de todo, la carga de la interacción débil no es otra cosa que el tipo de partícula, a los tipos de partículas se denominan sabores. Por lo tanto, todas las partículas la sienten y la generan.

En el campo de las partículas elementales la gravedad es tan poco intensa que no se considera. Además todas las interacciones no gravitatorias las hemos podido describir en términos cuánticos, la gravedad aún no se ha dejado. La teoría de la gravedad cuántica sigue siendo un problema abierto en física.

Clasificación según las interacciones no gravitatorias

Los quarks

Los quarks son fermiones.

Los quarks tienen carga de color, por tanto sienten la interacción fuerte.

Los quarks vienen en distintos tipos, sabores, up, down, charm, strange, top y bottom. Por lo tanto sienten la interacción débil.

Los quarks tienen carga eléctrica así que también sienten la interacción electromagnética.

Los leptones

Se denominan leptones a todas aquellas partículas fermiónicas que no tienen carga de color y por lo tanto no sienten la interacción fuerte.

Los leptones que tienen carga eléctrica son el electrón, el muón y el tau. Estos sienten la interacción electromagnética.

Los leptones sin carga eléctrica, que no sienten la interacción electromagnética, son los neutrinos.

Los sabores de los leptones son electrón y neutrino electrónico, muón y neutrino muónico y tau y neutrino tauónico. La interacción débil opera entre ellos.

La interacción débil es la única que es capaz de comunicar a quarks y leptones. Al cambiar una partícula de un tipo en otro, por ejemplo un quark down en un quark up, involucran (aparecen) otras partículas asociadas, en el ejemplo leptones y neutrinos.

Las interacciones según la cuántica

Como sois muy sagaces os habréis percatado que hemos dejado de lado a los bosones en esta historia. No lo hemos hecho porque le tengamos especial inquina, todo lo contrario, es porque los bosones son los mensajeros de las interacciones.

Según la cuántica una interacción se da por un proceso asombroso, las partículas literalmente crean bosones que están asociados a una determinada interacción:

- Los fotones están asociados a la interacción electromagnética.

- Los gluones están asociados a la interacción fuerte.

- Los bosones W y Z están asociados a la interacción débil.

Por lo tanto, las partículas con carga eléctrica son capaces de intercambiar fotones y es dicho intercambio el que produce las interacciones atractivas y repulsivas. Y así con todas las interacciones.

Ya hemos acabado de clasificar las partículas. A partir de la siguiente entrada nos centraremos en los protagonistas de nuestra historia, los neutrinos.

Nos seguimos leyendo…

Archivado en: modelo estándar y extensiones, partículas elementales, teoría cuántica de campos Tagged: bosón W, bosón Z, electromagnetismo, fotones, gluones, interacción débil, interacción fuerte, interacciones, leptones, neutrinos, quarks

El Constitucional portugués limita los recortes salariales a funcionarios

Para atajar el déficit público, el Gobierno portugués había pactado con Bruselas prolongar los recortes salariales a los funcionarios hasta 2015, para ir suavizándolos después, hasta revertirlos en 2019. Y había reformado el impuesto a los pensionistas, para hacerlo más liviano, pero permanente. Escarmentado por rechazos anteriores del Tribunal Constitucional a ajustes tan drásticos, Lisboa hizo una consulta previa al Alto Tribunal, que este jueves volvió a poner límites al Ejecutivo: las rebajas salariales deben cesar en 2016, y el propósito de una tasa permanente a los pensionistas es, directamente, inconstitucional. La consecuencia es que el Gobierno luso tendrá que idear nueva medidas de ahorro para cumplir con la UE.

Los jueces del Alto Tribunal, que analizaron la ley a instancias del presidente portugués, Aníbal Cavaco Silva, coincidieron en que los recortes previstos para los próximos años son parcialmente contrarios a la Carta Magna y obligan al Ejecutivo a realizar nuevos ajustes por valor de más de 500 millones de euros al año. El Constitucional ha considerado durante los tres últimos años ilegales recortes del gasto público por valor de varios miles de millones de euros y ha llevado al Gobierno a poner en marcha alternativas para cumplir con las exigencias de la UE y el FMI, que acudieron al rescate de las finanzas públicas portuguesas en 2011.

Las medidas analizadas, que afectaban a casi un millón de portugueses entre pensionistas y funcionarios, habían sido aprobadas por el Gobierno conservador para acometer una reforma a medio plazo con la meta de sanear las cuentas. Así, los trabajadores públicos sufrirán de nuevo un recorte diseñado por el anterior Gobierno socialista (2005-2011). Tendrán una reducción de entre el 3,5 % y el 10 % en los salarios superiores a 1.500 euros mensuales, pero solo hasta 2016.

Veto en pensiones

Los jueces justificaron esta aprobación parcial debido a la necesidad de que el Gobierno baje su déficit público, tal y como pidió la troika, integrada por el FMI, la UE, y también por el Banco Central Europeo.

Sin embargo, la norma sobre las pensiones no entrará en vigor por “la violación del principio de protección de confianza”, según el fallo de los jueces. Esta ley consistía en un plan definitivo de reducción de las pensiones, llamado “contribución de sostenibilidad”, que sustituía a una tasa de solidaridad temporal más onerosa. La nueva contribución establecía una tasa en varios rangos, del 2 % a aquellas pensiones que cobraban entre 1.000 y 2.000 euros al mes, que sube al 3,5 % en las de hasta 3.500 euros. El Ejecutivo luso tenía previsto recaudar unos 370 millones de euros al año con esta medida, frente a los 660 millones que ingresaba con la tasa temporal.

Las mejores aplicaciones para niños en Android

Las mejores aplicaciones para niños en Android para ver dibujos animados ...

Las mejores aplicaciones para niños en Android para ver dibujos animados ...Y comienza el espectáculo

Rosetta, la ambiciosa misión destinada a marcar un antes y un después en nuestro conocimiento sobre los cometas, sigue aproximándose lentamente a su objetivo, ahora a poco menos de 9.000 Kilómetros de distancia. Notables son las espectativas generadas por esta sonda y su pequeña compañera de viaje, el módulo de aterrizaje Philae, de la que se espera que nos ofrezca las mejores imágenes y datos científicos jamás reunidos de uno de estos viajeros interplanetarios, pero posiblemente pocos esperaban que las sorpresas comenzaran tan pronto. Y es que ir al encuentro de un cuerpo celeste y encontrarse con dos de ellos al mismo tiempo es siempre algo inesperado.

Las imágenes tomadas por Rosetta cuando se encontraba a 12.000 Kilómetros de su objetivo han revelado que el núcleo de Churyumov-Gerasimenko está formado posiblemente por 2 cuerpos independientes, tan cerca uno de otro que han terminado por quedar unidos, lo que se conoce como una binaria de contacto. Aunque deberemos esperar a nuevas imágenes, aún más claras a medida que la distancia se reduzca, para desvelar la naturaleza exacta del núcleo de cometa, sea doble, como todo indica ahora, o uno solo con una forma extremadamente irregular, lo cierto es que estamos ante algo inesperado, que podría implicar la necesidad de replanetar algunos aspectos de la misión para hacerla compatible con este nuevo escenario

"Actualmente estamos viendo imágenes que sugieren una forma bastante compleja, pero todavía hay muchas cosas que tenemos que aprender antes sacar conclusiones", explica el directos el director de la misión, Fred Jansen. "No sólo en términos de lo que esto significa para el conocimiento científico del cometa en general, sino también con respecto a la planificación de las observaciones científicas, asi como aspectos operativos de la misión, como la órbita y el aterrizaje. Tendremos que realizar un análisis detallado y modelado de la forma de la cometa para determinar la mejor forma de volar alrededor de un cuerpo así, teniendo en cuenta el control de vuelo, los requisitos para la ciencia, y todos los elementos relacionadas con Philae, como el análisis del sitio de aterrizaje y la visibilidad módulo- orbitador. Pero, a menos 10.000 km para llegar a la cita del 6 de agosto, pronto podremos responder a estas preguntas".

Desde el momento en que Rosetta despertó de su largo sueño, marcando el inicio de la mayor y más compleja aventura interplanetaria jamás afrontada por Europa, la cuenta atrás avanza imparable hacia ese gran momento, cuando, tanto desde en órbita como desde la propia superficie, se levantará el telón del que esperemos sea uno de los mayores espectáculos planetarios jamás observado por la Humanidad. El descubrimiento de que quizás estamos ante un núcleo binario, un cometa con doble personalidad, no hace otra cosa que aumentar aún más las espectativas de que este sea aún más increible de lo que nos podríamos imaginar.

El nucleo de Churyumov-Gerasimenko, desvelándose ahora como una binaria de contacto. Se estima que ambos componentes debieron entrar en contacto a velocidades no superiores a los 3 Metros/Segundo para terminar de esta forma. Otro misterio que Rosetta deberá investigar.

Uno de los momentos culminantes de la misión Rosetta será el aterrizaje de Philae, ahora una operación más complicada con el descubrimiento de su naturaleza doble.

Quick Rosetta update: Churyumov-Gerasimenko is a contact binary!

Rosetta’s Comet Looks Like a Giant Peep

Los Anillos del Señor… James Clerk Maxwell

El patito feo de los materiales termoeléctricos se convierte en cisne

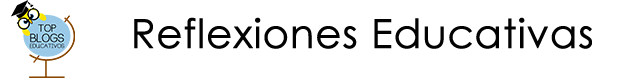

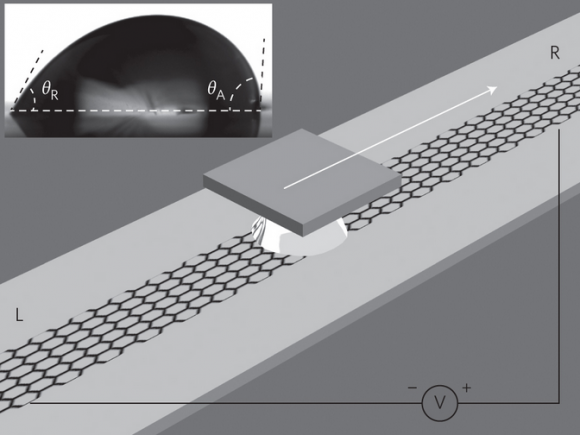

Para generar electricidad a partir de calor se utiliza un fluido de trabajo que mueve una turbina acoplada a una dinamo. La termoelectricidad permite evitar la turbina, usando electrones como fluido de trabajo. Sin embargo, su eficiencia es muy baja (la mayor parte del calor se pierde en la generación de fonones).

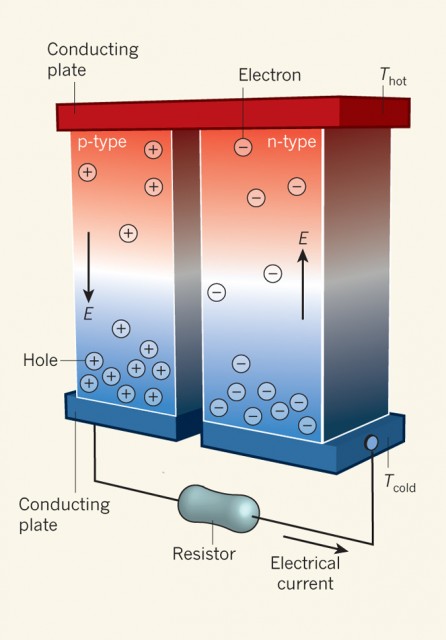

Se publica en Nature que el patito feo de la termoelectricidad, los cristales de monoseleniuro de estaño (SnSe) o seleniuro estañoso, alcanzan un rendimiento récord que duplica al de sus competidores (aleaciones de teluro de plomo o PbTe) . Una gran sorpresa para muchos que habían despreciado este material en favor otros más chic diseñados usando nanotecnología.

Nos lo cuenta Joseph P. Heremans, “Thermoelectricity: The ugly duckling,” Nature 508: 327-328, 17 Apr 2014, siendo el artículo técnico Li-Dong Zhao et al., “Ultralow thermal conductivity and high thermoelectric figure of merit in SnSe crystals,” Nature 508: 373-377, 17 Apr 2014.

Que me perdonen los más puristas entre los lectores de este blog, pero no he podido resistir la tentación con el titular. Uno más justo sería “Nuevo récord en el rendimiento de un material termoeléctrico” o quizás “El seleniuro estañoso es el material termoeléctrico de mayor rendimiento.”

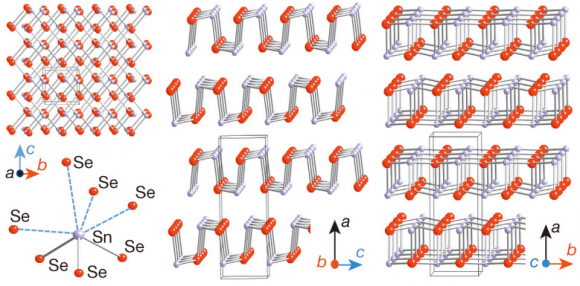

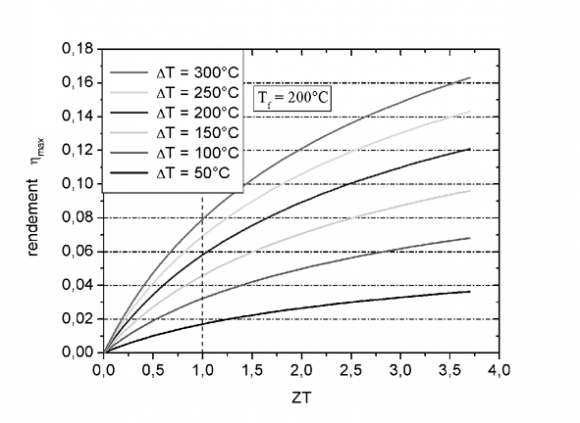

Según la segunda ley de la termodinámica, una máquina térmica genera trabajo gracias a un ciclo de Carnot, extrayendo calor de una fuente caliente (Tc) y disipando calor hacia una fuente fría (Tf) con un rendimiendo máximo de η = 1−(Tf/Tc); recuerda que el rendimiento es el cociente entre la cantidad de trabajo que hace el motor y la cantidad de calor consumido.

Un generador termoeléctrico funciona gracias a un gradiente térmico (∇T) entre dos materiales termoeléctricos que produce un campo eléctrico (E) entre el lado frío y el lado caliente de cada material. Uno de los materiales es un semiconductor de tipo n (en el que la mayoría de las cargas libres son electrones) y el otro de tipo p (en el que la mayoría de las cargas libres son huecos, es decir, electrones ausentes). El cociente E/∇T es negativo en el material tipo n y positivo en el tipo p. Como resultado se obtiene un ciclo de Carnot que convierte el calor suministrado en el lado caliente en energía eléctrica en el lado frío.

Se alcanzaría el rendimiento máximo de Carnot si el ciclo fuera termodinámicamente reversible. Pero es termodinámicamente irreversible debido a la conducción de calor a través de la red cristalina de los átomos de los semiconductores y al calentamiento del efecto Joule en los semiconductores. La fracción del rendimiento máximo de Carnot que se alcanza con este ciclo termoeléctrica se cuantifica por el llamado valor zT del sistema (*). El objetivo de la investigación en termoelectricidad es descubrir nuevos materiales con valores altos de zT.

En los últimos 15 años, los avances en nanotecnología han permitido dupliar el valor de zT mediante ingeniería de la estructura de bandas de energía en los semiconductores. El récord de zT hasta ahora se había alcanzado con aleaciones de teluro de plomo (PbTe). El nuevo trabajo publicado en Nature presenta un nuevo récord (zT = 2,6 a una temperatura caliente de unos 900 K) gracias a cristales de monoseleniuro de estaño (SnSe). Este material es ligero, no contiene plomo (cuyo uso está limitado por la legislación), contiene elementos abundantes en la Tierra (el Te no lo es) y se puede preparar de forma sencilla.

El SnSe es un cisne fascinante. Su secreto, según los autores del nuevo trabajo, es la alta anarmonicidad de sus enlaces químicos, lo que disminuye la dispersión fonón-fonón y reduce las fuentes de irreversibilidad termodinámica cuando se usa como material termoeléctrico. El nuevo trabajo, toda una sorpresa para muchos, promete que futuros estudios teóricos del SnSe, un patito feo en el campo porque su zT a temperatura ambiente era muy baja, podrían lograr nuevos diseños de la estructura electrónica que alcancen valores de zT aún más altos. Las aplicaciones prácticas de la termoelectricidad cada día parecen más próximas.

PS (18 Abr 2014): (*) el rendimiento del motor es una función no lineal del valor zT y depende de la diferencia de temperatura que se use en el motor. Como el valor zT cambia con la temperatura, no se puede utilizar una diferencia de termperatura arbitraria.

Esta figura (extraída de la wikipedia) muestra la relación entre rendimiento y zT. Para un motor que trabaje entre 750 K (zT≈1 en el SnSe) y 923 K (zT=2,62 en el SnSe) esta figura indica un rendimiento entre el 8% y el 10%.

La entrada El patito feo de los materiales termoeléctricos se convierte en cisne fue escrita en La Ciencia de la Mula Francis.

Entradas relacionadas:

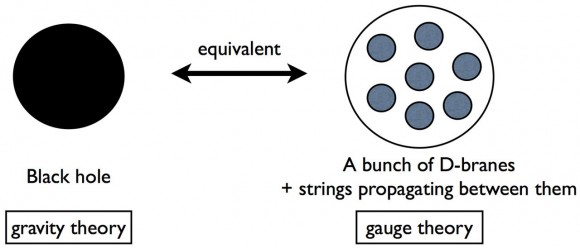

Descripción numérica de un agujero negro cuántico gracias al principio holográfico

GilbmartinezUna simulación númerica basada en la conjetura de Maldacena parece confirmar tanto la radiación Hawking (que presupone la posibilidad de evaporación de agujeros negros (micros) y el principio holográfico propuesto inicialmente por van 't 'Hoof.

Leer un artículo sobre gravedad cuántica y teoría de cuerdas en Science es una agradable sorpresa. Jun Nishimura (KEK, Tsukuba, Japón) y tres colegas calculan mediante métodos numéricos de Montecarlo la radiación de Hawking emitida por un agujero negro cuántico descrito de forma holográfica gracias a la conjetura de Maldacena, la dualidad gauge/gravedad (o dualidad CFT/AdS).

Estudian su evaporación y el resultado concuerda con la predicción teórica de Hawking. Un punto a favor para la resolución holográfica de la paradoja de la pérdida de información en los agujeros negros. Muchos afirman que el nuevo trabajo, cuyo primer autor es Masanori Hanada (Instituto Yukawa de Física Teórica de la Universidad de Kyoto, Japón), da un espaldarazo a la teoría de supercuerdas. Por supuesto, este resultado, esperado por la mayoría de los expertos, abre nuevas perspectivas para el estudio numérico de la gravedad cuántica.

El artículo técnico es Masanori Hanada, Yoshifumi Hyakutake, Goro Ishiki, Jun Nishimura, “Holographic Description of a Quantum Black Hole on a Computer,” Science, AOP 17 Apr 2014 [DOI]; arXiv:1311.5607 [hep-th]. Recomiendo leer a Ron Cowen, “Simulations back up theory that Universe is a hologram. A ten-dimensional theory of gravity makes the same predictions as standard quantum physics in fewer dimensions,” News, Nature, 10 Dec 2013.

En 1974 Hawking descubrió que todo agujero negro debe emitir partículas como un cuerpo negro ideal debido a los efectos cuánticos en el espaciotiempo circundante, con lo que acabará evaporándose por completo. En 1975 Hawking describió la llamada paradoja de la pérdida de información en los agujeros negros: la información de cualquier objeto lanzado dentro de un agujero negro se pierde para siempre, no se puede recuperar en la radiación de Hawking porque es térmica. Esto viola la mecánica cuántica que afirma que la evolución unitaria de un sistema es reversible, la información del estado inicial siempre se puede recuperar en el estado final (si nadie mide el estado y lo colapsa). Un agujero negro está aislado, luego debe evolucionar de forma unitaria.

En la década de los 1990 se propuso una solución a la paradoja gracias al principio holográfico (‘t Hooft (1993), Susskind (1995) y otros). La idea nació en el contexto de la teoría de supercuerdas/teoría M, pero se puede describir en términos más generales. La descripción más habitual para el principio holográfico se basa en la conjetura de Maldacena (1998) llamada dualidad gauge/gravedad, o también CFT/AdS. Esta idea ha sido demostrada en modelos muy simplificados, pero su aplicación a los agujeros negros en un espaciotiempo de cuatro o más dimensiones sigue siendo una conjetura. Las matemáticas son de extrema complejidad, por lo una opción natural es recurrir al uso de métodos numéricos.

Mediante métodos numéricos no se puede demostrar un teorema (salvo cuando el teorema es intrínsecamente numérico). Pasa lo mismo que con los experimentos y las teorías. Los experimentos no pueden verificar las teorías, sólo pueden incrementar nuestra confianza en ellas; sin embargo, un experimento puede llegar a refutar (falsar) una teoría. Los métodos numéricos nos permiten realizar experimentos donde es físicamente imposible hacerlo de otra forma. La relatividad numérica (o gravedad numérica) ha revolucionado la astrofísica y la cosmología. La gravedad cuántica numérica (vía el principio holográfico) promete una revolución similar.

Un agujero negro es una solución de tipo solitón en la teoría clásica de la gravedad. Las D-branas en la teoría de supercuerdas también son soluciones de tipo solitón (se suelen llamar soluciones no perturbativas). Un conjunto finito de D-branas conectadas entre sí por la presencia de cuerdas abiertas y cuerdas cerradas se comporta como una solución de tipo solitón análoga a un agujero negro en un espaciotiempo de diez dimensiones. Se puede obtener un análogo a un agujero negro clásico en cuatro dimensiones utilizando un gran número de D-branas (N→∞) y especificando una compactificación, pero no sabemos cuál es la más adecuada. Este último problema se puede esquivar cuando se usa un número pequeño de D-branas (el nuevo artículo utiliza N≤4).

Nishimura simplifican aún más el modelo limitándose a D-branas puntuales (cero-D-branas). Asumiendo que la conjetura de Maldacena es aplicable, la interacción entre N de estas 0-D-branas se puede estudiar usando la interacción entre los campos de la versión matricial de una teoría gauge (en esta teoría los campos se representan mediante matrices N×N). La simulación numérica de teorías gauge mediante métodos de Montecarlo está bien estudiada, pero requiere superordenadores (en el nuevo artículo se usa un cluster).

El modelo numérico de teoría de supercuerdas desarrollado tiene ciertas limitaciones. No se puede estudiar el acoplo fuerte entre las 0-D-branas, por lo que se estudia sólo su límite a baja energía (cuando la tensión de las cuerdas α → 0); en este límite la física está dominada por la presencia de cuerdas cerradas (gravitones) entre las 0-D-branas. En el límite clásico de esta teoría se obtiene una teoría de supergravedad, que describe un agujero negro extremal con temperatura nula, es decir, que no emite radiación de Hawking. Gracias a los métodos numéricos se puede estudiar un límite cuasi-clásico, o con temperatura finita, que corresponde a un agujero negro no extremal que emite radiación de Hawking.

El modelo numérico desarrollado para el agujero negro cuántico para N pequeño está dominado por las interacciones entre gravitones (cuerdas cerradas) y a temperatura finita permite estudiar cómo emite radiación de Hawking hasta evaporarse por completo. Gracias a ello permite estudiar la paradoja de la pérdida de información en un contexto de la gravedad cuántica.

Por supuesto, puede parecer que se está haciendo trampa al asumir la validez de la conjetura de Maldacena en un estudio que pretende estudiar su validez. Sin embargo, esto es lo mismo que se hace cuando se realizan experimentos de laboratorio para estudiar las predicciones de una teoría. Se asume la teoría, se ejecuta el experimento y se comprueba si los resultados coinciden con lo predicho por la teoría. Si no coinciden sabemos que la teoría es incorrecta (en el límite probado por el experimento). Pero si coinciden lo único que crece es nuestra confianza en la validez (en el limíte estudiado) de dicha teoría.

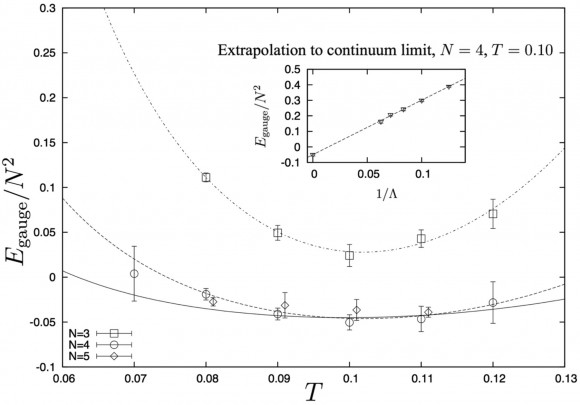

Sin entrar en detalles técnicos, se puede evaluar la “energía” del agujero negro en función de la temperatura (entre comillas porque se evalúa la diferencia de masa entre el agujero negro no extremo con cierta temperatura y el agujero negro extremo). Se habla de “energía” porque en la teoría gauge dual equivale a la energía interna. Usando las leyes de la termodinámica de los agujeros negros de Bekenstein y Hawking se obtiene como resultado

donde se usa una “energía” y temperatura normalizadas (ver el artículo para más detalles técnicos). El resultado del método numérico (que repito asume la validez del principio holográfico) se ajusta a una expresión similar con ciertos parámetros libres desconocidas (aunque las potencias de la temperatura se predeterminan por un análisis dimensional). Se espera que dicho ajuste reproduzca la predicción teórica (lo que “confirma” la validez del principio holográfico).

Simulaciones numéricas publicadas en los últimos años habían confirmado que en el límite N=∞ el ajuste del resultado numérico coincide con la predicción teórica para 0,5 ≤ T ≤ 0,7, lo que confirma la dualidad gauge/gravedad a nivel clásico. Los resultados del nuevo artículo publicado en Science la confirman para T ≈ 0,1 con N = 3, 4 y 5, es decir, en el límite cuántico. Un gran resultado cuyos detalles técnicos omito por brevedad pero pueden ser consultados en la versión en arXiv del artículo.

En resumen, se confirma que la dualidad gauge/gravedad permite estudiar de forma numérica la evaporación de los agujeros negros cuánticos y el resultado confirma las predicciones teóricas de Hawking. Por tanto, como en la teoría gauge dual no se pierde información, tampoco se pierde en el agujero negro cuántico.

Con todas las comillas con las que hay que tomar el nuevo resultado publicado en Science, lo más importante es que nos ofrece un futuro muy prometedor para la gravedad cuántica numérica gracias a la conjetura de Maldacena. Muchos otros problemas (como la interacción entre pares de agujeros negros cuánticos) podrán ser explorados por este método en un futuro no muy lejano. Sin lugar a dudas estamos en un momento apasionante para trabajar en gravedad cuántica numérica.

La entrada Descripción numérica de un agujero negro cuántico gracias al principio holográfico fue escrita en La Ciencia de la Mula Francis.

Entradas relacionadas:

Newton, eres grande en lo pequeño

La gravedad es la fuerza arquetípica de la que todos tenemos una constancia directa. Es normal que fuera la primera interacción de la que dispusimos una formulación matemática formal. Como es bien conocido la ley matemática de la gravitación vino de la mano del amigo Newton. En la actualidad tenemos una teoría más general para la gravedad, Albert Einstein nos proporcionó una nueva forma de entender la gravedad como la consecuencia de la cambiante geometría del espaciotiempo. En esta teoría el espaciotiempo es una entidad dinámica que interactúa con el resto de campos físicos. Hay que decir que la relatividad general, la teoría gravitatoria de Einstein, no invalida a la gravedad de Newton sino que la contextualiza. En la relatividad general recuperamos la gravedad Newtoniana para campos gravitatorios débiles y velocidades pequeñas de los cuerpos gravitantes. Así que esto no es una competición de la relatividad general está bien y por tanto la gravedad de Newton está mal.

La gravedad es la fuerza arquetípica de la que todos tenemos una constancia directa. Es normal que fuera la primera interacción de la que dispusimos una formulación matemática formal. Como es bien conocido la ley matemática de la gravitación vino de la mano del amigo Newton. En la actualidad tenemos una teoría más general para la gravedad, Albert Einstein nos proporcionó una nueva forma de entender la gravedad como la consecuencia de la cambiante geometría del espaciotiempo. En esta teoría el espaciotiempo es una entidad dinámica que interactúa con el resto de campos físicos. Hay que decir que la relatividad general, la teoría gravitatoria de Einstein, no invalida a la gravedad de Newton sino que la contextualiza. En la relatividad general recuperamos la gravedad Newtoniana para campos gravitatorios débiles y velocidades pequeñas de los cuerpos gravitantes. Así que esto no es una competición de la relatividad general está bien y por tanto la gravedad de Newton está mal.

En ciencia lo único que puede decir que una teoría no es válida es el experimento. Las teorías tienen que predecir valores de los observables físicos y el experimento tiene que ser capaz de decir si los valores “reales” observados de esas magnitudes coincide con lo predicho por las teorías o no.

Por tanto, en ciencia hay una lucha eterna entre teorías y experimentos. Los experimentos nos dan los valores de las magnitudes físicas medidas y estos resultados se comparan con los valores predichos para dichas magnitudes por los modelos físicos. Así pues, confiamos en una teoría hasta que llega un experimento que esta no puede explicar.

Pues bien, de forma sorprendente (al menos a mí siempre me ha parecido sorprendente), la interacción gravitatoria no es la mejor conocida experimentalmente. En la actualidad podemos decir que sabemos que la teoría de la relatividad general y su límite Newtoniano funcionan en un rango de distancias desde el mm hasta algo más allá del sistema solar. Si bien es cierto que cada vez tenemos mejor control a grandes escalas, verificar y experimentar con el campo gravitatorio en escalas por debajo del milímetro es ciertamente complicado.

Pero parece que se ha hecho algún avance importante en este sentido como dicen en el artículo:

Gravity resonance spectroscopy constrains dark energy and dark matter scenarios

Vamos a ver de qué va esto.

¿Qué queremos medir?

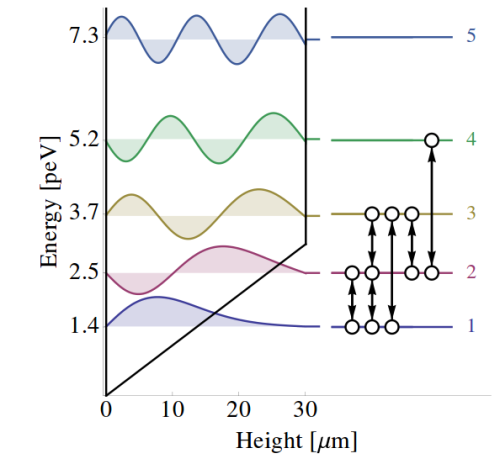

Cuando tenemos un sistema de partículas confinadas, es decir, que están condenadas a “vivir” en una determinada región finita del espacio, las energías de estas partículas no pueden ser cualesquiera sino solo determinados valores. Es decir, los niveles de energía permitidos no son un continuo sino un conjunto discreto. Esta es una de las predicciones de la teoría cuántica y es una de las más estudiadas y de las más contrastadas experimentalmente.

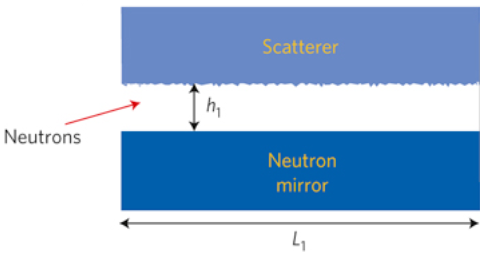

Lo que queremos medir son los niveles de energía de un sistema de neutrones de poquita energía (neutrones frío o de velocidad baja) confinados entre dos espejos dispuestos de tal forma que estén inmersos en el potencial gravitatorio de la tierra. En el experimento se emplean neutrones para minimizar la influencia de otras interacciones, como la electromagnética, y así tener un buen control de la influencia de la gravedad en este experimento. (Recordemos que la gravedad es la más débil de las interacciones y que cualquier otra de ellas enmascararía su efecto en el experimento).

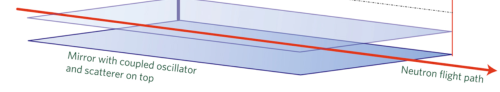

Lo que hacemos es lo siguiente:

1.- Lanzamos neutrones a muy baja velocidad de forma que atraviesen dos espejos separados una determinada distancia h. DAdo que ambos espejos están a distintas alturas hay una influencia del potencial gravitatorio. En puntos más altos la gravedad es menor que en puntos más cerca de la tierra, eso induce un potencial gravitatorio. Los neutrones en este dispositivo tienen distintos niveles discretos de energía.

2.- Además, el espejo superior tiene una rugosidad conocida que induce transiciones de los neutrones entres distintos niveles de energía. (En realidad introduce un factor de disipación que hace que la vida media en los estados sea conocida, esto es útil para seleccionar qué estados queremos medir en el experimento, pero es una pijada técnica)

Los niveles de energía, con la representación de sus funciones de onda y las posible transiciones entre niveles.

3.- Los espejos se acoplan a un resonador. Este provoca una oscilación en los mismos con lo que se induce una modificación efectiva periódica en el potencial de interacción gravitatorio que van sintiendo los neutrones en vuelo. Esto nos proporciona una herramienta para provocar un fenómeno de resonancia.

4.- Esto provoca que podamos entender el experimento como una situación de dos niveles de energía (seleccionados por la configuración de los espejos, la rugosidad del superior y la oscilación mecánica que modula y selecciona frecuencias resonantes). Lo que medimos es la transición entre estos dos estados para los neutrones fríos en vuelo.

4.- Esto provoca que podamos entender el experimento como una situación de dos niveles de energía (seleccionados por la configuración de los espejos, la rugosidad del superior y la oscilación mecánica que modula y selecciona frecuencias resonantes). Lo que medimos es la transición entre estos dos estados para los neutrones fríos en vuelo.

Lo que se encuentra

Lo que se encuentra

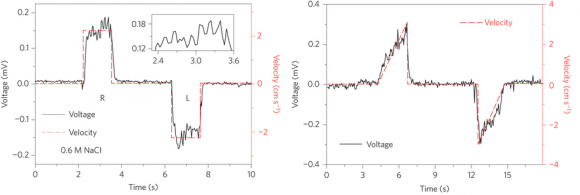

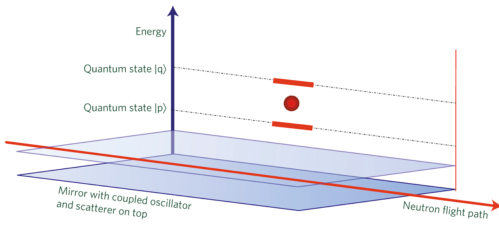

El resultado del experimento se puede resumir en la siguiente figura:

Lo puntos experimentales son los que uno esperaría encontrar si la ley de Newton de la gravedad no sufre modificaciones a la escala en la que se está haciendo el experimento.

Así pues, este experimento alarga la vida a la gravedad de Newton :)

¿Qué tiene que ver esto con la energía oscura y la materia oscura?

Pues como no sabemos qué son estas cosas hay sobre la mesa varios modelos. Estos modelos asignan diferentes propiedades gravitatorias a estos bichos y afectaría a los neutrones de este experimento. Eso daría una señal que podríamos identificar.

Lo que se ha obtenido en este experimento se puede resumir en lo siguiente:

a) La gravedad de Newton (como límite de la relatividad general sin modificaciones) ha sido comprobada hasta la escala micrométrica. (Esto descarta que haya dimensiones extra grandes del orden del milímetro como se había propuesto en algunos modelos de física de partículas).

b) Una familia de modelos para explicar la energía oscura, los conocidos como modelos camaleónicos, ha visto muy reducida su viabilidad aunque aún no se pueden descartar del todo a la espera de la mejora de estas técnicas.

c) Una de las formas de materia oscura, los axiones, pueden interactuar con los neutrones del experimento modificando las transiciones que se ven en el experimento. Sin embargo, dichas transiciones no han aparecido, lo que constriñe aún más la posibilidad de materia oscura axionica.

Concluyendo

Estas técnicas pueden deparar muchas sorpresas y dar restricciones mucho más fuertes para modelos de energía oscura, materia oscura y dimensiones extra. Son experimentos relativamente “sencillos” y “baratos” que nos pueden enseñar muchas cosas.

Nos seguimos leyendo…

Archivado en: dimensiones, dimensiones extra, experimentos, física nuclear, gravitación, mecánica cuántica Tagged: experimentos, gravedad de Newton, gravitación, neutrones, resonancia

Vamos a morir todos

Cuando me hablan del diseño inteligente dando como “prueba” lo bien ajustadito que está todo para que nosotros podamos vivir en el universo, me da un poco de ternura. Sin duda el universo permite la vida en él, a las pruebas me remito, pero tampoco está fuera de ninguna duda que el universo es un sitio inhóspito y hostil para la vida. Todos los que propugnan lo bien diseñado que está el universo para permitir vida superior en él deberían seguir leyendo las instrucciones, porque amigos, el universo es una fabulosa máquina de matar.

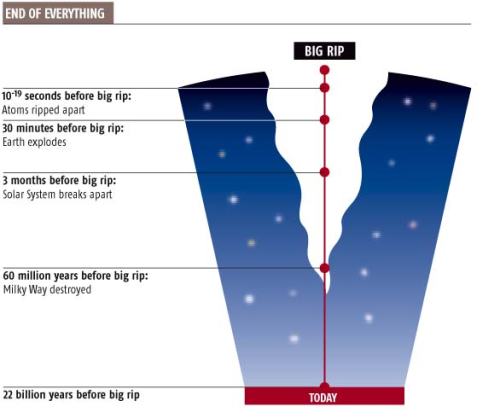

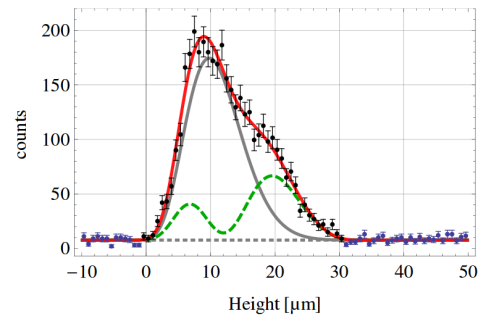

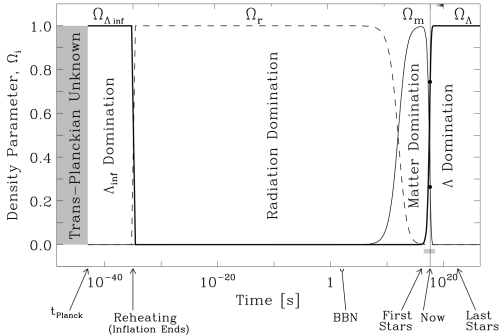

En esta entrada hablaremos del fin del universo. Con las evidencia actuales sobre la constitución del mismo y sabiendo que su dinámica está dominada por una energía (oscura) que provoca la expansión, cada vez más acelerada, del mismo, podemos aventurar qué pasará en los próximos miles de millones de años.

El principio antrópico de mi barrio

Antes de empezar a meternos en harina, hablemos un poco del principio antrópico.

El principio antrópico reza tal que así: