Hablando de… es la serie caótico-histórica de El Tamiz. En ella hablamos más o menos de cualquier cosa de manera caprichosa y enlazamos cada artículo con el siguiente para poner de manifiesto que todo está conectado de una manera u otra; los primeros 32 artículos de la serie están disponibles, además de en la web, en forma de dos libros, pero esto tiene pinta de no terminarse pronto (al menos, mientras vosotros y yo nos sigamos divirtiendo). En los últimos artículos hemos hablado de Giordano Bruno, cuyas obras fueron prohibidas por el Papa Clemente VIII, quien en cambio tres años antes dio el beneplácito de la Iglesia al café, bebida protagonista de la Cantata del café de Johann Sebastian Bach, cuya aproximación intelectual y científica a la música fue parecida a la de Vincenzo Galilei, padre de Galileo Galilei, quien a su vez fue padre de la paradoja de Galileo en la que se pone de manifiesto lo extraño del concepto de infinito, cuyo tratamiento matemático sufrió duras críticas por parte de Henri Poincaré, el precursor de la teoría del caos, uno de cuyos padres, Sir Robert May, fue Presidente de la Royal Society de Londres, sociedad formada a imagen de la Casa de Salomón descrita en el Nova Atlantis de Francis Bacon cuando científicos de las siguientes generaciones leyeron sus escritos, como le sucedió a Robert Boyle, cuyo trabajo en óptica fue bienintencionado pero muy inferior al de otros estudiosos de la naturaleza de la luz.

Pero hablando de la naturaleza de la luz…

Un aviso pertinente: como siempre me pasa en esta serie he empezado a escribir, y escribir, y una cosa me ha llevado a otra… “Pero ¿cómo no voy a mencionar tal cosa?”, pensaba. “Ah, pero claro, entonces también hablaré sobre esta otra…” De manera inocente, ¡lo juro! me ha salido un ladrillo de tal calibre que he tenido que partirlo no en dos, sino en tres partes. Dicho en otras palabras, vais a acabar hasta las mismísimas narices de la luz y de los cambios de rumbo y digresiones constantes… pero ¿quién dijo que Hablando de… servía para aprender de algo concreto? Divaguemos juntos entonces.

El problema es que la luz es una de las cosas más sutiles, enrevesadas y difíciles de entender con las que se ha encontrado el ser humano al observar el Universo. Por eso ha sido el objeto de discusiones enconadísimas a lo largo de la historia de la ciencia, y a ellas se han dedicado algunas de las mentes más afiladas de todos los tiempos. Además esa misma sutileza de la luz supone que, para entenderla, nos ha hecho falta mecánica, geometría, ondulatoria, electricidad, magnetismo, relatividad, cuántica… pueden contarse con los dedos de una mano las ramas de la Física que no son necesarias para comprender este misterio.

Sin embargo, irónicamente durante milenios simplemente aceptamos la existencia de la luz sin pensar demasiado en ello –o, al menos, no tenemos mención alguna al respecto hasta el siglo V a.C.–. Teníamos claro lo evidente y necesario para sobrevivir: algunos objetos emiten luz por sí mismos, otros la reflejan de una manera u otra, y nosotros somos capaces de ver gracias a los ojos. Al fin y al cabo no hace falta más que mirar al Sol o a una lámpara para darse cuenta de lo primero, y taparse los ojos para comprender lo segundo. Pero, como digo, no fuimos más allá de este conocimiento práctico y concreto que no requiere de razonamiento alguno.

Cuando finalmente empezamos a pensar de verdad en el problema, se hizo evidente que era un problema de muy difícil solución. En este largo artículo vamos a recorrer las distintas ideas que se fueron proponiendo acerca de esa naturaleza de la luz. Como verás, poco a poco fuimos refinando nuestras sospechas, pero el problema es tan sutil que en casi todas las épocas hubo más de una hipótesis acerca de ella –las primeras más bien burdas, las posteriores mucho más elaboradas–, y una discusión a veces acalorada acerca de cuál se acercaba más a la realidad. ¿Listo para empezar el viaje? Pues retrocedamos dos milenios y medio.

Fue entonces cuando vivió el primero de quien tenemos noticia que postuló una hipótesis razonada sobre la naturaleza de la luz: Empédocles de Agrigento (¡sorpresa, un filósofo griego!). Además de poeta, Empédocles fue uno de los principales filósofos naturales del siglo V a.C. Vivió en la Magna Grecia, en lo que hoy es Agrigento pero por entonces era la ciudad helena de Akragas, en el sur de Sicilia, entre alrededor de 490 y 430 a.C.

Empédocles de Agrigento en un grabado del s. XVII.

Aunque Empédocles escribió sobre muchos asuntos, lo que nos interesa hoy se encuentra en su obra Sobre la Naturaleza, un poema de dos mil versos del que, desgraciadamente, sólo conservamos medio millar. En él postula la idea por la que es más conocido: la existencia de cuatro elementos fundamentales (tierra, aire, agua y fuego), pero también habla sobre la percepción y los sentidos y ahí, por fin, encontramos la primera mención de la Historia sobre la naturaleza de la luz.

La hipótesis sobre la luz y la visión de Empédocles era endiabladamente complicada, y en muchos aspectos errónea, pero contiene algunos gérmenes de verdad que resulta sorprendente encontrar en una época tan temprana. Recuerda que estamos hablando de la Grecia clásica: filosofía y ciencia aún no se han separado y todavía no se ha establecido una de las “patas” de la ciencia moderna, la experimentación. Sin embargo, sí existe ya por entonces la contribución helena al desarrollo de la ciencia: la primacía de la razón. Aunque Empédocles aún involucra a los dioses en sus ideas, las conclusiones concretas que obtiene son fruto del razonamiento lógico a partir de los fenómenos observados.

Según el siciliano, el ojo está formado por los cuatro elementos, y el fuego en su interior emite luz que atraviesa la córnea y sale al exterior. Esta primera hipótesis sobre la luz y la visión es, por tanto, una hipótesis de emisión, pero como veremos luego hay sutilezas en ella que no la hacen tan extrema. Aunque no tenemos constancia del porqué de esta hipótesis, sospecho que tiene que ver con dos razones que Empédocles, como cualquiera con dos ojos en la cara, seguramente había observado:

En ocasiones, cuando se mira a los ojos de un gato o algún otro animal por la noche, se ven dos discos brillantes en el interior. De acuerdo con la hipótesis de emisión, esto es porque los gatos tienen fuegos oculares especialmente poderosos, tanto que pueden ser percibidos por el ser humano.

Algunas personas ven mucho mejor que otras, y esta diferencia puede ser explicada porque su fuego interior es más intenso que el de quienes ven peor. Dado que los gatos ven muy bien de noche, y que es muy difícil percibir discos de luz en los ojos del ser humano por la noche, esto explica también por qué estos animales ven mejor que nosotros.

Pero la emisión era sólo una parte de la hipótesis de Empédocles: al fin y al cabo, el siciliano podría ser ingenuo y vivir en una época en la que no tenía nada anterior en lo que basarse, pero no era tonto. No hace falta pensar mucho para darse cuenta del agujero enorme en una hipótesis pura de emisión: ¿por qué vemos de día y no en la oscuridad?

Aquí entra la segunda parte de la hipótesis de Empédocles: el ojo humano no es lo único que contiene un fuego interior. El Sol, la Luna, las lámparas, etc., también los contienen, y emiten a su vez luz. Tanto la emitida por el ojo como por cualquier otro fuego, de acuerdo con el de Agrigento, viaja en línea recta –en forma de rayos, en términos modernos–, hasta los objetos. Estos rayos, según Empédocles, viajan de un lugar a otro a una velocidad finita.

Cuando los objetos reciben estos rayos, a su vez emiten los suyos propios en respuesta. Cuando estos rayos “secundarios” entran en contacto con los emitidos por el ojo, la interacción entre ambos constituye la visión. Así, el proceso no sería puramente de emisión, sino de emisión-recepción. Esto explicaría, según Empédocles, por qué no vemos en la oscuridad: no hay suficiente luz sobre los objetos, ya que nuestro ojo no tiene un fuego tan intenso. El de un gato seguramente sí puede emitir suficiente “fuego” como para ver, pero no nosotros.

Algunas de las ideas de Empédocles son sorprendentemente acertadas: la existencia de rayos luminosos, la velocidad finita de la luz, la reacción de los objetos al recibir luz emitida por otros… sin embargo, en otras cosas estaba completamente equivocado, sobre todo en la concepción de la visión como la interacción entre dos fuegos, uno interior y otro exterior.

Sé que hoy en día resulta un poco ingenua su hipótesis de emisión-recepción, pero ¿es tan diferente de la manera en la que delfines o murciélagos perciben las cosas? ¿resulta tan absurda dados los conocimientos empíricos de la época? Yo creo que no. El problema principal de Empédocles, como el de casi todos los científicos de la época, era la ausencia casi total de experimentos preparados cuidadosamente: se basaban en observaciones casuales.

Parte de lo que sabemos de las ideas de Empédocles se debe a los versos que conservamos de Sobre la naturaleza, pero la otra parte se la debemos al científico griego más influyente sobre nuestra concepción de las cosas durante muchos siglos: Aristóteles de Estagira. Irónicamente, Aristóteles no estaba de acuerdo en casi nada con Empédocles en lo que respecta a la luz, pero a la manera griega –¡qué grandes eran!–, antes de destrozar las ideas del otro las describía con cierto detalle, para poner de manifiesto sus agujeros, con lo que gracias a Aristóteles conocemos mucho mejor las ideas de Empédocles.

Así, de la velocidad finita de la luz de Empédocles, Aristóteles nos dice, en su Sobre los sentidos:

Empédocles afirma que la luz del Sol viaja primero por el espacio intermedio antes de llegar al ojo, o alcanzar la Tierra. Esto podría considerarse plausible, ya que cualquier cosa que se mueve por el espacio viaja de un lugar a otro; por tanto, debe haber un intervalo de tiempo durante el que viaja de un lugar a otro. Pero dado que cualquier intervalo de tiempo es divisible en partes, podemos suponer que hubo un instante en el que el rayo de luz solar no había llegado al ojo, sino que estaba todavía viajando por el espacio intermedio.

Sin embargo, según Aristóteles la luz no viaja por ninguna parte, porque no es algo que se mueva: es una presencia que inunda el espacio. O existe, o no lo hace, pero no empieza a existir en unas regiones del espacio para llegar a otras. Si fuese de otro modo podríamos detectar ese movimiento, por ejemplo cuando sale el Sol por el este. Pero no sucede así — la luz llega al oeste de manera instantánea. En Sobre el alma, Aristóteles refuta a Empédocles así:

Empédocles (y con él los que usan las mismas formas de expresarse) erraba al hablar de la luz como algo que “viaja” o que existe en un momento dado entre la Tierra y su envoltura, con un movimiento imperceptible para nosotros; esta idea es contraria tanto a las pruebas argumentales como a los hechos observados. Si la distancia recorrida fuese corta tal vez este movimiento fuera inobservable, pero cuando la distancia es desde el extremo oriental al occidental, lleva demasiado lejos a nuestra credulidad.

Dicho de otra manera, Aristóteles acepta el hecho de que la luz pueda moverse tan rápido que, al encender una linterna, parezca inundar el espacio circundante de manera instantánea. Pero es imposible, de acuerdo con él, que no sea perceptible un cierto intervalo de tiempo “desde el extremo oriental al occidental”, con lo que parece referirse a la salida del Sol, que llena de luz de uno al otro horizonte de modo instantáneo.

Por lo tanto, según el estagirita no tiene sentido intentar determinar la velocidad de la luz: cuando existe, es algo ubicuo. De acuerdo con Aristóteles tampoco hay emisión alguna por parte del ojo: cuando hay luz en el exterior –luz creada por fuegos externos–, ésta llena todo el espacio, incluido el interior del ojo y su fuego interno, y por eso vemos. Si no hay luz externa no podemos ver. Su hipótesis, por tanto, no es de emisión como la de Empédocles, sino de absorción.

Otro filósofo griego que encontró problemas con las ideas de Empédocles fue el genial Euclides de Alejandría, del cambio de siglo IV-III a.C. Al igual que Empédocles, Euclides es más conocido por algo que no tiene que ver con nuestro asunto de hoy, en este caso por ser el padre de la geometría. Euclides era, de hecho, mucho más matemático que científico, pero dedicó parte de su atención a la hipótesis de emisión de Empédocles y encontró un problema fundamental en ella.

Supongamos, pensaba el alejandrino, que me encuentro en el campo en una noche estrellada, y tengo los ojos cerrados. Las estrellas están muy, muy lejos de mí, como puede comprobarse por el hecho de que, al movernos, sus posiciones aparentes no cambian en absoluto. Por lo tanto, cuando abro los ojos y el fuego interior emite rayos hacia ellas, debería haber un desfase entre el momento en el que abro los ojos y el momento en el que veo las estrellas. Como mínimo, entre un instante y otro debería pasar el tiempo necesario para que la luz viajase de mi ojo a la estrella y de vuelta.

Sin embargo, al abrir los ojos vemos las estrellas instantáneamente, luego debía ser falsa una de dos cosas en la hipótesis de Empédocles: o bien la visión no se producía por la excitación del objeto por parte del fuego del ojo, o bien la luz viajaba de manera instantánea.

En lo que todos los filósofos griegos estaban de acuerdo era en que existía una interacción entre dos fuegos, el interno y el externo. Lo mismo opinaba Platón, que como Empédocles era partidario de la hipótesis de emisión. En uno de sus diálogos, Timeo, dice lo siguiente sobre la luz y la visión (énfasis mío):

Los primeros instrumentos que construyeron fueron los ojos portadores de luz y los ataron al rostro por lo siguiente. Idearon un cuerpo de aquel fuego que sin quemar produce la suave luz, propia de cada día. En efecto, hicieron que nuestro fuego interior, hermano de ese fuego, fluyera puro a través de los ojos, para lo cual comprimieron todo el órgano y especialmente su centro hasta hacerlo liso y compacto para impedir el paso del más espeso y filtrar sólo al puro. Cuando la luz diurna rodea el flujo visual, entonces, lo semejante cae sobre lo semejante, se combina con él y, en línea recta a los ojos, surge un único cuerpo afín, donde quiera que el rayo proveniente del interior coincida con uno de los externos. Como causa de la similitud el conjunto tiene cualidades semejantes, siempre que entra en contacto con un objeto o un objeto con él, transmite sus movimientos a través de todo el cuerpo hasta el alma y produce esa percepción que denominamos visión.

Platón (izquierda) y Aristóteles (derecha), parte de La escuela de Atenas, de Rafael.

Pero desde luego ni Empédocles, ni Aristóteles, ni Euclides ni Platón podían demostrar sus ideas: ninguno midió una velocidad para la luz, ni realizó ningún experimento que demostrase sin lugar a dudas que su hipótesis era verdadera y la otra falsa. Tampoco podían demostrar siquiera aquello en lo que todos estaban de acuerdo, la existencia de un fuego interior del ojo. Aunque aquí nos centraremos en la naturaleza de la luz y no tanto en la del ojo, hoy sabemos que la cosa es muy diferente de como pensaban Empédocles y compañía en este aspecto.

Aunque no postulase hipótesis sobre la naturaleza de la luz, no puedo dejar de mencionar a otro genio, Arquímedes de Siracusa –más conocido por su principio que por esto–. De acuerdo con los relatos posteriores, cuando los romanos sitiaban Siracusa entre 214 y 212 a.C. Arquímedes empleó todo tipo de argucias científico-ingenieriles para ponerles freno. Tanto es así que, al parecer, cuando los barcos romanos veían cualquier signo de vigas, poleas, espejos u otros artilugios sospechosos sobre las murallas de la ciudad, ponían pies en polvorosa.

Grabado de los espejos de Arquímedes, en la Óptica de Alhacén de la que hablaremos luego.

Entre las faenas de Arquímedes contra los romanos parece haber estado el uso de la luz del Sol, reflejada de alguna manera. Las historias más fantasiosas hablan de la concentración de rayos solares sobre los barcos hasta hacerlos arder, aunque conseguir esto es realmente difícil. Versiones más moderadas hablan del uso de espejos no para quemar los barcos, sino para deslumbrar a los marineros y hacerlos menos eficaces. Muy probablemente Arquímedes dispuso muchos espejos –seguramente escudos de bronce o similares– apuntando al mismo barco y consiguiendo así enfocar la luz solar hasta cierto punto. Sea como fuere, no se trató tanto de una especulación teórica sobre la naturaleza de los rayos solares como un uso práctico de la reflexión –que es uno de los fenómenos luminosos más fáciles de predecir y explicar–.

Quien sí fue un teórico de tomo y lomo y propuso una idea nueva y diferente de la de los helenos fue otro científico de la Antigüedad, en este caso un romano. Se trataba de un atomista, Tito Lucrecio Caro. Alrededor de 55 a. C. este individuo de intuición maravillosa, en su De rerum natura (Sobre la naturaleza de las cosas), dice más o menos esto (no es una cita, pues el original es un poema algo farragoso, sino que está dicho con mis pobres palabras):

Los objetos más ligeros y sutiles, compuestos de los átomos más pequeños, son a menudo los que se mueven más rápido. Esto sucede con la luz y el calor del Sol, formados por minúsculas partículas que se mueven sin impedimento a través de los intersticios del aire, golpeados a su vez por los que vienen detrás.

Como digo, esto es de una intuición que deja la boca abierta. En la concepción de Lucrecio –una vez más indemostrable por experimento alguno que pudiera realizarse en el siglo I a.C.–, a diferencia de la de Aristóteles, la luz está formada por minúsculas partículas que se mueven a una velocidad gigantesca. Sí, está equivocado al pensar que unas partículas se mueven empujadas por las que vienen por detrás, pero la conjetura del romano me deja sin palabras.

El siguiente en decir algo novedoso sobre la luz fue otro genio, Herón de Alejandría, que vivió en el siglo I d.C. Nos encontramos ya, por tanto, en la época helenística, pero sigue siendo la misma cultura la que avanza en el conocimiento de la luz –y en casi todos los demás, para qué vamos a engañarnos–. En su Catoptrica el alejandrino examinó cuidadosamente la propagación de la luz, la reflexión y la trayectoria de los rayos luminosos. Su principal contribución fue una forma primitiva del principio del mínimo camino óptico (posteriormente llamado principio de Fermat): un rayo de luz que se propaga por un mismo medio seguirá el camino más corto entre dos puntos dados.

Esto puede sonar como una estupidez, pero el de Alejandría no sólo se refiere al hecho de que el camino más corto entre los puntos A y B es una recta y por lo tanto la luz se propaga en línea recta. No: Herón incluye en este principio la luz que se refleja en uno o más espejos, y esto supone un avance fundamental en el modo de mirar el problema, si no en las conclusiones.

La mejor manera de comprender la relevancia del principio de Herón es con un ejemplo. Si, por ejemplo, sabemos que un rayo de luz parte de A y llegará a B tras reflejarse en un espejo en algún punto C, ¿cuál será ese punto C? ¿Será C1, C2 o C3? Cada punto determinaría una trayectoria diferente para el rayo:

Si se miden las tres longitudes, la que pasa por C2 es la más corta de las tres, de modo que de acuerdo con el alejandrino ésa será la trayectoria del rayo. Dicho en términos más modernos, el ángulo con el que incide la luz sobre el espejo es idéntico al ángulo con el que se refleja. Pero la importancia de este principio de mínimo recorrido de Herón es doble por lo que significa, sobre todo por la segunda razón:

Suponer que la luz sigue una trayectoria sugiere que Herón pensaba que era algo que se movía, aunque fuera incapaz de determinar su velocidad.

Supone el primer tratamiento matemático del comportamiento de la luz que produce una predicción concreta. En esto, como en muchas otras cosas, Herón fue único para su época. Este punto merece que nos detengamos en él.

Donde los filósofos anteriores habían especulado de manera cualitativa, Herón realiza una predicción concreta, medible y comprobable experimentalmente: basta tomar una fuente de luz, asegurar que incide sobre cierto punto tras reflejarse en un espejo y luego verificar en qué punto del espejo se produce la reflexión –existen varias maneras de hacer esto y dejo al paciente lector que piense en alguna para ejercitar las neuronas–.

Desde luego, Herón es incapaz de explicar por qué la luz hace eso, ni tampoco predice qué sucederá si la luz se refracta entrando en el agua o en un cristal, pero el paso hacia delante ya se había dado. No hacía falta más que continuar el camino marcado por él.

Curiosamente el siguiente paso fue dado casi inmediatamente después y exactamente en el mismo sitio, Alejandría –lo cual no es sorprendente ya que por entonces esa ciudad era el centro de la ciencia mundial–, por otro científico muy conocido: Claudio Ptolomeo. Como parece estar siendo frecuente en este artículo, Ptolomeo es mucho más conocido por algo diferente, su modelo geocéntrico del Universo como modificación de los anteriores. Sin embargo, el de Alejandría se dedicó también a muchas otras cosas, y entre ellas al estudio de la óptica.

Al igual que Herón, Ptolomeo se limitó a describir cómo se comporta la luz en ciertas situaciones, no a especular sobre por qué lo hace. Por lo tanto podríamos llegar a la conclusión –errónea en mi opinión– de que no aportó nada al estudio de la naturaleza de la luz. Sin embargo, la descripción detallada y minuciosa de un fenómeno es uno de los pasos esenciales para comprender las razones que hay detrás. La clave es recordar que la Ciencia es un proceso colectivo: que uno no consiga extraer las conclusiones no quiere decir que no pueda establecer las bases sobre las que otro –con mejores herramientas, más capacidad o simplemente más suerte– pueda llegar al final de la carrera.

Claudio Ptolomeo publicó un tratado, Óptica, en el que muestra el mismo estilo que en casi todo lo demás que hizo: no plantea ideas nuevas o revolucionarias, pero perfecciona lo que existía anteriormente. En cierto sentido es un compilador de conocimientos anteriores, pero también filtra, aclara, detalla y en algunos aspectos –no muchos– amplía. Nuestra inmensa fortuna es, por un lado, que esta obra fue traducida al árabe –y volveremos a mencionarla precisamente por eso dentro de un rato–, de modo que la conservamos hoy en día.

Por otro, Ptolomeo es una fuente extraordinaria para conocer el “consenso científico” de la época. Imagina el lugar: Alejandría era el centro de conocimiento académico absoluto en el mundo, y su Biblioteca contenía las mejores referencias en prácticamente todo. Desde luego, en cuanto a libros de filosofía natural no existía absolutamente nada que pudiera comparársele. Además, allí se congregaba un número sin igual de científicos –atraídos, en gran medida, precisamente por la misma Biblioteca– que discutían sobre prácticamente todo.

Por lo tanto, la Óptica de Ptolomeo es un lugar estupendo donde detenernos un momento para comprender la visión general de los científicos del siglo I d.C. acerca de la luz –y esto es importante porque no habría otro avance hasta el siglo X–. Aunque había pequeños desacuerdos, las ideas generales eran las siguientes:

La luz es emitida por fuegos diversos, divididos en dos tipos: el del interior del ojo y los objetos calientes.

Esa luz se transmite en línea recta siempre que no cambie de medio, ya que si lo hace cambia de dirección (aquí fue donde Ptolomeo hizo su propia contribución, de la que hablaremos en un momento).

La visión se produce cuando los rayos internos emitidos por el ojo interaccionan con los externos emitidos por otros fuegos.

La posición de las cosas es determinada por el ojo dependiendo del ángulo que forman los rayos internos unos con otros.

La naturaleza de las cosas –por ejemplo, su color– es determinada por el ojo dependiendo de la naturaleza de los rayos externos con los que interaccionan los internos.

En lo que Ptolomeo avanzó sin duda más allá que Herón fue en el estudio de lo que le sucede a la luz al cambiar de medio, es decir, al sufrir refracción, por ejemplo en el paso del aire a un vidrio o al agua y viceversa. Como recordarás, Herón se había limitado a determinar el comportamiento de la luz reflejada, no refractada.

Lo mismo que Herón, Ptolomeo desafía nuestra imagen del científico griego –y por más que vivieran en el moderno Egipto y en una época más bien tardía, ambos eran de cultura griega–: realizó multitud de cuidadosos experimentos. A diferencia de Herón, Ptolomeo no enunció sus leyes en función de la distancia recorrida por los rayos, sino del ángulo. Para determinar los ángulos que formaban los rayos con las diversas superficies –dentro y fuera del agua, por ejemplo– construyó recipientes con muescas equiseparadas.

Los cuidadosos experimentos de Ptolomeo lo llevaron a varias conclusiones. Por un lado, se dio cuenta de que el cambio de dirección de los rayos tenía que ver con la densidad de los materiales. Si el cambio de densidad de un medio a otro era ligero (por ejemplo, del agua al vidrio o viceversa) el cambio de dirección también lo era, mientras que si el cambio de densidad era brusco (como del aire al agua o al revés) el rayo cambiaba de dirección también bruscamente.

Claudio Ptolomeo, en un grabado barroco.

Aunque Ptolomeo realizó meticulosas tablas con los ángulos de incidencia y refracción, no consiguió una ley matemática que relacionase ambos. Si el rayo era casi perpendicular a la superficie de separación de los medios, los ángulos de incidencia y refracción parecían ser casi proporcionales, pero esta proporcionalidad se perdía para ángulos más grandes. Desde luego, el de Alejandría no sabía por qué pasaba esto, pero su trabajo sirvió de trampolín para científicos posteriores.

Desgraciadamente hay muy poco que contar entre el siglo I y el X. Hubo que esperar a que surgiera una nueva Alejandría, en el sentido de un centro de saber y discusión en el que germinase nuevo conocimiento, y ese lugar fue Bagdad. Allí, durante el esplendor abásida, multitud de científicos recuperaron gran parte del saber griego –entre otras cosas la Catoptrica de Herón y la Óptica de Ptolomeo– y, además de guardar nuevas copias para la posteridad, realizaron sus propios avances.

Estos científicos musulmanes no dieron importancia, como casi nadie antes, a la hipótesis atomista de Lucrecio, y siguieron considerando la luz como rayos –nada más allá– que se propagaban en línea recta por el espacio, lo mismo que Ptolomeo. Para que te hagas una idea de la importancia que dieron los califas abásidas a las obras griegas en general y a Ptolomeo en particular, en uno de los tratados que firmaron con el Imperio Bizantino aparecía el siguiente punto: Constantinopla proporcionaría a la Casa de la Sabiduría de Bagdad –el equivalente a la Biblioteca de Alejandría– una copia del Almagesto de Ptolomeo. ¡Era un tesoro de tal categoría que era utilizado en la negociación política!

De modo que Ptolomeo se convirtió en la base de la concepción abasí sobre la luz. Sin embargo, el consenso entre ellos eliminó una parte de la teoría híbrida de absorción-emisión de Ptolomeo y sus coetáneos: de acuerdo con los científicos de Bagdad del siglo X, la visión se debe únicamente a la entrada en el ojo de rayos luminosos. Ya no hay rayos emitidos por los ojos.

Además, casi todos estaban de acuerdo en que la luz se propagaba por el espacio, no como pensaba Aristóteles que inundase todo instantáneamente. Uno de ellos, Abū Rayhān al-Bīrūnī, aunque fue incapaz de medir la velocidad de la luz, postuló una hipótesis muy razonable: ya que al observar un fenómeno más o menos lejano, como un rayo, se ve el suceso antes de oírlo, la luz debe ser muchísimo más rápida que el sonido.

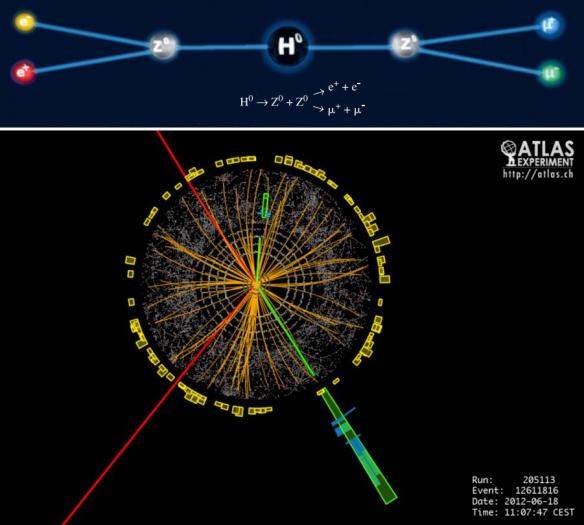

Otro, Abu Saʿd al-ʿAlaʾ ibn Sahl, enunció utilizando triángulos rectángulos y las relaciones entre catetos e hipotenusas la ley de la refracción, que desgraciadamente conocemos hoy como ley de Snell (luego veremos en honor a quién). Ibn Sahl detalló el diseño y construcción de espejos parabólicos, lentes biconvexas y planoconvexas y, en general, desarrolló la óptica de Ptolomeo hasta límites que hubieran hecho salivar al alejandrino.

Diagrama de refracción del manuscrito de Ibn Sahl, publicado en 984.

Mucho más importante que los dos anteriores fue Ibn al-Haytham, más conocido en Occidente como Alhacén. Escribió entre 1011 y 1021 un tratado de óptica en siete volúmenes, traducido al latín como Opticae Thesaurus, algo así como Enciclopedia de Óptica, que supuso la desaparición absoluta de la idea de rayos emitidos por el ojo.

Alhacén argumentó de la siguiente manera: es posible comprobar situaciones en las que rayos luminosos externos dañan al ojo, por ejemplo al mirar una luz muy brillante. Sin embargo, nadie ha observado jamás que los rayos del interior del ojo alteren en modo alguno lo que hay fuera de él al mirarlo. Por lo tanto no hay razón que haga pensar que el ojo emite nada, y muchas para pensar que los objetos externos emiten algo.

Además, Ibn al-Haytham diferenció dos tipos de luz: la luz primaria y la luz secundaria. Los objetos que brillan por sí mismos emiten el primer tipo. Todos los demás objetos, al recibir luz primaria, emiten a su vez luz secundaria –cuánta y de qué tipo depende de la naturaleza de cada objeto–. Aunque podemos ver ambas con el ojo, no es posible que exista la luz secundaria sin que lo haga la primaria, de modo que ésta es necesaria para la visión.

Portada de una traducción al latín del séptimo volumen de la Óptica de Alhacén, en una edición de 1574.

Alhacén fue incluso más allá: dado que infinitos rayos luminosos entran en el ojo, ¿cómo es posible que veamos imágenes nítidas y no un batiburrillo de luz difusa? Porque los rayos que inciden sobre el ojo lo hacen con diversos ángulos, y sólo los que penetran perpendicularmente a la córnea pueden alcanzar el fondo del ojo; los otros se refractan dentro y no alcanzan el final del camino. No me negarás que, independientemente de la corrección de sus conclusiones, el tipo no era de un genio extraordinario. Más importante que las conclusiones, por supuesto, es el hecho de que Alhacén las basaba en observación y razonamiento.

¿Qué hacían los europeos mientras Bagdad publicaba colecciones enteras de óptica? Poco más que traducirlas al latín. No es que nadie hablase sobre el asunto –lo hicieron John Pecham, Roger Bacon, Vitelo y otros–, pero realmente no merece la pena siquiera que nos detengamos en lo que dijeron. Sus ideas, aunque influenciadas por los científicos musulmanes, estaban mezcladas con neoplatonismo, superstición y filosofía barata, y no tenían suficiente rigor, base empírica ni fundamento en la razón.

Irónicamente, con el tiempo la ciencia islámica declinó y fue en gran medida ahogada por el fundamentalismo religioso, mientras que en Europa sucedió exactamente al contrario y la libre discusión de ideas filosóficas y científicas fue en aumento, especialmente a partir del Renacimiento. También irónicamente la herencia griega no llegó a Europa occidental desde la propia Grecia –a través de Constantinopla–, sino de traducciones del árabe que habían sido, a su vez, traducidas del griego. Lo bueno de esto es, por supuesto, que las concepciones de los libros en árabe eran refinamientos de las griegas, con lo que nuestra base fue más sofisticada de lo que hubiera sido de otro modo.

El incomparable Galileo Galilei, de hecho, hizo un intento por avanzar en la idea de al-Bīrūnī de que la luz viaja más rápido que el sonido. El italiano diseñó un experimento para medir la velocidad de la luz, el primero del que tengo noción. Si eres tamicero añejo has leído ya largo y tendido sobre Galileo, y no tengo que repetir aquí mi admiración por él. En este caso fracasó, pero se trataba de un problema muy difícil y su intento es de todos modos tan delicioso que lo tengo que contar.

Galileo pensó en lo siguiente: mirar un suceso lejano, como hizo al-Bīrūnī, y comprobar que lo vemos antes de escucharlo, sólo lleva a la conclusión de aquél, es decir, que la luz es más rápida que el sonido. Galileo habla de esto en su inefable Discorsi e dimostrazioni matematiche, intorno à due nuove scienze (Discursos y demostraciones matemáticas en torno a dos nuevas ciencias). Allí menciona el caso de un disparo de cañón y el tiempo que pasa entre ver la llamarada y oír el disparo.

¿Cómo medir la velocidad de algo como la luz que es más rápido que cualquier otra cosa conocida? Galileo dio con la solución. Su experimento consistía en tomar dos linternas cubiertas, y llevar una a una gran distancia de la otra. Un experimentador descubriría su linterna al mismo tiempo que empezaba a contar el tiempo; cuando el otro viera la luz descubriría la suya, y cuando el primero viera la luz del segundo detendría la cuenta del tiempo. De este modo, el tiempo que transcurriese medido por el primer observador permitiría, conocida la distancia entre las dos linternas, calcular la velocidad de la luz.

Galileo Galilei (1564-1642).

Galileo no tuvo éxito por más lejos que puso las linternas, entre otras cosas porque no disponía de relojes lo suficientemente precisos. No pudo más que llegar a la conclusión de que era algo muy, muy rápido. Pero ¿no es magnífico su razonamiento? Introduce la experimentación cuidadosa, el cálculo matemático para alcanzar conclusiones y, en mi opinión, lo más grande de la idea: medir la velocidad de algo más rápido que cualquier otra cosa sin recurrir a nada más que el propio fenómeno que estamos observando. Como siempre, este sinvergüenza de Pisa me deja sin palabras.

Otro científico de principios del XVII dedicado al estudio de la luz fue el holandés Willebrord Snellius. Francamente, no mencionaría a Snellius si no fuese porque, a pesar de ser sólo uno de los que obtuvo lo que hoy conocemos como ley de la refracción, por alguna razón en casi todo el mundo se la conoce como ley de Snell en su honor. Ya hemos dicho antes que Alhacén la obtuvo unos cuantos siglos antes que él –aunque algunos científicos europeos no la conocían–. Además, versiones equivalentes a la de Snellius fueron obtenidas casi al mismo tiempo por Descartes y Fermat. Pero, a veces, la historia de la ciencia es así de injusta, y Snellius ha recibido el crédito –aunque creo que en Francia se la conoce como ley de Descartes–.

Snellius no es muy importante en esto –menos aún que Galileo– porque intentó determinar cómo cambiaban los rayos de luz al cambiar de medio, pero no atacó el problema fundamental: ¿qué eran esos rayos?

A eso se dedicó precisamente René Descartes, pero aquí surge el primer duelo entre hipótesis luminosas de la ciencia moderna –el primero de varios–, ya que otro francés, Pierre Gassendi, propuso una idea opuesta a la de Descartes. De ese primer duelo, Descartes versus Gassendi, y de muchas otras cosas más, hablaremos en la segunda parte del artículo, si es que aún te quedan ganas.

El histórico cine Urgel, propiedad del Grupo Balañá, cerrará sus puertas el próximo 30 de mayo, por falta de rentabilidad económica de la sala, que, con 1.832 butacas, es la más grande de Barcelona, según han informado fuentes del sector de la exhibición.

Más detalles sobre el cierre de esta sala, en HoyCinema.com

...

El histórico cine Urgel, propiedad del Grupo Balañá, cerrará sus puertas el próximo 30 de mayo, por falta de rentabilidad económica de la sala, que, con 1.832 butacas, es la más grande de Barcelona, según han informado fuentes del sector de la exhibición.

Más detalles sobre el cierre de esta sala, en HoyCinema.com

...