Shared posts

Bailando con Saturno

Cassini de desplaza a una media de 2.4 Kilómetros/Segundo con respecto a Saturno, aunque en ocasiones, como ocurrirá el próximo 9 de Abril, cuando afronte una de sus mayores aproximaciones al planeta de los últimos años, puede multiplicarse, y ese día en concreto llegará hasta los 9 Kilómetros/Segundo. Unas velocidades asombrosas que hacen que las imágenes que nos envía habitualmente sean en forma de tomas cortas, increiblemente hermosas pero congeladas en el tiempo.

Afortunadamente podemos apreciar la compleja danza de Cassini entre Saturno y sus lunas gracias a secuencias de imágenes fijas, encadenadas formando animaciones simples. En ocasiones como parte de una serie de observaciones de rutina de las que se saca un rendimiento no programado, pero en muchas otras planificadas de forma expresa para lograr este tipo de secuencias, este tipo de "magia" en movimiento es posible gracias a los equipos de ingeniería y ciencia que trabajan en esta misión, que se coordinan para construir una serie de instrucciones minuciosamente precisos que posteriormente son enviadas. Cassini se encarga del resto, girando y haciendo todo tipo de maniobras para orientar sus cámaras de forma que puedan captar sus objetivos pasando entre ellos a gran velocidad.

Como resultado podemos disfrutar de lo más cercano a tener una visión en movimiento de Saturno y su complejo sistema de lunas y anillos, limitadas pero pese a ello espectaculares, y que dotan a las ya de por sí maravillosas fotografías de Cassini de una profundidad temporal que aún magnifica lo que esta ya veterana sonda significa para la exploración planetaria.

La pequeña Encelado moviéndose entre las estrellas de fondo, con sus geisers claramente visibles.

Dione desplazándose por delante del planeta y la sombra que los anillos proyectan sobre el.

El reflejo del Sol sobre los brillantes anillos.

La pequeña luna pastora Prometheus dejando su caótica huella gravitatoria en el anillo F.

Aproximándose a las iluminadas capas atmosféricas de Titán.

La pequeña luna Epimetheus seguida por las cámaras de Cassini.

Siguiendo el desplazamiento de Mimas.

Dancing With Saturn

Los bebés no toman el pecho como creíamos

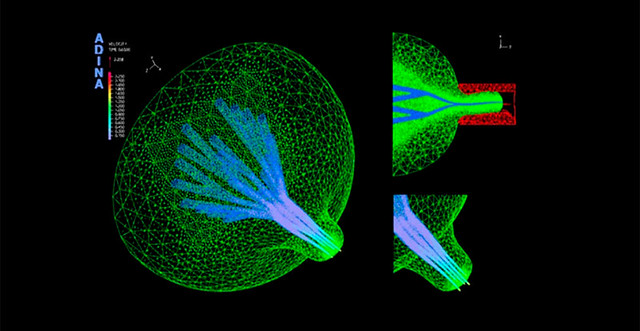

La manera en que el bebé consigue extraer la leche del pecho de su madre durante la lactancia ha sido objeto de debate durante más de un siglo. Las últimas evidencias muestran que el secreto no está en la presión de la mandíbula del niño sobre el pezón, sino en el sistema de vacío que se crea en la cavidad bucal durante el proceso. La última prueba la presentan esta semana en la revista PNAS un equipo de científicos encabezados por el israelí David Elad, quienes han analizado el proceso mediante imágenes por ultrasonido.

Leer más y ver vídeo en: Los bebés no toman el pecho como creíamos (Next)

Tenemos un universo, tenemos un problema

Durante los últimos días, y a causa del descubrimiento del BICEP2 de algo llamado polarización en modos B de la radiación cósmica de fondo, han habido dimes y diretes en relación a la existencia de un universo, de un multiverso y de otras cosas al respecto.

Durante los últimos días, y a causa del descubrimiento del BICEP2 de algo llamado polarización en modos B de la radiación cósmica de fondo, han habido dimes y diretes en relación a la existencia de un universo, de un multiverso y de otras cosas al respecto.

Pues bien, yo aquí he venido a sincerarme… A pesar de haber estudiado cosmología una temporadita de mi vida, he venido a confesar que no tengo ni puñetera idea de la mayoría de las cosas de las que se hablan en este contexto. Todo lo que puedo decir es que actualmente la física teórica está plagada de ideas lo suficientemente locas y atrevidas como para sorprender al más pintado. Además, estas ideas polarizan las opiniones de físicos, aficionados y de los que pasaban por allí. El problema en mi opinión, y sí, esta es mi opinión personal, es que nadie pone énfasis en qué es lo aceptado teórica y experimentalmente, es decir, fuera de toda duda (fuera de toda duda en ciencia se traduce por: estamos bastante seguros mientras no se demuestre lo contrario), y lo que son puras elucubraciones teóricas asociadas a los modelos que estamos usando para describir la realidad que nos rodea (por favor, uso realidad en el sentido de la calle, no estoy haciendo ontología, axiología, teleología o cualquier otra logía que se os ocurra).

Por lo tanto, voy a poner aquí unas cuantas cosas que me llevan de cabeza en este tema. Son cosas que si las piensas dos veces tienes tres opiniones distintas, por eso procuro pensarlas solo una vez y, la mayoría de las veces, media vez. Voy a procurar seguir la siguiente estructura:

- El título de las secciones será alguna idea cosmológica.

- Intentaré decir y fundamentar si la idea es aceptada (comprobada con mayor o menor grado) o no lo es. Algunas, directamente son ideas falsas que pululan por ahí.

- Procuraré explicar, en la medida de lo posible y lo más llanamente que sea capaz, de dónde viene la idea y qué importancia tiene.

Espero que esto le sirva a alguien, a mí me servirá para poner orden en mi cabeza.

El big bang fue la explosión de un punto que lo contenía todo

Estado de la idea:

Hoy día tenemos múltiples evidencias de que nuestro universo se está expandiendo. Además sabemos que lo está haciendo de forma acelerada. Por lo tanto podemos hacer la siguiente cadena de razonamientos:

Hoy día tenemos múltiples evidencias de que nuestro universo se está expandiendo. Además sabemos que lo está haciendo de forma acelerada. Por lo tanto podemos hacer la siguiente cadena de razonamientos:

- Si todo está separándose de todo (y aquí por todo tenemos que entender las galaxias) en el pasado todo estaba más junto, más cerca.

- Si extrapolamos esta situación llegamos a la conclusión de que tuvo que haber un instante en el que toda la materia/energía que conocemos estaría concentrada en un único punto.

A eso se le han dado varios nombres, big bang, huevo cósmico, etcétera.

La idea por tanto nos lleva a pensar que todo lo que existe pre-existía contenido en un punto. Pero aquí vienen varios problemas, ese punto tendría una densidad infinita y una temperatura infinita. Lo que es aún más grave, la expansión del universo involucra la propia expansión del espaciotiempo. Es dicha expansión del espaciotiempo lo que “arrastra” a las galaxias que están en su seno. Por lo tanto, ese huevo cósmico también contenía todo el espaciotiempo. Nada existía fuera de él.

El origen del universo se plantea en este contexto como la “explosión” de este huevo. Esta imagen ha pululado y se ha asentado en el imaginario popular echando profundas raíces. Sin embargo, es una imagen falsa y sin sentido físico. Las razones son las siguientes:

a) Si todo estaba contenido en un punto con propiedades infinitas de densidad y temperatura nuestras leyes de la física no pueden describir ese sistema. El susodicho huevo no es algo físico.

b) No tenemos ninguna explicación ni razón para que dicho huevo “explotara” generando el universo.

c) Hoy sabemos que la materia como la vemos hoy día no es como ha sido siempre durante la evolución del universo. En los experimentos de alta energía hemos visto como la materia se comporta de formas extrañas y exóticas cuando está en un ambiente de alta energía. En la evolución del universo, al estar más y más comprimido la temperatura sería más y más alta. Por tanto la energía disponible en el ambiente sería tal que las formas en las que se presentaba la materia tendrían poco que ver con la materia que estamos acostumbrados a ver a nuestro alrededor. Esto quiere decir que aún no sabemos que había justo en los primerísimos instantes del universo.

Cuando un científico habla del big bang habla de la historia del universo sin especificar su origen. Asumimos que tuvo un origen, no podemos explicar el mismo, pero si podemos explicar su evolución.

¿Qué cosas hemos predicho sobre el universo y su evolución?

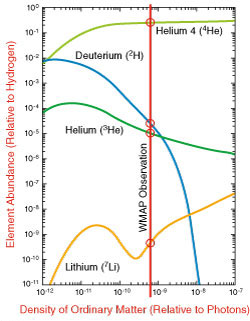

a) La teoría del big bang, como teoría de la evolución del universo sin entrar en su origen, ha predicho las proporciones de los primeros elementos químicos, hidrógeno, helio, litio, etc.

b) Ha permitido entender la estructura a gran escala del universo. La forma en la que se distribuyen las galaxias en el universo.

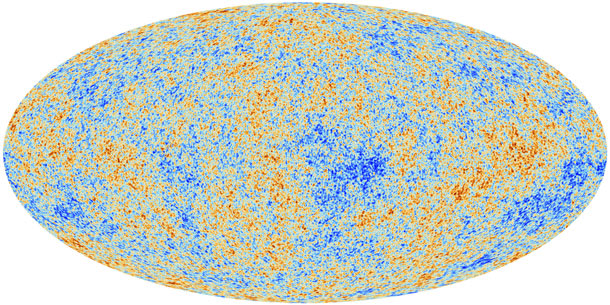

c) Y quizás lo más impactante, predijo la presencia de una radiación cósmica de microondas que nos llegaba desde todas las direcciones. Esta radiación tendría que tener la misma energía en todos los puntos salvo por fluctuaciones de una parte en 100.000.

La radiación cósmica de fondo es la mejor fuente de información que tenemos para contrastar nuestros modelos y para hacer observaciones sobre características que adquirió el universo temprano. Cada vez somos capaces de hacer mejor medidas sobre dicha radiación y de extraer más y mejor información sobre el universo.

El universo tiene un tamaño de… El universo es infinito

En muchas ocasiones nos hablan sobre el tamaño del universo. En muchas otras nos dicen que el universo es infinito. ¿Nos toman el pelo?

La respuesta es, no.

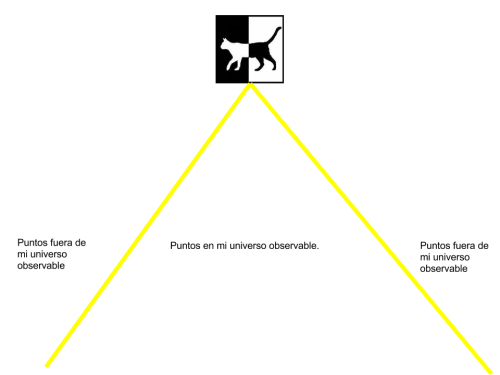

Cuando nos hablan del tamaño del universo nos están hablando del universo observable. El universo que es accesible a nosotros. Y tenemos que recordar que solo podemos tener conocimiento de un suceso o localización de algo en el universo si ha dado tiempo a que nos llegue información sobre dicho suceso o localización. Sabemos que la información se traslada por el universo con una velocidad que a lo sumo es la velocidad de la luz en el vacío. Por tanto, esto hace que tengamos regiones de las que podemos tener conocimiento y otras de las que no.

La región de universo observable tiene un tamaño finito. El tamaño viene dado por la distancia máxima que han podido seguir los rayos de luz en la vida del universo.

La región de universo observable tiene un tamaño finito. El tamaño viene dado por la distancia máxima que han podido seguir los rayos de luz en la vida del universo.

¿Hay más universo fuera de mi universo observable? Pues no podemos estar seguros, no sabemos lo que hay ahí fuera, ni tan siquiera si hay algo. Sin embargo, podemos suponer que no estamos en ningún sitio especial del universo así que si nos movemos a un punto distante, a otra galaxia, nuestro universo observable cambiaría. Es de suponer que no encontraremos una barrera donde el universo acabe bruscamente. Así el tamaño del universo “completo” (observable + no observable) podría ser infinito.

De hecho, hoy día sabemos que nuestro universo se está expandiendo de forma acelerada. Hay una sutil relación entre este hecho y las posibles “formas geométricas” y “tamaños” del universo completo (no solo el observable). Lo que ahora asumimos en cosmología es que nuestro universo completo es infinito en extensión espacial, siendo nuestro universo observable un parche de universo, al que podemos acceder por observaciones.

Para concluir,

Nuestro universo puede ser infinito en extensión espacial. De ese universo solo podemos acceder a una pequeña parte conocida como “universo observable”.

El universo pasó por una fase de expansión muy, muy rápida llamada inflación

Estado de la idea:

Esta idea está hoy día aceptada por los datos acumulados en distintas misiones de observación cosmológica.

Lo que nos cuenta es que el universo pasó un proceso de expansión exponencial y salvaje en los primeros instantes de su vida. Este proceso es capaz de explicar una serie de detalles que pasamos a mencionar:

a) El universo es homogéneo a gran escala. El universo se presenta homogéneo, tan homogéneo que solo hay variaciones en la densidad del mismo en una parte en 100.000. Esto es justo lo que se ve en la radiación cósmica de fondo.

Esta homogeneidad no hace referencia a escalas pequeñas, sistema solar o galaxias, hay que ir a escalas mucho más grandes donde los elementos más pequeños distinguibles serían cúmulos o supercúmulos de galaxias. Entonces el universo se muestra como una pasta homogénea con pequeños grupos despreciables.

Con la teoría del big bang no era posible tener un universo tan homogéneo sin que el estado inicial del universo “hubiera sido seleccionado con una precisión exquisita”. Pero dado que no hay ningún mecanismo que haga esa selección de forma natural tendríamos que pensar que nuestro universo empezó de una forma arbitraria. Hawking y compañía demostraron en la década de los 70 que no hay ninguna posibilidad de acabar con un universo tan homogéneo como el que vemos si empezamos con unas condiciones iniciales arbitrarias.

La inflación soluciona esto de una forma simple y elegante, da igual con que situación inicial empieces, tras la expansión brutal que implica la inflación siempre acabarás con una distribución homogénea con pequeñas variaciones. La inflación tiene como efecto tamizar el universo.

b) La inflación también predice que tenemos que ver distintas características en la radiación cósmica de fondo. Hay una cosa en la radiación cósmica de fondo que se denomina multipolos. Distintos modelos cosmológicos describen de forma diferente la forma en la que se presentan dichos multipolos en la radiación. Lo que se encuentra es:

Diferentes curvas de distintos colores corresponden a distintos modelos cosmológicos. La curva roja es la que mejor ajusta a los datos observacionales y es la que predice la inflación (los modelos más sencillos con constante cosmológica).

Además, la inflación explica de dónde procede la materia que observamos en el universo. Inicialmente se produce un proceso de expansión inflacionaria y llegado un momento esta inflación se detiene, se frena, y en el proceso de frenado se libera energía que se transforma en las partículas y en los campos cuya evolución dio lugar al universo que conocemos.

La inflación no modifica al big bang (historia de la evolución térmica del universo), lo complementa y lo amplía explicando algunas cosas que la teoría originaria no podía explicar.

Evidentemente, la teoría inflacionaria no está libre de problemas:

a. Hay, literalmente, cientos de modelos inflacionarios con distintos modos en los que la inflación empieza y acaba. Afortunadamente dan lugar a distintas predicciones sobre distintos observables y ahora estamos en disposición de eliminar aquellos cuyas predicciones no coinciden con la observaciones experimentales.

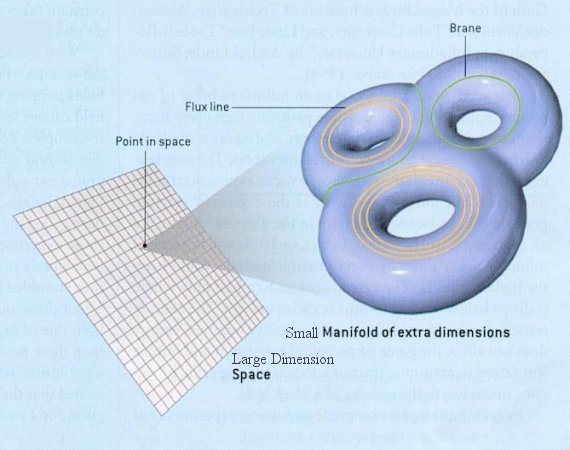

b. Los modelos inflacionarios tienen una extensión metafísica, parecen implicar que nuestro universo solo es una parte de algo mayor llamado multiverso. Ahora hablaremos de eso con más detalles.

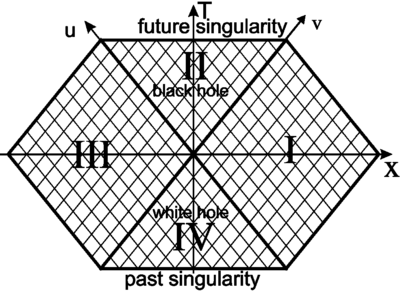

Nuestro universo no es más que un miembro de un multiverso

Estado de la idea:

La idea es que nuestro universo forma parte de algo mayor, el multiverso. Este multiverso es un conjunto de universos desconectados entre sí y que, hipotéticamente, no pueden tener contacto unos con otros.

Esta idea aparece en varias teorías físicas, y no tiene su origen en ideas esotéricas o mágicas, se extrae de teorías físicas que están siendo, en su mayoría, comprobadas observacionalmente o que tienen suficiente entidad teórica como para intentar comprobarlas desde el punto de vista experimental. Ejemplos de teorías que conducirían a la idea de multiverso son la teoría de cuerdas, la inflación, la teoría cuántica, etc.

Aquí describiremos el multiverso inflacionario. Para ellos necesitamos explicar algunos conceptos previos.

El vacío

El vacío en física no es la nada absoluta, es un estado físico de los sistemas que está bien definido y que tiene propiedades particulares que le posibilitan interactuar con otros estados de diversos sistemas. Es decir, el vacío es algo bien definido en física y no implica la ausencia de todo.

En teoría cuántica los campos como el campo electromagnético está asociado a la presencia de unas determinadas partículas, los fotones. Así podemos decir:

Sabemos que en una región hay campo electromagnético porque hay fotones. Si en una región encontramos fotones sabemos que hay campo electromagnético.

Esto pasa con todos los campos cuánticos conocidos, el Higgs, el electromagnético, el débil, etc. Cada uno de ellos tiene sus propias partículas asociadas con características propias del campo al que están asociadas.

La primera noción que podemos tener del vacío es la siguiente:

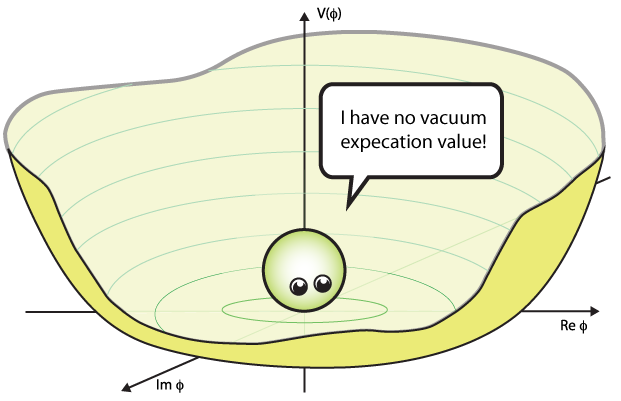

El estado de vacío cuántico de un campo es el estado de mínima energía del mismo y que tiene ausencia de sus partículas asociadas.

Así, el campo electromagnético estará en el vacío si tenemos una situación en la que no hay fotones y por tanto el campo electromagnético está en su estado de mínima energía.

Esto es lo que sucede con la mayoría de los campos conocidos.

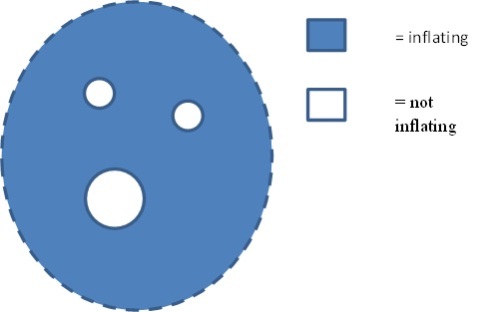

Si representamos el campo por una bola y sus posibles energías por una superficie, la situación de vacío es que el campo (la bola), esté en el mínimo de energía:

Sin embargo, hay campos que pueden estar en la situación de no tener partículas asociadas presentes y no estar en su mínima energía.

Cuando el valor esperado del vacío es nulo (vacuum expectation value) no hay partículas presentes del campo, sin embargo el campo no está en su mínima energía. Esta situación es la que presenta por ejemplo el campo de Higgs. Cuando un campo está en esta situación, energía no nula y sin partículas asociadas, se dice que está en estado de falso vacío.

Propiedades del falso vacío

La primeras propiedades del falso vacío son:

a) Al no ser el estado de mínima de energía de un sistema es inestable. Eso quiere decir que decaerá o se “desintegrará” en el estado de mínima energía propia del sistema, el estado de vacío real.

b) Al pasar del falso vacío al vacío real, la energía sobrante se transforma en otros campos y partículas.

Si metemos la gravedad de por medio una región con falso vacío tiene propiedades espectaculares:

1.- Produce una expansión enorme en dicha región. Actúa como una fuente de repulsión gravitatoria. Esto es lo que produce la inflación.

2.- Su densidad de energía no disminuye al expandirse el espacio, se mantiene contante.

¿Cómo sale el multiverso de la teoría inflacionaria?

La cadena de ideas que nos lleva al multiverso es la siguiente:

1.- Inicialmente todo era un falso vacío. Y permítanme tomar este tuit del amigo @inerciacreativa

Hijo, antes todo esto era vacío cuántico…—

Jose Cuesta (@InerciaCreativa) March 18, 2014

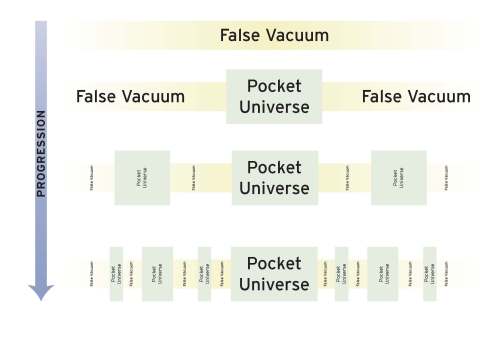

2.- Este falso vacío se expande de forma inflacionaria, así que también llamaré al falso vacío, vacío inflacionario.

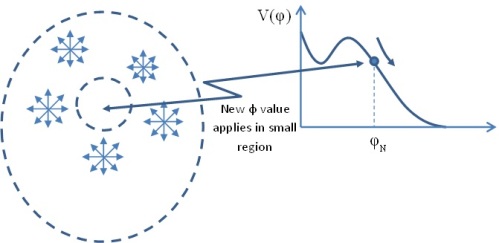

3.- Este vacío fluctúa, es decir, su valor oscila alrededor del valor de energía que le corresponde en la configuración en la que se encuentra. Las fluctuaciones son inevitables, son debido a la naturaleza cuántica del campo y del vacío inflacionario. Estas fluctuaciones modelan la forma gráfica de la energía del campo y a veces hacen que el falso vacío decaiga a un vacío real. Pero eso no tiene por qué pasar en todo el espaciotiempo a la vez, lo hará en una pequeña región. Esta región dejará de expandirse de forma inflacionaria, “sumergida” en un falso vacío que sigue expandiéndose de forma exponencial. Se crearán partículas, se fijaran las constantes físicas en función del nuevo valor del vacío y tendremos un universo. A estos universos se los denomina universo burbuja.

3.- Pero el falso vacío exterior sigue expandiéndose de forma inflacionaria. La burbuja donde se ha frenado la inflación seguirá una evolución dictada por las leyes de la física que gobiernen la materia que se ha creado en su interior. El proceso de decaimiento del falso vacío a uno real se hará por zonas, será aleatorio y continuará por siempre:

¿Estas burbujas son universos?

Teóricamente, sí.

En estas burbujas las leyes de la física se fijan por cómo haya decaído el vacío inflacionario al vacío real.

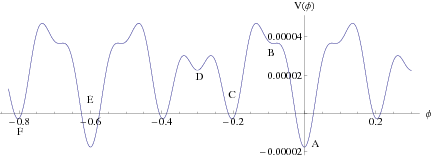

El vacío inflacionario no tiene una gráfica de energía simple, más bien es algo así:

Dependiendo del vacío inflacionario de partida y del vacío real de llegada, las leyes de la física no tienen que ser la misma en distintas burbujas. Las leyes de la física a baja energía, aquellas que controlan los procesos físicos relevantes a nuestra escala, están influídas por el valor de determinados campos en el vacío. Por ejemplo, hoy sabemos que las masas de las partículas tienen que ver con el vacío del campo de Higgs. Esto fija masas, cargas e interacciones efectivas en las burbujas, así aunque haya un conjunto de leyes físicas operando en todo el multiverso, en cada burbuja, cada vacío selecciona unas leyes físicas efectivas a baja energía distintas en cada burbuja.

Pero las burbujas están encerradas y aisladas. Bueno, el nombre burbuja, dominio, pocket, o cualquier otro es engañoso. En estas regiones la geometría puede ser infinita, no podemos pensar que son bolas sumergidas en un océano de falso vacío que se expande como loco. La matemática aquí es bellísima y nos dice que estás “burbujas”, o “dominios”, o “universos hijos”, o “universos pocket”, pueden tener geometrías tal y como entendemos la geometría de nuestro universo.

¿Se podría comprobar experimental u observacionalmente la existencia de otros universos?

Pues parece difícil, sin embargo, en física no es la primera vez que se propone algo que en principio no es comprobable y al final se ha comprobado. Empezando por los neutrinos y acabando con la tan buscada supersimetría que aún no ha dado la cara. Unas veces se ha encontrado algo que en principio era inobservable, como los neutrinos. Con los neutrinos hemos pasado de ser no observables a tener cañones que los lanzan donde queremos.

Pero dado que cabezotas hay en todos sitios y en física son especialmente abundantes:

First Observational Tests of Eternal Inflation Se plantean encontrar pruebas de las colisiones de burbujas en el multiverso mirando los datos de la radiación cósmica de fondo del WMAP. RESULTADO = NINGUNA EVIDENCIA.

Cosmological avatars of the landscape. I. Bracketing the supersymmetry breaking scale.

¿Podría nuestro universo tener alguna señal de entrelazamiento cuántico con otro universo del multiverso? RESULTADO=NINGUNA EVIDENCIA.

No haré una lista pormenorizada de cuantos trabajos hablan de observar el multiverso en datos a los que podemos o podríamos acceder.

A mí, no me gusta el tema de los multiversos por varios motivos:

1.- La principal razón es… Porque no.

2.- La segunda es que los modelos inflacionarios todavía no están libres de problemas en su definición. Por ahora se basan en modelos extrapolados de modelos efectivos, es decir, no sabemos qué campo es el que generó la inflación. Lo que parecen indicar los datos es que debe de ser un campo escalar. Afortunadamente ya hemos encontrado un campo escalar fundamental en la naturaleza, el Higgs. Eso hace más plausible encontrar otro, el inflatón, que produzca la inflación.

3.- Los argumentos gravitatorios asumen que la relatividad general es válida en el contexto inflacionario, tal vez lo sea, pero no está probado. Seguramente hay que partir de un estado anterior preinflacionario en el que una teoría de gravedad cuántica sea indispensable para saber qué genero y cómo la inflación.

Pero el modelo inflacionario nos lleva genéricamente a pensar en un multiverso del tipo explicado aquí, tendremos que seguir pensando en el tema y viendo a ver si podemos descartar o aceptar la imagen en base a datos observacionales. Al igual que tenemos que seguir buscando la energía oscura, dimensiones extra o señales de supercuerdas. Al final, como siempre en este negocio, decidirán los datos.

Para terminar:

A mí, el multiverso me parece una ordinariez.

Esta entrada ha quedado un poco larga, pero nadie dijo que fuera fácil ;)

Nos seguimos leyendo…

Archivado en: cosmología, Sin categoría Tagged: big bang, cosmología, falso vacío, inflación cosmológica, inflación eterna, radiación cósmica de fondo, vacío cuántico

![]()

"Carmina Burana", flashmob en Viena

GilbmartinezImprersionante!

Conoce tus elementos - El selenio

En la última entrega de la serie Conoce tus elementos estudiamos el de treinta y tres protones, el arsénico. Hoy lo haremos con el de treinta y cuatro protones –y por tanto, salvo que esté ionizado, treinta y cuatro electrones–, un elemento de los que han tardado en ser descubiertos hasta hace bastante poco: el selenio.

Existen varias razones para ello y si eres un veterano de la serie estoy seguro de que te hueles cuáles son. La primera es la escasez de este elemento químico en la corteza terrestre: tan sólo un 0,000 005% en masa, es decir, prácticamente nada. Esto ya supondría una dificultad para percatarnos de que existe, pero en segundo lugar el selenio es muy reactivo, de modo que no aparece puro jamás. Forma óxidos con una facilidad pasmosa, lo mismo que reacciona con casi cualquier metal para formar sales binarias, de modo que en la Naturaleza sólo aparece en forma de compuestos.

Pero, para hacerlo aún más difícil, también es casi imposible encontrar compuestos del selenio en grandes concentraciones. Dicho de otro modo, no es que haya muy pocas rocas de selenio en la corteza y haya que encontrar uno de esos raros yacimientos, es que no hay yacimientos específicos de minerales de selenio. Aparece como impureza en minerales de otros elementos similares pero mucho más comunes, de modo que para darse cuenta de que está ahí hace falta examinar esos otros minerales y percibir que hay algo extraño e inesperado en ellos.

Todas estas razones son las que hicieron que no fuéramos conscientes de la existencia del selenio hasta principios del siglo XIX. Su descubrimiento se trató, de hecho, de una casualidad, aunque era inevitable tarde o temprano según nuestra ciencia química avanzaba y nos fijábamos más en pequeños detalles que antes se nos hubieran pasado desapercibidos. El responsable fundamental fue un genio sueco que no ganó varios Nobeles por una razón muy simple: no existían aún durante su vida. Estoy hablando de un viejo conocido nuestro, Jöns Jacob Berzelius.

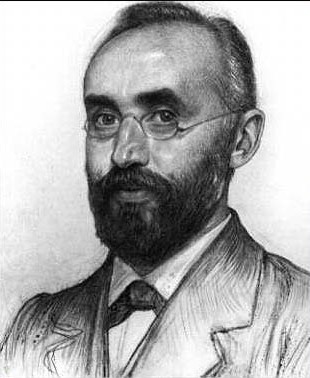

Jöns Jacob Berzelius (1779-1848).

Como digo, todo fue fruto de la casualidad. El primer laboratorio químico industrial de Suecia había sido establecido en Mariefred, en la antigua destilería del castillo de Gripsholm. Sin embargo, por las razones que fuesen, la empresa quebró y salió a subasta pública en 1816. Un químico sueco, Johan Gottlieb Gahn –a quien conocimos como descubridor del manganeso–, convenció a algunos inversores y otros dos químicos amigos suyos –H. P. Eggertz y Jöns Jacob Berzelius– para entrar en la subasta y comprar el laboratorio. Aunque Berzelius no estaba muy interesado en los negocios, imagino que poder formar parte del laboratorio industrial más importante de Suecia y el primero de todos lo tentaría mucho: tanto que aceptó y se convirtió en uno de los directores.

Aunque no estoy seguro, sospecho que Berzelius no estaba motivado sólo por la posibilidad de ganar dinero, sino también de disponer de un laboratorio bien guarnecido con el que poder realizar nuevos descubrimientos. Si así fue, tenía toda la razón, como se demostraría tan sólo un año más tarde de comprar el laboratorio de Gripsholm.

Los tres químicos cambiaron el rumbo del laboratorio –algo inteligente, ya que había quebrado–. Anteriormente se había dedicado a producir alcohol etílico para fabricar luego con él ácido acético, pero ahora empezó a producir ácido sulfúrico (H2SO4) y ácido nítrico (HNO3), aunque ahora mismo el que nos interesa más es el primero, enseguida verás por qué.

La fábrica de Gripsholm obtenía parte del azufre necesario para producir ácido sulfúrico de la mina sueca de Falun llamada Stora Kopparberg (Gran Mina de Cobre), que además del metal que le daba nombre extraía muchos otros minerales. Entre ellos se encontraban grandes cantidades de pirita (FeS2), uno de los más importantes minerales de hierro. Gripsholm usaba pirita de Stora Kopparberg y también de otras minas, pero algo extraño succedía cuando se usaba la pirita de esta mina en particular.

Stora Kopparberg (Lapplaender / Creative Commons Attribution-Sharealike 2.0 Germany License).

El proceso químico extraía el azufre de la pirita, pero la de Stora Kopparberg dejaba un residuo rojizo que no era azufre y que no aparecía en la de las otras minas: el azufre obtenido de ella era impuro. Los técnicos de Gripsholm pensaron al principio que se trataba de arsénico, algo que no sólo no tenía utilidad para ellos sino que era muy tóxico, con lo que dejaron de utilizar la pirita de Stora Koppaberg. Sin embargo, cuando Gahn y Berzelius se enteraron de esto decidieron asegurarse de que ese resto rojizo era, en efecto, arsénico.

Para ello aislaron unos 200 kg de azufre impuro de la pirita de la mina de Falun y luego separaron, a su vez, el azufre del residuo rojizo que constituía la impureza. Consiguieron así una pequeña muestra de 3 g del polvo rojizo que supuestamente era arsénico. Como puedes imaginar, no llevó mucho tiempo a dos químicos de la talla de Gahn y Berzelius –sobre todo el segundo– darse cuenta de que aquello no podía ser arsénico.

Al principio Berzelius pensó que podía tratarse de un elemento muy raro descubierto unas décadas antes, el teluro (aún no hemos llegado a él en la serie, pero se parece en muchas cosas al selenio por estar en el mismo grupo). En alguna carta inicial el sueco expresó esta sospecha. Sin embargo, como no estaba seguro, se llevó parte de la muestra de Gripsholm a su laboratorio principal en Estocolmo y allí realizó un examen más detallado. Tras ese análisis no le quedó duda: aunque se parecía al teluro, el residuo rojizo era un elemento nuevo y desconocido hasta entonces. El descubrimiento se produjo en 1817, tan sólo un año después de la compra de Gripsholm.

Dado que se parecía al teluro y que el nombre de ese elemento provenía del latín tellus (tierra), Berzelius decidió bautizar al nuevo elemento con un nombre relacionado. Si el teluro era el elemento de la Tierra, el otro sería el elemento de la Luna, cuyo nombre griego es Selene, con lo que lo llamó selenio. Sí, es un poco tonto y lleva a confusión –el helio, por ejemplo, se llama así porque se detectó por primera vez en el Sol, Helios–, ya que el selenio no tiene absolutamente nada que ver con la Luna, pero así son las cosas.

Berzelius determinó cuidadosamente las propiedades del selenio puro, así como los tipos de compuestos que formaba con oxígeno, fósforo, azufre y otros elementos conocidos. El selenio resultó tener varias formas alótropas, es decir, de la misma composición pero diferente estructura y propiedades, como sucede con muchos otros elementos. El polvo rojizo que se había encontrado en Gripsholm era uno de estos alótropos, formado por anillos de ocho átomos de selenio (Se8), y es una forma muy común al obtener el elemento a partir de reacciones químicas a alta temperatura. Recibe el nombre de selenio rojo.

Selenio rojo (W. Oelen / Creative Commons Attribution-Sharealike License 3.0).

Las otras dos formas alotrópicas más comunes son menos llamativas. Si se funde el selenio rojo es posible luego enfriarlo de modo que forme una sustancia amorfa parecida al vidrio pero de color negro, cuya estructura química es mucho más compleja que la del selenio rojo. Este selenio recibe el nombre de selenio negro y está formado por polímeros de miles de átomos de selenio unidos unos a otros en forma de anillos entrelazados.

Selenio negro (Images of Elements / Creative Commons Attribution-Sharealike License 3.0).

Como dije al principio ninguna de estas formas de selenio puro es químicamente estable: al exponerlas al aire, por ejemplo, ambas forman óxidos de selenio y dejan de ser puras. El selenio suele venderse en forma de pastillas de selenio negro, pero cubiertas con una fina capa del alótropo más estable, el selenio gris, formado fundamentalmente mediante el enfriamiento muy lento de selenio fundido. Este enfriamiento lento permite que se formen cristales hexagonales de átomos de selenio, a diferencia de las dos formas amorfas anteriores. Aunque, como digo, siga sin ser estable, la estructura cristalina lo es mucho más que las otras dos: por ejemplo, no se oxida tanto al ser expuesta al oxígeno del aire.

Pastillas de selenio negro recubiertas de selenio gris (W. Oelen / Creative Commons Attribution-Sharealike License 3.0).

Al observar el selenio gris cristalino, su color y su brillo metálico al pulirlo, Berzelius llegó a la conclusión de que se trataba de un metal, a pesar de que hoy sabemos que sus propiedades electrónicas son las de un elemento no metálico o, como mucho, un semimetal. Por ejemplo, desde el principio se realizaron experimentos para medir su resistencia eléctrica, que resultó ser mucho mayor que la de los metales “de verdad”. Está muy a la derecha de la tabla, en el mismo grupo que el azufre y el teluro y justo entre ambos, de modo que tiene propiedades intermedias entre los dos. Este “muy a la derecha” significa, por la estructura de la tabla periódica, que el selenio está muy cerca de completar una capa electrónica, de modo que puede alcanzar la estabilidad ganando un par de electrones más –lo mismo que oxígeno, azufre y teluro–. De ahí que su estado de oxidación más común sea -2.

Sin embargo también puede mostrar estados de oxidación +2, +4 y +6 en los que no gana electrones sino que los pierde. Esto sucede, por ejemplo, si se encuentra con oxígeno –un elemento muy electronegativo, es decir, muy hambriento de electrones–, en cuyo caso puede formar diferentes óxidos como SeO, SeO2 o SeO3. Algo parecido le pasa al azufre, pero el selenio tiene una capa electrónica más, de modo que es menos electronegativo y puede llegar a comportarse como un semimetal, lo mismo que el silicio y otros elementos similares.

El propio Berzelius notó en sus experimentos algo preocupante: el selenio parecía ser tóxico en algunos de sus compuestos. En sus propias palabras describiendo el selenuro de hidrógeno (H2Se),

El gas tiene el olor del sulfuro de hidrógeno [H2S, el gas de las bombas fétidas] cuando está diluido en el aire; pero si se respira más concentrado produce una sensación dolorosa en la nariz y una inflamación violenta que desemboca en una inflamación de las mucosas. Aún sigo sufriendo los efectos de haber respirado hace unos días una burbuja de selenuro de hidrógeno no más grande que un guistante pequeño. Apenas había percibido el sabor hepático en la boca cuando experimenté otra sensación aguda: me entró un mareo que, sin embargo, pronto me abandonó, y la sensibilidad de la membrana schneideriana [una mucosa que cubre el seno maxilar] estaba tan dañada que el amoníaco más fuerte apenas producía un efecto sobre la nariz.

Dejando aparte la audacia o imprudencia de Berzelius, desde el principio estuvo claro que el selenio era algo con lo que era necesario tener cuidado. Las buenas noticias eran que, dada su escasez, era muy difícil estar expuesto a burbujas de selenuro de hidrógeno como las que atacaron a Berzelius salvo que las produjera uno mismo. Sin embargo sí es cierto que muchos compuestos del selenio –no sólo el H2Se sino el selenio puro y muchas de sus sales– son tóxicas, aunque no tengas que preocuparte por ello porque es rarísimo que estés expuesto a estos compuestos.

Al mismo tiempo que satisfacíamos nuestra curiosidad sobre este nuevo elemento, muchos científicos e ingenieros intentaban determinar si tenía alguna propiedad especial que lo hiciera útil industrialmente, o si era simplemente una impureza indeseable. Pronto se determinó que era, eléctricamente hablando, un semiconductor –como el silicio–, pero no era el único ni eso lo hacía especial.

Hubo que esperar décadas, pero en 1873 un ingeniero británico, Willoughby Smith, descubrió algo realmente inusual en el selenio, por total y completa casualidad una vez más. Willoughby estaba involucrado en la fabricación e instalación de cables submarinos de telégrafo eléctrico, y se hallaba intentando diseñar circuitos de prueba que permitiesen comprobar que el cable submarino transmitía perfectamente según se iba soltando bajo el agua.

Para su circuito de prueba hacía falta un semiconductor, y Willoughby empleó cilindros de selenio gris (recuerda, la forma cristalina), que no funcionaron bien: eran inconsistentes en sus propiedades eléctricas, de modo que presentaban una resistencia en el laboratorio y otra distinta –mucho mayor –al meterlos bajo el agua. El británico no hizo lo que imagino que hubiera hecho yo –sustituir el selenio por otro semiconductor– sino que intentó determinar por qué el selenio cambiaba su resistencia eléctrica.

Tras realizar experimentos en laboratorio Willoughby llegó a una conclusión sorprendente, que publicó en Nature bajo el título Effect of Light on Selenium during the passage of an Electric Current (Efecto de la luz sobre el selenio durante el paso de una corriente eléctrica): el selenio gris era extraordinariamente sensible a la luz. Al iluminarlo su resistencia eléctrica disminuía, de modo que al probar los circuitos bajo la luz del Sol el selenio gris conducía relativamente bien –para ser un semiconductor, por supuesto– pero al sumergirlo en las profundidades y la consecuente oscuridad su resistencia aumentaba mucho. Esto era un problema para probar cables telegráficos, pero una propiedad utilísima para muchas otras cosas.

Se trataba del primer semiconductor fotosensible que conocíamos, y los ojos de los ingenieros de todo el mundo se pusieron a hacer chiribitas. Entre ellos se encontraba nada menos que Alexander Graham Bell, que se planteó lo siguiente: ¿no sería posible convertir la voz en pulsos luminosos en un emisor y luego recibir esos pulsos con un receptor de selenio para convertirlos en impulsos eléctricos? Junto con su ayudante, Charles Sumner Tainter, Bell puso manos a la obra y los dos hombres consiguieron su propósito en 1880.

El aparato, bautizado con el magnífico nombre de fotófono, era de una sencillez propia de los genios. El emisor tenía un espejo parabólico de gran tamaño con una bombilla en su foco, que recibía directamente la voz de quien hablaba. El sonido hacía vibrar el espejo, con lo que los rayos de luz eran reflejados en distintas direcciones cuando el espejo vibraba: el haz se “esparcía” o se “concentraba” según la forma del espejo vibrante.

El receptor, a su vez, tenía otro espejo parabólico con una pieza de selenio en el foco unida a un circuito eléctrico: allí pasaba justo lo contrario. El receptor de selenio recibía pulsos de luz acompasados a la luz que llegaba al espejo, de modo que el circuito recibía pulsos eléctricos cuando el selenio recibía luz y, en consecuencia, disminuía su resistencia eléctrica. El aparato funcionaba estupendamente bien e imagino que a muchos les hubiera parecido magia. A mí lo que me sorprende es su absoluta sencillez.

Receptor del fotófono del Alexander Graham Bell, con su pieza de selenio en el foco (dominio público).

El fotófono fue eclipsado unos años más tarde por la radio, pero siguió utilizándose con usos muy concretos pero importantísimos. A diferencia de las ondas de radio, mucho más difíciles de enfocar, el fotófono permitía comunicarse a distancia y sin cables de un modo muy preciso, con lo que en la guerra era muchísimo más útil que la radio… siempre que hubiera una línea de visión ininterrumpida entre emisor y receptor, por supuesto. Ése era uno de sus puntos flacos, ya que la niebla, la lluvia o una cadena montañosa lo dejaban fuera de juego.

Sin embargo, Alexander Graham Bell lo consideró hasta su muerte su mayor invento –más importante que el teléfono–, y el concepto no es tan diferente del que utilizaríamos muchos años más tarde al desarrollar la fibra óptica, que también convierte la información en pulsos luminosos que luego se transforman, en el receptor, en impulsos eléctricos. Sin embargo, ahora ya no usamos selenio como hizo Bell, por razones que describiré en un momento.

Durante un tiempo el selenio fue muy utilizado como fotorreceptor en muchos circuitos fotosensibles, como los de los fotómetros en fotografía o incluso células fotoeléctricas que usaban luz en vez de radiación ultravioleta o infrarroja como las modernas. Y es que el selenio, como otros semiconductores fotosensibles, es capaz no sólo de disminuir su resistencia eléctrica ante la luz: es capaz, si las condiciones son las adecuadas, de generar una corriente eléctrica al exponerlo a la luz. Es un material no sólo fotosensible, sino fotovoltaico. De hecho, algunos de los fotómetros de selenio usados en fotografía ni siquiera necesitan una pila para funcionar, sino que la pieza de selenio genera el suficiente voltaje para el aparato al exponerlo a la luz.

Fotómetro de selenio (Audriusa / Creative Commons Attribution-Sharealike 3.0 License).

Además de sus propiedades fotovoltaicas, a finales del siglo XIX se descubrió que era posible usarlo como semiconductor para fabricar rectificadores de mayor calidad que los anteriores. Un rectificador es un dispositivo usado en electrónica para convertir una corriente alterna en otra continua, lo cual es utilísimo en una enorme variedad de aparatos, por ejemplo televisores o radios.

El caso es que, por unas y otras razones, hubo una “edad de oro del selenio” entre 1900 y 1940. Sin embargo esto se terminó y hoy en día apenas se usa en electrónica –y, como veremos, en casi ninguna otra cosa–, una vez más por varias razones. La primera es que ya he dicho repetidas veces que el selenio es muy, muy escaso, y pronto descubrimos otros semiconductores de características muy similares –incluso en sus propiedades frente a la luz–, pero muchísimo más comunes y por lo tanto mucho más baratos. Quien destronó al selenio en casi todos sus papeles fue el silicio, también con propiedades fotovoltaicas, también un excelente semiconductor… y constituyente de un 27% de la corteza terrestre.

Rectificadores de selenio del ordenador MADDIDA (1950).

Pero hubo una razón más que seguro que te estás oliendo ya, como hizo Berzelius desde el principio: el selenio y muchos de sus compuestos son tóxicos. Cuando los rectificadores de las televisiones pegaban un petardazo por alguna razón, del aparato salía un olor desagradable y, además, un gas tóxico. He leído que los técnicos sabían que había fallado el rectificador precisamente por el olor nauseabundo, aunque no sé si también eran conscientes de que estaban respirando un gas venenoso.

De modo que llegó el ocaso del selenio, más o menos hacia 1940-1950. Hoy en día se produce una cantidad bastante pequeña, unas 2 000 toneladas anuales en todo el mundo; sé que parece mucho, pero es una cantidad ridícula comparada con la de cualquier otro semiconductor “exitoso”. Y de esa cantidad apenas usamos nada en electrónica.

De hecho, la mitad de la producción mundial se destina al vidrio de colores. Si recuerdas su forma alotrópica roja, el color es muy bello e intenso, y se emplea para dar color al vidrio. Al estar embebido en el vidrio no hay peligro –salvo que se funda, algo que no va a pasar en una casa– de que se emitan gases tóxicos.

Vidrio tintado con selenio.

También se emplea, en menor medida, en aleaciones diversas, lo mismo que en la obtención de manganeso mediante la electrólisis, en forma de SeO2. Incluso se sigue utilizando en pequeñas cantidades para la fabricación de células fotovoltaicas, haciendo honor a su pasado fotosensible, unido a otros semiconductores. Sin embargo, como dije antes, se trata de un elemento cuyo glorioso pasado ya queda lejos.

Irónicamente, en los años 50 –cuando llegaba su ocaso– se descubrió que formaba parte de la bioquímica de algunos organismos simples. Esto puede parecer contradictorio porque he dicho que es tóxico, pero pasa muchas veces que algunos elementos químicos son necesarios en pequeñas cantidades pero peligrosos en grandes concentraciones.

De hecho un par de décadas después descubrimos que no sólo existe en nuestro cuerpo, sino que es un oligoelemento esencial para la vida de todos los mamíferos. Forma parte de dos aminoácidos, la selenocisteína y la selenometionina, además de varias enzimas, y en resumen sin pequeñas cantidades de selenio no podríamos vivir. Afortunadamente se trata de uno de esos casos en los que no hay que preocuparse: en una dieta normal y corriente hay suficiente selenio para olvidarse de ello, y no hay tanto que sea un peligro.

Selenocisteína (izq.) y selenometionina (der.).

Sí, es uno de esos casos: no podemos vivir sin selenio ni tampoco con un exceso de este elemento. No he conseguido descubrir exactamente qué hace en el cuerpo a nivel químico, pero sí que interfiere en suficientes procesos como para ser terrible en grandes concentraciones. Por encima de 400 microgramos diarios puede producir selenosis, pero una vez más no hay por qué preocuparse ya que, en condiciones normales, no estamos expuestos a tal cantidad de selenio en nuestra vida cotidiana.

Lo que sí es muy peligroso y no hace falta una gran cantidad para que lo sea es el selenuro de hidrógeno, H2Se, el gas que inhaló por accidente el bueno de Berzelius. Es hediondo y además corrosivo, ya que al disolverse en agua le proporciona carácter ácido. En contacto con las mucosas, como comprobó el químico sueco, puede provocar estragos. Una vez más lo bueno es que, salvo en un laboratorio, nadie suele estar expuesto a este gas.

En la siguiente entrega de la serie nos acercaremos aún más al margen derecho de la tabla con un elemento aún más reactivo que el selenio: el elemento de treinta y cinco protones, el bromo.

Para saber más (esp/ing cuando es posible):

(Vídeo) Doodling in Math Class: Dragon Dungeons

Hoy os traigo un nuevo vídeo de Vi Hart. Se trata de la segunda parte de DRAGONS, y sus protagonistas vuelven a ser los fractales, con la Dragon Curve, la curva de Koch y el triángulo de Sierpinski como principales protagonistas:

No se puede negar que la señorita Hart (cuyo canal de youtube es éste) se curra mucho sus vídeos.

Entra en Gaussianos si quieres hacer algún comentario sobre este artículo, consultar entradas anteriores o enviarnos un mensaje.

Construye tú también el poliedro de Császár.

Ecuaciones de Maxwell y Relatividad

Hoy estamos realmente contentos en Cuentos Cuánticos porque tenemos el palcer de presentar a una nueva colaboradora, Reyes Zambrano (@MReyesZam). Seguro que nos hará pasar buenos ratos leyendo sus aportaciones a este blog. Y qué mejor manera de empezar que entrando fuerte. Hoy nos hablará sobre las ecuaciones de Maxwell y relatividad, una entrada para aficionados y estudiantes de relatividad especiao y electromagnetismo. Disfrutadla.

Bienvenida Reyes y gracias por participar ![]()

¿Qué tienen que ver las ecuaciones de Maxwell con la relatividad? En seguida vamos a verlo, pero, empecemos por el principio…

James Clerk Maxwell en una ilustración de 1880 aparecida en la revista Popular Science Monthly Volume 17

Las ecuaciones de Maxwell llevan más de 140 años describiendo los fenómenos electromagnéticos. Aquí las tenemos:

donde es el campo eléctrico,

es el campo magnético y

la densidad de corriente.

Estas ecuaciones han resistido a todas las teorías de la Física que han venido después, incluida la relatividad. Esto significa que deberían poder aplicarse cuando tratemos con fenómenos relativistas.

Los fenómenos electromagnéticos son, en algunas ocasiones, curiosos. Por ejemplo, si tenemos un grupo de cargas fijas, un observador en reposo respecto a ellas ve un campo eléctrico asociado, pero otro observador que está en movimiento puede ver también un campo magnético. ¿Cómo se pasa de una descripción a la otra? Necesitamos unas relaciones matemáticas que hagan las transformaciones . Y esas relaciones no son las conocidas transformaciones de Galileo, son las transformaciones de Lorentz.

Se llaman así porque en 1904 fueron escritas por Hendrik Antoon Lorentz. Las transformaciones proporcionaban una base para el desarrollo de la relatividad especial, aunque las consecuencias importantes de la relatividad no fueron descubiertas por este científico. Lorentz creía en el concepto de eter, e intentó ajustar sus cálculos para que cuadraran con dicho concepto.

Hendrick Antoon Lorentz por Jan Veth

Las transformaciones conectan las coordenadas del espacio y del tiempo de un sistema de referencia con las cantidades correspondientes en otro sistema de referencia que se encuentra en movimiento uniforme respecto al primero. Podemos interpretarlas como una rotación en el espacio de cuatro dimensiones x, y, z, t.

donde es la velocidad uniforme de un sistema de referencia S’ que se mueve en la dirección

respecto de otro sistema de referencia S.

son las coordenadas en el sistema de referencia S’ y

son las coordenadas en el sistema de referencia S.

Henri Poincaré y Albert Einstein enunciaron el principio de la relatividad, según el cual las leyes de la naturaleza deben ser las mismas para dos observadores en movimiento uniforme uno respecto al otro.

En concreto, en 1905, en su artículo “Sobre la electrodinámica de los cuerpos en movimiento” (en alemán, “Zur elektrodynamik bewegter körper”), Einstein enunció los dos postulados básicos de la relatividad.

El primer postulado dice: “Las leyes de la naturaleza son las mismas en todos los sistemas de coordenadas que se mueven con movimiento uniforme uno respecto al otro”.

Y sabemos que los postulados de la relatividad especial tienen que cumplirse. Al menos, hasta ahora, todos los intentos de encontrar fisuras en esta teoría han fallado. Luego entonces, las ecuaciones de Maxwell tendrán que cumplir el primer postulado. Y ¿lo hacen? Claro que sí. El propio Einstein en el mencionado artículo de 1905 lo comprueba.

Sin embargo, hemos visto que las transformaciones de Lorentz mezclan las coordenadas del espacio y del tiempo. En las ecuaciones de Maxwell las coordenadas deberían también aparecer en una forma simétrica. Dicho de otra manera, que entren en la ecuación en un nivel equivalente tanto coordenadas espaciales como el tiempo, con rotacionales y divergencias en cuatro dimensiones.

Hay una forma de escribir estas ecuaciones, llamada formulación covariante, en la que tenemos esta simetría. Serán las mismas ecuaciones, pero escritas de otro modo . Para llegar a esta formulación habrá que hacer algunas cuentas. Pues, allá vamos…

Sabemos que los campos eléctrico y magnético pueden derivarse de los potenciales escalar y vectorial, y

:

Y con ambos potenciales vamos a escribir un cuadrivector donde:

Al que vamos a llamar cuadripotencial o potencial universal.

Si calculamos las tres componentes del campo eléctrico y las tres del campo magnético, usando las definiciones anteriores, y sustituimos las componentes de los potenciales vector y escalar por las del potencial universal, obtenemos:

Por tanto, e

juntos, forman el rotacional cuadridimensional de

.

Si ahora definimos una cantidad a la que vamos a llamar , Tensor de Campo Electromagnético, como:

Resulta que es el rotacional en cuatro dimensiones de

.

¿Os gustan las matrices? Pues, vamos a escribir en forma matricial, simplemente, para verlo mejor:

Ahora tenemos que calcular la divergencia del tensor de campo electromagnético. Nos queda lo siguiente.

Y ahora, ¿qué hacemos con ésto? Aunque parece que las expresiones son cada vez más complicadas, en realidad, ya está casi todo el trabajo hecho. Vamos a ver que los dos sumandos a la derecha del igual van a simplificarse, de tal forma, que nos va a llevar a una fórmula muy sencilla para justo la mitad de las ecuaciones de Maxwell.

El primer sumando es cero. Y ¿por qué? La respuesta está en una condición que hacemos cumplir a los potenciales escalar y vectorial, la llamada condición de Lorentz. Es ésta:

Que escrita en función de las componentes del potencial universal es:

Hay una razón para imponer esta condicion y es simplificar las expresiones que se obtienen cuando en la segunda y cuarta ecuaciones de Maxwell sustituimos las ecuaciones que relacionan los campos con los potenciales. Operando, tras esta simplificación, llegamos a una ecuación de onda para el potencial vector:

Donde es la densidad de corriente.

Usando el cuadripotencial se escribe así:

donde son las componentes del cuadrivector

. Porque la densidad de corriente también puede, y debe, escribirse en forma covariante. Las tres primeras componentes seran las componentes conocidas en tres dimensiones y la cuarta es

. Esto es así debido a la relación que existe entre ambas, la conocida ecuación de continuidad:

Usando el cuadrivector se escribe:

O, lo que es lo mismo.

Pero, no nos desviemos del camino. En la ecuación de onda del potencial vector escrita usando el cuadripotencial aparece, a la izquierda del igual, una expresión que vimos antes cuando calculamos la divergencia del tensor de campo electromagnético. Vamos a sustituir en la expresión de la divergencia del tensor esta expresión por lo que nos ha salido en la ecuación del potencial vector. Y nos encontramos, una vez hecho ésto, con una bonita expresión para :

Pero a los físicos nos gustan más las ecuaciones simples y elegantes, así que la escribimos de esta manera:

Esta ecuación representa a las dos primeras ecuaciones de Maxwell, en lo que se llama Formulación Covariante de las Ecuaciones de Maxwell.

Las otras dos ecuaciones de Maxwell vienen representadas, en la mencionada formulación, por la siguiente expresión:

donde representan tres de los subídices 1, 2, 3 ó 4. Esta formula se deduce directamente de la expresión del tensor de campo electromagnético.

Llegamos al final. Ahora, ya sabemos cómo se escriben las ecuaciones de Maxwell para que las coordenadas del espacio y del tiempo estén tratadas a un nivel equivalente tal como se hace en relatividad.

¡Hasta pronto!

Archivado en: relatividad especial, Sin categoría Tagged: campo eléctrico, campo magnético, ecuaciones de Maxwell, formulación covariantes, relatividad especial, tensor electromagnético, transformaciones de Lorentz

Francis en #rosavientos: El meteoro de Cheliábinsk, el asteroide con seis colas y las exotierras de Kepler

Ya puedes oír el audio de mi sección Eureka, en La Rosa de los Vientos, de Onda Cero, siguiendo este enlace. Como siempre una transcripción libre y algunos enlaces.

Esta semana se han publicado nuevos datos sobre el meteoro que cayó en Rusia el pasado 15 de febrero en Cheliábinsk. ¿Qué novedades hay sobre este meteoro? Ya comenté en su momento en Eureka los datos iniciales sobre su trayectoria y la estimación mediante infrasonidos de su masa. Estos datos preliminares han sido revisados esta semana por dos artículos publicados en Nature y un artículo publicado en Science. El meteoro que impactó en Cheliábinsk tenía una masa entre 12.000 y 13.000 toneladas métricas, casi el doble de lo que se estimó en su momento, impactó en la parte superior de la atmósfera a una velocidad de unos 19 km/s, más de 50 veces la velocidad del sonido en esa región de la atmósfera, liberando una energía de unos 500 kilotones de TNT, que por fortuna fue, en gran parte, absorbida por la atmósfera (lo que minimizó los daños, aunque llevó al hospital por lesiones leves a 1.200 personas).

Desde el impacto de Tunguska en 1908, la Tierra no había sido testigo una colisión espacial tan destructiva. El meteoro se fracturó en miles de pedazos a una altura entre 30 y 45 km El 75% de la masa del asteroide se vaporizó, mientras que el resto se convirtió en polvo. Sólo el 0,05% (unas 4 o 6 toneladas) sobrevivió a la explosión y cayó al suelo en forma de meteoritos. Sólo se han encontrado unos pocos meteoritos en tierra, el mayor de los cuales, con 600 kg de masa, formó un agujero circular en el hielo de la superficie del lago Chebarkul, a 60 km al suroeste de Cheliábinsk y acabó en el fondo del lago desde donde ha sido recuperado para su estudio. Los nuevos análisis de todos los datos recabados sobre este meteoro nos dan mucha información sobre este tipo de sucesos y nos permite estimar la probabilidad de futuros sucesos similares.

Más información en este blog en «Los últimos datos sobre el meteoro de Chelyabinsk,» LCMF, 7 Nov 2013. Los tres artículos técnicos son Jiří Borovička et al., «The trajectory, structure and origin of the Chelyabinsk asteroidal impactor,» Nature, AOP, 06 Nov 2013; P. G. Brown et al., «A 500-kiloton airburst over Chelyabinsk and an enhanced hazard from small impactors,» Nature, AOP 06 Nov 2013; y Olga P. Popova et al., «Chelyabinsk Airburst, Damage Assessment, Meteorite Recovery, and Characterization,» Science, AOP 07 Nov 2013 [DOI].

En español te recomiendo leer a Alicia Rivera, «El superbólido ruso alcanzó un brillo aparente de 30 veces el Sol,» El País, 6 Nov 2013, Teresa Guerrero, «El riesgo de meteoritos peligrosos es 10 veces más alto de lo que se creía,» El Mundo, 7 Nov 2013, José Manuel Nieves, «La otra mitad del meteorito de Chelyabinsk está aún ahí arriba,» ABC, 6 Nov 2013, y «El asteroide que explotó sobre los cielos rusos mandó a más de 1.200 personas al hospital,» Agencia SINC, 7 Nov 2013.

Los oyentes están interesados en el riesgo que supone la colisión de meteoritos peligrosos contra la Tierra. ¿Qué hemos aprendido al respecto gracias al meteoro de Cheliábinsk? Gracias al análisis de todos los meteoros que han colisionado con la Tierra en el siglo pasado y a los datos del meteoro de Cheliábinsk los expertos estiman que el riesgo de impactos similares es 10 veces mayor de lo que se creía hace sólo un año. El meteoro de Cheliábinsk es una condrita cuya composición indica que su origen está en el cinturón de asteroides que orbita el Sol entre los planetas Marte y Júpiter. Se estima que se formó hace 4452 millones de años y desde entonces había estado vagando por el Sistema Solar hasta que la Tierra se topó en su camino. Los cálculos estadísticos realizados teniendo en cuenta este meteoro indican que las colisiones con asteroides cercanos son más frecuentes de lo esperado. Hasta ahora se pensaba que un impacto como el de Cheliábinsk solamente tenía lugar una vez cada unos 150 años, pero ahora creemos que su frecuencia es mayor y se aproxima a un choque cada unos 30 años. Eso significa que los eventos de tipo Tunguska tendrían lugar cada pocos siglos en vez de una vez por milenio como creíamos hasta hace menos de un año. Antes se creía que existían entre tres y cuatro millones de asteroides como el de Cheliábinsk en el Sistema Solar, pero los nuevos datos indican la cifra real está más cerca de los veinte millones. Las agencias espaciales tendrán que reforzar los programas de detección de asteroides cercanos si queremos anticipar este tipo de eventos en el futuro.

Los asteroides del cinturón de asteroides entre los planetas Marte y Júpiter guardan aún muchos misterios por desvelar. ¿Hay algo curioso al respecto que nos puedas contar? El telescopio espacial Hubble de la NASA observó en agosto de este año el asteroide más misterioso hasta el momento, llamado P/2013 P5, misterioso porque tiene seis colas de polvo, como las de los cometas. La publicación en la revista The Astrophysical Journal Letters ha causado gran expectación en la comunidad científica porque nunca se había vista nada igual antes. Todavía no se tiene ninguna explicación adecuada de este misterio. Lo más asombroso es que las colas del asteroide cambian muy rápido, en tan sólo dos semanas. Se cree que este asteroide está en rotación y hay una ley física que afirma que hay una velocidad de rotación máxima a partir de la cual la superficie del asteroide comienza a volar a pedazos, expulsando polvo en erupciones periódicas. Se cree que este asteroide ha superado la velocidad de rotación crítica y está expulsando polvo de forma periódica que da lugar a las seis colas que ha observado el telescopio espacial Hubble. Pero esta hipótesis todavía no está confirmada, pues no se ha podido medir la velocidad de rotación de este asteroide. La verdad es que los asteroides nos guardan aún muchos misterios por desvelar.

Más información en «Hubble Sees an Asteroid with Six Comet-like Tails,» NASA News, 7 Nov 2013, siendo el artículo técnico David Jewitt et al., «The extraordinary multi-tailed main-belt comet P/2013 P5,» The Astrophysical Journal Letters 778: L21, 2013. En español puedes leer a Europa Press, «El asteroide de seis colas,» Público, 8 Nov 2013, Agencias, «El enigmático asteroide ‘aspersor’ de seis colas,» El Mundo, 8 Nov 2013, «El asteroide con seis colas, un «aspersor giratorio» que enloquece a los astrónomos,» RT Ciencia, 8 Nov 2013.

Cambiando de tema, esta semana se han publicado los últimos resultados del telescopio espacial Kepler de la Nasa sobre exoplanetas. ¿Qué se ha descubierto? El último análisis de los datos del telescopio espacial Kepler de la NASA han identificado un total de 833 nuevos candidatos a exoplanetas, de los que 104 son planetas en la zona de habitabilidad de su estrella y 10 de ellos son candidatos a exotierras, planetas del tamaño de la Tierra. Con estos nuevos datos, los candidatos a exoplanetas descubiertos por Kepler ascienden a 3538. Pero lo más importante es el estudio estadístico de estos datos. Se publica en la revista PNAS que el 78% de todos estos planetas son de tamaño terrestre (con un radio inferior a 1,25 veces el de la Tierra) o más pequeños. Como hasta 10 de estos planetas rocosos deben estar en la zona habitable de su Tierra, es decir, podrían ser exotierras, se puede estimar el número de exotierras en nuestra galaxia, la Vía Láctea. El resultado es que el 22% de las estrellas de tipo solar tienen al menos un planeta terrestre situado en la zona habitable. ¡Un quinto de todas las estrellas de tipo solar podrían tener exotierras girando a su alrededor! Esta noticia confirma lo que ya indicaban estudios anteriores, los planetas habitables son muy comunes en nuestra Galaxia. Pero esto no significa que sean planetas con vida. Además conviene recordar que estos resultados estadísticos son pura especulación y que se trata de candidatos a exotierras, que han de ser confirmados por estudios futuros. Por ahora no se trata de planetas confirmados. Hasta el momento, el 90% de los candidatos a planetas de Kepler se han confirmado como planetas, pero queda un 10% de falsos positivos y además su tamaño y órbita podrían ser ligeramente distinta. Así que algunos candidatos a exotierras podrían estar situados fuera de la zona habitable. Pero lo importante es que podemos decir con seguridad que la Vía Láctea está llena de planetas de tamaño terrestre potencialmente habitables. Ahora sólo falta confirmar alguno de ellos de forma definitiva. Un resultado que huele a Premio Nobel.

Más información en «NASA Kepler Results Usher in a New Era of Astronomy,» NASA News, 4 Nov 2013. El artículo técnico es Erik A. Petigura, Andrew W. Howard, Geoffrey W. Marcy, «Prevalence of Earth-size planets orbiting Sun-like stars,» PNAS, AOP 4 Nov 2013. El español te recomiendo leer a Daniel Marín, «Nuevos resultados de Kepler: los planetas habitables de tipo terrestre son comunes en la Galaxia,» Eureka, 4 Nov 2013, Teresa Guerrero, «Una de cada cinco estrellas como el Sol tiene planetas del tamaño de la Tierra en su zona habitable,» El Mundo, 5 Nov 2013.

La cocina del CIS al extremo

Sobre el alzhéimer y la prueba del cacahuete

¿Se puede detectar el alzhéimer por la pérdida del olfato? Hace un par de semanas, un estudio publicado en Journal of the Neurological Sciences tuvo bastante eco en los medios norteamericanos: habían conseguido detectar signos precoces del alzhéimer mediante una simple prueba que consistía en oler un bote de mantequilla de cacahuete. Aunque suena estrafalario, los neurocientíficos saben desde hace tiempo que la pérdida del olfato es un indicador de algunas enfermedades degenerativas, entre ellas el alzhéimer, y se afanan en encontrar la manera de detectarlas precozmente. Pero, ¿qué hay de cierto en la noticia sobre esta prueba?

Es mi ultima colaboración con la CCCientífica. Seguir leyendo en: Sobre el alzhéimer y la prueba del cacahuete (Frontera)

Leonard Susskind nos cuenta qué son el campo y el bosón de Higgs

Como muchos ya sabéis, Lenny Susskind imparte cursos de adultos (como ya hacía Richard Feynman) en los que cuenta conceptos muy complicados de física a un público general (alumnos y exalumnos de la Univ. Stanford). Este vídeo titulado “Demystifying the Higgs Boson” es un buen ejemplo. Lenny nos explica qué es un campo, qué es al vacío de un campo, qué es la masa, cómo le da masa el campo de Higgs a los fermiones y cómo le da masa a los bosones vectoriales. Sin fórmulas matemáticas, pero con las ideas correctas. Algunas de las metáforas que usa ya las he añadido a mi bolso de metáforas sobre el Higgs. Muy recomendable esta charla.

Archivado en: Bosón de Higgs, Ciencia, Física, Noticia CPAN, Noticias, Personajes, Physics, Recomendación, Science Tagged: Bosón de Higgs, Ciencia, Conferencia, Física, Noticias, Personajes

Cauchy y el rigor en el análisis matemático

Muchos historiadores de la matemática afirman que el rigor en matemáticas nació con Augustin-Louis Cauchy. Todo un revolucionario, Cauchy trató de establecer una base rigurosa para el análisis matemático. Un buen ejemplo fue su demostración del teorema del valor intermedio, que afirma que toda función real f(x) continua en un intervalo [a,b] asume cada valor posible entre f(a) y f(b) en ese intervalo. Parece obvio gracias a la idea intuitiva de continuidad y de hecho hasta Cauchy nadie pensó que fuera necesario demostrarlo, pero hoy en día todos los estudiantes de matemáticas se pelean con su demostración rigurosa (aunque sin saberlo, como homenaje en memoria de Cauchy). Por cierto, Cauchy enseñó la demostración de este teorema por primera vez en el curso que impartió en la École Royale Polytechnique en 1816. Su libro de texto de 1821, admirado por más de una generación de matemáticos, presenta dos demostraciones diferentes; la más famosa, la que todos los estudiantes de matemáticas aprenden, fue relegada a un apéndice. Nos lo recuerda Michael J. Barany, “Stuck in the Middle: Cauchy’s Intermediate Value Theorem and the History of Analytic Rigor,” Notices of the AMS 60: 1334-1338, Nov. 2013.

La Revolución Francesa, bajo las consignas de libertad, igualdad y fraternidad, fue acompañada de una revolución matemática. Por primera vez, la élite de los ingenieros militares y civiles comenzó a recibir una formación matemática en París que comprendía las matemáticas más avanzadas del momento. Estos ingenieros aplicaron las matemáticas que estudiaron a los problemas más acuciantes del mundo moderno: infraestructuras, la navegación, la minería, la energía e incluso a la guerra. El buque insignia de esta revolución fue la École Polytechnique (que fue rebautizada como École Royale Polytechnique tras la derrota de Napoleón y el regreso de la monarquía). En esta institución Cauchy dejó su huella como estudiante y como profesor.

Cauchy fue un profesor impopular tanto entre los estudiantes como entre sus compañeros de facultad. Sus clases eran muy densas y difíciles de seguir, muchas veces prolongaba la clase más allá de su horario oficial y además realizaba continuas revisiones del temario. Para Cauchy las matemáticas del siglo XVIII eran una disciplina que había perdido el norte. Todo un siglo de innovaciones matemáticas maravillosas que habían sido logradas a costa del rigor. Matemáticos como Euler manejaban series que no eran convergentes y expresiones formales sin sentido que producían conclusiones absurdas. No estaban claros conceptos tan básicos como el de infinito, el de límite, los números imaginarios y muchos más. Cauchy admiraba la formulación axiomática de la geometría realizada por Euclides. El álgebra presentaba un estado similar, pero era considerada por los matemáticos del siglo XVIII como una herramienta, versátil, pero de poca utilidad a la hora de resolver problemas prácticos. Por el contrario, el análisis era muy útil en todo tipo de problemas prácticos, pero carecía de un formulación rigurosa. Cauchy quería que el status de la geometría y del álgebra fuera extendido al análisis. Por ello decidió revisar todo el análisis desde el punto de vista de la geometría y apoyado por el álgebra como herramienta.

Por supuesto, el “Curso de Análisis” de Cauchy, como suele ocurrir con todo trabajo pionero, carece de rigor en muchos aspectos. Por ejemplo, Cauchy asume que todas las funciones continuas son diferenciables. Sin embargo, lo importante del proyecto de reforma del análisis iniciado por Cauchy, que trata de llevar el rigor al análisis de la mano de la geometría y del álgebra, es que inició un camino hacia el rigor cuya culminación fue el motor de gran parte de la matemática de todo el siglo XIX, con la honrosa excepción del genial Henri Poincaré que vio en el rigor un corsé del que había que deshacerse.

El cénit del rigor en las matemáticas llegó en el siglo XX con Nicolas Bourbaki, el nombre colectivo de un grupo de matemáticos franceses que, en los años 1930, se pusieron a revisar todos los fundamentos de las matemáticas con una exigencia absoluta en el rigor tratando de combatir la corriente que había nacido con Poincaré. Matemáticos como Jean Dieudonné, André Weil, Henri Cartan, Claude Chevalley, y otros antiguos alumnos de la Escuela Normal Superior de París recogieron el guante de Cauchy e impusieron a toda la matemática el concepto de rigor matemático como definición de la labor del matemático.

Un matemático es una máquina de demostrar teoremas con absoluto rigor. La máxima revolucionaria de Bourbaki es Vive la rigueur!

Coda final. Esta entrada participa en la edición 4.1231056 del Carnaval de Matemáticas, cuyo anfitrión es el blog Scientia. Me hubiera gustado escribir una entrada sobre las Matemáticas de la Vida gracias a la Química, pero ya impartí una charla sobre el tema que puedes volver a ver siguiendo este enlace.

Archivado en: Ciencia, Historia, Matemáticas, Mathematics, Personajes, Science Tagged: Ciencia, Historia, Matemáticas, Personajes

(Vídeo) Solución en 3D para el enigma de los azulejos que aparecen y desaparecen

Seguro que muchos de vosotros conocéis el caso de los azulejos que aparecen y desaparecen (que también se vio con tabletas de chocolate) que se hizo famoso hace unos meses. En la red se podían ver vídeos y animaciones de todo tipo en los que al eliminar algunas piezas de una cuadrícula (de azulejos o de chocolate) la propia cuadrícula parecía quedar tal cual estaba al principio. ¿Llegasteis a ver alguna solución que explicara por qué ocurría aquello?

Antes de nada vamos a ver el vídeo que publiqué en este blog en marzo de este año sobre el tema:

Impresionante, ¿verdad? Bueno, en realidad tampoco lo es tanto, como es natural.

Bien, en aquel post ya decíamos que parece ser que la solución del asunto tiene que ver con el famoso juego inventado por Martin Gardner en el que al recolocar las piezas en las que está dividido un triángulo un cuadradito desaparece:

Bien, pues hoy os traigo una solución en 3D que posiblemente termine por explicar este tema a todos los que todavía no lo hubieran visto (seguro que quedaba gente). Ahí va:

Ahora volved a ver el vídeo anterior. ¿Os cuadra esta explicación? Seguro que no habíais imaginado que podría ser por algo así.

Esta es mi cuarta aportación a la Edición 4.1231056 del Carnaval de Matemáticas, cuyo anfitrión es nuestro amigo José Manuel López Nicolás en su blog Scientia.

Entra en Gaussianos si quieres hacer algún comentario sobre este artículo, consultar entradas anteriores o enviarnos un mensaje.

Vota a Gaussianos en los Premios Bitácoras 2013

Si no sabes cómo hacerlo te lo explico aquí.

Construye tú también el poliedro de Császár.

Cecilia Payne-Gaposchkin

Durante mucho tiempo se pensó que la composición de las estrellas como nuestro Sol debían ser muy similares a la composición de planetas como el nuestro. La persona que nos sacó de ese error no fue un astrónomo… sino una astrónoma. La maravillosa Cecilia Payne. Lo que vais a leer está sacado del libro Eurekas y Euforias, de Walter Gratzer, otro de aquellos libros maravillosos que recomiendo leer. Me encanta la conclusión final. Sin más preámbulo os copio y pego lo que dice ese libro.

Cecilia Payne-Gaposchkin (1900-1979) fue una astrónoma de gran relieve que sin duda hubiera logrado aún más de lo que consiguió si no hubiera tenido que luchar contra los prejuicios de una profesión aferrada a la tradición. Licenciada en Cambridge inmediatamente después de la primera guerra mundial, intentó inicialmente hacerse bióloga, pero la física formaba parte de su Tripos en Ciencia Natural y así se encontró en el Laboratorio Cavendish, aterrorizada por unos profesores predominantemente misóginos, especialmente Ernest Rutherford, en cuyas clases fue obligada, como única mujer, a sentarse en la primera fila y ser la receptora de las ironías olímpicas del gran hombre.

El trabajo de laboratorio era el terreno del doctor Searle, una némesis barbada y explosiva que producía terror en mi corazón. Si uno cometía un error era enviado a permanecer «de pie en el rincón» como un niño que se ha portado mal. No tenía paciencia con las estudiantes femeninas. Decía que perturbaban el equipamiento magnético y más de una vez le oí gritar: «¡Vaya y quítese su corsé!», pues la mayoría de las chicas llevaban entonces esas prendas en las que los huesos de ballena que les daban rigidez empezaban a ser reemplazados por varillas de acero. Pese a todas sus excentricidades, nos dio una excelente formación en todo tipo de medidas precisas y en el tratamiento correcto de los datos.

La epifanía de Cecilia Payne llegó una tarde cuando, como ella dijo, se le abrió espectacularmente la puerta a un nuevo mundo:

Estaba prevista una conferencia en la Gran Sala del Trinity College. El profesor Eddington iba a anunciar los resultados de la expedición que había dirigido en 1919 para observar el eclipse en Brasil. A los estudiantes del Newnham College se les habían asignado cuatro entradas para la conferencia y (casi por accidente, pues uno de mis amigos no pudo ir) una entrada me tocó a mí. La gran sala estaba abarrotada. El orador era un hombre delgado y de tez oscura que parecía ajeno a su audiencia y hablaba con una completa indiferencia. Hizo un esbozo de la Teoría de la Relatividad en lenguaje popular, como nadie mejor que él podría hacerlo. Describió la contracción de Lorentz-Fitzgerald [una manifestación de la relatividad], el experimento de Michelson-Morley [medida de la velocidad de la luz] y sus consecuencias [la eliminación del éter de la física, de acuerdo con la teoría de Einstein]. Llegó al desplazamiento de las imágenes estelares cerca del Sol tal como predecía Einstein y describió su verificación de la predicción. El resultado fue una completa transformación de mi imagen del mundo. De nuevo fui consciente del estruendo que produjo la comprensión de que todo movimiento es relativo. Cuando volví a mi habitación descubrí que podía reproducir la conferencia palabra por palabra … Creo que durante tres noches no dormí. Mi mundo había quedado tan sacudido que experimenté algo muy parecido a una depresión nerviosa.

Desde entonces, Cecilia Payne quedó completamente enamorada de la astronomía. Leyó todos los libros sobre el tema que pudo encontrar en la biblioteca. El maravilloso Hypothéses cosmogoniques de Henri Poincaré se convirtió, recuerda ella, en una fuente perenne de inspiración.

Supe que iba a haber una noche abierta al público en el Observatorio. Fui en bicicleta por Madingley Road y encontré a los visitantes reunidos en el telescopio Sheepshanks, ese curioso instrumento que, en palabras de William Marshall [un astrónomo residente] «combinaba todas las desventajas de un refractor y un reflector» … El brusco pero amable segundo ayudante, Henry Green, estaba ajustando el telescopio y al poco tiempo tuve una vista de una estrella doble cuyas componentes (como él señaló) diferían en color. «¿Cómo puede ser eso si tienen la misma edad?», le pregunté. Él no encontraba una respuesta y viendo que yo seguía con mis preguntas abandonó desesperado. «Te dejaré encargada de esto», dijo, y se fue escaleras abajo. Para entonces, él había orientado el instrumento a la espiral Andrómeda. Yo empecé a explayarme sobre ella (¡el cielo perdone mi presuntuosidad!) y estaba de pie con una niña pequeña en mis brazos diciéndole lo que tenía que mirar. Oí una risa ahogada detrás de mí y encontré a Eddington allí de pie.

Como le oí decir más tarde cuando llegué a conocerle, Henry Green había ido al estudio de «el profesor» y le dijo: «Hay una mujer haciendo preguntas», y le pidió ayuda. Había llegado el momento y no perdí la oportunidad. Le dije que me gustaría ser astrónoma. ¿Fue entonces o fue más tarde cuando me dio la respuesta que iba a sostenerme frente a tantos rechazos? «No puedo ver ninguna objeción insuperable». Le pregunté qué debería leer. Él mencionó varios libros y descubrí que los había leído todos. Así que él me remitió al Monthly Notices y al Astrophysical Journal. Estaban disponibles en la biblioteca del Observatorio en la que dijo que yo sería bienvenida. Para parafrasear el epitafio de Herschel [William Herschel, el astrónomo del siglo XVIII, él me había abierto las puertas de los cielos.

El entusiasmo y la determinación de Cecilia Payne le ganaron la estima de los más jóvenes y más brillantes astrónomos de Cambridge. Así es como conoció a uno de los más famosos:

Una tarde subí en bicicleta al observatorio de Física Solar con una pregunta en mi mente. Encontré a un joven, al que el cabello le caía sobre los ojos, que estaba sentado en el tejado de uno de los edificios y reparándolo. «He venido a preguntar», le grité, «por qué el efecto Stark [el efecto de un campo eléctrico sobre la posición de las líneas de un espectro] no se observa en los espectros estelares». Bajó y se presentó como E. A. Milne, el segundo en el mando del observatorio. Más tarde se convirtió en un buen amigo y una gran inspiración para mí. No sabía la respuesta a mi pregunta, que sigue preocupándome.

A pesar del apoyo de Milne y Eddington, Cecilia Payne no pudo progresar en el mundo cerrado de la astronomía británica, de modo que se trasladó a Harvard donde siguió una carrera notable. Su trabajo más famoso concernía a la composición del Sol. Ella demostró que la interpretación entonces aceptada de las líneas del espectro de la luz solar —según la cual éstas reflejaban la presencia de hierro en gran abundancia en el interior del Sol— estaba equivocada.