Jean-Philippe Encausse

Shared posts

Actualité : Adresses électroniques piratées : l'inquiétante vente de HIBP

Funko Releases a “Paint Yourself” Warhammer 40K Pop Vinyl Intercessor Ultramarine

Funko has recently started releasing various Warhammer 40K collectible Pop Vinyls, but their latest one, which will be available on June 29 for Warhammer day, is a little special: You can paint it yourself! I mean, you already do it for most of your collectible Space Marines figures, so why not do it with a Funko Pop?

On June 29, the Intercessor Ultramarine Pop will be available from the Games Workshop website and in Warhammer stores.

[Via: warhammer-community.com]

The post Funko Releases a “Paint Yourself” Warhammer 40K Pop Vinyl Intercessor Ultramarine appeared first on Geeks are Sexy Technology News.

New Experiment Will Test EmDrive That Breaks the Laws of Physics

Dream Machine

For nearly 20 years, scientists have debated the viability of an EmDrive, a hypothetical type of engine that could propel a spacecraft without the need for any fuel.

If that sounds too good to be true, that’s because it probably is — a working EmDrive would literally break one of the foundational laws of physics — but that hasn’t stopped scientists from top research organizations including NASA and DARPA from pursuing the tech, because the payoff would be so extraordinary.

Now, a team of German physicists is conducting a new EmDrive experiment — and this one could end the debate surrounding the controversial concept once and for all.

Thrust Bust

In 2001, British scientist Roger Shawyer proposed the idea of generating thrust by pumping microwaves into a conical chamber. They’d then bounce off the cone’s walls, exerting enough force to power spacecraft.”

The problem is that this would essentially be creating force out of nothing, which isn’t possible according to the law of conservation of momentum.

Still, a handful of researchers claim they’ve managed to generate some thrust in their EmDrive experiments — though the amount is so low that it’s thus far been hard to say whether the device was in fact generating the thrust or whether it was caused by some outside influence, such as the Earth’s magnetism or seismic vibrations.

Sensitivity Training

To clear up the controversy, the team from Technische Universität Dresden has built a super-sensitive instrument for measuring thrust that they believe to be immune to the outside interference plaguing other studies.

They plan to publish the latest results of their EmDrive experiments in the journal Acta Astronautica in August, according to a new Wired profile of their work, and lead research Martin Tajmar told the publication he thinks we might be just a few months away from finally putting the EmDrive debate to bed.

READ MORE: A MYTHICAL FORM OF SPACE PROPULSION FINALLY GETS A REAL TEST [Wired]

More on EmDrive: China Claims It’s Made the Impossible EmDrive Possible

The post New Experiment Will Test EmDrive That Breaks the Laws of Physics appeared first on Futurism.

Amazon will soon make having a chat with Alexa feel more natural

At its re:Mars conference, Amazon today announced that it is working on making interacting with its Alexa personal assistant more natural by enabling more fluid conversations that can move from topic to topic — and without having to constantly say “Alexa.”

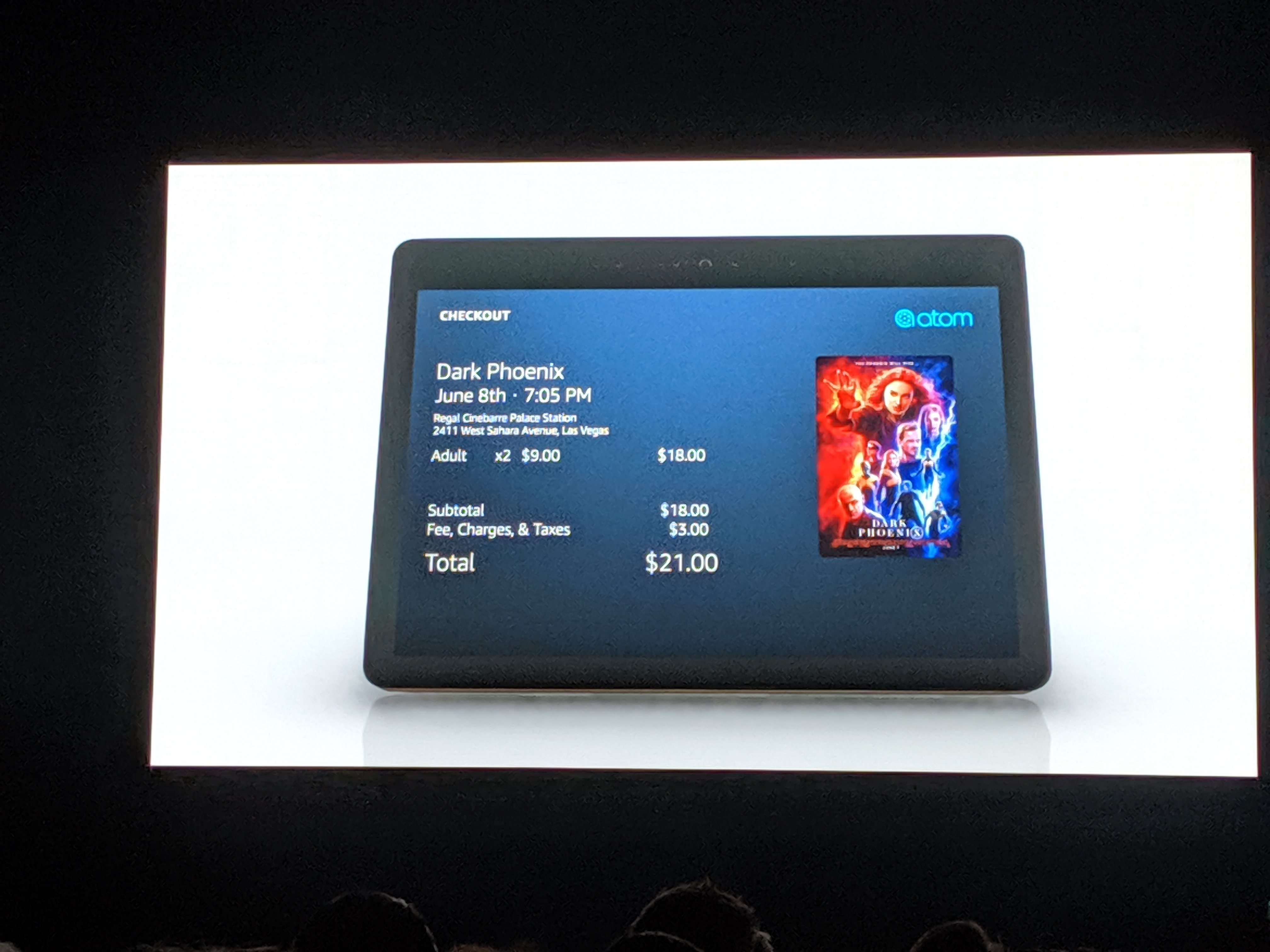

At re:Mars, the company showed a brief demo of how this would work to order movie tickets, for example, taking you from asking “Alexa, what movies are playing nearby?” to actually selecting the movie, buying the tickets and making a restaurant reservation nearby — and then watching the trailer and ordering an Uber.

In many ways, this was a demo that I would have expected to see from Google at I/O, but Amazon has clearly stepped up its Alexa game in recent months.

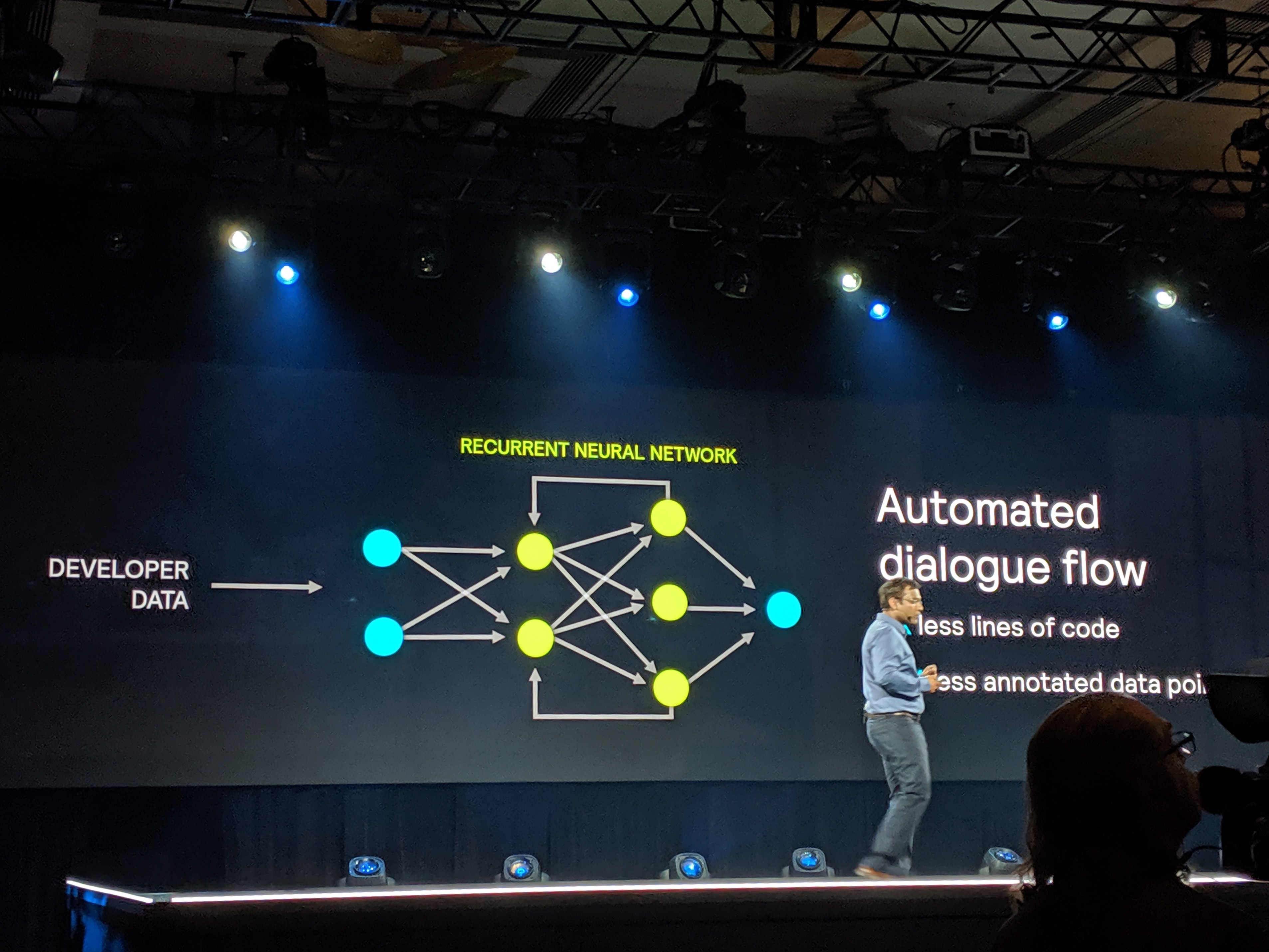

The way the company is doing this is by relying on a new dialogue system that can predict next actions and easily switch between different Alexa skills. “Now, we have advanced our machine learning capabilities such that Alexa can predict customer’s true goal from the direction of the dialogue, and proactively enable the conversation flow across skills,” the company explained.

This new experience, which Amazon demoed on an Alexa Show, with the appropriate visual responses, will go live to users in the coming months.

Over the last few months, the company also announced today, Alexa became 20% more accurate in understanding your requests.

In addition, developers will be able to make use of some of these technologies that Amazon is using for this new dialogue tool. This new tool, Alexa Conversations, allows developers to build similar flows. Traditionally, this involved writing lots of code, but Alexa Conversations can bring this down by about a third. The developer simply has to declare a set of actions and a few example interactions. Then, the service will run an automated dialogue simulator so that the developers don’t actually have to think of all the different ways that a customer will interact with their skills. Over time, it will also learn from how real-world users interact with the system.

[NUMBERS] Le podcast, un marché publicitaire à 1 milliard de dollars aux Etats-Unis en 2021

Le marché des publicités dans les podcasts a progressé de 53% en 2018, par rapport à 2017.

L’article [NUMBERS] Le podcast, un marché publicitaire à 1 milliard de dollars aux Etats-Unis en 2021 est apparu en premier sur FrenchWeb.fr.

Gorgeous Variant Fan Covers and Artwork for Supergirl Comics

A series of gorgeous variant cover for Supergirl comics by artist Artgerm.

The post Gorgeous Variant Fan Covers and Artwork for Supergirl Comics appeared first on Geeks are Sexy Technology News.

Paper Strandbeest Is Strong Enough To Walk

Most readers will be familiar with the work of the Dutch artist Theo Jansen, whose Strandbeest wind-powered mechanical walking sculptures prowl the beaches of the Netherlands. The Jansen linkage provides a method of making machines with a curious but efficient walking gait from a rotational input, and has been enthusiastically copied on everything from desktop toys to bicycles.

One might think that a Jansen linkage would be beyond some materials, and you might be surprised to see a paper one. Step forward [Luis Craft] then, with a paper walking Strandbeest. Designed in Blender, cut on a desktop CNC paper cutter, and driven by a pair of small robots linked to an Arduino and controlled by a Bluetooth link, it has four sets of legs and can push around desktop items. We wouldn’t have thought it possible, but there it is.

He claims that it’s an origami Strandbeest, but we’re not so sure. We’re not papercraft experts here at Hackaday, but when we put on our pedantic hat, we insist that origami must be made of folded paper in the Japanese style rather than the cut-and-glue used here. This doesn’t detract from the quality of the work though, as you can see in the video below.

We think this is the first paper Strandbeest we’ve seen, but we’ve brought you countless others over the years. Here’s [Jansen]’s latest, wave-like take on the idea.

Leap Motion racheté par une société de contrôle haptique anglaise

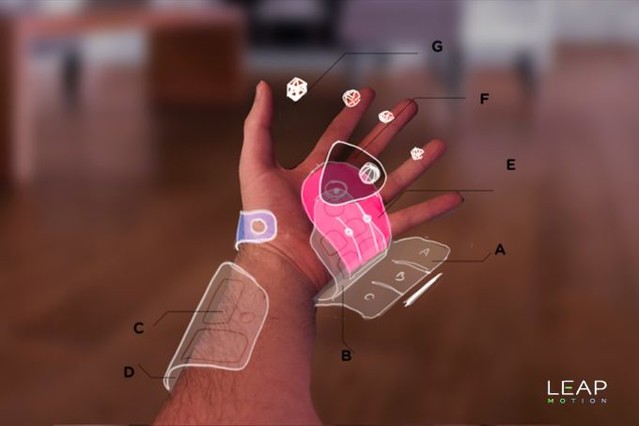

Six ans se sont écoulés depuis le Buzz planétaire de Leap Motion. La marque qui, avec de simples capteurs infrarouges et un algorithme un peu fou, permettait de comprendre les objets situés dans son champ de vision. En 2013, la Start Up recevait 300 millions de dollars et réussissait un financement participatif magistral.

Faute de développements réellement utiles, d’intérêt pour les dévellopeurs à vrai dire avec un modèle économique passant exclusivement sur un store un peu moisi piloté par Leap Motion lui même, la sauce n’a pas pris. Si la société avait simplement demandé des royalties sur les matériels et une faible licence sur le logiciel, peut être que le sort en aurait été autrement. Mais avec l’obligation de vendre ses développements sur le store de la marque, personne n’a eu ni la publicité méritée, ni les retours financiers pour continuer à développer des applications.

Résultat, après une approche d’Apple pour acquérir cette technologie de contrôle gestuel, c’est finalement un autre acteur du monde de la VR qui s’en empare. UltraHaptics développe des solutions de retours haptiques pour la VR comme pour le mobilier tactile. Avec Leap Motion, ils pourront proposer une solution probablement plus efficace encore. La marque vise surtout les kiosques, les tableaux de bord et autres outils domotiques. On imagine l’intérêt d’une borne interactive située derrière la vitre d’un magasin ou l’intérêt de coupler un retour haptique qui crée une sensation de toucher d’un objet virtuel avec la visualisation précise de vos mains dans l’espace quand vous avez un casque VR vissé sur la tête.

C’est probablement la fin de Leap Motion comme produit accessible directement au grand public.

Source : The Wall Street Journal

Leap Motion racheté par une société de contrôle haptique anglaise © MiniMachines.net. 2019

Astounding AI Guesses What You Look Like Based on Your Voice

Vox Humana

A new artificial intelligence created by researchers at the Massachusetts Institute of Technology pulls off a staggering feat: by analyzing only a short audio clip of a person’s voice, it reconstructs what they might look like in real life.

The AI’s results aren’t perfect, but they’re pretty good — a remarkable and somewhat terrifying example of how a sophisticated AI can make incredible inferences from tiny snippets of data.

Biometric Characteristics

In a paper published this week to the preprint server arXiv, the team describes how it used trained a generative adversarial network to analyze short voice clips and “match several biometric characteristics of the speaker,” resulting in “matching accuracies that are much better than chance.”

That’s the carefully-couched language of the researchers. In practice, the Speech2Face algorithm seems to have an uncanny knack for spitting out rough likenesses of people based on nothing but their speaking voices.

Face/Off

The MIT researchers urge caution on the project’s GitHub page, acknowledging that the tech raises worrisome questions about privacy and discrimination.

“Although this is a purely academic investigation, we feel that it is important to explicitly discuss in the paper a set of ethical considerations due to the potential sensitivity of facial information,” they wrote, suggesting that “any further investigation or practical use of this technology will be carefully tested to ensure that the training data is representative of the intended user population.”

Editor’s note: This story mistakenly identified Speech2Voice as a Carnegie Mellon University project, not an MIT one. It has been updated.

READ MORE: Speech2Face: Learning the Face Behind a Voice [arXiv]

More on neural networks: A Neural Net Hooked Up to a Monkey Brain Spat Out Bizarre Images

The post Astounding AI Guesses What You Look Like Based on Your Voice appeared first on Futurism.

Wireless LEDs Aren’t A First, But You Can Make Your Own

Wireless LEDs. That’s what [Scotty Allen] found in Japan, and if you find something you just have to replicate it.

[Scotty] found these wireless LEDs in a display stand for model makers and gunpla. Because you don’t want to run wires, drill holes, and deal with fiber optics when illuminating plastic models, model companies have come up with wireless LEDs. Just glue them on, and they’ll blink. It requires a base station, but these are wireless LEDs.

After buying a few of these LEDs and sourcing a base station, [Scotty] found the LEDs were three components carefully soldered together: an inductor, two caps, and the LED itself. The base station is simply two coils and are effectively a wireless phone charger. Oh, some experimentation revealed that if you put one of these wireless LEDs on a wireless phone charger it’ll light up.

The next step is of course replication, so [Scotty] headed out to Akihabara and grabbed some wire, resistors, and LEDs. The wire was wrapped into a coil, a LED soldered on, and everything worked. This is by no means the first DIY wireless LED, as with so many technologies this too hit fashion first and you could buy press-on nails with embedded wireless LEDs for years now. Check out the video below.

Hypervoix (2/2) : les enjeux de la voix au-delà de la voix

L’enjeu des assistants vocaux ne se limite pas à leur seule conception sonore et vocale, comme nous le rappelions dans la première partie de ce dossier. A l’occasion de la journée d’étude Hypervoix qui avait lieu le 15 avril à Paris, retour sur les autres enjeux de conception que posent les assistants vocaux en élargissant le champ des questions et des critiques.

Assistants vocaux : quelles voix pour le design ?

Anthony Masure (@anthonymasure), maître de conférences et chercheur en design, co-organisateur de cette journée d’étude, a introduit la matinée (voir sa présentation) en dressant le bilan d’une précédente journée d’étude, intitulée Vox Machines (dont nous avions rendu compte). Il est revenu notamment sur les projets produits par les étudiants du master Design transdisciplinaire, cultures et territoires de l’université de Toulouse-Jean Jaurès, suite à cette journée, qui ont questionné, par exemple, les enjeux de la normativité des voix (via la question des accents régionaux), ceux de l’interaction entre la voix et sa représentation visuelle (ou comment rendre tangible les voix et les sons, via les projets dernier contact et swiiiing) ou encore d’éprouver de nouvelles formes de commandes vocales (via un sextoy à commande vocale par exemple)… Autant d’exemples et de prototypes qui soulignent combien les usages stéréotypés des assistants vocaux tels qu’ils se proposent aujourd’hui peuvent être subvertis.

Pour Anthony Masure, une conception critique des assistants vocaux nécessite d’interroger les limites des systèmes proposés actuellement. Comment rendre les techniques qui sous-tendent le fonctionnement de ces objets, intelligibles ? Comment ouvrir les usages ? Comment associer les interfaces vocales aux interfaces graphiques ? Comment travailler la question vocale dans toutes ses dimensions et penser l’interaction sonore au-delà de la voix ?… Telles sont quelques-uns des enjeux que posent ces appareils à l’heure où la question vocale incarnée dans les assistants vocaux et leur apparente simplicité ne cesse de masquer la complexité de leur fonctionnement. C’était par exemple tout l’enjeu du travail de Kate Crawford et Vladan Joler qui ont tenté de mettre à jour toute la complexité d’Amazon Echo, de ses impacts techniques de transcription entre la voix et le texte jusqu’au rôle des transcripteurs et écouteurs humains qui se dissimulent derrière ces systèmes présentés pourtant comme complètement automatisés.

Derrière l’aspect ludique de ces appareils, la question de la voix n’est pas sans impacts et enjeux. Par exemple, celle de penser l’interaction vocale au prisme des questions de genre, de classe ou de race. C’est ce que questionne le collectif Feminist Internet qui a travaillé notamment à des prototypes d’une Alexa féministe, pour susciter de la conversation autour des stéréotypes sexistes que perpétuent les assistants trop souvent dotés de voix féminines pour souligner leur serviabilité (et ce alors que les appareils auraient plus de mal à répondre aux commandes provenant de femmes que d’hommes). Bien souvent, contrairement à ce qu’annonce leur marketing, ces appareils qui ne sont pas conçus pour susciter des conversations, mais juste là pour apporter des réponses formatées. Cela montre qu’il est plus que jamais nécessaire d’hybrider la conception des interfaces vocales avec les enjeux de la société d’aujourd’hui. C’est ce que propose par exemple les designers du projet Made in Machina/e, qui veulent faire se rencontrer le design Ikea avec la culture de la fabrication des contrefaçons de matériel électronique des Shanzhai, à l’image des multiples interrogations que pose leur lustre d’iPhone, qui propose de composer son lampadaire de téléphones… On a besoin d’une conception critique des objets technologiques, souligne Anthony Masure en faisant référence au projet de l’artiste Jennifer Lyn Morone, qui a décidé de se transformer elle-même en entreprise, transformant sa santé, son patrimoine génétique, sa personnalité, ses savoir-faire, son expérience en ressources pour en tirer profit. Comment se transformer soi-même en produit qui exploite ses propres ressources ? À l’image des assistants personnels qui exploitent ce qu’on leur dit de nous pour produire leur propre rentabilité depuis l’exploitation de nos données…

Derrière l’aspect ludique de ces appareils, la question de la voix n’est pas sans impacts et enjeux. Par exemple, celle de penser l’interaction vocale au prisme des questions de genre, de classe ou de race. C’est ce que questionne le collectif Feminist Internet qui a travaillé notamment à des prototypes d’une Alexa féministe, pour susciter de la conversation autour des stéréotypes sexistes que perpétuent les assistants trop souvent dotés de voix féminines pour souligner leur serviabilité (et ce alors que les appareils auraient plus de mal à répondre aux commandes provenant de femmes que d’hommes). Bien souvent, contrairement à ce qu’annonce leur marketing, ces appareils qui ne sont pas conçus pour susciter des conversations, mais juste là pour apporter des réponses formatées. Cela montre qu’il est plus que jamais nécessaire d’hybrider la conception des interfaces vocales avec les enjeux de la société d’aujourd’hui. C’est ce que propose par exemple les designers du projet Made in Machina/e, qui veulent faire se rencontrer le design Ikea avec la culture de la fabrication des contrefaçons de matériel électronique des Shanzhai, à l’image des multiples interrogations que pose leur lustre d’iPhone, qui propose de composer son lampadaire de téléphones… On a besoin d’une conception critique des objets technologiques, souligne Anthony Masure en faisant référence au projet de l’artiste Jennifer Lyn Morone, qui a décidé de se transformer elle-même en entreprise, transformant sa santé, son patrimoine génétique, sa personnalité, ses savoir-faire, son expérience en ressources pour en tirer profit. Comment se transformer soi-même en produit qui exploite ses propres ressources ? À l’image des assistants personnels qui exploitent ce qu’on leur dit de nous pour produire leur propre rentabilité depuis l’exploitation de nos données…

« Le design ne peut avoir pour vocation d’accompagner sans heurts le développement du capitalisme cognitif qu’incarnent les assistants vocaux », conclut Anthony Masure. Il n’est pas là pour produire de l’acceptation sociale de procédés qui ne sont pas acceptables. C’est assurément aux designers de trouver des formes d’ancrages permettant de contrecarrer les faisceaux de prescriptions que ces technologies produisent par-devers nous.

Promesses et illusions des interfaces vocales

« Derrière leur promesse de fluidité, d’interaction « naturelle », les assistants vocaux jouent de ce qu’ils disent et entendent, comme de ce qu’ils montrent et cachent de leur fonctionnement. La question de leur conception se joue précisément là, entre ce que l’on voit et ce qui est masqué, entre ce qui est rendu visible, lisible, audible et ce qui est invisibilisé, illisible, et également inaudible ». Cette question de la tension entre visibilité et invisibilité des processus techniques qui façonnent les dispositifs vocaux, est l’une des clés de lecture du programme Hypervoix, explique Cécile Christodoulou, qui copilote ce programme de recherche de la Fing avec Véronique Routin (voir sa présentation).

Depuis leurs apparitions, les principaux usages des assistants vocaux sont demeurés simples et constants : poser une question, lancer sa musique, demander la météo ou programmer une alarme sont toujours en tête des usages. Pourtant, de nouvelles pratiques apparaissent, principalement liées aux fonctions domotiques et ludiques des applications que l’on trouve dans les magasins d’applications vocales qu’ont ouverts Amazon et Google. Pour l’instant, comme le souligne l’étude d’usage de voicebot.ai, le problème de ces applications vocales tierces consiste plutôt à les trouver qu’à les utiliser… Si la découverte était améliorée, peut-être que certaines applications pourraient alors venir bousculer la monotonie des usages des interfaces vocales. Cela ne signifie pas pour autant que l’application vocale de la relation client dont rêvent nombre de grandes entreprises qui se lancent sur le créneau de la voix sera simple à construire… Mais que peut-être, certaines d’entre elles pourraient se faire une place dans le paysage des usages des interfaces vocales.

Le système technique des assistants vocaux demeure complexe, comme l’ont montré Kate Crawford et Vladan Joler. La simple formulation d’une requête telle que “quel temps fait-il ?” implique, pour que l’IA donne une réponse, des ressources naturelles, des lignes d’assemblage, des données et du travail humain pour entraîner la machine. On s’aperçoit que la forme de ces objets, qui semblent si anodins, masque une complexité technique invisible et un coût social, environnemental et économique significatif. Nous sommes encore bien loin de la machine auto-apprenante, intelligente, que les assistants vocaux nous promettent, à l’image du témoignage publié par la Quadrature du net qui montrait comment nos conversations avec les machines sont écoutées, retranscrites, analysées par des humains, véritables « dresseurs d’IA » invisibles. L’impact social des techniques vocales est un enjeu encore bien insuffisamment documenté.

Un autre enjeu majeur de ces technologies repose sur la communication entre l’homme et la machine (ou l’humain derrière la machine) : comment se fait-on comprendre par la machine ? Comment formuler sa requête ? L’art de la conversation avec les machines semble encore à explorer, tant nous sommes loin de la fluidité ou du « naturel » annoncé. Et ce alors que chacun a sa “façon de parler”, son tempo, son style d’interaction, directif, poli, articulé ou non… Sans compter les particularités locales et culturelles : en français par exemple, “Avec ça”, est interprété par erreur comme le mot clé d’activation “Alexa”. « À l’avenir, faudra-t-il inventer de nouveaux langages humain-machine, une langue commune et spécifique à l’interaction avec les machines ? »

La relation de confiance entre l’utilisateur et ces objets connectés est également importante : comment rendre visible la voix ou l’écoute, comment savoir si un objet est équipé d’un micro ou doté d’une voix ? Récemment, lors d’une mise à jour de la suite domotique Nest Secure (le système de sécurité domestique de Google), Google a annoncé que la commande vocale était désormais active, sans avoir jamais prévenu ses clients dans la notice de l’appareil qu’un micro était pré-installé dans l’appareil. Un exemple parmi d’autres qui questionne la confiance que l’utilisateur peut accorder aux concepteurs de ces dispositifs. À titre prospectif, se pose la question de la conception des systèmes vocaux et de leur capacité à rendre visibles l’interaction vocale et l’écoute.

La question de la confiance, de la surveillance, capacité intrinsèque de ces outils, et de l’intrusion dans nos vies privées, ne cesse d’interroger les acteurs du secteur. Plusieurs projets tentent d’apporter des réponses ou de questionner ces enjeux, à l’image du projet Alias, développé par Borek Karmann et Topp Tore Knudsen. Alias se présente comme un « parasite », un couvercle imprimé en 3D qui se fixe au sommet d’une enceinte intelligente ; à l’intérieur, un microphone et deux haut-parleurs produisent un bruit blanc qui empêche le haut-parleur cible de s’activer. Le système permet à l’utilisateur de paramétrer un mot d’activation personnel pour « libérer » l’écoute de son assistant vocal et de permettre aux utilisateurs de retrouver du contrôle sur ces machines.

La question de la confiance, de la surveillance, capacité intrinsèque de ces outils, et de l’intrusion dans nos vies privées, ne cesse d’interroger les acteurs du secteur. Plusieurs projets tentent d’apporter des réponses ou de questionner ces enjeux, à l’image du projet Alias, développé par Borek Karmann et Topp Tore Knudsen. Alias se présente comme un « parasite », un couvercle imprimé en 3D qui se fixe au sommet d’une enceinte intelligente ; à l’intérieur, un microphone et deux haut-parleurs produisent un bruit blanc qui empêche le haut-parleur cible de s’activer. Le système permet à l’utilisateur de paramétrer un mot d’activation personnel pour « libérer » l’écoute de son assistant vocal et de permettre aux utilisateurs de retrouver du contrôle sur ces machines.

Finalement, on peut également interroger la réponse unique donnée par l’assistant vocal. À la différence de l’écran, la voix ne permet pas de proposer en simultané plusieurs réponses. C’est une des grandes limites aujourd’hui des assistants vocaux, incapables d’un art de la conversation. Comment la réponse est-elle choisie ? Quelle est sa qualité, pertinence, précision ? L’Arcep, autorité de régulation, alertait dans un rapport sur cet enjeu politique et économique des terminaux : “lorsqu’elles sont contraintes à une restitution orale, les enceintes connectées ne fournissent souvent qu’un seul résultat pour une requête, choisi par l’algorithme de classement. […] il reste que la nécessité d’une réponse unique constitue une restriction structurelle à l’ouverture d’internet.”

Face à ces enjeux (et il y en a d’autres, comme la faible portabilité des données vocales ou les limites de l’interaction quand elle est uniquement basée sur la voix), le défi est de parvenir à mieux cartographier et prioriser ces questions au croisement de la recherche, du développement et de leurs impacts sociaux.

Partager la parole avec les machines

« Le premier outil de régulation d’un État de droit est la parole », explique la philosophe Cynthia Fleury. C’est dire si la voix et ses impacts ne sont pas à prendre à la légère, rappelle la designer Zoé Aegerter de l’agence de design fiction spécialisée dans les questions vocales, Postillon prospective (voir sa présentation .pdf). Notre société est en apparence bavarde, mais ce n’est pas sans finalité. La parole est un moyen d’agir ! Si la parole reste un exercice difficile, qui nécessite d’en maîtriser des codes multiples qui ne sont pas accessibles à tous, celle-ci ne se déploie pas de la même manière et par les mêmes personnes selon qu’elle s’exprime sur un plateau télévisé, à l’Assemblée nationale ou à la terrasse d’un café. En cela, la parole est influencée par les dispositifs dans lesquels elle s’exprime. D’où l’importance de la conception des dispositifs et espaces qui l’accueillent.

C’est ce que réalise la designer avec le projet de « concerteur » des causeuses électroniques. Le concerteur est une boîte vocale à laquelle on envoie des messages par SMS et qui, via une voix de synthèse, permet d’écouter les réactions du public à la question à laquelle ils ont répondu par SMS. Pour Zoé Aegerter, ce prototype est un moyen d’humaniser les interfaces en réduisant la distance entre l’humain et la technique. A l’heure où l’humain perd le monopole de la parole et doit le partager avec les machines, il est nécessaire de réfléchir à développer des modes de communication inter-espèces plus accessibles.

C’est ce que réalise la designer avec le projet de « concerteur » des causeuses électroniques. Le concerteur est une boîte vocale à laquelle on envoie des messages par SMS et qui, via une voix de synthèse, permet d’écouter les réactions du public à la question à laquelle ils ont répondu par SMS. Pour Zoé Aegerter, ce prototype est un moyen d’humaniser les interfaces en réduisant la distance entre l’humain et la technique. A l’heure où l’humain perd le monopole de la parole et doit le partager avec les machines, il est nécessaire de réfléchir à développer des modes de communication inter-espèces plus accessibles.

Trop souvent encore, la machine ne comprend pas l’intention. Quand on demande la météo à un assistant vocal par exemple, l’intention non explicite de la question consiste à savoir si l’on doit prévoir de prendre son parapluie ou comment s’habiller en conséquence… Cela montre que la réponse apportée (« forts risques d’averses annoncés pour demain ») ne correspond pas toujours exactement à l’intention non exprimée. C’est tout l’enjeu du travail de design et de conception des dialogues de la machine d’implémenter des réponses qui correspondent mieux aux attentes humaines. Pour l’instant, l’assistant vocal demeure un pantin technologique qui dépend entièrement des choix de conception qui le façonne. Dans un prototype de jeu pour enfant réalisé pour EDF afin de les sensibiliser aux enjeux écologiques dans l’habitat, la designer a conçu une application vocale où des comédiens donnaient une voix à des objets domestiques que les enfants devaient reconnaître et trouver. Cette voix des objets était elle-même une synthèse, une rencontre hybride entre la voix humaine et celle des machines. Une manière à nouveau d’interroger les enjeux du rapport humain-machine, pour tenter de trouver des pistes pour vivre avec les machines vocales. La designer a produit d’ailleurs des cartes de scénarios de réflexion sur les formes de prospective autour de la parole, en proposant des scénarios qui interrogent les espaces, les identités, les environnements cognitifs comme l’économie de la parole. Un moyen complémentaire pour cartographier les enjeux à venir de la voix à mesure qu’ils vont envahir nos interactions.

Image : cartographie de scénarios d’enjeux prospectifs de la parole par Postillon Prospective.

Vers une relation schizophrénique avec les interfaces vocales ?

Notre collègue Rémi Sussan, journaliste pour InternetActu.net, avait la mission, lors de cette journée d’étude, d’éclairer l’avenir des interfaces vocales.

L’avenir des interfaces, de la relation entre l’homme et la machine, semble balancer, hésiter, entre deux visions, deux tendances opposées : d’un côté la machine qui s’intègre à nous, qui connecte nos cerveaux à des extensions, les augmente ; de l’autre la projection de l’homme dans la machine, notre intégration à des formes de réalité virtuelle. On peut d’ailleurs envisager une synthèse entre ces deux approches : la réalité virtuelle totale, celle où le cerveau se connecte directement au monde virtuel. C’est bien sûr l’idée de base du film Matrix, mais également celle du cyberespace imaginé par l’auteur de science-fiction William Gibson dans son roman Neuromancien.

Les auteurs de science-fiction ont imaginé des futurs lointains qui ne sont bien sûr pas près de se réaliser. Mais on observe déjà des recherches contemporaines qui apparaissent comme des petits pas vers les fantasmes les plus fous… Outre le cyberespace, l’une des présentations sciences-fictionnelles les plus excitantes de la réalité virtuelle est celle donnée par Bruce Sterling dans son livre La Schismatrice. Il y imagine une « arène » où les joueurs doivent se combattre en se retrouvant dans le corps d’une créature dont ils ne connaissent pas la nature et les capacités. Ils doivent donc apprendre à contrôler leurs corps en même temps qu’affronter leur adversaire.

On imagine souvent la réalité virtuelle comme une technologie essentiellement audiovisuelle, mais pour son créateur, Jaron Lanier, l’un des aspects les plus intéressants de cette technologie est justement de permettre à la conscience d’incarner un autre corps.

Côté interfaces cerveau-machine, les auteurs de SF s’interrogent beaucoup sur les conséquences de la délégation de nos facultés mentales à un système technique extérieur. Dans son excellent roman (le meilleur probablement sur le transhumanisme) Accelerando, Charles Stross met en scène un personnage qui ne quitte jamais ses lunettes, qui concentrent la plupart de ses données personnelles et qui est truffée d’algorithmes et d’IA. Ayant perdu ses dernières, il se demande un moment qui il est, il est frappé d’une espèce d’amnésie : « Cliquez sur mon arborescence mémétique, je suis perdu. Oh merde. Qui suis-je ? Qu’est-il arrivé ? Pourquoi tout est-il flou ? Je ne retrouve plus mes lunettes… »

Cette expérience extrême, les chercheurs en lifelogging (activité qui consiste à enregistrer sa vie en permanence) Jim Gemmel et Gordon Bell, en ont eu un avant-goût. Gemmel a eu l’impression de perdre une partie de sa mémoire à la suite d’un crash de disque dur, tandis que Bell s’est demandé si mylifebits, son logiciel de lifelogging, n’allait pas dégrader la capacité de son cerveau biologique à se ressouvenir.

La télépathie, elle, est l’horizon fantasmatique de l’interface cerveau-machine. Du reste, lorsque le neurologue allemand Hans Berger créa le premier électro-encéphalogramme d’un cerveau humain en 1924, c’était au cours de recherches sur ce mystérieux pouvoir paranormal. Reste que la télépathie est un sujet récurrent de la littérature de SF, qui se développe souvent sous la forme d’une évolution du genre humain comme dans Les enfants de Darwin de Greg Bear, ou via des machines, à l’image du professeur Xavier, dans la saga X-Men qui utilise une machine, le Cerebro, susceptible d’accélérer ses pouvoirs mentaux.

Pourrons-nous un jour lire les pensées grâce aux machines ? Là encore, on en est loin, mais des recherches existent déjà dans ce sens, comme celles de Marcel Just et Tom Mitchell à l’université Carnegie Mellon.

Dans sa trilogie Nexus, Crux et Apex, l’écrivain transhumaniste Ramez Naam imagine une molécule capable de relier les cerveaux entre eux. Dans sa Trilogie du Vide, l’auteur de science-fiction Peter Hamilton imagine un « internet de la pensée ». À l’aide d’outils technologiques, les pensées et les sensations de tout un chacun deviennent accessibles à tous. Mais la réalité est encore bien loin de la fiction. Pour l’instant, on en est encore à tester des « interfaces-cerveau-cerveau », comme celle utilisée par Rajesh Rao et Andrea Stocco, à l’université de Washington.

Reste enfin la question de l’IA. Comment celle-ci peut-elle s’intégrer à une interface cerveau-machine ? Dans son roman Aristoï, Walter Jon Williams imagine que ses personnages sont dotés de « personnalités artificielles ». Autrement dit, à l’intérieur même de leur cerveau vivent des entités purement virtuelles, boostées par des implants IA, avec lesquelles le « moi » d’origine peut discuter et à qui il peut demander différents services. Telle personnalité artificielle est capable par exemple de contrôler les niveaux de stress ou de prendre certaines décisions…

Sommes-nous prêts à devenir des « personnalités multiples » et à abandonner ainsi l’unité de notre moi, à héberger en notre sein des entités extérieures à notre esprit ? Nous n’en sommes peut-être pas si loin d’une certaine manière, s’amuse Rémi Sussan. Il existe déjà, aux marges, toute une sous-culture qui tend vers ce but, celle des « tulpamanciens »…

En tout cas, ces romans comme ce genre de mouvements marginaux nous montrent que bien souvent, l’imaginaire précède la technologie, et non l’inverse. Et que des promesses des interfaces vocales à la télépathie ou à la schizophrénie… Il n’y a parfois qu’un pas !

Hubert Guillaud

Avec la complicité de Fanny Maurel et Véronique Routin.

Si la question des enjeux et de la prospective des interfaces vocales vous intéresse, le programme Hypervoix de la Fing (éditeur d’InternetActu.net) organise le 6 juin une journée de scénarios extrêmes pour mieux en cartographier les enjeux.

Little Lamp To Learn Longer Leaps

Reinforcement learning is a subset of machine learning where the machine is scored on their performance (“evaluation function”). Over the course of a training session, behavior that improved final score is positively reinforced gradually building towards an optimal solution. [Dheera Venkatraman] thought it would be fun to use reinforcement learning for making a little robot lamp move. But before that can happen, he had to build the hardware and prove its basic functionality with a manual test script.

Inspired by the hopping logo of Pixar Animation Studios, this particular form of locomotion has a few counterparts in the natural world. But hoppers of the natural world don’t take the shape of a Luxo lamp, making this project an interesting challenge. [Dheera] published all of his OpenSCAD files for this 3D-printed lamp so others could join in the fun. Inside the lamp head is a LED ring to illuminate where we expect a light bulb, while also leaving room in the center for a camera. Mechanical articulation servos are driven by a PCA9685 I2C PWM driver board, and he has written and released code to interface such boards with Robot Operating System (ROS) orchestrating our lamp’s features. This completes the underlying hardware components and associated software foundations for this robot lamp.

Once all the parts have been printed, electronics wired, and everything assembled, [Dheera] hacked together a simple “Hello World” script to verify his mechanical design is good enough to get started. The video embedded after the break was taken at OSH Park’s Bring-A-Hack afterparty to Maker Faire Bay Area 2019. This motion sequence was frantically hand-coded in 15 minutes, but these tentative baby hops will serve as a great baseline. Future hopping performance of control algorithms trained by reinforcement learning will show how far this lamp has grown from this humble “Hello World” hop.

[Dheera] had previously created the shadow clock and is no stranger to ROS, having created the ROS topic text visualization tool for debugging. We will be watching to see how robot Luxo will evolve, hopefully it doesn’t find a way to cheat! Want to play with reinforcement learning, but prefer wheeled robots? Here are a few options.

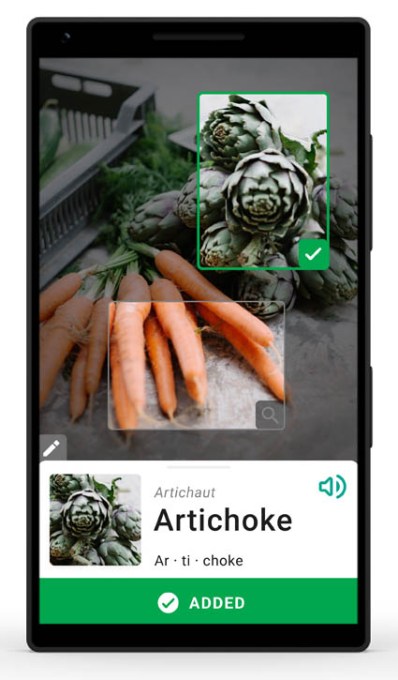

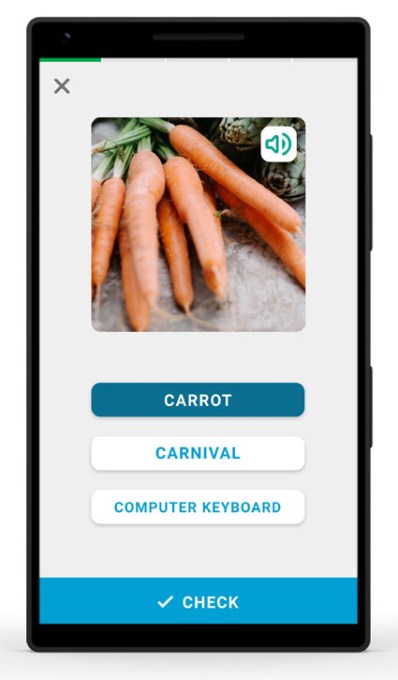

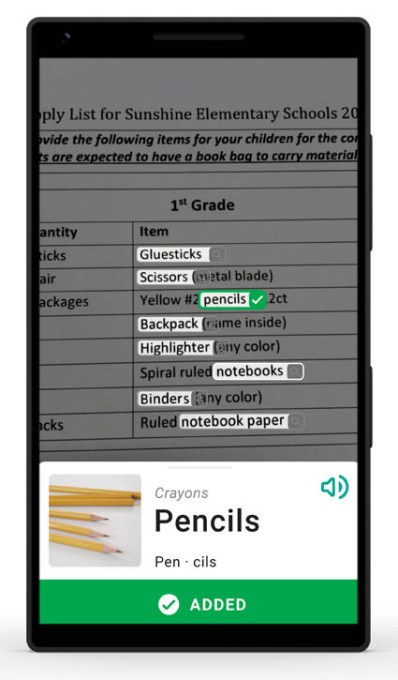

Microsoft’s new language learning app uses your phone’s camera and computer vision to teach vocabulary

Eight Microsoft interns have developed a new language learning tool that uses the smartphone camera to help adults improve their English literacy by learning the words for the things around them. The app, Read My World, lets you take a picture with your phone to learn from a library of more than 1,500 words. The photo can be of a real-world object or text found in a document, Microsoft says.

The app is meant to either supplement formal classroom training or offer a way to learn some words for those who didn’t have the time or funds to participate in a language learning class.

Instead of lessons, users are encouraged to snap photos of the things they encounter in their everyday lives.

“Originally, we were planning more of a lesson plan-style approach, but through our research and discovery, we realized a Swiss army knife might be more useful,” said Nicole Joyal, a software developer intern who worked on the project. “We wound up building a tool that can help you throughout your day-to-day rather than something that teaches,” she said.

Read My World uses a combination of Microsoft Cognitive Services and Computer Vision APIs to identify the objects in photos. It will then show the word’s spelling and speak the phonetic pronunciation of the identified vocabulary words. The photos corresponding to the identified words can also be saved to a personal dictionary in the app for later reference.

Finally, the app encourages users to practice their newly discovered words by way of three built-in vocabulary games.

The 1,500-word vocabulary may seem small, but it’s actually close to the number of words foreign language learners are able to pick up through traditional study. According to a report from the BBC, for instance, many language learners struggle to learn more than 2,000 to 3,000 words even after years of study. In fact, one study in Taiwan found that after nine years of learning a foreign language, students failed to learn the most frequently-used 1,000 words.

The report also stressed that it was most important to pick up the words used day-to-day.

Because the app focuses on things you see, it’s limited in terms of replacing formal instruction. After gathering feedback from teachers and students who tested an early version, the team rolled out a feature to detect words in documents too. It’s not a Google Lens-like experience, where written words are translated into your own language — rather, select words it can identify are highlighted so you can hear how they sound, and see a picture so you know what it is.

For example, the app pointed at a student’s school supply list may pick out words like pencils, notebooks, scissors and binders.

The app, a project from Microsoft’s in-house incubator Microsoft Garage, will initially be made available for testing and feedback for select organizations. Those who work with low literacy communities at an NGO or nonprofit can request an invitation to join the experiment by filling out a form.

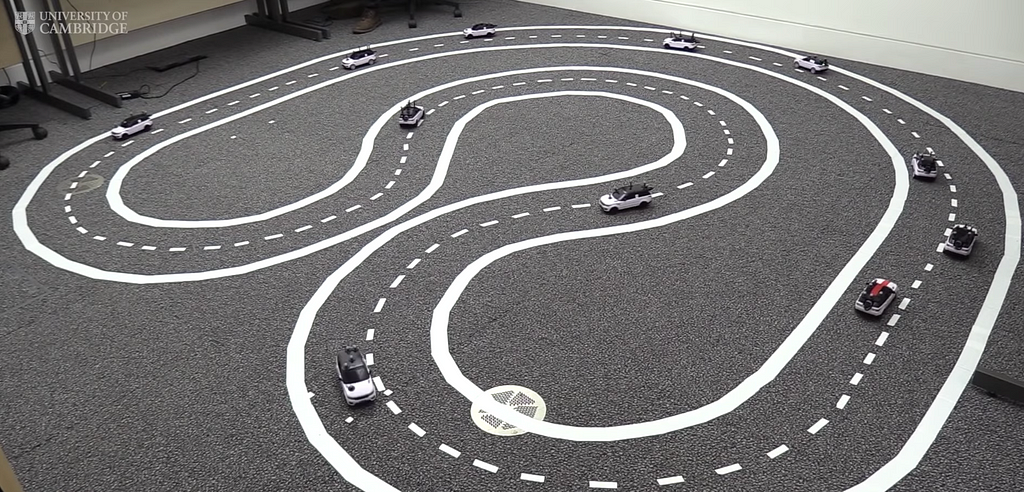

Driverless Range Rovers Collaborate in Tiny Freeway Model

Researchers from the University of Cambridge have deployed a fleet of 1:24 scale autonomous Range Rovers to explore how cars can communicate and work together. Results are promising, with cooperative driving improving traffic flow by 35% in normal driving operation, and a staggering 45% when driving more aggressively.

The experiment takes place on a two-lane simulated freeway marked out on a room’s floor. When properly communicating, SUVs in the right-hand lane can preemptively slow down in order to allow drivers to quickly avoid a stopped car in the left lane, avoiding the need to wait for a random gap in traffic. Driving can be further interfered with by adding a human-controlled aggressive driver, which vehicles also avoid nicely when in communication. Perhaps this improvement is also a lesson in polite and aware driving in general, though data flowing between vehicles gives such systems a vastly improved ability to react.

To accomplish this autonomous and collaborative driving simulation, each mini Rover is embedded with a Raspberry Pi Zero W and uses an L293D motor driver IC for control. While the improved traffic flow and communication is the point of the exercise, the models themselves are quite impressive, and more info on the experiment is available on the project’s research paper.

https://medium.com/media/2c51ea511369cd4131d2e2a365609433/href[h/t: BBC]

Driverless Range Rovers Collaborate in Tiny Freeway Model was originally published in Hackster Blog on Medium, where people are continuing the conversation by highlighting and responding to this story.

Google announces a new $999 Glass augmented reality headset

Google has announced a new version of its business-focused Glass augmented reality headset, which it’s now designating an official Google product instead of an experiment. The Glass Enterprise Edition 2 costs $999, although, like its predecessor, it’s not being sold directly to consumers. It’s got a new processor, an improved camera, a USB-C port for faster charging, and a variety of other updates.

Google still isn’t positioning Glass as a mainstream product. But it seems to be expecting greater sales of the Glass Enterprise Edition 2. The device has been moved out of the Google X “moonshot factory” and into the main Google family of products, letting Google “meet the demands of the growing market for wearables in the workplace,” a...

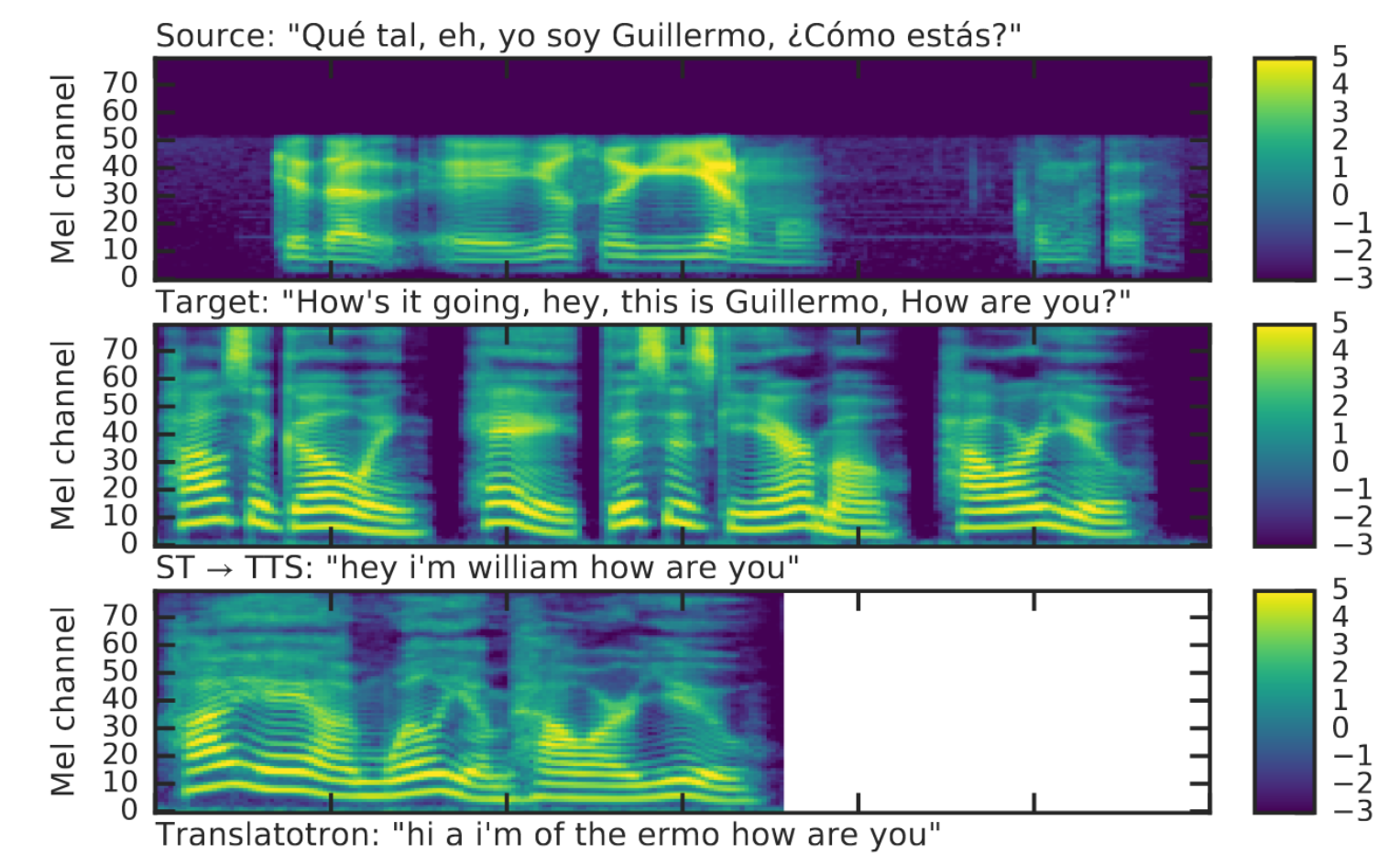

Google’s Translatotron converts one spoken language to another, no text involved

Every day we creep a little closer to Douglas Adams’ famous and prescient Babel fish. A new research project from Google takes spoken sentences in one language and outputs spoken words in another — but unlike most translation techniques, it uses no intermediate text, working solely with the audio. This makes it quick, but more importantly lets it more easily reflect the cadence and tone of the speaker’s voice.

Translatotron, as the project is called, is the culmination of several years of related work, though it’s still very much an experiment. Google’s researchers, and others, have been looking into the possibility of direct speech-to-speech translation for years, but only recently have those efforts borne fruit worth harvesting.

Translating speech is usually done by breaking down the problem into smaller sequential ones: turning the source speech into text (speech-to-text, or STT), turning text in one language into text in another (machine translation), and then turning the resulting text back into speech (text-to-speech, or TTS). This works quite well, really, but it isn’t perfect; each step has types of errors it is prone to, and these can compound one another.

Furthermore, it’s not really how multilingual people translate in their own heads, as testimony about their own thought processes suggests. How exactly it works is impossible to say with certainty, but few would say that they break down the text and visualize it changing to a new language, then read the new text. Human cognition is frequently a guide for how to advance machine learning algorithms.

Spectrograms of source and translated speech. The translation, let us admit, is not the best. But it sounds better!

To that end, researchers began looking into converting spectrograms, detailed frequency breakdowns of audio, of speech in one language directly to spectrograms in another. This is a very different process from the three-step one, and has its own weaknesses, but it also has advantages.

One is that, while complex, it is essentially a single-step process rather than multi-step, which means, assuming you have enough processing power, Translatotron could work quicker. But more importantly for many, the process makes it easy to retain the character of the source voice, so the translation doesn’t come out robotically, but with the tone and cadence of the original sentence.

Naturally this has a huge impact on expression, and someone who relies on translation or voice synthesis regularly will appreciate that not only what they say comes through, but how they say it. It’s hard to overstate how important this is for regular users of synthetic speech.

The accuracy of the translation, the researchers admit, is not as good as the traditional systems, which have had more time to hone their accuracy. But many of the resulting translations are (at least partially) quite good, and being able to include expression is too great an advantage to pass up. In the end, the team modestly describes their work as a starting point demonstrating the feasibility of the approach, though it’s easy to see that it is also a major step forward in an important domain.

The paper describing the new technique was published on Arxiv, and you can browse samples of speech, from source to traditional translation to Translatotron, at this page. Just be aware that these are not all selected for the quality of their translation, but serve more as examples of how the system retains expression while getting the gist of the meaning.

LiDAR Combined with Voice Assistant for Novel Interface Device

Consider smart home assistants. While useful, their interface methods generally consist of responding to voice commands, and some implement a small touchscreen. Normally, there’s no awareness of the surrounding area to tell where, for instance, you’re standing, or if there is an object on the table next to it.

SurfaceSight — a new project from Gierad Laput and Chris Harrison from Carnegie Mellon University’s Future Interfaces Group — takes a (literal) new spin on things, placing a rotating LiDAR unit underneath an Amazon Echo. This technology, most well known for its use in autonomous vehicles, is able to detect when something is in front of the sensor, and can group readings into contiguous objects. With this data, it uses machine learning to classify the type of item sensed, and can even track hand movements and respond to gestures.

The video below shows off some truly impressive abilities, as it’s capable to discriminate between different types of similarly sized objects. It can even roughly sense in which direction a human is facing and modify the way it interacts in response. Possible applications for such tech could include a smart wall or desk surface, or perhaps functionality to tell you where you left your keys or sunglasses!

https://medium.com/media/99efb05232f2a35abefa8cb7d673fc42/href

LiDAR Combined with Voice Assistant for Novel Interface Device was originally published in Hackster Blog on Medium, where people are continuing the conversation by highlighting and responding to this story.

Louis Vuitton and Royole put two web browsers on a handbag

Of all the companies to embrace flexible displays in 2019, we didn’t think the fashion brand Louis Vuitton would be among them. Yet, that’s exactly what it’s done with its new lineup of handbags featuring 1920 x 1440 resolution flexible AMOLED displays from Royole. Engadget reports that LV plans to produce two variations of the so-called Canvas of the Future handbags, one with a single display on each side, and the other with two.

On the runway at Cruise 2020, the screens were set to show an array of colorful urban visualizations, but in a video posted to Instagram one of the bags could also be seen showing a pair of scrolling web browsers. Louis Vitton says that the idea for the handbag is for it to become an extension of the...

Sephora débarque sur Google Nest Hub

Sephora propose des tutos et des astuces beauté sur Google Nest Hub. Il s'agit d'une sorte de Google Home muni d'un écran. Cet appareil se commande à la voix et va être vendu sur le site de Sephora à partir du 28 mai 2019.

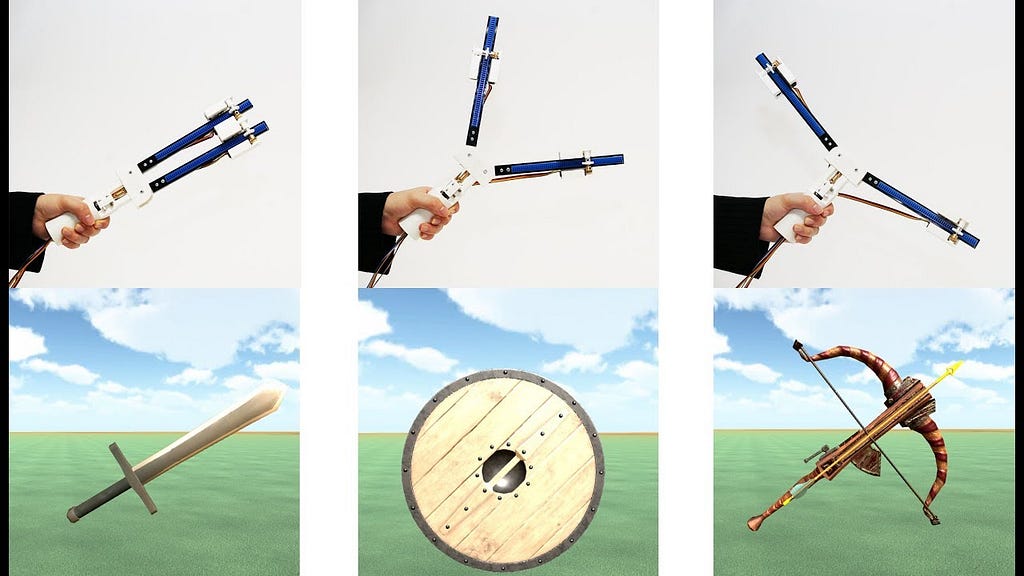

Lire l'articleThe Transcaliber VR Controller Can Render Different 2D Shapes by Changing Its Mass

We humans, are able to estimate the shape of an object by feeling their mass properties while holding them in our hands without needing to see what they are. This sense doesn’t translate well in the VR world, as most controllers offer a static design, with most feedback being vibrational with no options to sense an objects weight or perceived shape. Now some engineers from the University of Tokyo have designed a VR controller that allows you to “feel” various objects in a virtual space by changing its shape.

“We built a computational perception model using a data-driven approach from the collected data pairs of mass properties and perceived shapes. This enables Transcalibur to easily and effectively provide convincing shape perception based on complex illusory effects.”

The Transcalibur VR controller was designed using an angular mechanism (a worm gear drive and a pair of worm wheels) to rotate two independent arms made from acrylic plate and plastic gear tracks. Each arm is equipped with a weight mechanism (also consisting of a worm gear and wheel) that house lead bearings, which travel along the arms to adjust mass for the virtual object rendering.

The controller renders the VR shape using computational perception models obtained by data collection of targeted forms (i.e.: a sword, shield, or crossbow). That data is fitted to a regression model, which predicts the optimal shape, and configures the controller accordingly. It’s currently unknown if the Transcalibur will ever become available on the market, but here’s to wishful thinking that it might.

https://medium.com/media/d3d57af0f93df605a1afa19e57a0ef5c/href

The Transcaliber VR Controller Can Render Different 2D Shapes by Changing Its Mass was originally published in Hackster Blog on Medium, where people are continuing the conversation by highlighting and responding to this story.

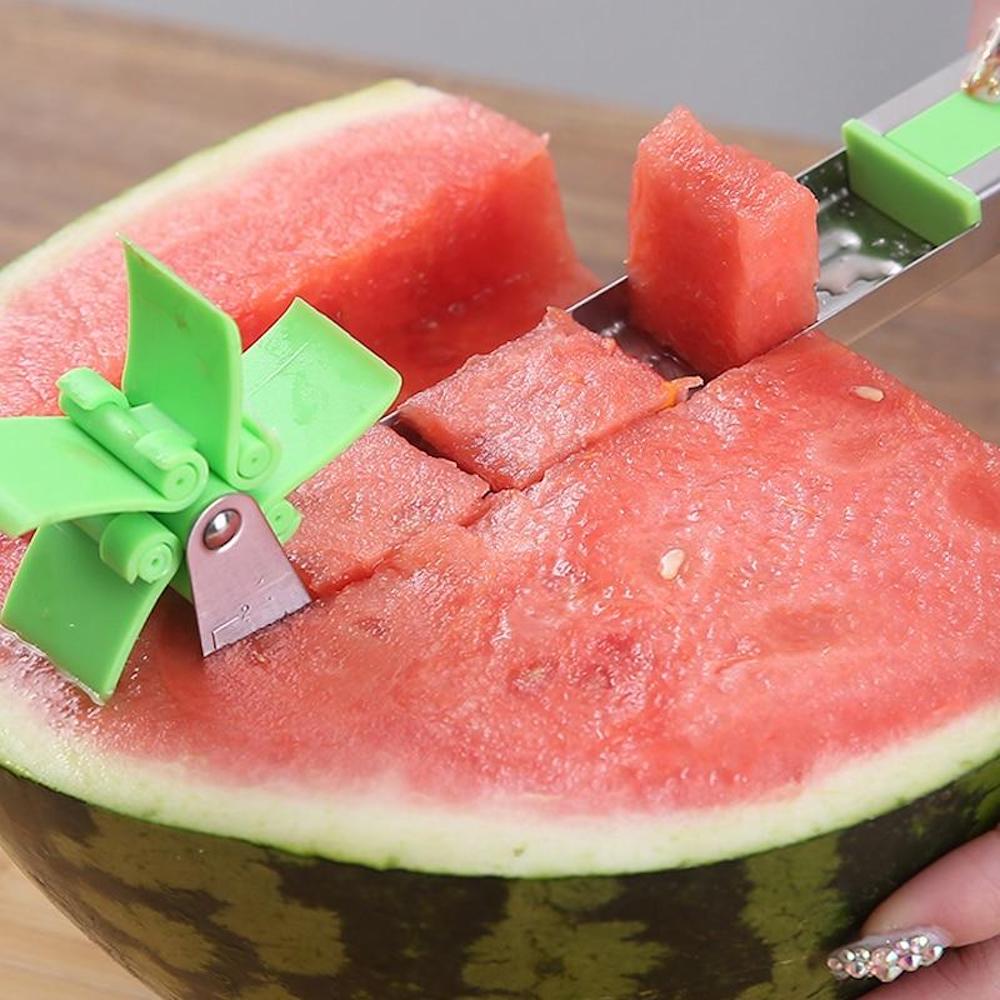

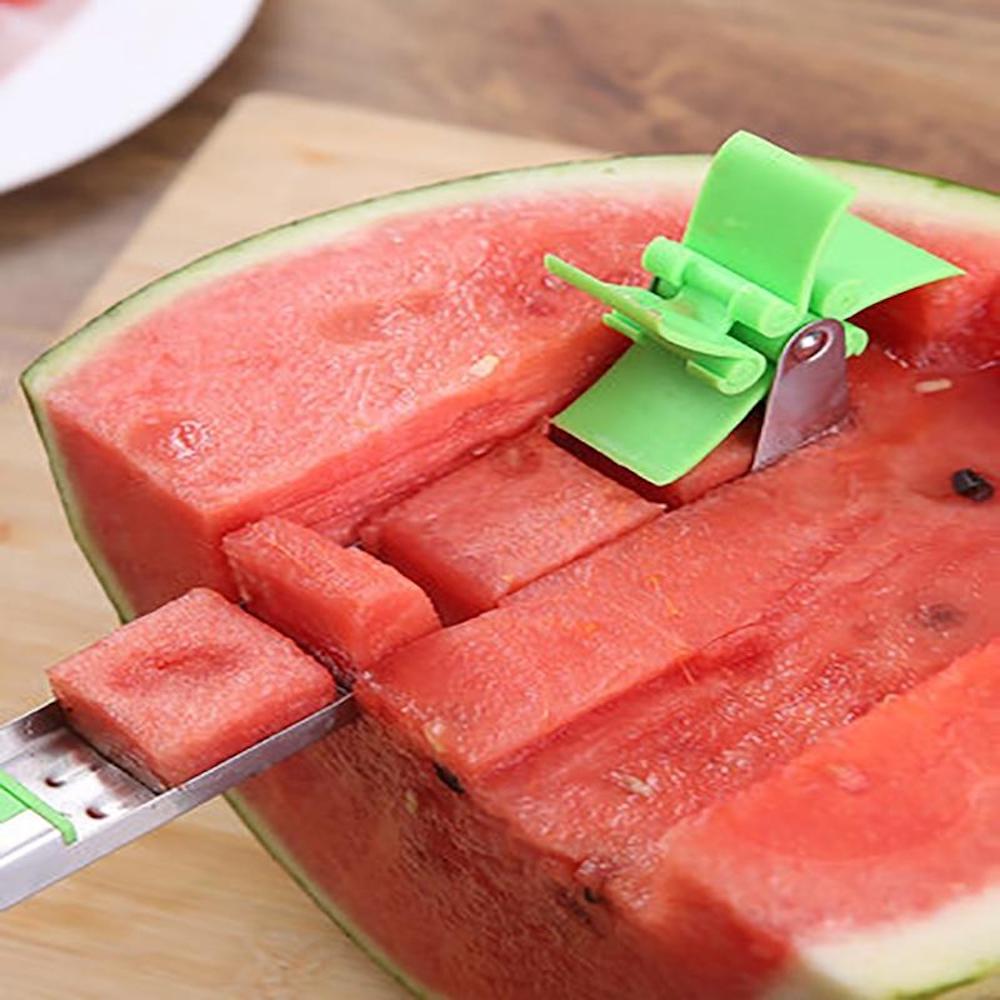

Ce découpe pastèque fonctionne comme un moulin à vent pour créer des cubes

L’été approche (bientôt), son beau temps et ses températures élevées aussi … Ça donne soif, on vous ne le fait pas dire. La période parfaite pour se ruer sur les pastèques : rafraîchissantes et sucrées, elles nous sauvent lors des épisodes de canicule. Mais pourtant, aussi délicieuses soient elles, quelle galère lorsqu’il s’agit de devoir les découper ! Alors, afin d’éviter les petits bobos, on a peut-être la solution …

Ce gadget bien pensé, qui ne paye pas de mine, sert à couper votre pastèque ! Grâce à son système malin de “roulette” et avec une légère pression vers l’avant, le découpage se fait tout seul. Les cubes de pastèque découpés sont ensuite recueillis grâce à une petite barre de stockage en acier, placée juste à l’arrière. Et grâce à un système de coulissage, cet espace de stockage peut aussi varier de tailles de cubes selon les envies !

Sans effort, ces cubes parfaitement carrés sont découpés avec cette “roulette”, qui fait d’ailleurs penser à un moulin-à-vent. Grâce au mouvement opéré à la main, cet outil facile d’utilisation ne requiert qu’une simple pression vers l’avant, afin d’obtenir vos précieux bouts de pastèque !

Le petit plus ? Étant donné que les bouts de cette roulette à couper sont arrondis, aucun danger pour vos petits doigts.

Alors, qu’en pensez-vous ? Parfait pour vous désaltérer sans en mettre partout. Et si vous avez encore du mal à éplucher ou découper d’autres fruits et légumes, on vous conseille cet article sur 20 accessoires de cuisine créatifs, pour vous faciliter la vie !

Crédits : Commonlee

Crédits : Commonlee

Crédits : Commonlee

Crédits : Commonlee

Imaginé par : COMMONLEE

Source :

L’article Ce découpe pastèque fonctionne comme un moulin à vent pour créer des cubes est apparu en premier sur Creapills.

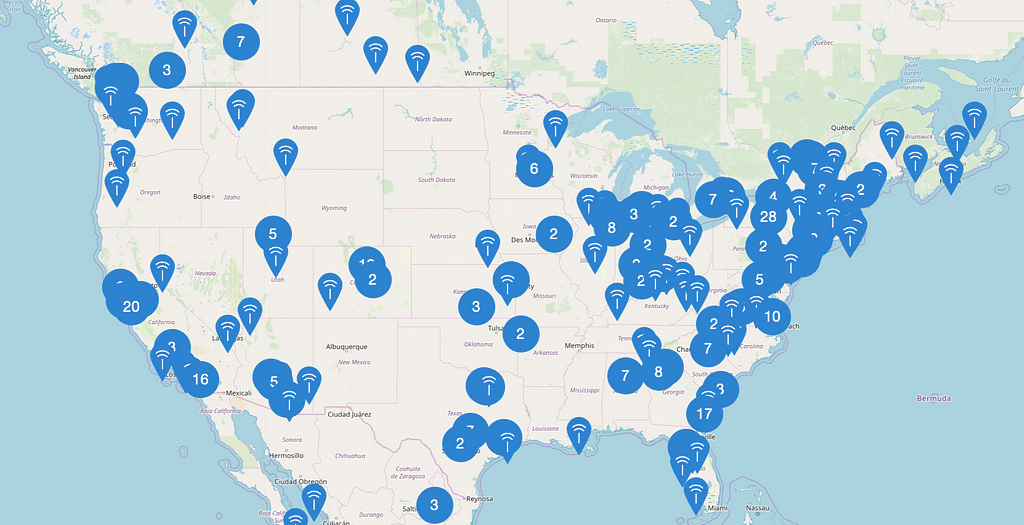

What Wireless Communication Standard to Use for Your Next Project

The hobbyist wireless communications space is becoming increasingly crowded with different radios and protocols — this guide will help you choose the right one for your next project!

TL;DR

If you’re just looking for a recommendation without any information, read this section. I go into much more detail below.

- I need to transmit a small amount of data a long distance without too much power: LoRA

- I need to transmit a lot of data back and forth from the internet from a remote device: Cellular

- I need to transmit a lot of data back and forth from the internet from a non-remote device: Wi-Fi

- I need to communicate with a phone: Bluetooth Low Energy (BLE)

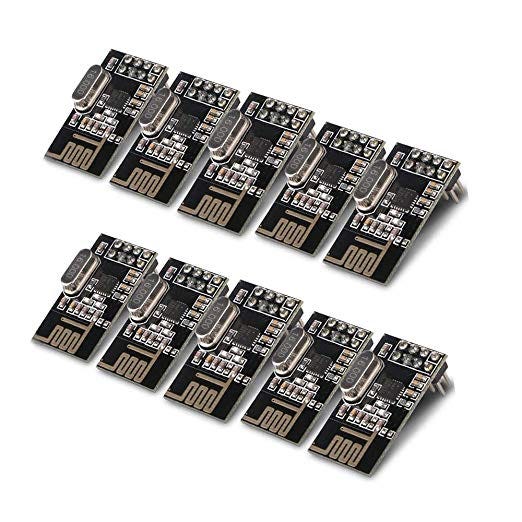

- I have extreme budget and/or power constraints: Generic 2.4GHz (nRF24L01)

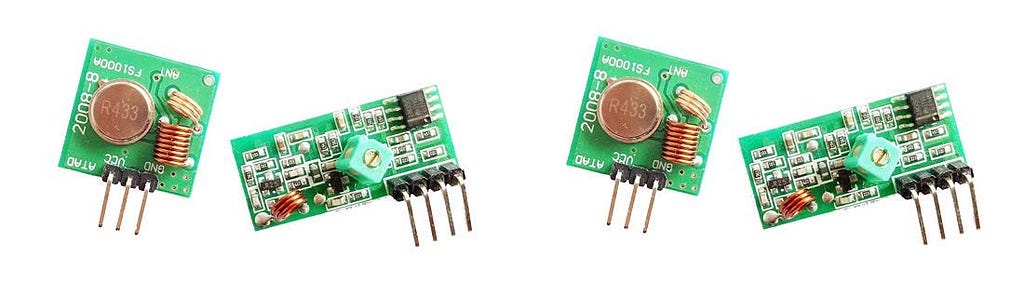

- I need a really small transmitter: Generic 433 MHz

- I need extreme flexibility and customization: Amateur Radio

Low-Power Wide Area Networks (LPWANs)

If you’re looking for a system that allows you to send a little bit of data a long distance without much power, LPWANs are the way to go! The main players in this space are LoRa and Sigfox.

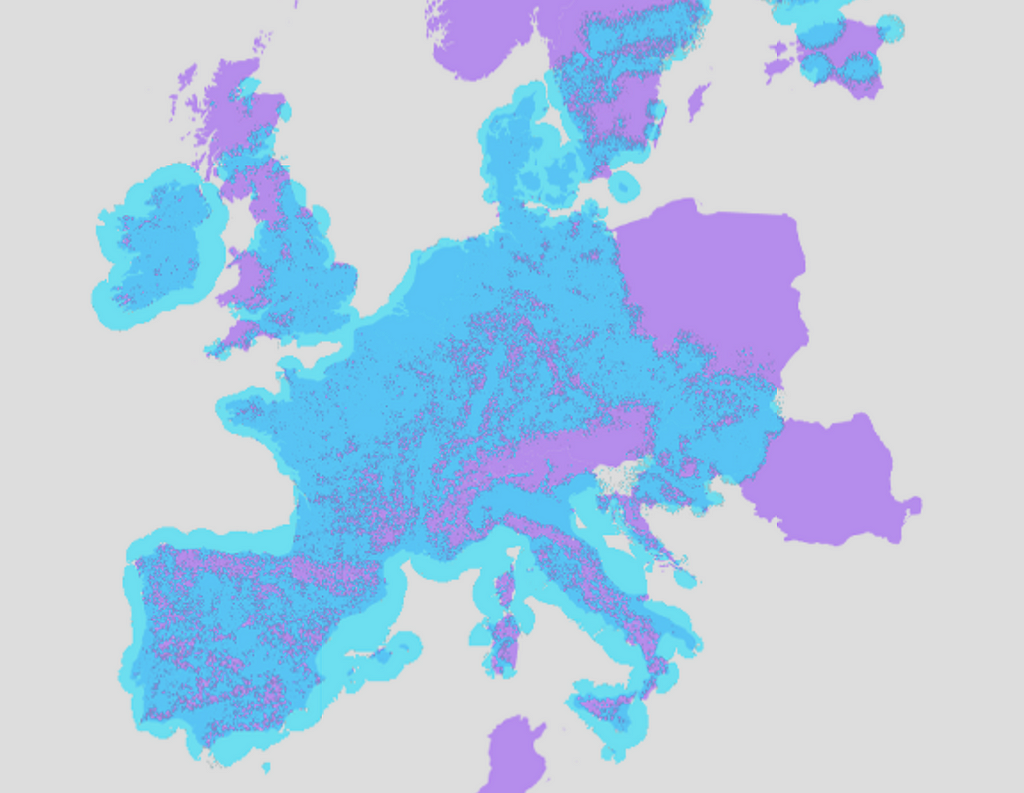

LoRa

LoRa, short for long range, is a standardized communication protocol that uses the 900 and 400 MHz ISM bands to send data upwards of a few miles. LoRa modules are inexpensive and easy to integrate with microcontrollers such as Arduino devices or computers like the Raspberry Pi. You can pick up a LoRa module from Amazon for around $20.

Some companies, such as The Things Network, maintain and operate a series of internet-connected gateways that allow you to connect your LoRa devices to the world wide web. These gateways are relatively sparse, however, and offer a fraction of the coverage of cellular networks.

Sigfox

Sigfox is another LPWAN standard that also uses the 900 MHz ISM band to transmit information. Unlike LoRa, the Sigfox network is centered around internet-connected gateways. Sigfox modules tend to be more expensive than LoRa modules but offer more features.

Connecting to the Internet

Another common use case for wireless communication technologies is sending data back and forth from the internet. The most common technologies that developers utilize for this application are Wi-Fi and cellular.

Wi-Fi

You’re likely already very familiar with Wi-Fi. It offers extremely fast data transfer rates (that you can’t really take advantage of with a slow microcontroller) at medium ranges. Boards like the Raspberry Pi have Wi-Fi built-in, and you can purchase inexpensive modules for around $1 that allow microcontrollers such as Arduino devices to utilize Wi-Fi.

Wi-Fi is a great communications standard choice for indoor projects. Wi-Fi utilizes relatively little power and offers decent ranges of typically a few hundred feet.

Cellular Networks

Cellular modules are more expensive and use more power than Wi-Fi modules but offer unparalleled internet coverage. Some microcontrollers, such as the Particle Electron, have cellular modules built in. You can also buy 3G Arduino-compatible modules for around $30. You can purchase USB cellular dongles that allow devices like the Raspberry Pi to communicate over cellular networks.

Cell service can be expensive and cellular modems use a lot of power, so only choose cellular networks if you need to.

Device-to-Device Communications

If you need to have two microcontrollers communicate with one another then you’re in luck; there’s plenty of options out there.

Low-Cost 2.4 GHz

There are tons of low-cost modules that utilize the 2.4 GHz band to create point-to-point communication networks. One of my personal favorites is the nRF24L01. Each radio is less than $1 and they’re extremely easy to use. These devices can communicate at a maximum range of a few hundred feet and are only capable of sending small data packets. This module is a great choice if you need to get two microcontrollers talking, or want a low-power communications solution.

Zigbee

Zigbee is a standardized communication technology designed to allow interoperable communications between devices. The XBee form-factor is extremely popular for Arduino devices. These modules are much pricier than some radios but offer great reliability and interoperability between existing devices.

Generic 433 MHz

These devices are perhaps the simplest communications hardware you can reliably use. They are incredibly inexpensive but can still transmit a small amount of data a few hundred feet. The only downside is you need a separate module for transmitting and receiving. So, if your application only needs to either transmit or receive data these are a great choice.

Communicating with Phones, Tablets, and Computers

There’s really only one contender in this space: Bluetooth. Every major phone and tablet and most computers have Bluetooth communications chips; this makes communicating with a variety of different devices extremely convenient. Standards such as Bluetooth Low Energy (BLE 4.0) allow tiny wearable devices to operate for months at a time without recharging or changing batteries. You can pick up inexpensive Bluetooth 4.0 modules for $10, or more well-documented modules from companies such as Adafruit for around $20.

Amateur Radio

The term “amateur radio” refers to radio activities in amateur radio, or “ham radio”, bands. Amateur radio equipment can be difficult to operate, and you need a license to do so, but it offers the utmost flexibility for unique communications tasks. It requires much more radio knowledge to construct a functioning amateur radio communications system than some of these cheap modules but it is a rewarding experience.

That’s all! If you enjoyed this, you can check out my website and more of my writing. Think there’s anything I missed? Let me know in the comments!

What Wireless Communication Standard to Use for Your Next Project was originally published in Hackster Blog on Medium, where people are continuing the conversation by highlighting and responding to this story.

This Thai Termite Spray Commercial is Epic Beyond Measure

Seriously, nothing beats Thai commercials when it comes to storytelling. So funny.

The post This Thai Termite Spray Commercial is Epic Beyond Measure appeared first on Geeks are Sexy Technology News.

Amazon says fully automated shipping warehouses are at least a decade away

The future of Amazon’s logistics network will undoubtedly involve artificial intelligence and robotics, but it’s an open question at what point AI-powered machines will be doing a majority of the work. According to Scott Anderson, the company’s director of robotics fulfillment, the point at which an Amazon warehouse is fully, end-to-end automated is at least 10 years away. Anderson’s comments, reported today by Reuters, highlight the current pace of automation, even in environments that are ripe for robotic labor, like an Amazon warehouse.

As it stands today, robots in the workforce are proficient mostly at specific, repeatable tasks for which they are precisely programmed. To get the robot to do something else takes expensive,...

Après avoir levé plus de 200 millions de dollars, Anki ferme ses portes !

Burger King is rolling out meatless Impossible Whoppers nationwide

Burger King is rolling out the Impossible Whopper nationwide, after a successful trial run testing the meatless burger in St. Louis. The chain announced in a statement today that it plans to test in more markets before distributing the burger nationally by the end of this year.

The Impossible Whopper is made with startup Impossible Foods’ plant-based patties, which are designed to look and taste like meat. The patties are also designed to “bleed,” just like the real thing, which can be attributed to the use of heme, a soy-based compound found in plants and meat. The burgers have 15 percent less fat and 90 percent less cholesterol than regular Whoppers, and Burger King’s taste test experiments claim that customers and employees can’t...

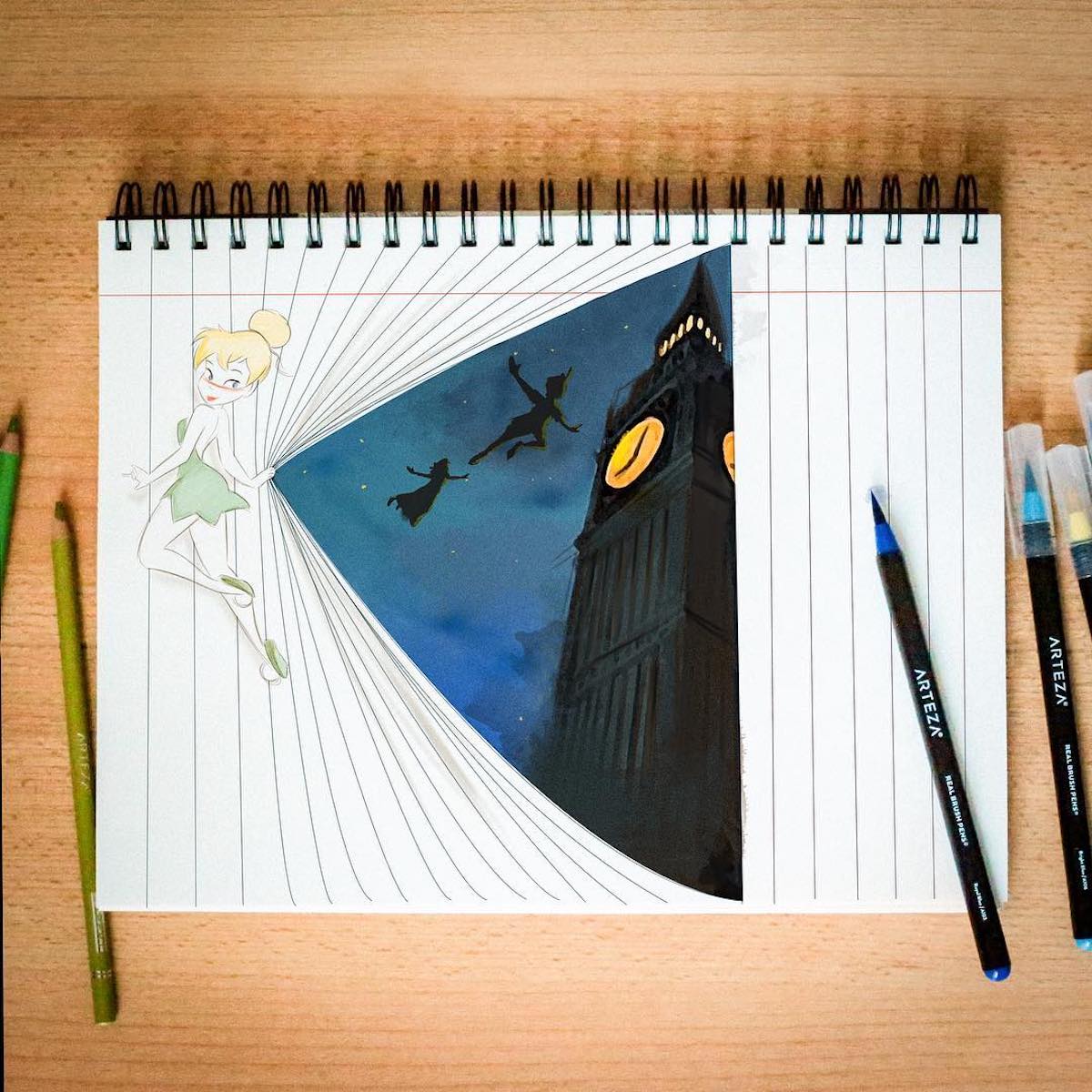

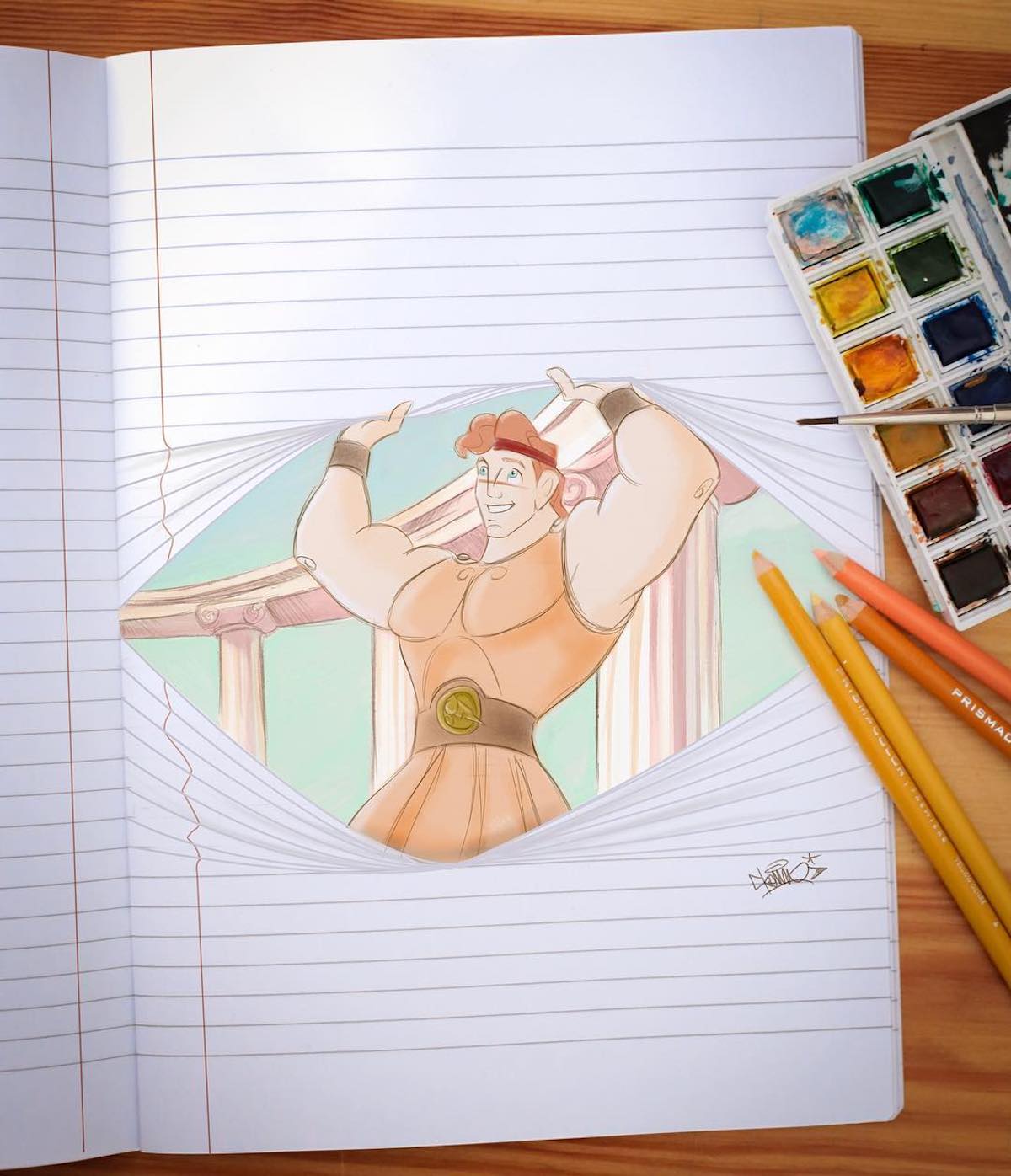

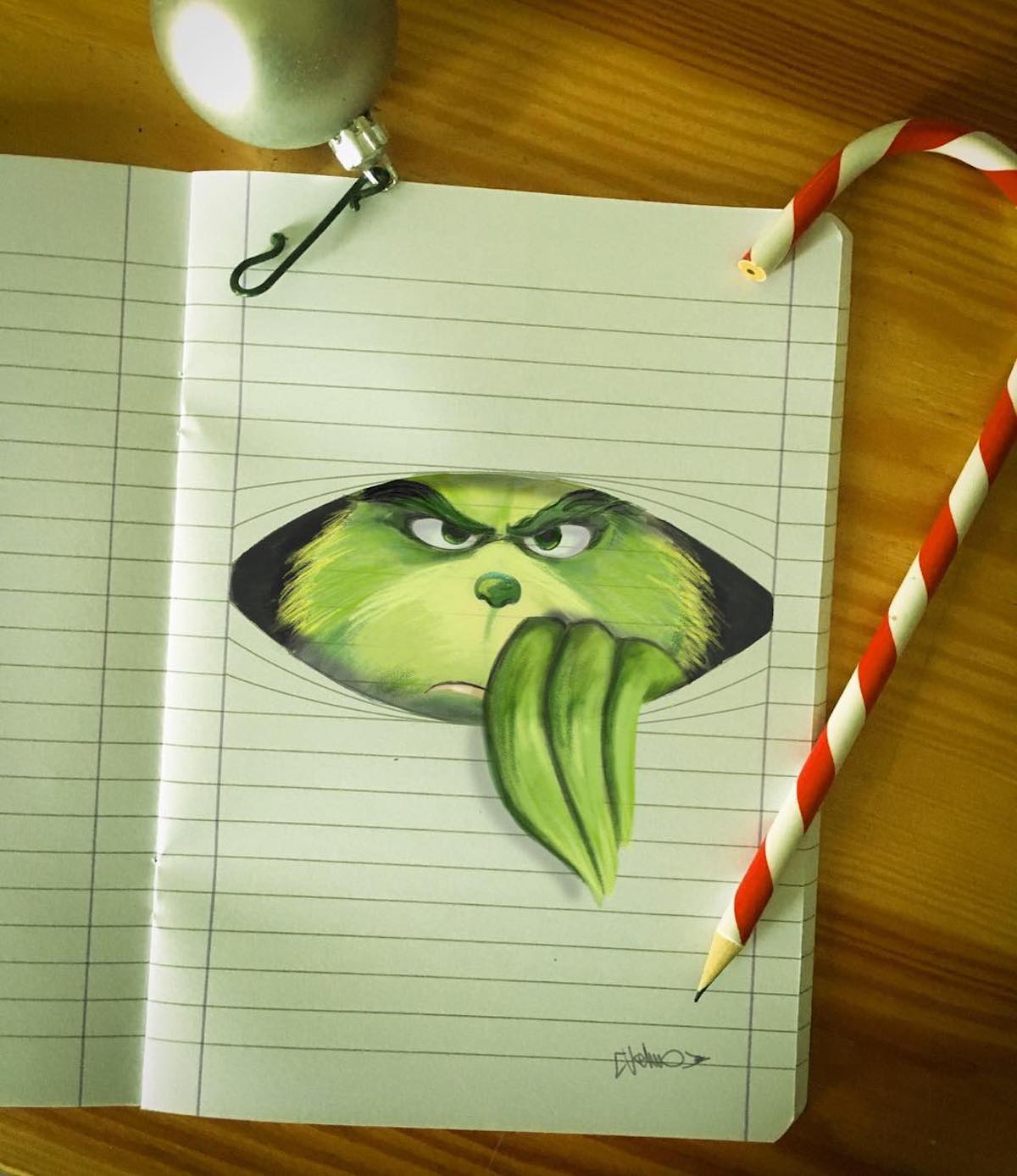

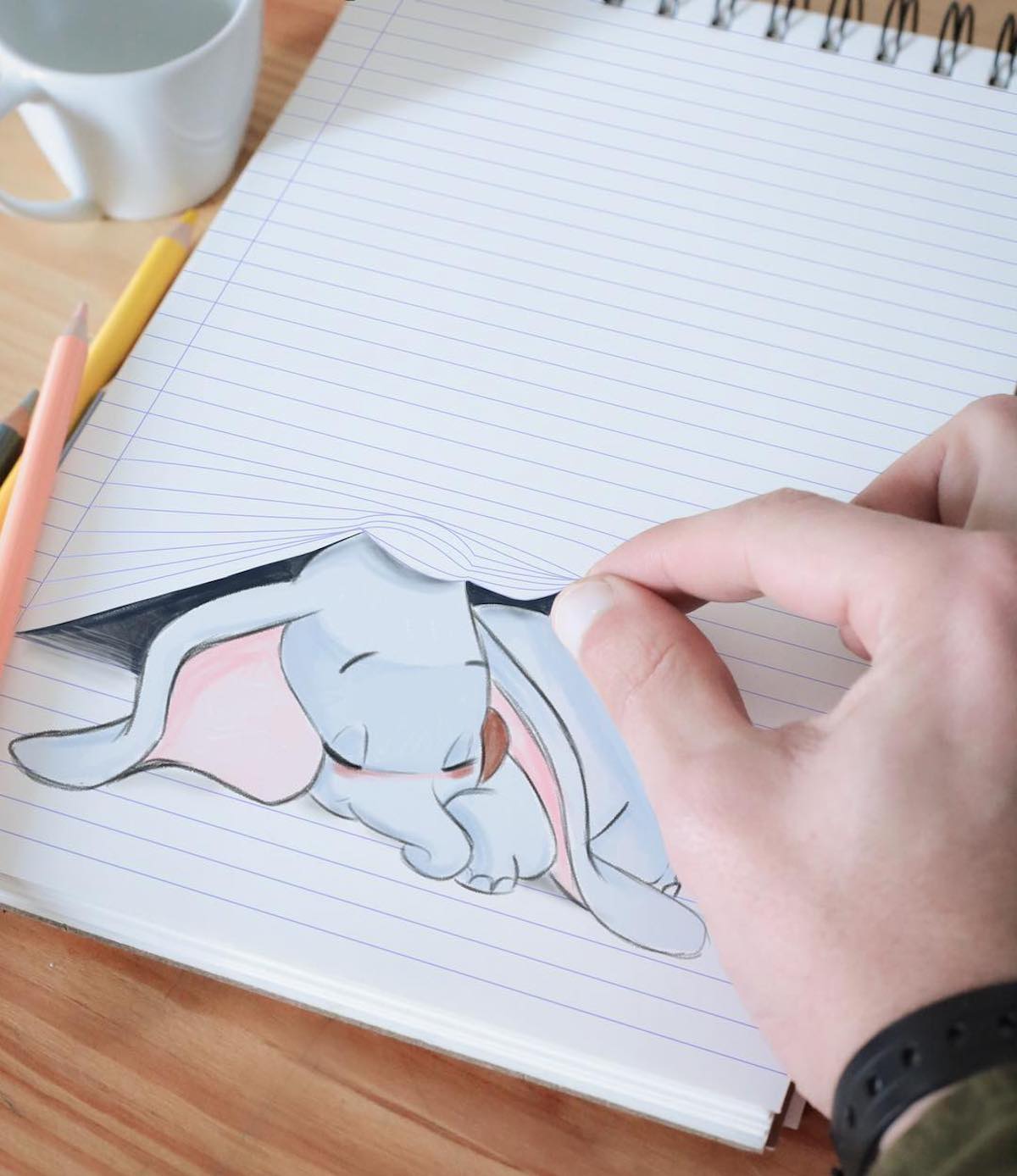

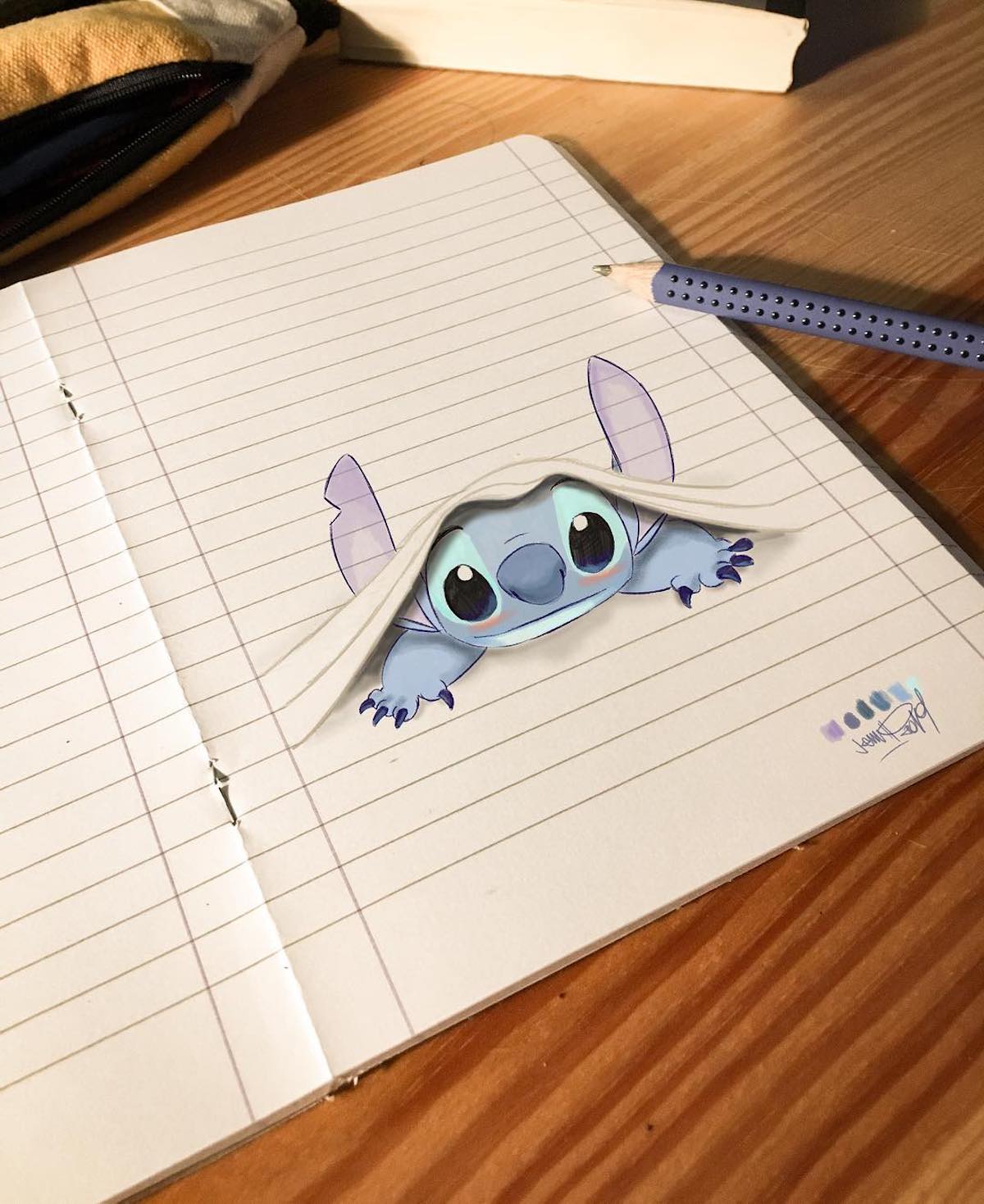

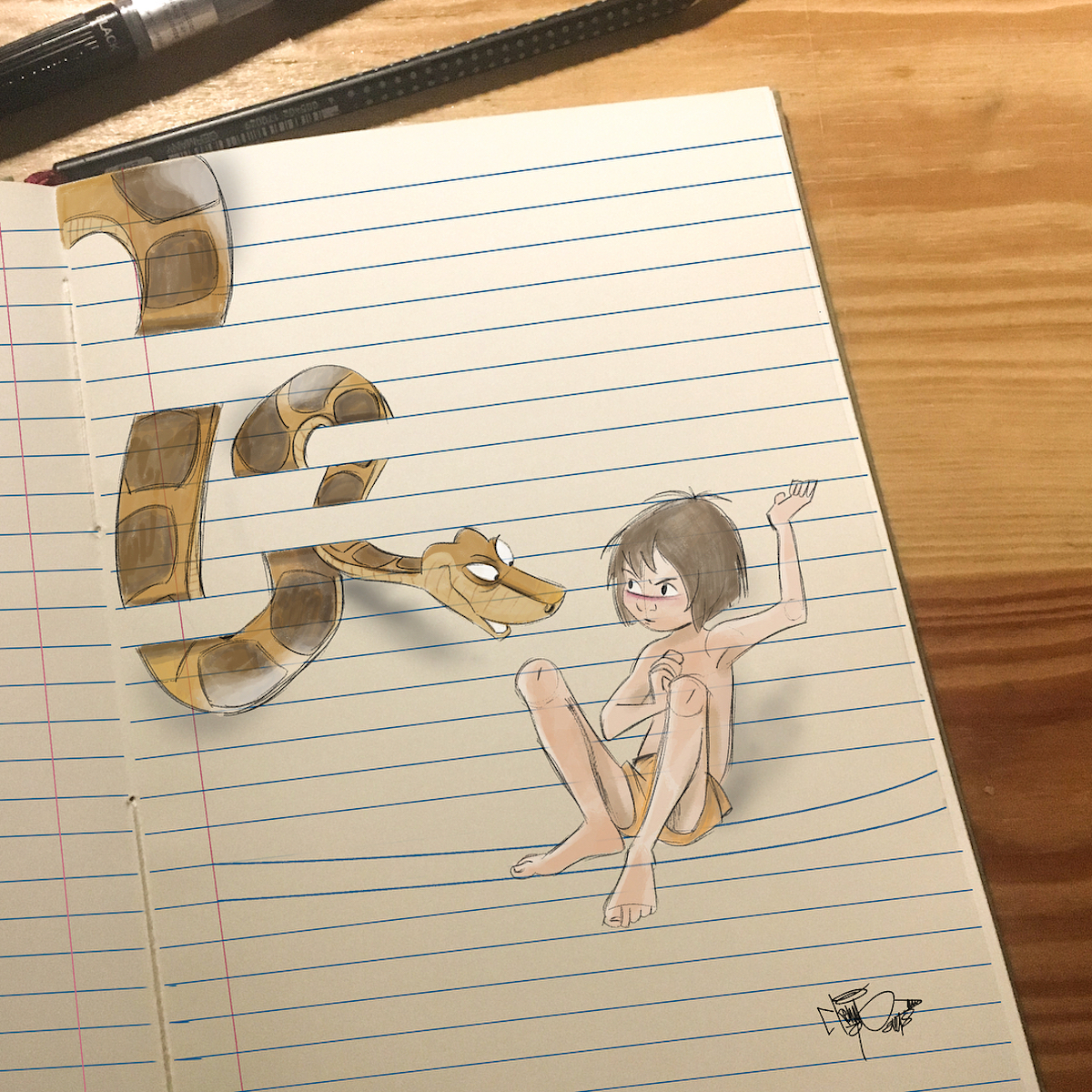

Cet illustrateur joue avec les lignes des cahiers pour donner vie aux personnages Disney

Avouez-le, on a tous déjà gribouillé quelques petits dessins dans nos marges de cahiers pendant les cours. Oui, mais là, on va vous présenter quelque chose d’un tout autre niveau … Cet artiste a élevé la barre très haut avec ses dessins de personnages Disney. On vous laisse les découvrir …

Luigi “Kemo” Volo est originaire de Naples, en Italie. Designer graphique et illustrateur, Kemo s’était fait connaître aussi pour ses montages photos, où il insère des personnages Disney dans la vraie vie. Sur son Instagram, il poste également d’autre types de contenus, comme celui dont nous allons vous parler.

Depuis quelques temps, Kemo s’amuse à dessiner des sortes de trompe-l’œil, qui jouent avec les lignes d’un cahier. Seulement, Kemo cherche à nous duper ! Car lorsqu’on regarde de près, on découvre que tout est fait à la main, même les lignes, qui ne sont donc pas issues d’un véritable cahier. En effet, afin de pouvoir donner ces effets surprenants dans ses dessins, il est indispensable d’être créatif au maximum ! Ce concept sort vraiment du lot ; encore plus parce qu’il jongle parfaitement avec les situations correspondant à chaque personnage.

Depuis que je suis petit, j’ai toujours été attiré par les « comics » et l’animation, deux passions qui m’ont irrémédiablement amené vers l’univers du dessin.

Entre Raiponce qui s’entremêle les cheveux entre les lignes, la Belle au Bois Dormant qui est assoupie dedans ou encore Hercule qui les soulèvent avec sa force légendaire, les “fausses” lignes de ces dessins ont un but bien précis, et ne sont pas juste là pour décorer. Une idée ingénieuse et amusante qui met en scène les personnages de l’univers Disney à merveille !

Crédits : Luigi Kemo Volo

Pourtant, cet illustrateur surdoué ne se destinait pas à cette carrière de dessinateur. Celui-ci ayant peu de ressources économiques, il n’a pas pu poursuivre un cursus approprié à ses envies. Il a donc été barman, et à côté, exerçait en tant que photographe dans des cérémonies ou pour des campagnes de publicité, par exemple. Preuve que la motivation paie, il précise :

Maintenant, je peux me permettre d’acheter tout le matériel nécessaire afin de m’adonner à mes passions (la photographie et l’illustration). Ce n’est que récemment que je me suis mis au graphisme digital. C’est comme ça que j’ai pu allier mes deux passions ! Dessiner mes personnages animés préférés et créer une interaction intéressante.

En bref, un talent qui continue à faire vivre son âme d’enfant à travers des dessins à la réalisation technique intéressante : tout ce qu’on aime ! Pour en savoir plus sur Kemo, n’hésitez pas à visiter son Instagram. Quant à l’univers Disney, si vous êtes fan et que vous appréciez les petites créations originales, on vous conseille cet article sur ces 50 personnages, réalisés de façon ultra-réaliste ou encore l’évolution Pokémon des personnages Disney !

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Crédits : Luigi Kemo Volo

Imaginé par : Luigi Kemo Volo

Source : instagram.com

L’article Cet illustrateur joue avec les lignes des cahiers pour donner vie aux personnages Disney est apparu en premier sur Creapills.

Ce fan de Spider-Man a créé un propulseur de fils d’araignée qui se collent (presque) partout

Et si les gadgets et autres pouvoirs de super-héros nous étaient accessibles ? On a tous déjà rêvé de se procurer une des inventions de Batman ou d’avoir d’incroyables capacités hors du commun. Et pourquoi pas, imaginer qu’il soit possible de se balancer entre les buildings, comme Spider-Man. Justement, même si nous n’y sommes pas encore, on s’en rapproche aujourd’hui, grâce à l’invention de HeroTech.

L’invention du jour concerne ici l’incroyable Spider-Man. À partir de presque rien, un jeune créatif a créé un objet reproduisant l’effet de jet de toile d’araignée du héros ! C’est Jacob Uy, un ingénieur originaire de Singapour, qui est à l’origine de ce projet de “Spider Web Shooter”. Avec sa société, il a conçu ce gadget, qui consiste à pouvoir se prendre pour le héros de comics, et à sa manière, de jeter des toiles un peu partout !

Mais comment ça marche ? Selon la description de ce gadget sur Etsy, le “Web Shooter” possède une technologie de “lancement de toile”, qui utilise des magnets rares composés de néodyme ; ce qui permet à la ficelle de se coller à n’importe quelle surface magnétique, et ce, jusqu’à 2 mètres de distance.

Ce gadget possède deux types de “toile” réutilisables, une ficelle faite de polyester, qui ressemble le plus à ce qu’a Spider-Man, et une autre ficelle beaucoup plus solide, le “SpiderWire” qui inclut un système de détection de mouvement avec des lumières LED vertes et une petite sécurité. Avec un système ingénieux de ressort et de recharges, il est possible de changer les ficelles facilement.

Pour ceux qui souhaiteraient rester incognito, le “WebShooter” a aussi une cartouche “swipable” avec une montre digitale, qui peut se changer en un coup d’œil. Malgré le fait que cela soit fort stylé et bien badass, à cause des très puissants magnets, ils ne doivent pas être exposés à proximité de technologies électroniques. D’ailleurs, il est précisé que les personnes possédant un pacemaker ne doivent pas utiliser le gadget !

Selon l’ingénieur derrière l’invention, la ficelle en elle-même n’est pas assez résistante pour reproduire les signature moves de Spider-Man, et ne se colle qu’aux surfaces magnétiques, on le rappelle. Mais … pensez-y, cela peut faire office de super accessoire pour votre costume d’Halloween, le véritable petit plus qui fera la différence.

Alors, comment s’en procurer un ? Jacob a décidé d’en mettre en vente sur son shop Etsy ! Malheureusement, victime de son succès, le gadget n’est plus disponible pour le moment. Mais bonne nouvelle, il a annoncé qu’il est possible de précommander pour se faire livrer en août 2019 ! Mais également, n’hésitez pas à regarder sa chaîne YouTube, pour observer son processus de création mais également ses crashtests de l’invention. C’est tout simplement fascinant !

Crédits : HeroTech

Crédits : HeroTech

Crédits : HeroTech

Crédits : HeroTech

Crédits : HeroTech

Imaginé par : Jacob Uy

Source : youtube.com

L’article Ce fan de Spider-Man a créé un propulseur de fils d’araignée qui se collent (presque) partout est apparu en premier sur Creapills.

Avengers Endgame Trailer – Developer version [No Spoiler]

Alors, si vous avez fait une mauvaise requête BDD, ou si vous avez juste envie de changer d’air et voir un peu le marché, découvrez les dernières offres sur ChooseYourBoss !

Note : Planche écrite sans avoir vu le film, dont aucun spoil, garantie !

Will Smith investit 46 millions de dollars dans l’eSport